手把手教你构建创意AI:PyTorch生成式模型开发指南

(如"夕阳下的城堡"对应特定色彩、构图和光影特征),再根据用户输入的新文本描述,从学习到的联合概率分布中采样,逐步生成符合描述的全新图像。生成式人工智能(Generative AI, GAI)是一种通过学习现有数据模式来创建全新内容的AI技术,能够生成文本、图像、音频、视频、代码等多种形式的输出。:通过大规模文本预训练,具备强大泛化能力,支持多种下游任务。:编码器-解码器结构,完全基于注意力机制,

1. 生成式人工智能基础概念

生成式人工智能(Generative AI, GAI)是一种通过学习现有数据模式来创建全新内容的AI技术,能够生成文本、图像、音频、视频、代码等多种形式的输出。

2. 生成式AI的工作逻辑与技术类型

以Midjourney文本生图过程为例,其核心逻辑是先学习海量图像-文本对的关联模式(如"夕阳下的城堡"对应特定色彩、构图和光影特征),再根据用户输入的新文本描述,从学习到的联合概率分布中采样,逐步生成符合描述的全新图像。这种"学习-采样-生成"的流程,是各类生成式AI的通用框架1。

3. Transformer

一、背景:Transformer 出现前的局限

-

主流模型:RNN(循环神经网络)及其变体 LSTM(长短期记忆网络)。

-

主要问题:

-

难以捕捉长期依赖:序列前端的信息容易丢失。

-

顺序处理,无法并行:训练速度慢,难以扩展至大规模数据。

-

二、Transformer 的核心创新

-

自注意力机制(Self-Attention):

-

能直接建模序列中任意两个位置之间的关系。

-

有效捕捉长期依赖,无论距离多远。

-

-

并行化处理:

-

不再按顺序处理输入,而是一次性处理整个序列。

-

训练可并行,显著提速,支持大规模数据训练。

-

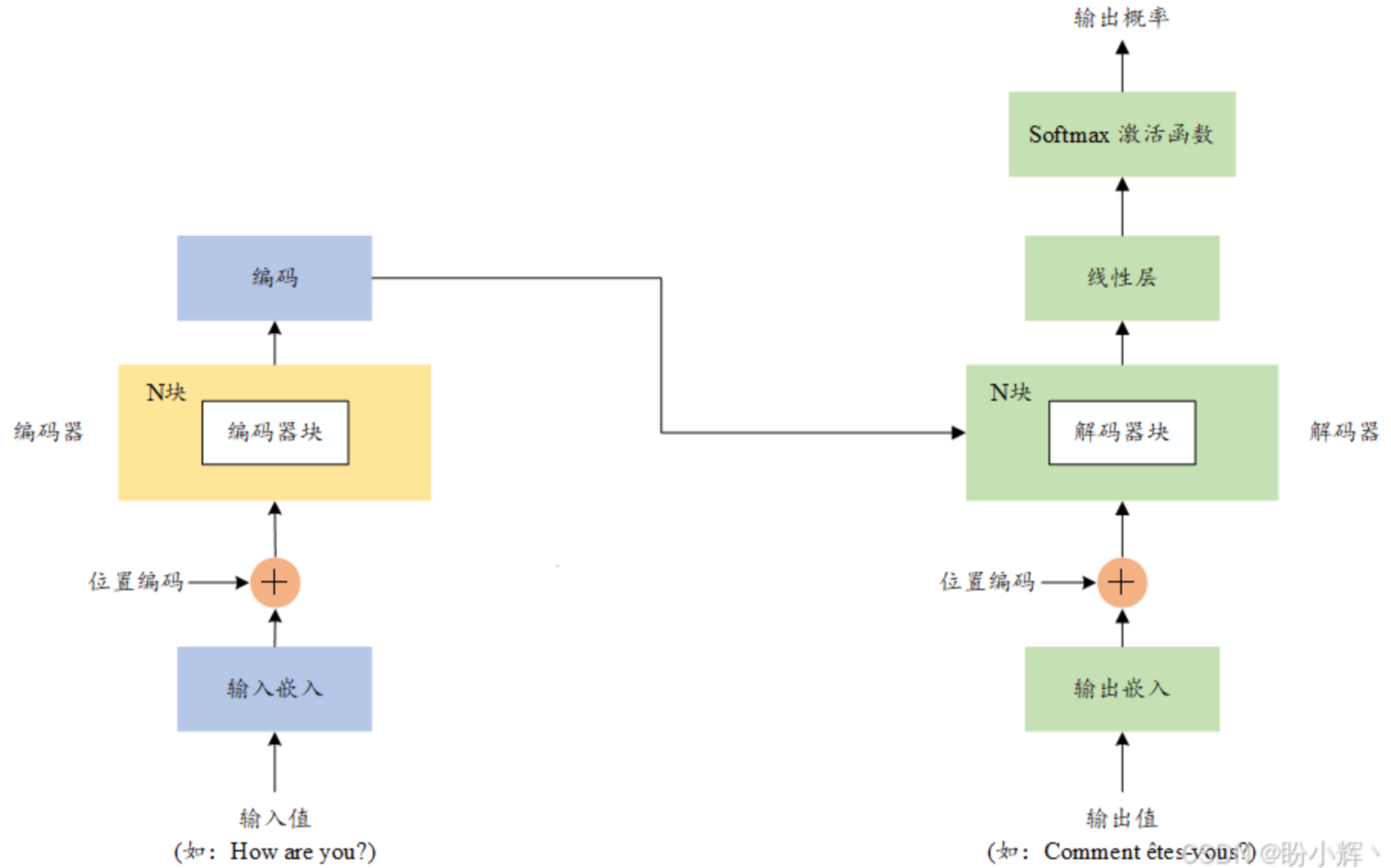

三、Transformer 的架构与演进

-

基础架构:编码器-解码器结构,完全基于注意力机制,无循环层。

-

模型类型:

-

编码器模型(如 BERT):用于理解类任务。

-

解码器模型(如 GPT):用于生成类任务。

-

编码器-解码器模型(如 T5):用于序列到序列任务。

-

-

扩展方向:

-

多模态模型:输入不限于文本,还包括图像、音频等。

-

预训练大语言模型(LLM):通过大规模文本预训练,具备强大泛化能力,支持多种下游任务。

-

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)