10 产品迭代-AI产品自我进化

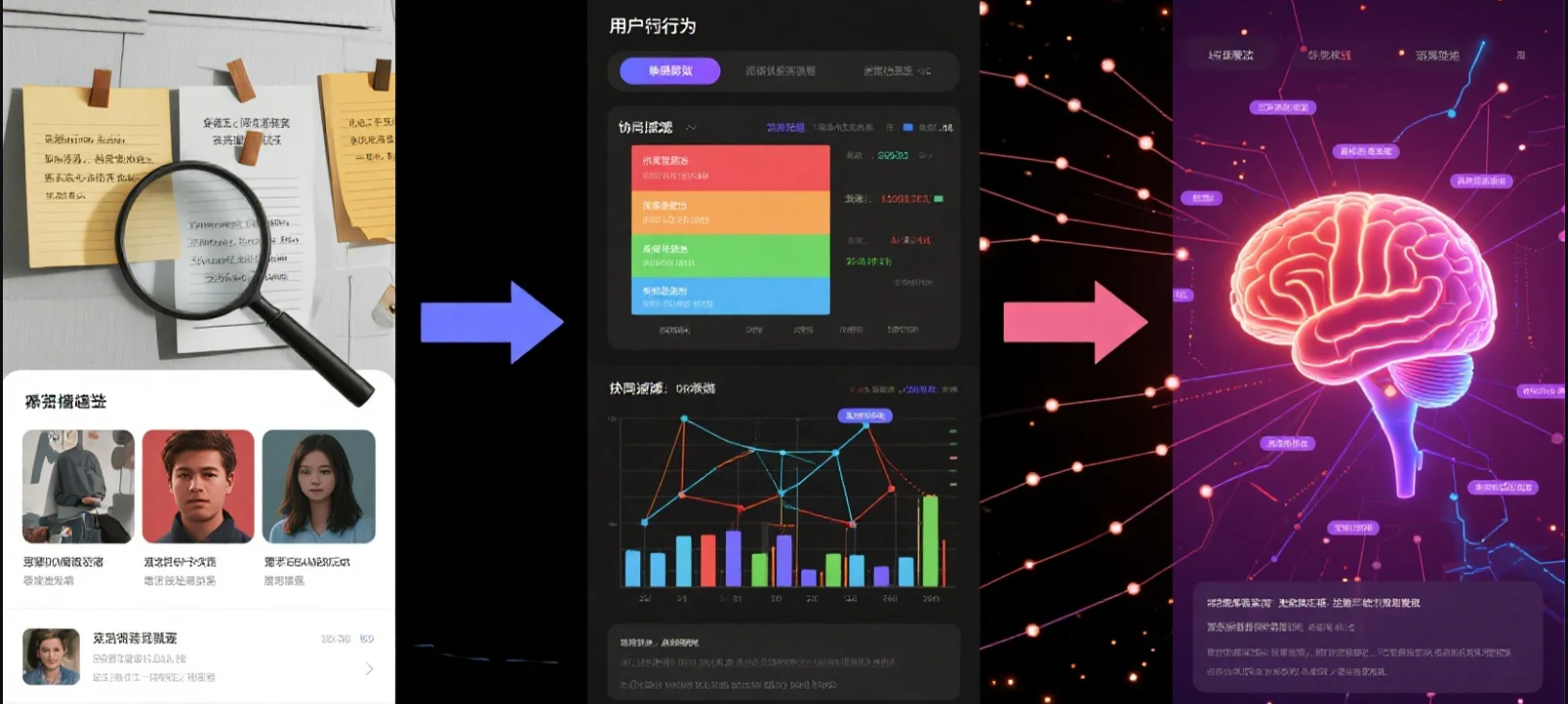

本文探讨了AI产品的自我进化机制,强调上线只是起点而非终点。文章以推荐系统为例,分析了从标签匹配到隐语义模型的三代算法进化,指出数据资产的广度、深度与温度是构建产品壁垒的关键。对于大模型产品,作者提出需要建立"反馈收集-数据处理-模型优化"的三层闭环系统,通过用户行为数据持续优化模型。文章指出,真正的AI产品竞争力不在于功能本身,而在于构建持续进化的能力闭环,将每次用户交互转化

10 产品迭代-AI产品自我进化

引言:上线不是终点,而是成长的起点

对于传统软件产品来说,“上线”意味着阶段性成功。而对于AI产品而言,上线只是开始——真正的挑战从冷启动那一刻才刚刚开始。

你并不是把一个模型推到用户面前就完事了,而是要让它在真实环境中持续学习、持续进化、持续提高用户体验。

这是打造AI产品关键路径中的最后一步,让我们看看如何让AI产品不断迭代,进化。

AI产品没有最终形态,它的竞争力来自持续进化的能力闭环。

一、从推荐算法看数据对产品的壁垒价值

推荐系统是AI产品中最典型的“自我进化机制”场景之一。

推荐算法经历了三次迭代升级:它从最初的“标签匹配”,逐步发展为“行为预测”,最终进化为“偏好建模”。

第一阶段:静态画像驱动(内容属性推荐)

- 核心方法:给内容打标签(如:导演、题材、时代背景等),进行向量化处理,计算内容间的相似度;

- 典型相似度算法:余弦相似度、欧几里得距离、皮尔逊相关系数、Jaccard系数等;

- 推荐逻辑:相似标签内容更优先推荐。

优点:

- 冷启动友好;

- 可解释性强;

- 用户推荐相对独立。

缺点:

- 个性化不足;

- 推荐内容趋同、缺乏惊喜;

- 缺少行为反馈的动态调整机制。

第二阶段:动态画像+协同过滤

引入用户行为数据,如浏览、点赞、评论、收藏、转发,构建动态画像,实现用户-内容之间的协同过滤。

- 协同逻辑:如果用户A喜欢的内容X,也被用户B喜欢,那么可以把X推荐给用户B;

- 内容的“动态热度”也会影响相似度判定,如:完播率、互动量等指标高,则权重上升。

优点:

- 个性化体验增强;

- 推荐更加贴合当前行为状态;

- 跨内容形式推荐成为可能。

缺点:

- 马太效应严重,热内容垄断曝光;

- 冷启动困难,新内容难获流量;

- 行为易被“刷量”污染,算法鲁棒性差。

第三阶段:隐语义模型驱动(潜在偏好建模)

这是AI推荐的真正“能力跃迁”。

通过矩阵分解、Embedding建模、神经协同过滤等机器学习方法,建立:

- 用户—偏好矩阵;

- 内容—偏好矩阵;

- 然后计算两者点积预测推荐。

不再依赖“明面标签”,而是基于历史行为自动提取兴趣偏好维度,进行精准匹配。

优点:

- 推荐结果更加“懂你”;

- 可自动发现用户潜在兴趣;

- 可迁移到不同场景的推荐任务中。

缺点:

- 可解释性差;

- 算法训练要求高;

- 需要较大规模数据支撑。

“数据壁垒”的真相

三代推荐的更迭,本质是数据能力的进化:从静态标签到动态行为,再到隐语义偏好。

简单说:前两阶段是“标签+行为推送”,第三阶段才是“模型真正开始理解你”。

算法可以买、能开源,真正不可复制的是你的数据资产——规模(广度)、粒度(深度)、时效与清洁度(温度),以及围绕数据建立的采集-反馈-评估-再训练闭环。

闭环一旦跑通,就会形成“更准推荐 → 更高留存与转化 → 更多行为数据 → 更准推荐”的飞轮,持续抬高 LTV 与获客效率。

换句话说,推荐系统不是一段模型代码,而是一套数据运营系统;数据的广度、深度与温度,决定了产品的壁垒高度。

二、大模型产品的自我进化机制壁垒:构建反馈闭环

大模型产品,也要走完“收集信号 → 构造样本 → 反哺模型”这条闭环路。第一步不是训练,而是倾听;最后一步也不是上线,而是循环。

一个真正有进化能力的AI产品,一定具备三个基本层级的“自反馈系统”:

1. 反馈收集层:让产品“听得见”用户

这是最基础的层——你的产品必须“听得见用户的声音”。

要让模型变聪明,先把用户的每一次犹豫与选择,变成可被读取的信号。

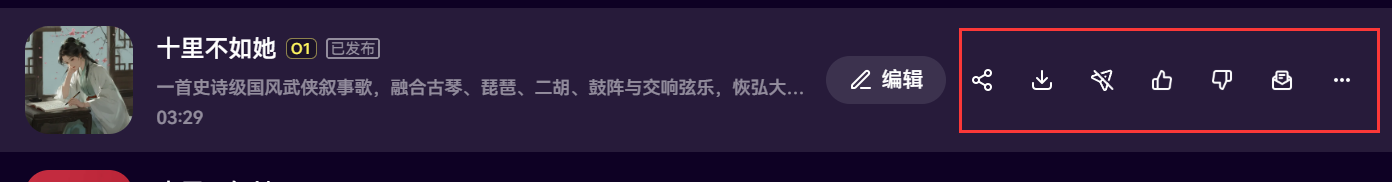

- 显性操作:点赞/点踩、重新生成、收藏、复制、下载、评论等,都是“我满意/不满意”的直白表达。

- 引导式反馈:在生成后用一句话追问——“哪一版更好?为什么?”——把“更好 vs 更差”沉到数据里。

- 隐性行为:停留、跳出、滚动、二次编辑、对比查看等,是不吭声的真实偏好。

落地要点:为每一次“重新生成”记录三件事——当时的 Prompt、原始输出、用户最终选择。这些就是之后的“训练对”

建议:记录每一次重新生成前的Prompt、原始输出、用户选择结果,用作未来优化素材。

下图是音乐制作软件 Mureka 的行为采集设计,核心就是:把从点按到选择的全过程留痕。

2. 数据处理层:把“杂音”变成“训练样本”

有了行为数据,并不代表你就拥有了可用的训练数据。你还需要完成对比数据构建,打造质量评分模型,建立数据清洗机制。

-

对比样本构建:基于用户选择,把输出配对成「更好 vs 更差」。必要时补齐“模型自打擂”的多候选对比。

-

质量评分模型(Reward):用规则+小模型对可读性、事实性、风格一致性等维度打分,让“好坏”不只停在主观。

-

数据清洗:剔除异常(批量刷量、随机点击、机器人流量),给用户与会话设置可信度权重,保留高置信样本。

一句话:把原始反馈,炼成可监督的偏好样本。

3. 模型优化层:用反馈驱动“模型—系统”协同演进

最后,利用对比数据训练奖励模型,并与原模型进行融合,这也是模型微调,只不过这个模型不限于大模型,而是你的整个系统。

-

优化方式:SFT → DPO/RLHF(或 RLAIF)→ 周期性微调;必要时多任务蒸馏,保证线上推理稳定。

-

演进节奏:离线训练 + A/B 验证 + 小流量灰度,逐步放量;把线上回传继续沉淀到第 2 层,形成数据飞轮。

-

系统协同:不只调大模型参数,还要联动提示词模板、检索召回、重排序、护栏策略,整体优化用户体感。

最终的目标很朴素:用户能明显感觉到——“这个产品,比昨天更懂我。” 这份“可感知的持续变好”,就是大模型产品独有的使用壁垒。

三、从提示词到产品:你是否在构建能力闭环?

如果大模型产品开发,单纯依靠prompt,也是没有产品价值壁垒的。

另外通过独特的知识库数据带来的有一定的差异性,但如果知识库可以基于用户的使用进行更新,则会形成增强回路,极大的提升用户体验。

市面上很多AI产品初期都依赖“提示词工程”取得初步效果,但一旦进入市场竞争阶段,如果缺乏有效反馈与自我优化机制,产品体验很快会陷入“平台同质化”。

所以你必须回答一个问题:

你的产品是否真正具备“持续变好”的能力?

如果你只是“把大模型包装了一层UI”,那你就只是一个“调用层产品”;

如果你能建立持续获取高质量交互+训练样本+产品微调迭代的能力闭环,你才具备“自我进化”的真正优势。

结语:AI产品的护城河,不是功能,而是进化能力

在AI时代,一切看起来都能被复制,Prompt可以抄,UI可以模仿,模型可以换。

唯一无法轻易复刻的,是产品在真实用户交互中形成的“能力自洽闭环”:

- 你是否构建了足够细腻的反馈系统;

- 你是否拥有持续学习并更新的能力链条;

- 你是否把每一次用户交互,都变成下一次更好的可能。

真正的AI产品不是交付一个静态工具,而是唤醒一个能“持续进化”的智能生命。

后续我会再进一步展开谈谈人机协同混合模式在不同系统中如何做技术架构,如何在用户使用大模型产品过程中,更好的获取数据。咱们下次见~

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)