LangChain 是如何把 AI 工具变成智能系统的?附核心组件全解析

LangChain是构建结构化AI系统的开发框架,其核心价值在于将模型、数据、流程等组件模块化组合。五大核心组件包括:1)支持多模型的统一接口;2)可变量注入的Prompt模板;3)封装任务逻辑的Chain;4)自主决策的Agent;5)管理对话上下文的Memory。该框架通过组件化设计提升开发效率、调试支持和系统扩展性,适用于智能客服、问答系统等企业级AI应用。开发者可通过LangChain构建

有没有一种感觉,大模型开发越来越“有样无型”了?

你调了一个通义千问或 ChatGPT 编了个对话循环,功能却很脆,改起来像拆积木一样,一堆 if-else 铺着,谁敢升生产环境?

但今天我们不聊累,聊准。

LangChain 是一个真正让开发者站在“编程模型”层面构建 AI 系统的工具。 它不仅仅是调用 LLM,而是连接数据与智能之间的结构性框架。

一、LangChain 简介:你可能用错了

LangChain 的核心价值不是“让调模型更容易”——而是“让模型、流程、数据、记忆、工具能协同起来,形成稳定系统的编程模型”。

它的定位是“AI 系统的 glue”,那粘合剂看着平平无奇,却是工业化的关键。

它的目标用户不是 LLM 爱好者,而是:

-

AI 应用开发者(构建智能客服、问答系统)

-

数据工程师(做好向量检索、数据输入处理)

-

全栈工程师(负责前端业务与 AI 模块集成)

-

研究人员(想要测试模型组合性能)

它的使用场景也不仅限于问答,还包括:自动化报告生成、数据分析、智能决策、知识引擎等。

二、五大核心组件:让智能可组合的“积木”

我们来一句代码一句架构逻辑地讲这五大模块:

🧠 2.1 模型(Model):LangChain 的思考引擎

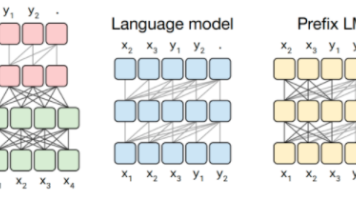

LangChain 支持两类模型接口:

-

LLM:纯文本输入输出,适合简单的 generation 场景

-

ChatModel:结构化的输入/输出,如 System/User/Assistant 角色(更贴近 ChatMessage 结构)

它不绑定你用 OpenAI、HuggingFace 还是阿里云的通义千问。 只需一个 adapter 层,就可以把所有模型变得统一调用。

from langchain_openai import OpenAI

llm = OpenAI(model="gpt-3.5-turbo-instruct")

response = llm.invoke("请生成一个关于AI开发平台选型的总结。")

关键是它允许你“抹平模型接入差异”,让你的重点是“逻辑组合”而非“模型转换”。

📝 2.2 提示模板(Prompt):AI行为背后的语言设计师

Prompt 是你对模型说的第一句话,但比这更重要的是:它定义了任务输进方式、格式化逻辑与上下文注入点。

LangChain 的 PromptTemplate 提供了变量注入能力,甚至可以在运行时动态替换:

from langchain_core.prompts import PromptTemplate

prompt = PromptTemplate.from_template("请用简洁的中文回答:{question}")

formatted_prompt = prompt.format(question="LangChain 适合哪些企业 AI 应用?")

真正聪明的 AI 系统,提示词就是它的‘操作系统入口指令’。

⚙️ 2.3 Chain(链):AI任务流的“装配线”

LangChain 最大的亮点——链(Chain),它把Prompt、Model、Memory、API调用逻辑组合成一个可执行单元,支持多级嵌套、顺序/并行执行,甚至能写成可发布的服务。

链的本质是:封装行为逻辑,让外面看到的只是“解决什么问题”,而不用理会内部如何执行。

from langchain.chains import LLMChain

chain = LLMChain(llm=llm, prompt=prompt)

result = chain.invoke({"question": "为什么智能系统要结构化?"})

“Chain 就是 AI 开发者最熟悉的编程管道(Pipeline)”

🤖 2.4 Agent(代理):知工具、能决策、会调用

有了 Agent,你就能构建一个 LLM 可以自主决策从工具集中选 API、查知识库,甚至做数学运算。

和 Chain 相对固定的方式不同,Agent 是“动态逻辑”的代表:

from langchain.agents import AgentType, initialize_agent, load_tools

tools = load_tools(["serpapi", "llm-math"], llm=llm)

agent = initialize_agent(tools, llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True)

agent.invoke("2024年阿里巴巴最新财报的净利润是多少?")

LangChain Agent 支持 Zero-shot(即时决策)、搜索调度、功能调用(Function Calling)等,适用于需要 Agent 自主选择执行路径的复杂场景。

🔁 2.5 Memory(记忆):让对话有上下文

你不可能随便“记住几次对话就丢了”,所以 LangChain 提供了 Memory 模块来管理多轮交互的状态。

从简单的缓存对话记录到基于数据库的持久化,它提供了丰富选择:

-

ChatMessageHistory:临时状态跟踪 -

ConversationBufferMemory:轮次数组式缓冲 -

ConversationSummaryMemory:压缩历史长对话,提升可控性 -

外部存储支持:如 Redis、MongoDB、PostgreSQL

from langchain.memory import ConversationBufferMemory

memory = ConversationBufferMemory()

memory.save_context(

{"input": "为什么 LangChain 的模块化设计重要?"},

{"output": "因为 Chain 和 Agent 的封装,让系统组织更清晰。"}

)

print(memory.load_memory_variables({})) # 输出记忆变量

“记忆不是锦上添花,而是构建有连续理解能力的 AI 系统必须品。”

三、LangChain 的设计哲学:“组件化”才是 AI 应用的王道

LangChain 给开发者的最大启示:智能系统天生应该是可组合的系统,不是黑箱。

它通过模块化、服务导向和高度可测试的设计,让开发者能从“拖一个模型调用 API”,变成“构建一个能扩展的 AI 流水线”。

| 维度 | LangChain 的做法 |

|---|---|

| 开发效率 | 通过 Prompt 和 Chain 快速定义逻辑 |

| 调试支持 | 运行时可记录、追踪,支持单元测试 |

| 可控性 | 借助 Memory 影响历史上下文响应 |

| 决策扩展 | Agent 支持工具增减和执行路径灵活 |

| 模型粘合 | 对接多种模型 API 接口实现单一抽象 |

四、开发者真实建议和使用陷阱

🌱使用建议

-

Favor Prompt Template over manual concat:结构胜于自由发挥

-

优先用 Chain 管理流程,而不是 raw 调用多个模型

-

用缓存跑测试用例——避免频繁调用昂贵模型

-

结合 Memory 实现个性对话路径,不要依赖“一律刷新”

🧱常见误区

| 误区 | 为什么会出问题 | 该怎么避免 |

|---|---|---|

| 滥用 Chain 堆叠,不加缓存 | 导致每次运行都调 API,效率差 | 可用 Chain with Memory 或 LLM Cache Layer |

| 把 Agent 当作包打万的自动聪明体 | 实际决策路径不稳定,输出不可控 | 设置白名单工具和规则兜底机制 |

| 忽略系统的上下文管理 | 对话频繁丢失先前信息 | 用 ConversationSummaryMemory 作为轻量状态管理器 |

五、从入门到精通:LangChain 的成长路径

推荐开发者逐层理解,逐步构建复杂应用:

🐚 初心者可以这样学

-

用熟悉的模型 + 全测试 Prompt,跑第一个 Chain

-

把问题从“调用谁”的问题变成“逻辑怎么走”的问题

-

试试嵌入一点点 Memory,看看是否提升连贯度

🚀 中阶目标

-

接入外部数据检索系统

-

构建 QA Chat、编写基于检索的 Agents

-

搭 RAG Chain,测试 VectorStore 集成能力

🧠 高阶实战建议

-

编写带异常处理的 Chain —— 出现 LLM 不可控的回答时,如何 fallback

-

使用 LangSmith 快速追踪执行路径和调用错误

-

构建 Version Control 化的 Prompt,做 Multi-Chain 的性能对比测试

六、生态拓展:不止是开发库,还是 AI 工具链起点

LangChain 的价值不止于“我跑一个应用”,它是一个巨大的生态:

-

LangServe:将你写的 Chain 写成 API 服务,推上线

-

LangSmith:调试、追踪、性能对比、版本管理都可做

-

LangGraph(LLM+Agent 状态记忆化模型):可以构建决策路径、状态图、上下文感知自动化系统

-

LLM Observability 系统(观测模型输出、调用轨迹、表现指标等)

Go-To 的企业 AI 项目中,LangChain 早已不是工具,而是系统级别的接入 API,集成到:

-

面向服务的 SaaS(AI助手后台)

-

企业 RAG 服务(知识问答 Boosting 引擎)

-

智能调度模块(如自动语音回复 Agent)

✅ LangChain 的本质

它不是一个 OpenAI 调用库,它是一个 AI 智能系统开发的‘编程语言层’!

即使后期你要替换平台,比如转向 Dify 或者 Coze,你也会发现一个现象:

大多数的 AI 逻辑开发习惯,当你是从 LangChain 学来的,就更容易重用;如果只写 Model 呼叫脚本,那就只是试验层代码。

聚焦LLM应用开发!微信公众号「AIGC研习屋」将持续带来Dify、Coze、RAGFlow的系列教程与洞察,助力你的AI项目。点击关注,赋能开发!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)