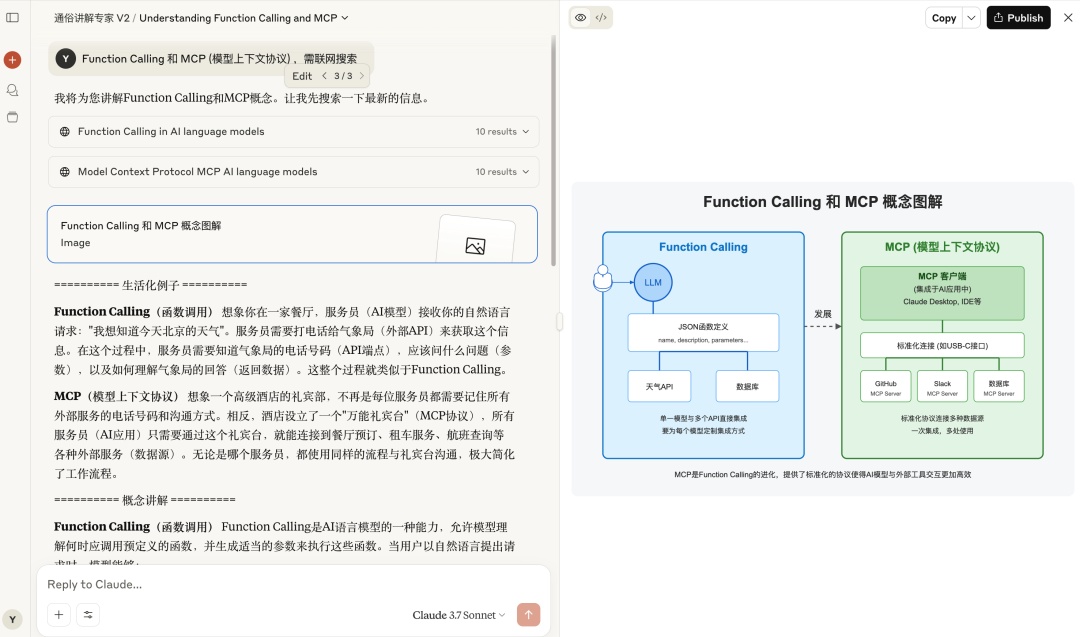

【收藏必学】MCP模型上下文协议:大模型工具调用的新标准

摘要:本文介绍MCP(模型上下文协议)这一大模型工具调用的新标准,结合RAG和Function Calling理论基础,阐述了MCP的核心架构、优势及实际应用。MCP采用动态灵活的客户端-服务器架构,解决了传统API的局限性,通过ModelScope市场和Cherry Studio展示了具体使用过程。尽管存在配置复杂、Token消耗大等问题,但MCP有望与A2A协议结合,推动AI工具调用的标准化发

一、前言

本文详细介绍了MCP(模型上下文协议)这一大模型工具调用的新标准,从理论基础(RAG、Function Calling)到MCP的核心架构和优势,通过ModelScope市场和Cherry Studio实例展示了实际应用过程。作者分析了当前MCP存在的问题,如配置不够智能、Token消耗大等,并展望了MCP与A2A协议结合的未来发展,认为MCP将为大模型工具调用提供标准化解决方案,推动AI应用进一步发展。

二、理论基础

RAG 是为了让大模型获取足够的上下文,Function Calling 是为了让模型使用工具,他们和 MCP 有或多或少的联系,因此,接下来,我先介绍前面两个概念再介绍 MCP。

2.1 先看 RAG

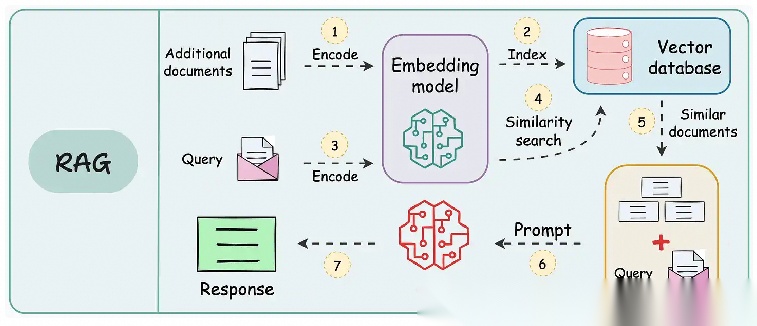

RAG(Retrieval Augmented Generation ,检索增强生成),我们不需要训练和微调大模型,只需要提供和用户提问相关的额外的信息到提示词中,从而可以获得更高质量的回答。

图片来源:https://www.dailydoseofds.com/16-techniques-to-supercharge-and-build-real-world-rag-systems-part-1/

通常,需要将资料通过嵌入模型生成服务转化为向量,然后存储到向量数据库中。

当用户提问时,将用户的问题向量化从向量数据库中进行相似度匹配出 TOP N 个片段,拼接成新的提示词发送给大模型,大模型就可以结合你的资料更好地回答问题了。

当然, RAG 还有很多变种,如 Agentic RAG 、Modular RAG、Graph RAG 等多种高级形式,这里就不展了。

2.2 再看 Function Calling

Function Calling (函数调用) 是一种允许大型语言模型(LLM)根据用户输入识别它需要的工具并决定何时调用该工具的机制。

图片来源:ailydoseofds

基本工作原理如下:LLM 接收用户的提示词,LLM 决定它需要的工具,执行方法调用,后端服务执行实际的请求给出处理结果,大语言模型根据处理结果生成最终给用户的回答。

不同的 API 需要封装成不同的方法,通常需要编写代码,很难在不同的平台灵活复用。

参见百炼函数调用文档:https://help.aliyun.com/zh/model-studio/tool-calling-overview/

2.3 来看 MCP

模型上下文协议(Model Context Protocol,简称MCP)是一个由 Anthropic 在 2024 年 11 月 25 日开源的新标准。MCP 是一个开放标准,旨在连接AI助手与数据所在的系统,包括内容存储库、业务工具和开发环境。其目标是帮助前沿模型产生更好、更相关的响应。

图片来源:https://zhuanlan.zhihu.com/p/598749792

MCP 可以看作是 AI 应用程序的 “USB-C端口”。就像 USB-C 为连接设备与各种外设提供了标准化方式,MCP为 AI 模型连接不同数据源和工具提供了标准化方法。

图片来源:ailydoseofds

2.3.1 MCP 的核心

从技术角度看,MCP 遵循客户端-服务器架构,其中主机应用可以连接到多个服务器。

MCP 有三个关键组件:

- 主机(Host)

- 客户端(Client)

- 服务器(Server)

2.3.2 组件详解

-

主机:代表任何提供 AI 交互环境的应用程序(如 Claude 桌面版、Cursor),它能访问工具和数据,并运行 MCP 客户端。

-

MCP 客户端:在主机内运行,使其能与 MCP 服务器通信。

-

MCP 服务器:暴露特定功能并提供数据访问,例如:

- 工具:使 LLM 能通过服务器执行操作

- 资源:向 LLM 公开服务器中的数据和内容

- 提示:创建可重用的提示模板和工作流

2.3.3 MCP 相比传统 API 的优势

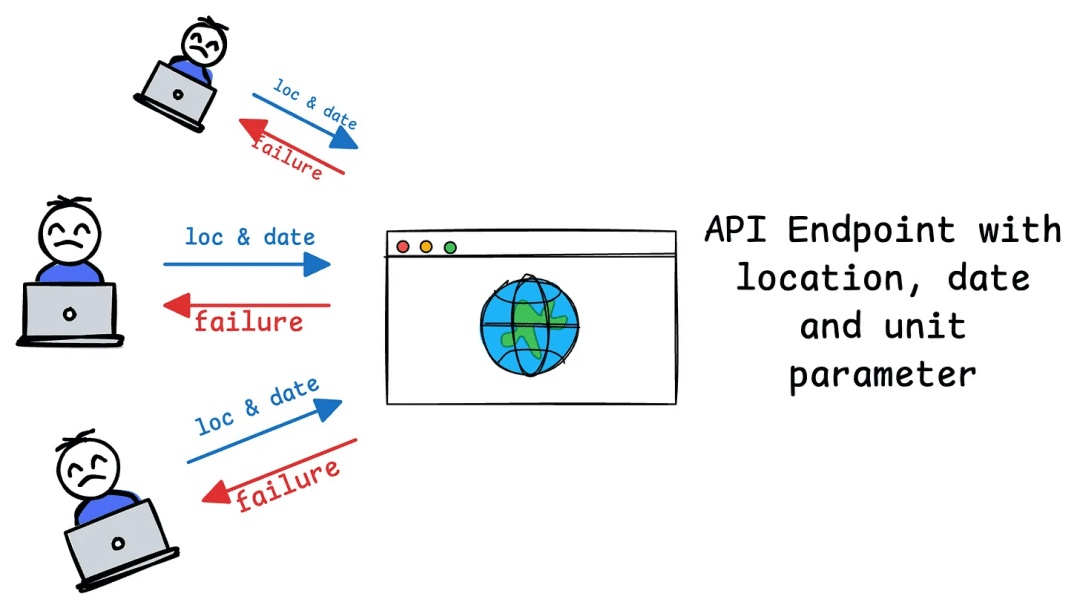

传统 API :

图片来源:ailydoseofds

-

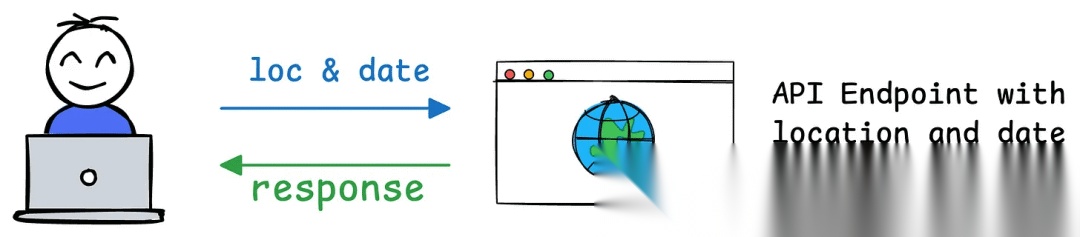

如果 API 最初需要两个参数(例如天气服务的位置和日期),用户集成应用程序会发送带有这些确切参数的请求。

图片来源:ailydoseofds

- 如果后来添加第三个必需参数(例如温度单位,如摄氏度或华氏度),API的合约就会改变。

- 这意味着所有 API 用户必须更新代码以包含新参数。如果不更新,请求可能失败、返回错误或提供不完整结果。

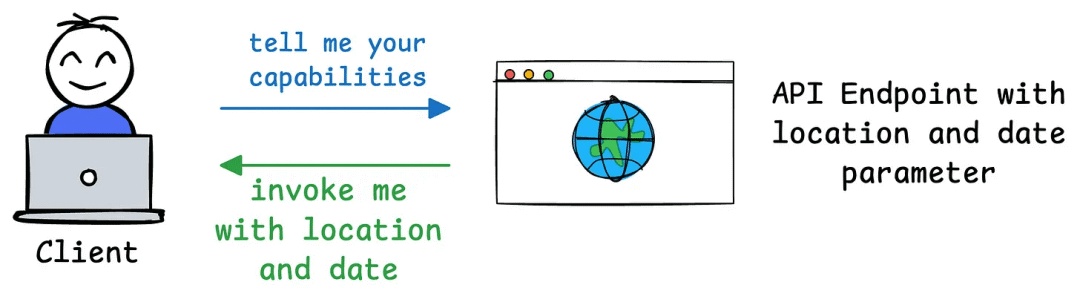

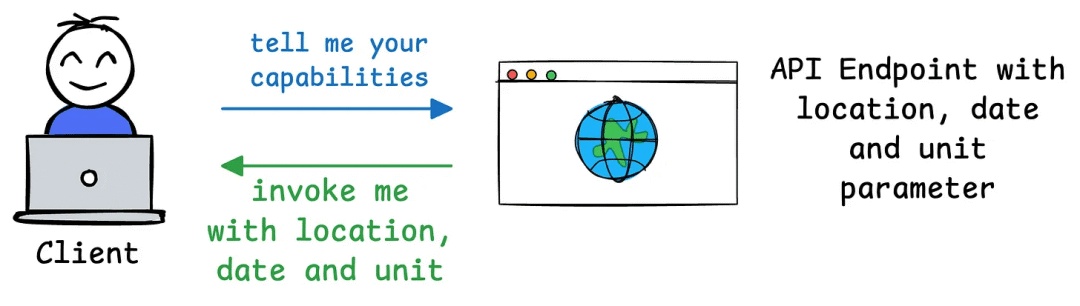

MCP 的设计解决了这个问题:

-

MCP 引入了与传统 API 截然不同的动态灵活方法。

-

当客户端(如 Claude 桌面版)连接到 MCP 服务器(如您的天气服务)时,它发送初始请求以了解服务器的能力。

图片来源:ailydoseofds

-

服务器响应其可用工具、资源、提示和参数的详细信息。例如,如果您的天气 API 最初支持位置和日期,服务器会将这些作为其功能的一部分进行通信。

图片来源:ailydoseofds

- 如果您稍后添加单位参数,MCP 服务器可以在下一次交换期间动态更新其功能描述。客户端不需要硬编码或预定义参数—只需查询服务器的当前功能并相应地适应。

- 这样,客户端可以及时调整其行为,使用更新的功能(例如在请求中包含单位),无需重写或重新部署代码。

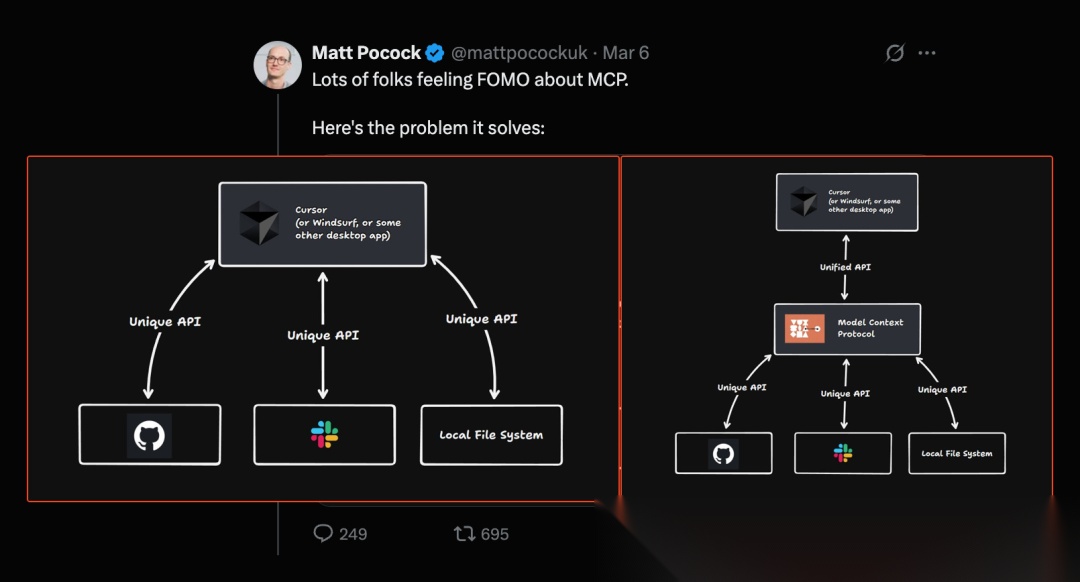

图源:https://www.latent.space/p/why-mcp-won

其实,MCP 也是用了 “中间层”的思想,让大模型使用工具标准化,让大模型调用工具更方便,焕发出新的生机。

2.3.4 MCP 的过程

图片来源:ailydoseofds

首先需要在主机上自动或手动配置 MCP 服务,当用户输入问题时, MCP 客户端让 大语言模型选择 MCP 工具,大模型选择好 MCP 工具以后, MCP 客户端寻求用户同意(很多产品支持配置自动同意),MCP 客户端请求 MCP 服务器, MCP 服务调用工具并将工具的结果返回给 MCP 客户端, MCP 客户端将模型调用结果和用户的查询发送给大语言模型,大语言模型组织答案给用户。

其实 RAG 、Function Call 和 MCP 本质上都是一样,都是为了借助外部工具帮助大模型完成更复杂的事情。

三、“看见” MCP 的过程

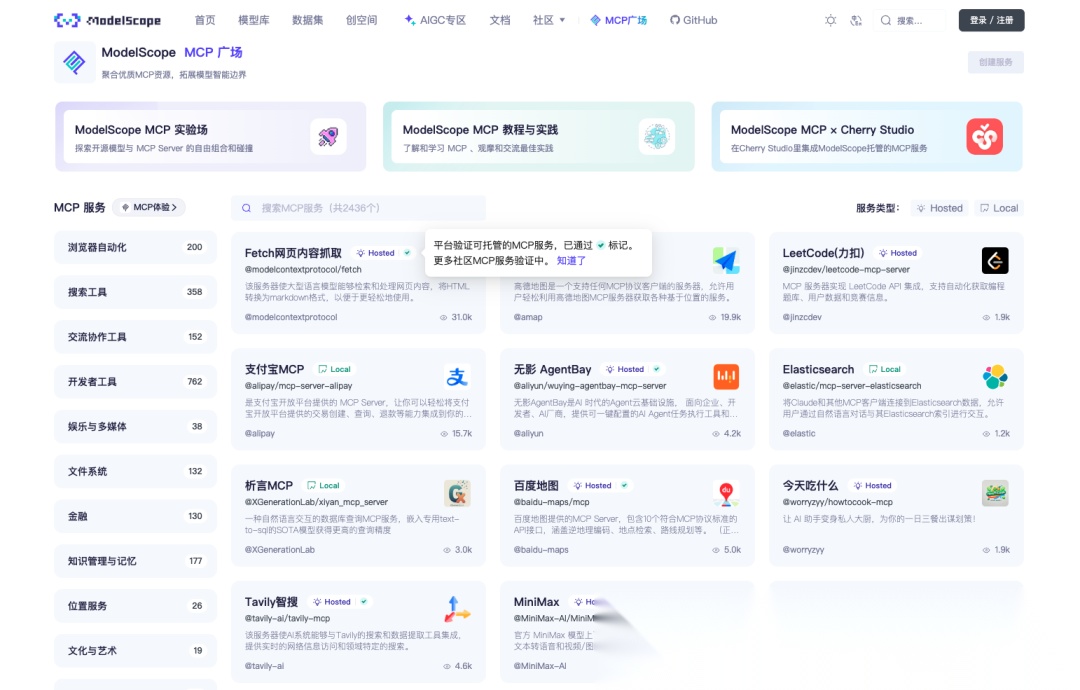

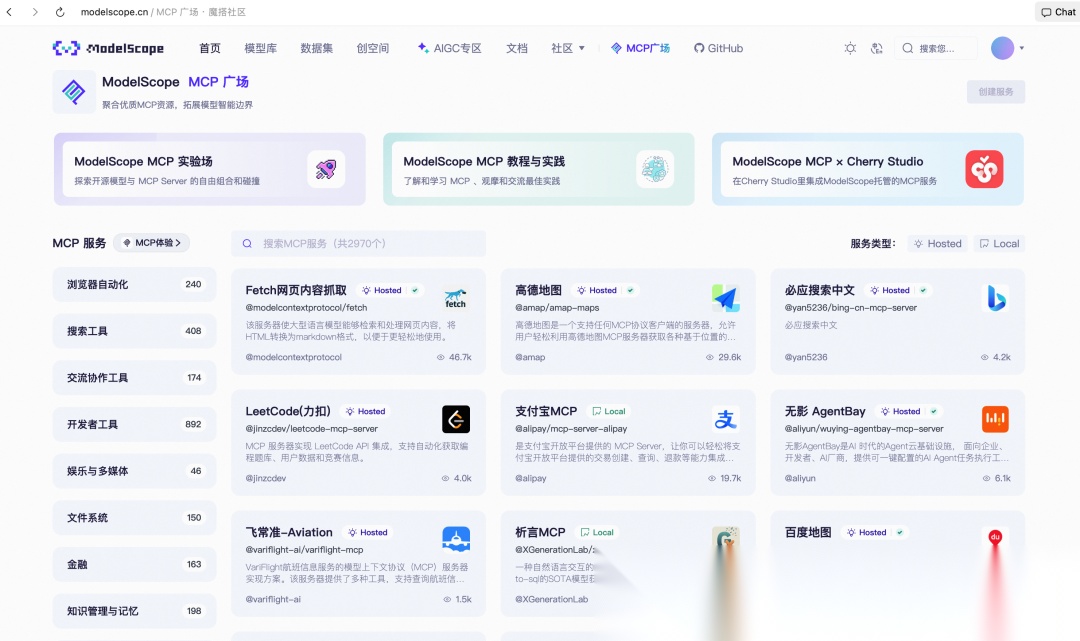

3.1 ModelScope

我们来到魔搭的 MCP 市场:https://modelscope.cn/mcp,这里只是为了演示,其他的 MCP 广场也是一样的。

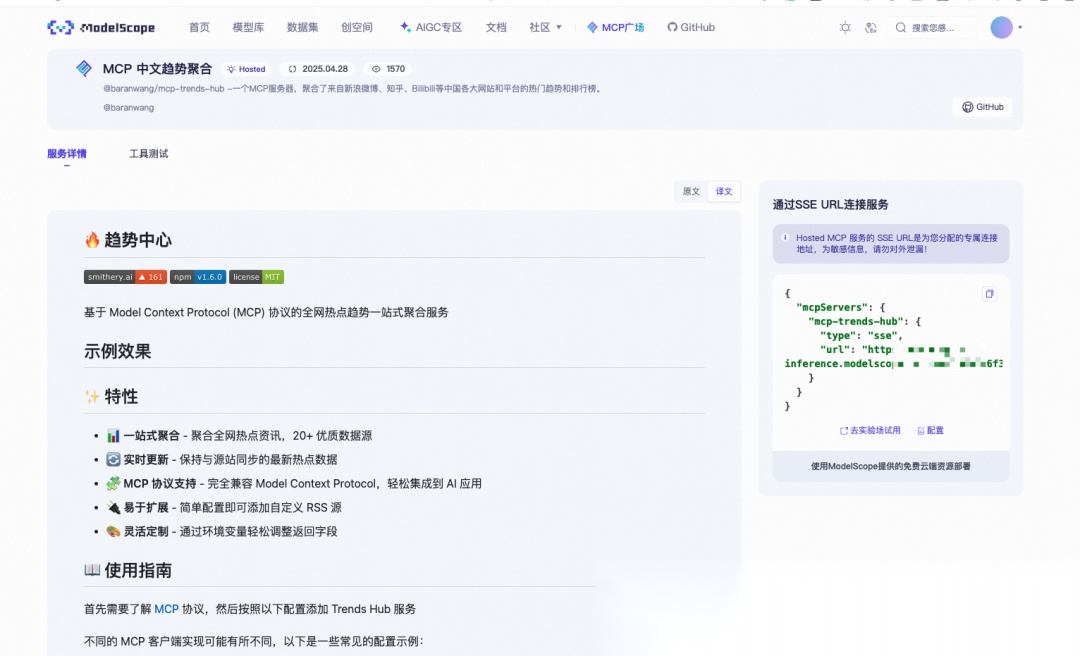

登录以后,我们选择一个 MCP 服务,点击右侧的“连接”按钮,就可以 获取 MCP服务的 SSE URL。

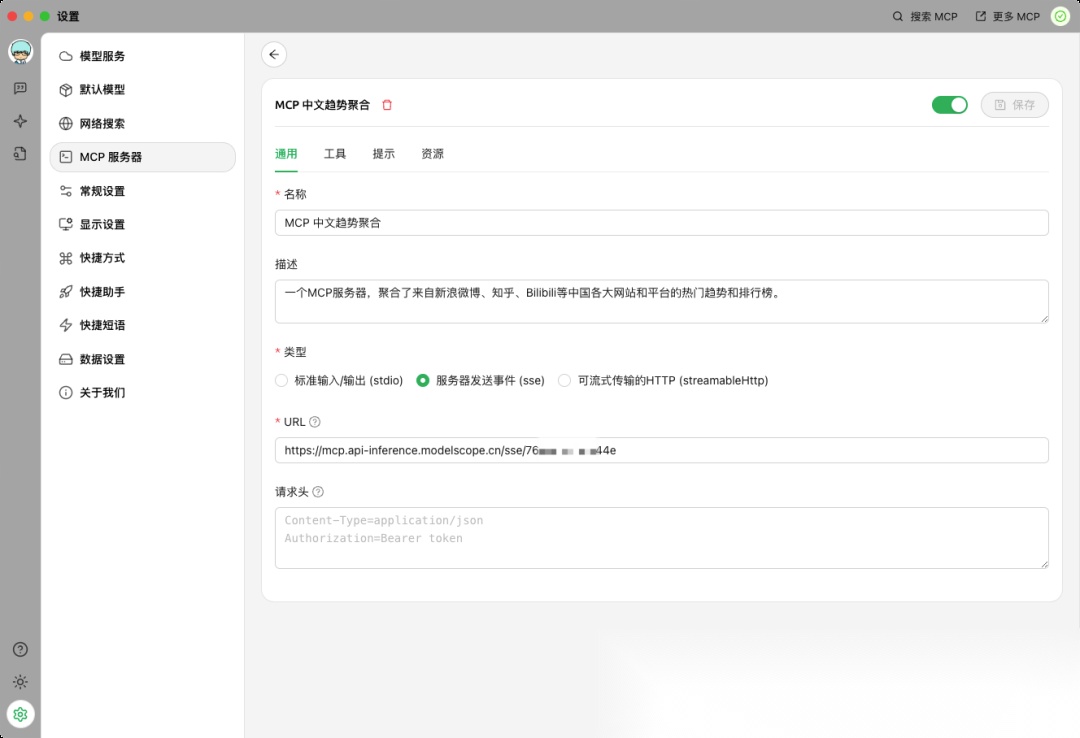

3.2 Cherry Studio

Cherry Studio 官网: https://cherry-ai.com/

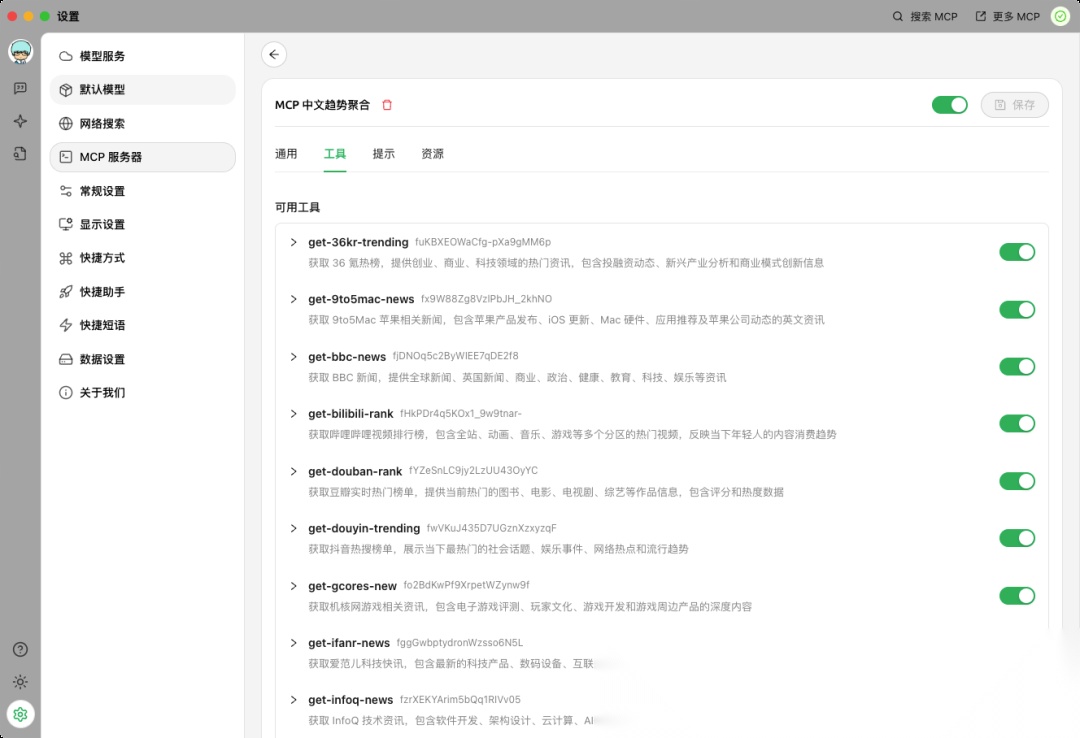

在右上角点击开启,就可以看到该 MCP 服务提供的工具、提示和资源。

可以单独开启和关闭每个可用的工具。

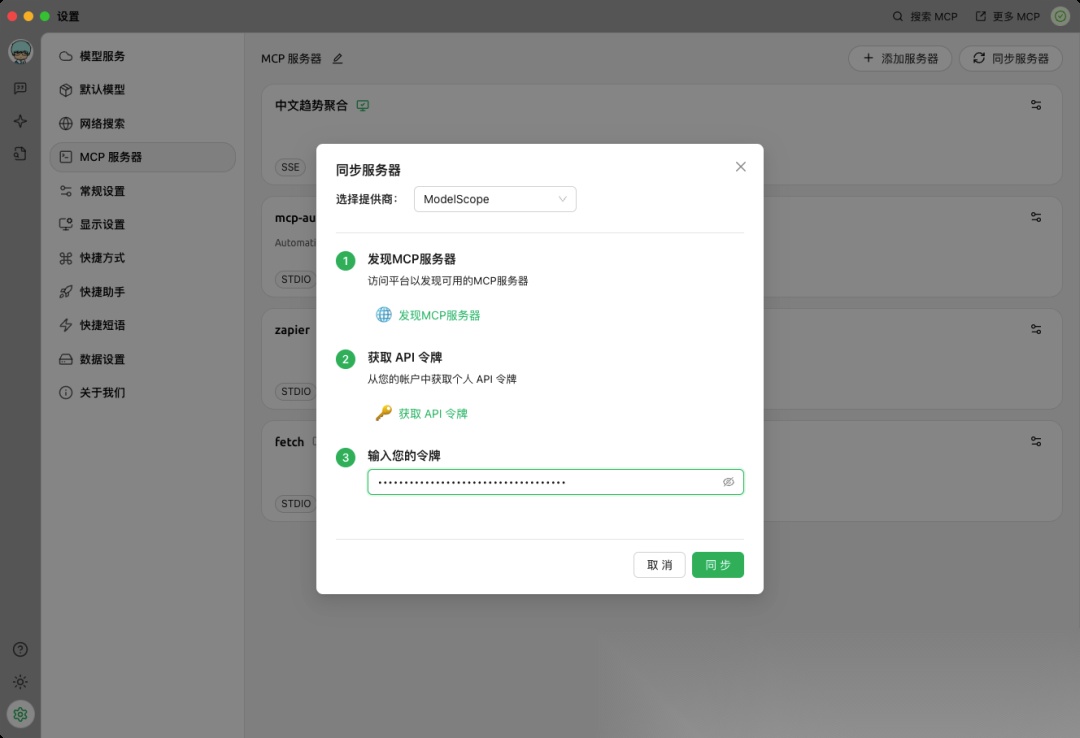

每个 MCP 服务手动配置太麻烦,大家也可以点击“同步服务器”,配置 ModelScope 的 API 令牌,配置之后就可以一键同步 ModelScope 上开启的 MCP 服务了。

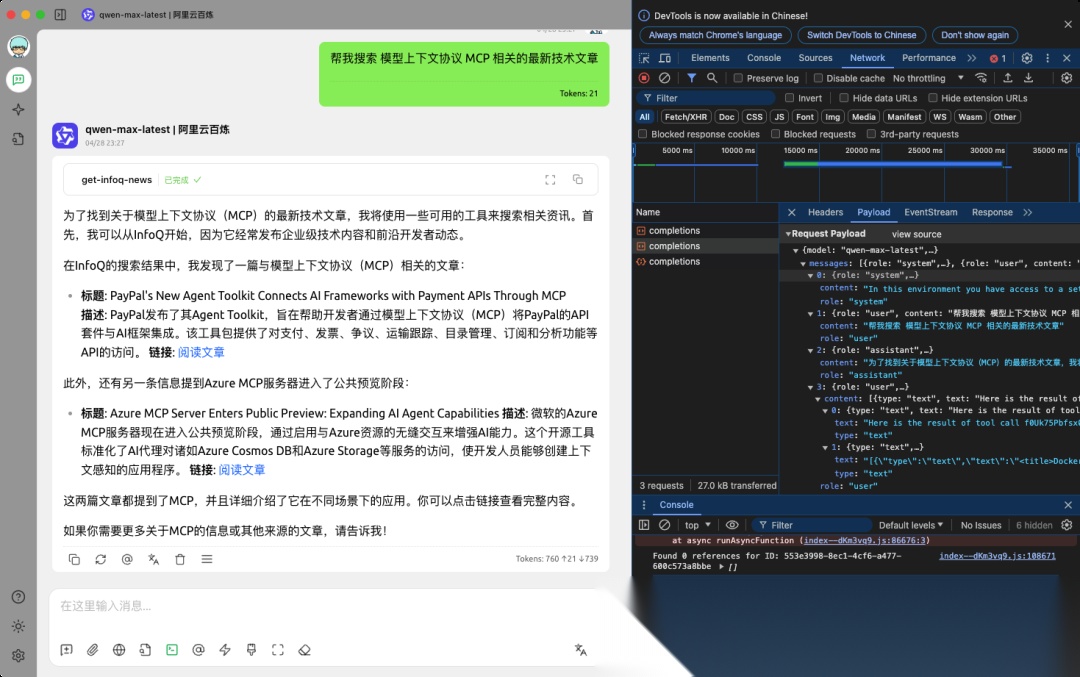

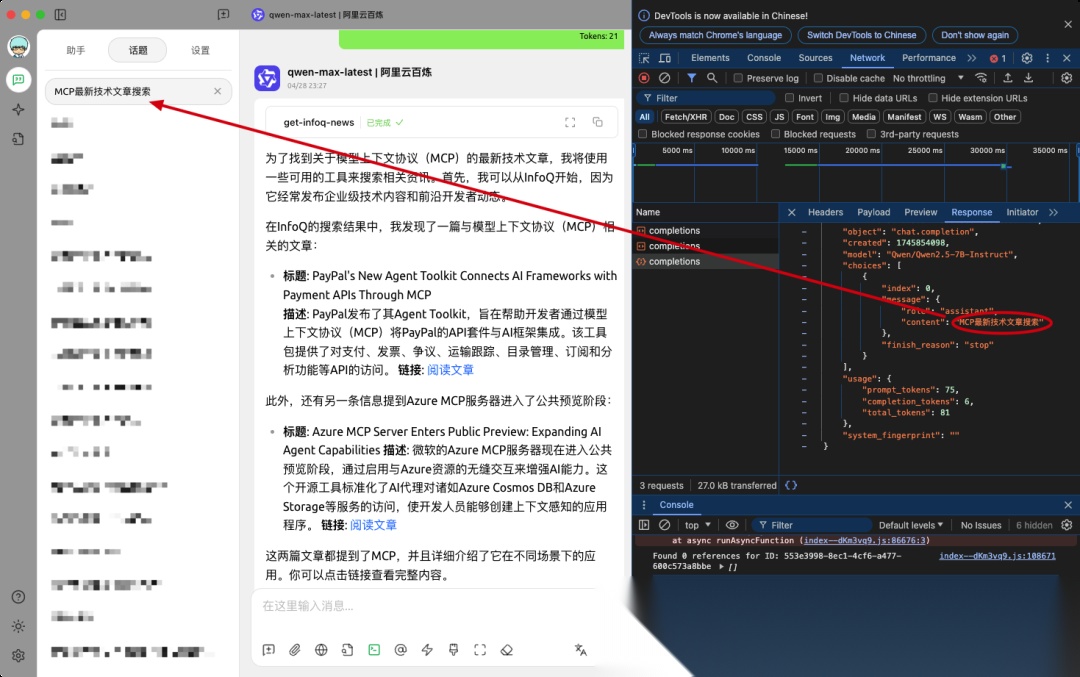

3.3 开发者模式

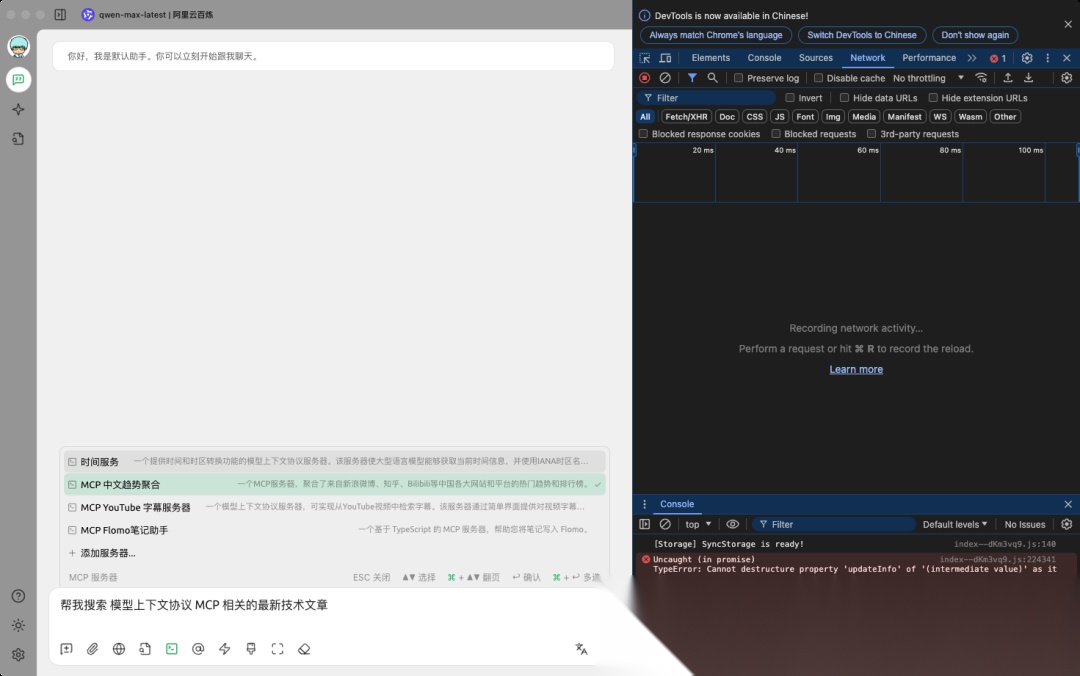

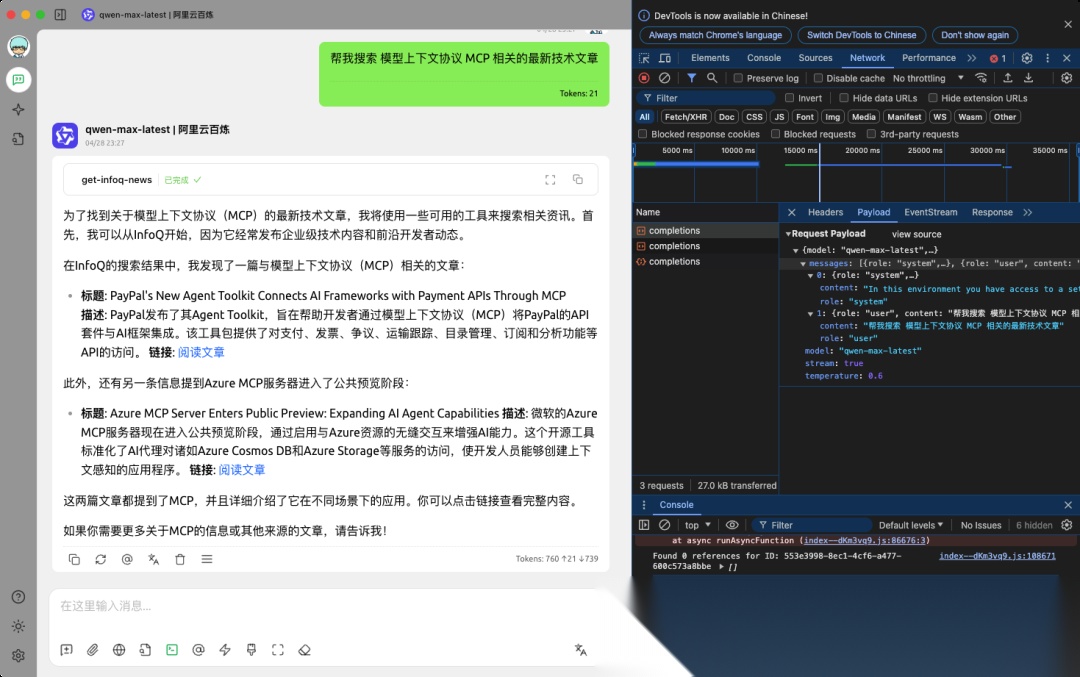

输入想要问的问题,开启需要的 MCP 服务。

为了看见 MCP 的执行过程,我们还需要通过 Ctrl+Shift+I(Mac端:Command+Option+I)打开开发者模式。

第一次请求,发送系统提示词,包括大模型可以选择的工具和要求等,然后给出用户的问题。

可以看到第二次调用,模型选择使用 infoq 工具获得资讯后组织语言展示给用户。

index =0 的系统提示词的内容:

{

主要包括:

- 工具使用格式 - 使用XML风格的标签来调用工具,包括工具名称和JSON格式的参数;

- 工具使用示例 - 展示了如何使用各种假设工具的例子,如文档问答、图像生成、Python解释器等;

- 可用工具列表 - 提供了多个实际可用的信息获取工具,主要是各种中英文新闻和内容平台的热门榜单;

- 工具使用规则 - 强调了正确使用参数、仅在需要时调用工具、不重复调用等规则;

- 最后,提示词以一个有趣的激励结束,表示如果任务正确完成,将获得一百万美元奖励。

index =1 的用户的内容

{

index =2 的助手的内容

{

index =3 的 用户的内容

{

第三次调用主要是为了给话题起标题。

大家,可以多开启几个工具或者多问几次,结合理论部分的讲解,会对 MCP 的过程会有更深刻的体会。

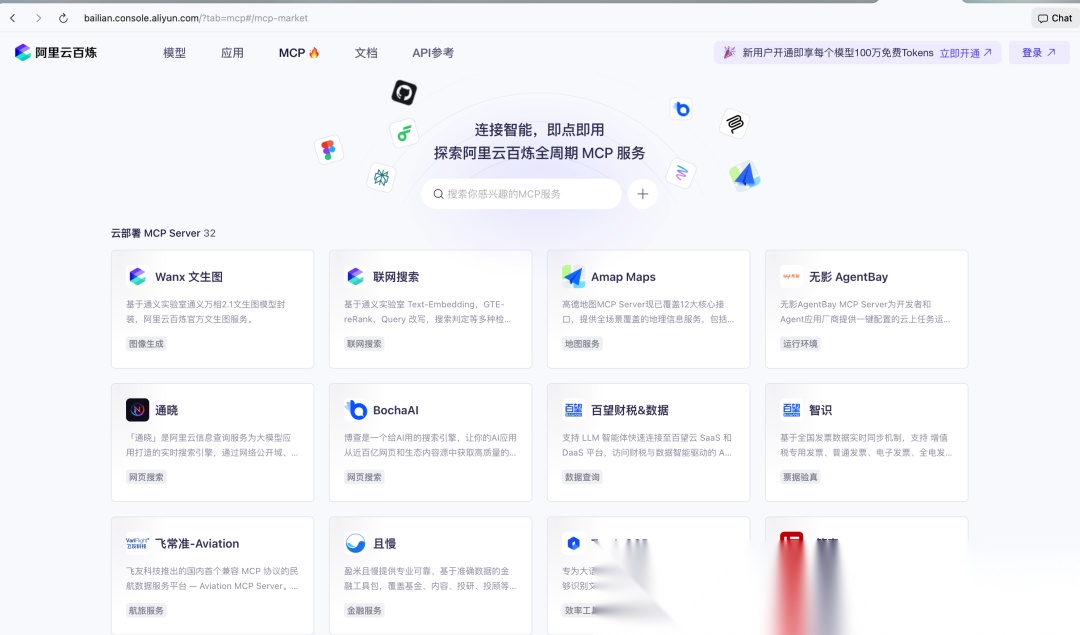

四、MCP 市场和 MCP 学习经验

4.1 MCP 市场

MCP 市场有很多,国内常见的有 ModelScope 和 阿里云百炼。

ModelScope:https://modelscope.cn/mcp

百炼 MCP 市场:https://bailian.console.aliyun.com/?tab=mcp#/mcp-market

4.2 MCP 学习技巧

大家还可以使用 Qwen (https://chat.qwen.ai)深入研究功能来系统学习 MCP。

我们感兴趣可以 Clone Cherry Studio 的源码,使用通义灵码、 Cursor 等 AI 编程工具,打开仓库:https://github.com/CherryHQ/cherry-studio 直接对你关心的问题进行提问,学习效果更好。

大家还可以通过我们之前分享的“通俗讲解专家智能体”,先用生活化的例子快速 GET 到意思,然后专业讲解,再给出易记的方法,最后通过 SVG 图解的方式帮助我们更直观理解知识。详情参见:《我是如何基于 DeepSeek-R1 构建出高效学习Agent的?》

五、观点

5.1 我发现的一些问题

**问题1:MCP 服务的配置、开关通常需要手动操作,使用方式还不够智能。这有点和 ChatGPT 的插件功能很相似,用户需要手动选择想要开启的插件,AI 还不能自动选择。**在大模型上下文和能力没有完全解决之前, MCP 下一步应该需要支持场景化(剧本式)开启和关闭,而不是全局的手动开启和关闭,开启太多 Tokens消耗大,开启太少可能影响功能的使用,某个场景在特定环节能够用到的 MCP 是相对确定的,需要类似工作流编排的形式来解决。

问题2:如果开启大量的 MCP 服务,客户端如果第一次将所有工具信息都发给大模型让大模型来抉择,会浪费大量 Tokens。未来这部分可能需要用本地模型来实现。

问题3:MCP 只是解决了协议的问题,工具的稳定性很重要,调用工具时服务不可用非常影响用户体验。应该有个工具可用性检测机制,不可用时及时下线。

问题4:现在 MCP 服务的封装主流还是前端框架和 Python,Java 来封装 MCP 似乎不太方便或者说上手门槛略高,未来可能需要再增加一个中间层来吃掉这个复杂度。

问题5:现在很多模型使用 MCP 的能力还不太强,有些场景哪怕适合调用某个 MCP 服务,有些模型也只会在需要明确告知使用 MCP 才会选择使用 MCP。

5.2 关于 MCP 只是一种“过渡”的说法

很多人认为 MCP 只是一个过渡,因为目前 MCP 设计存在一些局限性,而且,尽管 MCP 获得了 OpenAI、Google 等大厂的支持,但其成为永久行业标准仍存在不确定性。

我认为,MCP 确实存在一些缺点,但,MCP 确实为大模型更好地调用工具提供了一个非常好的协议。大模型想要做更复杂发挥出更大价值必然要学会使用工具,模型上下文协议非常有必要,只是未必一定是 Anthropic 这个版本。

MCP 可能是一个过渡,但这不是问题。其实 RAG 也存在诸多问题,可能也是一个过渡。其实,从更大尺度来看,我们以前用的电话、功能机、现在用的这些传统软件都是一种过渡。人,总是有时代局限性,比如我们手动挡的汽车和现在的自动驾驶没法比,也是一种过渡,但不妨碍它能够真正帮助到我们。

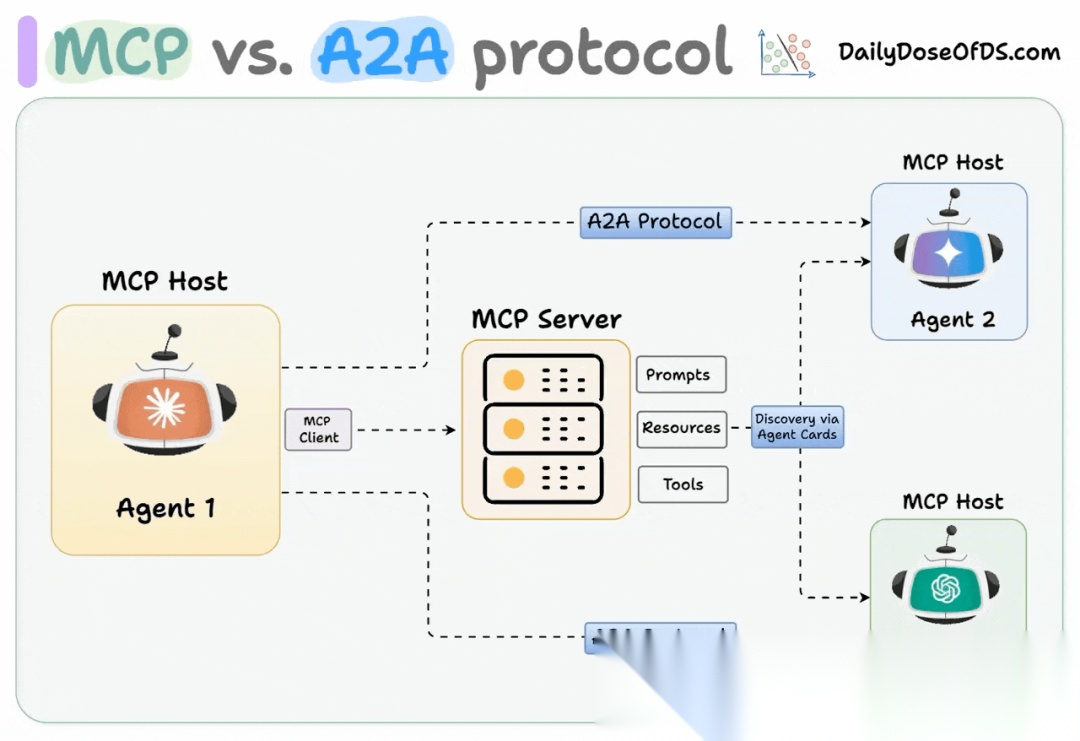

5.3 展望

当前,大模型现在还很难通过 MCP 实现人类一样的操作。比如 PPT 制作、视频剪辑,大模型还不能通过 MCP 实现类似真正和人类一样的智能的 “RPA”操作。

随着越来越多的服务支持 MCP,随着模型的服务不断增强,面向 MCP 的业务流程编排会或许成为主流。随着 AI 使用工具的能力不断增强,未来,能够带来的帮助也会更大。

图源:https://www.dailydoseofds.com/p/a-visual-guide-to-agent2agent-a2a-protocol/

MCP 试图在解决模型使用工具的问题(就像人可以使用扳手、可以开车、可以使用的电脑等)。但是,想要完成非常复杂的事情,智能体之间必然需要协同(就像上下级之间的管理和执行,同事之间分工合作),智能体之间的标准协议非常重要。谷歌最近发布的 A2A 协议则试图解决智能体之间通信的协议问题。正如上图所示,两者可以结合使用,MCP 用户服务的注册和发现, A2A 用户智能体之间的通信。

AI 技术的发展比想象地要更快,正如 ChatGPT 刚出来时,很多人说它永远不会取代我们,它的知识不会更新,现在 AI 搜索、RAG 已经成为常态。

现在,模型虽然存在速度慢的问题,存在上下文长度限制问题,存在幻觉的问题,存在好用模型价格高的问题等,这些都将逐渐得到解决。 AI 将会更好地使用工具,Agent 也将更加智能, Agent 之间的协同也将更加通畅。

关联文章:《一行代码不用改!搞定 HSF 转 MCP Server》

通义千问和LangChain搭建对话服务

结合通义千问和LangChain技术构建高效的对话模型,该模型基于自然语言处理技术提升语义理解和用户交互体验。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)