一文速通大模型本质与原理:程序员必知的“概率缝合怪“与token奥秘

本文以通俗方式解释了大语言模型的本质是"概率缝合怪",通过预测下一个token的概率来生成文本。介绍了温度参数如何控制回答随机性,以及token作为模型基本语言单位的概念。token不仅是文本处理的最小单位,也是计费依据。同时提到了上下文窗口对模型理解能力的影响,以及AI在总结、数据分析、创作等领域的广泛应用,并预告了将分享RAG应用和智能聊天机器人的构建方法。

本文以通俗方式解释了大语言模型的本质是"概率缝合怪",通过预测下一个token的概率来生成文本。介绍了温度参数如何控制回答随机性,以及token作为模型基本语言单位的概念。token不仅是文本处理的最小单位,也是计费依据。同时提到了上下文窗口对模型理解能力的影响,以及AI在总结、数据分析、创作等领域的广泛应用,并预告了将分享RAG应用和智能聊天机器人的构建方法。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

现在基本已经有全民 AI 浪潮的势头了,很多人的工作生活已经离不开大模型。但你了解大模型的本质吗?它的工作原理是什么?token 又是怎么来的?

今天就带大家用一篇文章速通大语言模型,快速搞懂这个概念!

大模型的本质

想象你有个朋友,他 7x24 小时刷遍互联网,但他并不真正“理解”任何知识,只是死记硬背人类说过的话。当你提问时,他就像在玩“关键词接龙”,把最常见的词句拼接在一起,组合成看起来合理的答案。

这就是大语言模型的本质:文本拼接器。

那么什么样的答案叫“合理”?

比如我说 唱、跳,你会跟 rap! 我说 回答我!你会说look in my eyes,tell me why why baby why!

这些都合理吧?

大模型 就好比浏览了人类编写的数十亿文本,它会根据我们输入的文本,“猜测”接下来会出现什么词,这些词的概率是多少。比如:

| look in my eyes | 3.3% |

|---|---|

| 你回答我 | 3.1% |

| 你爱我吗 宝贝 | 2.5% |

然后根据概率选择一个词,拼接上面的文本中后,继续询问“下一个词是什么”。

| tell me why | 5.3% |

|---|---|

| answer me | 3.5% |

| kiss me | 3.3% |

就这样不断地询问,最终得到结果。

“回答我!look in my eyes tell me why”

所以我们称大语言模型的本质为:概率缝合怪。

看到这你是否会产生一个疑问?

如果大模型就是按照概率排序来选择“下一个词”,那么同样的问题,每次询问大语言模型得到的结果不是应该完全一致吗?

这种情况我们一般称之为:人机。

为了避免这种情况,大语言模型引入了“温度”这个概念,用它来控制下一个词的“随机性”,而不是完全按照概率排名。

于是即便是同一个提示词,我们每次得到的内容也可能会不同。

像 DeepSeek 给出的接口就建议,代码生成/数据题解类,温度设置的低一些,确保回答的稳定性和正确性。创意类的写作,温度设置的就高一些,确保回答的发散性和创造性。

什么是 token?

理解温度后,我们再学习 token 这个概念。

那我问你。

大模型给出回答里,“look in my eyes” 是一个词吗?很明显不是。

在大语言模型场景,其实每次添加的是一个 token,而不是词。

那什么是 token?

实际上,大语言模型是个文盲,它完全不懂 look in my eyes 的含义,只会利用一个叫分词器的家伙,把这些文本进行切割,切完的小文本就是一个个 token。

为什么要切?

前面我们提到大语言模型的本质是概率缝合怪,那么只有把大文本切成一个一个小文本,才好按照概率排名来选择“下一个词”,近而得到“合理”的回答。

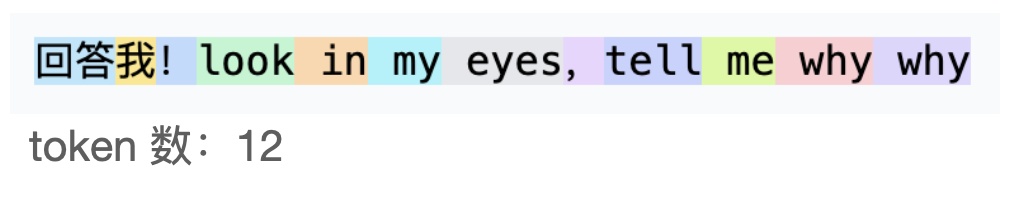

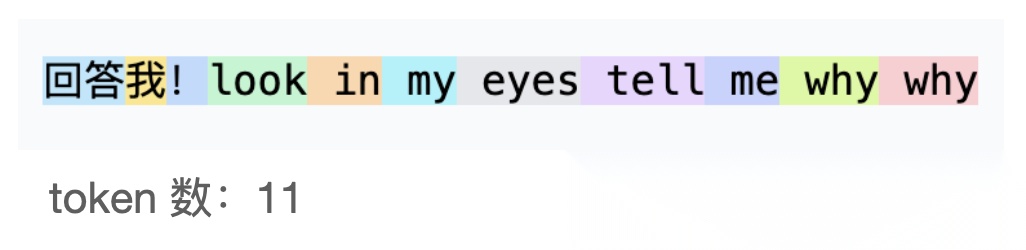

可能这样切。

也可能这样切。

这完全取决于不同大模型的分词方法。

比如通过统计学来实现分词,在统计大量文本后发现“回答” 这两个字,经常出现,那么“回答”就可以变成一个 token。

发现 “!” 经常出现,那么“!”也是一个 token。

发现“ing” 经常出现,那么 “ing” 也是一个 token。

所以 token 可以是一个单词、单词组合、标点符号甚至是单词的一部分。如果说我们人类以字为基本语言单位,那么大语言模型就是以 token 为基本语言单位。

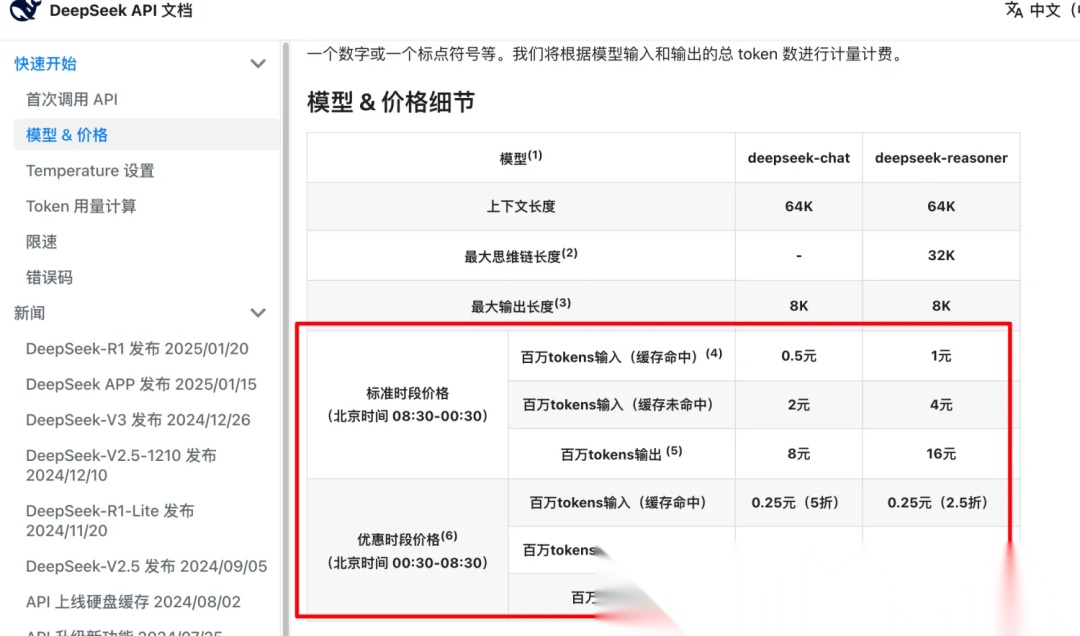

除此之外,token 还有一个非常现实的作用:计费。

和小说按字数计费类似,token 数代表了大语言模型在计算和生成内容时所消耗的资源。

这里还有一个概念叫做上下文窗口。

简单理解就是大模型可以处理 token 数量,上下文越大,能处理的 token 数越多。能处理的 token 数量越多,大模型对信息理解就会越充分,最终给出的结果就会更“合理”。

以前,在大模型能处理 token 数较少的情况下,让它总结一本《三体 2:黑暗森林》(约 30 万字),几乎是不可能的——它会直接“宕机”,因为无法一次性处理这么大量的 token。

于是有聪明的朋友就想到了分批总结,将整本书拆成多个部分,挨个处理。即,让模型先总结一部分,然后在下一批处理中,携带上一批的总结内容继续提问。

这种方法虽然在一定程度上缓解了 token 限制,但由于每次都需要归纳上一批的内容,信息传递过程中不可避免地丢失了大量细节,导致最终的总结变得更加概括,甚至可能遗漏关键情节。

但如今,随着大模型的飞速发展,部分先进模型已经能够一次性处理整本《三体 2》,不再需要分批。这意味着,它们能更完整地理解上下文,保留更多细节,从而生成更加精准、全面的总结。

AI 的应用场景极为广泛,不仅可以用于总结论文、提炼报告核心内容,还能优化数据分析流程,甚至辅助创作和决策。无论是普通上班族还是程序员,AI 都已成为不可忽视的重要工具。我们应当尽快拥抱 AI,充分利用其优势,以提升工作效率和竞争力。

接下来,我们将分享如何自动化构建 RAG 应用、实现智能聊天机器人等前沿 AI 技术,帮助大家直观、便捷地理解并应用 AI。

无论是普通上班族还是程序员,AI 都已成为不可忽视的重要工具。我们应当尽快拥抱 AI,充分利用其优势,以提升工作效率和竞争力。

接下来,我们将分享如何自动化构建 RAG 应用、实现智能聊天机器人等前沿 AI 技术,帮助大家直观、便捷地理解并应用 AI。

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)