Python 2025:AI赋能下的智能编程与新范式革命

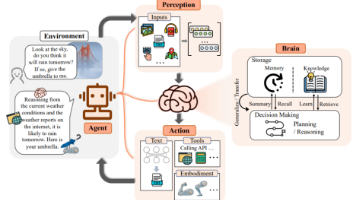

Python已成为AI驱动开发的核心引擎,2025年数据显示其占比达26.14%居首。文章分析Python在AI时代的五大技术革新:1)AI代码助手显著提升开发效率;2)深度学习框架在性能与易用性双突破;3)自动化智能体系统实现自主决策;4)类型系统与异步编程的现代特性;5)AI应用部署的云原生实践。未来趋势包括AI原生开发、多模态智能体和边缘AI部署等。开发者需掌握AI协作开发、智能体框架等技能

从AI代码助手到智能体系统,Python正在重塑软件开发的基本范式

在2025年的技术图景中,Python已经从一个"简单易学"的编程语言蜕变为AI驱动开发的核心引擎。根据TIOBE 2025年8月编程语言排名,Python以26.14% 的历史最高占比稳居榜首,这很大程度上得益于AI技术与Python生态的深度整合。

本文将深入探讨Python在AI时代的五大技术革命:AI代码助手带来的开发效率飞跃、深度学习框架的持续演进、自动化智能体系统的成熟应用、类型系统与异步编程的范式升级,以及AI应用部署的全新实践。

1 AI代码助手:开发效率的量子跃迁

1.1 AI辅助编程的现状

2025年,AI代码助手已成为Python开发者的标准配置。斯坦福大学的研究表明,使用Microsoft Copilot、Cursor或Google Gemini Code Assist等工具时,Python开发效率可提升20%。

# AI助手生成的深度学习代码示例

import torch

import torch.nn as nn

import torch.optim as optim

class NeuralNetwork(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(NeuralNetwork, self).__init__()

self.layer1 = nn.Linear(input_size, hidden_size)

self.relu = nn.ReLU()

self.layer2 = nn.Linear(hidden_size, output_size)

def forward(self, x):

x = self.layer1(x)

x = self.relu(x)

x = self.layer2(x)

return x

# AI助手建议的模型训练优化方案

def train_model(model, train_loader, criterion, optimizer, num_epochs):

model.train()

for epoch in range(num_epochs):

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

if batch_idx % 100 == 0:

print(f'Epoch {epoch}, Batch {batch_idx}, Loss {loss.item()}')这种效率提升主要源于Python拥有更丰富的代码库供AI模型训练,使AI助手能提供更准确的代码补全和建议。

1.2 智能代码生成与优化

AI代码助手不仅能完成简单的代码补全,还能进行复杂算法优化和代码重构:

# AI助手优化的数据预处理管道

def optimize_data_pipeline(data):

"""

AI助手优化的数据处理函数

原函数处理大型数据集时内存占用过高

"""

# AI助手建议使用更高效的内存处理方式

import numpy as np

import pandas as pd

# 使用分块处理大型数据集

chunk_size = 10000

processed_chunks = []

for chunk in pd.read_csv(data, chunksize=chunk_size):

# 应用数据处理逻辑

chunk = chunk.dropna()

chunk['processed_value'] = chunk['value'].apply(lambda x: x * 2)

processed_chunks.append(chunk)

# 合并处理后的块

result = pd.concat(processed_chunks, ignore_index=True)

return result

# AI助手生成的异步高效版本

async def async_data_processing(data_source):

"""AI助手生成的异步数据处理函数"""

import aiofiles

import asyncio

async with aiofiles.open(data_source, 'r') as f:

content = await f.read()

# 异步处理数据

processed_data = await asyncio.to_thread(process_data, content)

return processed_data2 深度学习与AI框架:性能与易用性的双重突破

2.1 框架性能优化

2025年,Python深度学习框架持续演进,TensorFlow和PyTorch仍然是主流选择,但在性能和易用性方面都有显著提升。

# PyTorch Lightning的现代化训练示例

import pytorch_lightning as pl

from torch.utils.data import DataLoader, Dataset

class AdvancedModel(pl.LightningModule):

def __init__(self, learning_rate=1e-3):

super().__init__()

self.save_hyperparameters()

self.layer1 = nn.Linear(28 * 28, 128)

self.layer2 = nn.Linear(128, 10)

self.dropout = nn.Dropout(0.2)

def forward(self, x):

x = x.view(x.size(0), -1)

x = torch.relu(self.layer1(x))

x = self.dropout(x)

x = self.layer2(x)

return x

def training_step(self, batch, batch_idx):

x, y = batch

y_hat = self(x)

loss = nn.CrossEntropyLoss()(y_hat, y)

self.log('train_loss', loss)

return loss

def configure_optimizers(self):

return torch.optim.Adam(self.parameters(), lr=self.hparams.learning_rate)

# 使用Lightning的高级功能

trainer = pl.Trainer(

max_epochs=10,

accelerator='auto',

devices='auto',

precision='16-mixed',

enable_progress_bar=True,

deterministic=True

)2.2 模型部署与优化

模型部署方面,ONNX和Triton Inference Server成为生产环境的标准选择:

# 模型优化与导出

def optimize_and_export_model(model, sample_input):

"""优化模型并导出为生产格式"""

# 模型量化

quantized_model = torch.quantization.quantize_dynamic(

model, {torch.nn.Linear}, dtype=torch.qint8

)

# 转换为ONNX格式

torch.onnx.export(

quantized_model,

sample_input,

"optimized_model.onnx",

opset_version=15,

input_names=['input'],

output_names=['output'],

dynamic_axes={'input': {0: 'batch_size'}, 'output': {0: 'batch_size'}}

)

# 验证导出的模型

validate_onnx_model("optimized_model.onnx", sample_input)

return quantized_model

# 使用Triton进行部署

def create_triton_config(model_name, max_batch_size=8):

"""创建Triton推理服务器配置"""

config = f"""

name: "{model_name}"

platform: "onnxruntime_onnx"

max_batch_size: {max_batch_size}

input [

{{

name: "input"

data_type: TYPE_FP32

dims: [ 784 ]

}}

]

output [

{{

name: "output"

data_type: TYPE_FP32

dims: [ 10 ]

}}

]

"""

with open("model_config.pbtxt", "w") as f:

f.write(config)3 自动化智能体系统:从脚本到自主决策

3.1 智能体开发框架

2025年,AI智能体从简单的脚本工具发展为能够自主决策和执行复杂任务的系统。

from langchain.agents import AgentType, initialize_agent

from langchain.llms import OpenAI

from langchain.tools import Tool

class ResearchAgent:

def __init__(self, api_key):

self.llm = OpenAI(temperature=0, openai_api_key=api_key)

self.tools = self.setup_tools()

self.agent = initialize_agent(

self.tools, self.llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

def setup_tools(self):

"""设置智能体工具集"""

web_search_tool = Tool(

name="Web Search",

func=self.web_search,

description="Useful for searching current information from the web"

)

data_analysis_tool = Tool(

name="Data Analysis",

func=self.analyze_data,

description="Useful for analyzing datasets and generating insights"

)

return [web_search_tool, data_analysis_tool]

def execute_research_task(self, task_description):

"""执行研究任务"""

prompt = f"""

请执行以下研究任务:{task_description}

请按照以下步骤进行:

1. 收集相关信息和数据

2. 分析数据并提取关键见解

3. 生成综合报告

4. 提供建议和下一步行动

"""

result = self.agent.run(prompt)

return result

# 使用示例

research_agent = ResearchAgent(api_key="your_api_key")

report = research_agent.execute_research_task("分析2025年Python在AI领域的最新趋势")3.2 多智能体协作系统

复杂任务往往需要多个智能体协同工作,每个智能体专注于自己的专业领域:

class MultiAgentSystem:

def __init__(self):

self.agents = {

'data_scientist': DataScientistAgent(),

'software_engineer': SoftwareEngineerAgent(),

'business_analyst': BusinessAnalystAgent()

}

def coordinate_project(self, project_description):

"""协调多智能体完成项目"""

# 任务分解

tasks = self.decompose_project(project_description)

# 分配任务给合适的智能体

results = {}

for task_name, task_description in tasks.items():

best_agent = self.select_best_agent(task_name)

result = best_agent.execute_task(task_description)

results[task_name] = result

# 整合结果

final_result = self.integrate_results(results)

return final_result

def decompose_project(self, project_description):

"""分解项目为具体任务"""

# 使用LLM分析项目并分解任务

return {

"data_analysis": "分析相关数据并提取见解",

"code_development": "开发必要的软件组件",

"business_insights": "提供商业建议和可行性分析"

}4 类型系统与异步编程:现代Python的核心特性

4.1 高级类型提示

Python的类型系统在2025年变得更加强大和表达力丰富,支持复杂的类型操作:

from typing import TypeVar, Generic, AsyncIterator

from pydantic import BaseModel

from datetime import datetime

T = TypeVar('T')

class PaginatedResponse(Generic[T]):

"""分页响应模型"""

items: list[T]

total_count: int

page: int

page_size: int

has_more: bool

class AIResponse(BaseModel):

"""AI响应模型"""

content: str

confidence: float

sources: list[str]

generated_at: datetime

model_version: str

# 复杂的类型组合

def process_ai_responses() -> AsyncIterator[PaginatedResponse[AIResponse]]:

"""处理AI响应流"""

async def generator():

# 异步生成分页响应

for page in range(1, 4):

responses = [AIResponse(

content=f"Response {i}",

confidence=0.9 - i * 0.1,

sources=[f"source_{i}"],

generated_at=datetime.now(),

model_version="2.1.0"

) for i in range(10)]

yield PaginatedResponse[AIResponse](

items=responses,

total_count=30,

page=page,

page_size=10,

has_more=page < 3

)

return generator()4.2 异步编程新模式

Python 3.14的并行线程处理特性进一步简化了并发编程:

import asyncio

from concurrent.futures import ThreadPoolExecutor

import time

async def main():

"""异步主函数"""

# 创建线程池执行器

with ThreadPoolExecutor(max_workers=4) as executor:

# 并行执行CPU密集型任务

loop = asyncio.get_event_loop()

tasks = [

loop.run_in_executor(executor, cpu_intensive_task, i)

for i in range(10)

]

results = await asyncio.gather(*tasks)

print(f"Results: {results}")

def cpu_intensive_task(task_id):

"""CPU密集型任务"""

print(f"Starting task {task_id}")

time.sleep(1) # 模拟计算

return f"Result_{task_id}"

# 运行异步程序

if __name__ == "__main__":

asyncio.run(main())5 AI应用部署与规模化:生产环境最佳实践

5.1 容器化与云原生部署

2025年,Python AI应用的容器化部署已成为行业标准:

dockerfile

# Python AI应用Dockerfile

FROM python:3.12-slim

# 安装系统依赖

RUN apt-get update && apt-get install -y \

gcc \

g++ \

&& rm -rf /var/lib/apt/lists/*

# 设置工作目录

WORKDIR /app

# 复制依赖文件

COPY requirements.txt .

# 安装Python依赖

RUN pip install --no-cache-dir -r requirements.txt

# 复制应用代码

COPY . .

# 暴露端口

EXPOSE 8000

# 设置环境变量

ENV PYTHONPATH=/app

ENV PYTHONUNBUFFERED=1

# 启动应用

CMD ["gunicorn", "-w", "4", "-k", "uvicorn.workers.UvicornWorker", "main:app"]

对应的requirements.txt文件:

text

fastapi==0.104.1 uvicorn[standard]==0.24.0 torch==2.1.0 transformers==4.35.0 langchain==0.0.330 pydantic==2.5.0 gunicorn==21.2.0

5.2 性能监控与优化

生产环境的AI应用需要完善的监控体系:

from prometheus_client import Counter, Histogram, generate_latest

from fastapi import Response, Request

import time

# 定义监控指标

REQUEST_COUNT = Counter('request_count', 'Total API Requests', ['method', 'endpoint'])

REQUEST_LATENCY = Histogram('request_latency_seconds', 'Request latency', ['endpoint'])

MODEL_INFERENCE_TIME = Histogram('model_inference_seconds', 'Model inference time')

def monitor_performance(func):

"""性能监控装饰器"""

async def wrapper(request: Request, call_next):

start_time = time.time()

response = await call_next(request)

duration = time.time() - start_time

# 记录指标

REQUEST_LATENCY.labels(endpoint=request.url.path).observe(duration)

REQUEST_COUNT.labels(method=request.method, endpoint=request.url.path).inc()

return response

return wrapper

@app.get("/metrics")

async def metrics():

"""暴露监控指标"""

return Response(generate_latest(), media_type="text/plain")

# 模型推理监控

def monitor_model_inference(model_func):

"""模型推理监控装饰器"""

def wrapper(*args, **kwargs):

start_time = time.time()

result = model_func(*args, **kwargs)

inference_time = time.time() - start_time

MODEL_INFERENCE_TIME.observe(inference_time)

return result

return wrapper6 未来展望:Python在AI领域的发展趋势

基于2025年的技术发展,Python在AI领域将继续沿以下几个方向演进:

-

AI原生开发:开发工具和框架将更加深度集成AI能力,实现代码自动生成和优化。

-

多模态智能体:AI智能体将支持文本、图像、音频的多模态理解和生成。

-

边缘AI部署:小型化、高效能的AI模型将在边缘设备上广泛部署。

-

自主学习系统:AI系统将具备持续学习和自我优化的能力。

-

伦理与安全:AI伦理和模型安全性将成为核心考量因素。

结语

Python在2025年已经发展成为AI驱动开发的首选平台,通过AI代码助手大幅提升开发效率,通过先进的深度学习框架支持复杂模型构建,通过智能体系统实现自主决策和执行,并通过完善的类型系统和异步编程支持构建可靠的高性能应用。

对于开发者来说,掌握这些新技术不仅意味着能够构建更强大的AI应用,更是为了在快速发展的技术环境中保持竞争力。AI时代的Python开发不再是单纯的编写代码,而是与AI协作,共同解决复杂问题。

学习建议:

-

掌握AI助手使用:熟练运用AI代码助手提升开发效率。

-

深入异步编程:掌握Python 3.14的并行线程处理特性。

-

学习智能体开发:了解LangChain等智能体开发框架。

-

关注模型优化:学习模型量化和优化技术,提升部署效率。

-

重视安全伦理:在追求技术创新的同时,重视AI伦理和安全性。

Python在AI领域的未来充满了可能性,随着技术的不断成熟和工具的进一步完善,我们有理由相信Python将继续在AI时代发挥关键作用,帮助构建更加智能、高效和可靠的未来应用。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)