【AI大模型学习路线】第一阶段之大模型开发基础——第三章(大模型实操与API调用)如何通过API调用大模型?

【AI大模型学习路线】第一阶段之大模型开发基础——第三章(大模型实操与API调用)如何通过API调用大模型?

·

【AI大模型学习路线】第一阶段之大模型开发基础——第三章(大模型实操与API调用)如何通过API调用大模型?

【AI大模型学习路线】第一阶段之大模型开发基础——第三章(大模型实操与API调用)如何通过API调用大模型?

文章目录

欢迎宝子们点赞、关注、收藏!欢迎宝子们批评指正!

祝所有的硕博生都能遇到好的导师!好的审稿人!好的同门!顺利毕业!

大多数高校硕博生毕业要求需要参加学术会议,发表EI或者SCI检索的学术论文会议论文。详细信息可关注VX “

学术会议小灵通”或参考学术信息专栏:https://fighting.blog.csdn.net/article/details/146692330

前言

结合大模型的发展现状与前景,当前我们可以通过多种方式在实际项目中调用大模型(如GPT-4、Claude、Gemini、文心一言等),最主要和常用的方式之一就是通过API(应用程序接口)调用。下面我们来系统地讲解如何通过API调用大模型,并结合一个Python代码示例来说明实操过程。

一、大模型发展现状与前景简述

1. 发展现状

- 大模型如OpenAI的GPT-4、Google的Gemini、Anthropic的Claude、百度的文心一言、阿里的通义千问等,已具备强大的文本生成、问答、翻译、编程、推理等能力。

- 各大厂商均提供了开放API服务,支持通过HTTP请求远程调用模型能力。

- 多数API采用RESTful接口,数据交换格式通常为JSON,使用简单,易集成。

2. 前景

- 大模型将嵌入到各种软件工具、智能助手、代码开发、数据分析、自动文档生成、自动化办公等场景中。

- 趋势是:模型即服务(Model-as-a-Service, MaaS),无需本地部署,只需调用API即可获取强大推理能力。

- 企业和开发者可以灵活调用多模态、领域专用、私有化部署的大模型API。

二、大模型API调用的基本流程

以下是标准步骤,以OpenAI GPT-4为例,调用流程基本一致于其他大模型API:

1. 注册账号并获取API Key

如在 OpenAI官网 注册并获取你的API_KEY。

2. 安装必要库(如 openai)

pip install openai

3. 编写Python调用代码

import openai

# 设置 API 密钥

openai.api_key = "你的API_KEY"

# 调用 ChatGPT (GPT-4 或 GPT-3.5)

response = openai.ChatCompletion.create(

model="gpt-4", # 模型名称

messages=[

{"role": "system", "content": "你是一个智能Python编程助手"},

{"role": "user", "content": "帮我写一个快速排序的Python代码"}

],

temperature=0.7, # 控制生成文本的多样性

max_tokens=500 # 控制回复长度

)

# 输出回复

print(response['choices'][0]['message']['content'])

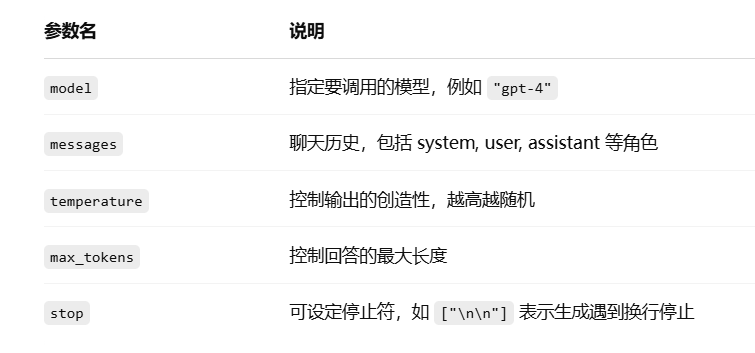

三、API调用常见参数说明

四、调用其他厂商大模型API(如百度文心、阿里通义)

示例:调用百度文心一言(Ernie)

import requests

API_KEY = "你的API_KEY"

SECRET_KEY = "你的SECRET_KEY"

# 获取access_token

def get_access_token():

url = f"https://aip.baidubce.com/oauth/2.0/token"

params = {

"grant_type": "client_credentials",

"client_id": API_KEY,

"client_secret": SECRET_KEY

}

res = requests.post(url, params=params)

return res.json().get("access_token")

access_token = get_access_token()

# 调用文心一言大模型

url = f"https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/completions?access_token={access_token}"

headers = {'Content-Type': 'application/json'}

data = {

"messages": [

{"role": "user", "content": "介绍一下人工智能的发展历程"}

],

"temperature": 0.7

}

response = requests.post(url, headers=headers, json=data)

print(response.json()['result'])

五、实用技巧与建议

- API Key 保密:切勿将你的密钥硬编码在公共代码中,应使用环境变量或配置文件。

- 使用代理或本地封装库:如国内访问OpenAI,可以通过代理加速;或使用现成的 SDK,如

openai、dashscope(通义)等。 - 模型调用负载控制:使用

max_tokens限制生成长度,合理设置timeout避免长时间等待。 - 多轮对话管理:需维护上下文

messages结构,支持连续对话。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)