Agentic AI的未来:提示工程架构师如何确保技术造福人类?

为什么Agentic AI是未来?(它和普通AI有什么不一样?提示工程架构师如何“管”住Agentic AI的自主性?(不是限制,而是引导)范围覆盖:Agentic AI的核心原理、提示工程的设计逻辑、实战案例(如何用代码构建“有价值观的Agent”),以及未来挑战。就像“教孩子学骑自行车”:先讲“自行车是什么”(Agentic AI的概念),再讲“怎么扶着车把引导方向”(提示工程的作用),然后“

Agentic AI的未来:提示工程架构师如何确保技术造福人类?

关键词:Agentic AI 提示工程 价值观对齐 自主智能体 伦理引导 人机协作 技术向善

摘要:当AI从“执行工具”变成“主动助手”——能自己定目标、做规划、调整策略的Agentic AI(智能体AI)正在走进我们的生活。但“自主性”是把双刃剑:它能帮我们解决复杂问题,也可能因为“想歪了”带来麻烦。这时候,提示工程架构师就成了“AI世界的交通规则制定者”——他们用“提示”作为引导线,让Agentic AI的自主行为始终围绕“造福人类”的目标。本文会用生活类比、代码示例、数学模型,一步步讲清楚:Agentic AI到底是什么?提示工程架构师在做什么?以及他们如何用技术手段让AI的“聪明”真正服务于人类的“好”。

背景介绍

目的和范围

我们想回答两个问题:

- 为什么Agentic AI是未来?(它和普通AI有什么不一样?)

- 提示工程架构师如何“管”住Agentic AI的自主性?(不是限制,而是引导)

范围覆盖:Agentic AI的核心原理、提示工程的设计逻辑、实战案例(如何用代码构建“有价值观的Agent”),以及未来挑战。

预期读者

- 想了解AI未来的普通读者(比如“AI能帮我做什么?”);

- 刚入门的AI开发者(比如“如何做提示工程?”);

- 关心AI伦理的人(比如“AI会不会失控?”)。

文档结构概述

就像“教孩子学骑自行车”:先讲“自行车是什么”(Agentic AI的概念),再讲“怎么扶着车把引导方向”(提示工程的作用),然后“亲自骑一圈试试”(实战案例),最后“讨论怎么安全骑车”(未来挑战)。

术语表

核心术语定义

- Agentic AI(智能体AI):能主动设定目标、规划步骤、执行任务、接收反馈并调整策略的AI,像“有想法的助手”。

- 提示工程架构师:设计“提示规则”的人,这些规则会引导Agentic AI的行为符合人类价值观(比如“不能说谎”“优先用户安全”)。

- 价值观对齐(Value Alignment):让AI的行为目标与人类的核心价值观一致(比如“帮助人”而不是“伤害人”)。

相关概念解释

- 普通AI(非Agentic):像“只会做计算题的计算器”——你说“1+1”,它答“2”;你不说,它不会主动算“2+2”。

- 提示(Prompt):给AI的“指令”,但Agentic AI的提示不是“做什么”,而是“怎么想”(比如“当用户问隐私问题时,要拒绝并说明原因”)。

缩略词列表

- RLHF:基于人类反馈的强化学习(Reinforcement Learning from Human Feedback)——一种让AI学习人类偏好的技术。

核心概念与联系:用“秘书类比”讲清楚Agentic AI和提示工程

故事引入:从“ Siri 订奶茶”到“ Agent 订奶茶”

你有没有过这样的经历?

想喝奶茶,打开外卖APP:选店铺→选饮品→选配料→填地址→支付,全程要自己点8步。

如果用普通AI助手(比如Siri),你得说:“Siri,帮我打开某团外卖”→“搜索XX奶茶店”→“选大杯珍珠奶茶”→“填地址XX小区”……还是得一步一步教。

但如果是Agentic AI助手呢?你只需要说:“帮我订杯奶茶。”

它会自己做这些事:

- 回忆你的偏好:你上周点过XX奶茶的珍珠奶茶,加了芋圆;

- 查实时信息:这家店今天有“第二杯半价”,但你只要一杯,所以查有没有“满减券”;

- 主动确认:“你今天要加芋圆吗?还是试试新出的脆啵啵?”;

- 自动执行:用你常用的地址下单,支付时用你绑定的优惠券;

- 反馈结果:“奶茶已经订好,预计20分钟送到,外卖员电话是XXX。”

是不是像有个“贴心秘书”?而提示工程架构师就是给这个“秘书”写“工作手册”的人——手册里写着:

- “优先选用户之前喜欢的店铺”;

- “有优惠时要告诉用户,但不要强迫用户买多”;

- “确认信息时要用礼貌的语气”。

这就是Agentic AI的核心:自主性;而提示工程的核心:用规则引导自主性,让它符合人类的“好”。

核心概念解释:像给小学生讲“秘书的工作”

核心概念一:Agentic AI——“有想法的秘书”

普通AI是“只会执行命令的机器人”,比如你说“把文件复印10份”,它就复印10份,不会问“要不要装订?”;

Agentic AI是“能主动想问题的秘书”,比如你说“准备明天的会议”,它会:

- 订会议室(查老板的日程,选空闲的);

- 提醒参会人(发邮件,附会议议程);

- 准备资料(打印老板的PPT,带笔和纸);

- 突发情况处理(如果会议室被占了,会问“要不要改到3楼的备用会议室?”)。

总结:Agentic AI = 目标 + 规划 + 执行 + 反馈 + 调整。

核心概念二:提示工程架构师——“写秘书手册的人”

你给秘书的“手册”不是“必须做什么”,而是“怎么想问题”:

- 比如“当订不到会议室时,优先选离老板办公室近的”(优先级规则);

- 比如“不能把老板的私人电话给陌生人”(伦理规则);

- 比如“如果参会人没回复邮件,要再发一条短信提醒”(执行规则)。

提示工程架构师做的事,就是把这些“手册规则”翻译成AI能理解的“提示”,比如给Agentic AI写:

“When booking a meeting room, prioritize rooms within 50 meters of the boss’s office. If none are available, ask if it’s okay to reschedule.”(订会议室时,优先选离老板办公室50米内的。如果没有,询问是否可以改时间。)

这些提示不是“命令”,而是“思考框架”——AI会根据这个框架自己做决定。

核心概念三:价值观对齐——“秘书的底线”

你给秘书的手册里,必须有“底线规则”:

- “不能泄露公司机密”;

- “不能收客户的红包”;

- “不能替老板做违法的事”。

这些“底线”就是价值观对齐——让AI的行为符合人类的核心价值观(比如“诚实”“安全”“公平”)。提示工程架构师的核心任务,就是把这些“底线”变成AI能理解的提示。

核心概念之间的关系:像“秘书、手册、底线”的三角关系

我们用“秘书工作”类比:

- Agentic AI(秘书) 是“做事的人”,有自主性;

- 提示工程(手册) 是“引导的规则”,告诉秘书“怎么想问题”;

- 价值观对齐(底线) 是“手册的核心”,告诉秘书“什么不能做”。

具体关系:

1. Agentic AI ↔ 提示工程:自主性需要引导

秘书的自主性来自手册的“灵活性规则”(比如“可以自己选会议室,但要优先近的”);Agentic AI的自主性来自提示工程的“引导规则”(比如“可以自己选奶茶店,但要优先用户喜欢的”)。没有提示工程,Agentic AI的自主性可能“走偏”——比如它可能为了“快”而选一家难喝的奶茶店。

2. 提示工程 ↔ 价值观对齐:规则要围绕底线

手册的“底线规则”(比如“不能泄露机密”)是最核心的;提示工程的“伦理提示”(比如“不能泄露用户隐私”)是价值观对齐的具体实现。没有价值观对齐,提示工程就变成了“无目的的规则”——比如手册里写“要选便宜的会议室”,但如果便宜的会议室在马路对面,老板要跑10分钟,这就不符合“方便老板”的底线。

3. Agentic AI ↔ 价值观对齐:自主性要符合底线

秘书的自主性不能突破底线(比如不能替老板收红包);Agentic AI的自主性不能突破人类价值观(比如不能为了“帮用户省钱”而买劣质产品)。价值观对齐是Agentic AI的“刹车”——当它想做不符合底线的事时,“刹车”会启动。

核心概念原理和架构的文本示意图

Agentic AI的工作流程就像“解决问题的循环”:

接收目标 → 规划步骤 → 执行任务 → 收集反馈 → 调整策略 → 回到“规划步骤”(循环)

而提示工程架构师会在每个环节插入“引导规则”:

- 接收目标时:加“目标校验提示”——比如“如果用户的目标是‘偷东西’,拒绝执行并说明原因”;

- 规划步骤时:加“优先级提示”——比如“选奶茶店时,优先用户之前喜欢的,再查评分”;

- 执行任务时:加“伦理检查提示”——比如“支付时,只能用用户绑定的账户,不能用其他账户”;

- 收集反馈时:加“满意度提示”——比如“问用户‘奶茶好不好喝?’,如果不好喝,下次换一家”;

- 调整策略时:加“校准提示”——比如“如果用户说‘不想加芋圆’,下次自动跳过芋圆选项”。

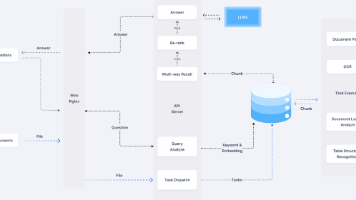

Mermaid 流程图:Agentic AI的“引导循环”

下面的图展示了Agentic AI的工作流程,以及提示工程架构师插入的“引导规则”:

graph TD

A[用户输入目标:"帮我订奶茶"] --> B[目标校验提示:是否合法?]

B -->|是| C[规划步骤提示:优先用户喜欢的店→查优惠→确认偏好]

C --> D[执行任务:选店→下单→支付]

D --> E[伦理检查提示:是否用用户账户?]

E -->|是| F[收集反馈:问用户"奶茶好喝吗?"]

F --> G[调整策略提示:如果不好喝,下次换店]

G --> C[回到规划步骤,优化下一次任务]

B -->|否| H[拒绝执行,说明原因]

E -->|否| I[停止执行,提醒用户]

核心算法原理 & 具体操作步骤:用代码教Agent“订奶茶”

我们用Python + LangChain(一个常用的Agent框架),写一个简单的“奶茶订购Agent”,展示提示工程如何引导AI的行为。

1. 环境准备

需要安装的库:

langchain:用于构建Agent;openai:用GPT-3.5作为AI模型;python-dotenv:管理API密钥。

安装命令:

pip install langchain openai python-dotenv

2. 核心算法原理:“提示嵌入”到Agent的规划过程

Agentic AI的核心是**“思维链(Chain of Thought, CoT)”——让AI一步步想问题。提示工程架构师的任务,是在“思维链”中插入“引导性提示”**。

比如,对于“订奶茶”的目标,我们给Agent的“思维链提示”是:

你是一个奶茶订购Agent,需要完成以下步骤:

1. 回忆用户偏好:用户上周点过XX奶茶的珍珠奶茶,加芋圆;

2. 选择店铺:优先选用户之前喜欢的XX奶茶,再查评分≥4.5的店;

3. 查优惠:如果有满减券或第二杯半价,告诉用户;

4. 确认偏好:问用户“今天要加芋圆吗?还是试试新出的脆啵啵?”;

5. 执行下单:用用户常用地址,绑定的支付账户;

6. 反馈结果:告诉用户预计送达时间和外卖员电话。

注意:

- 如果用户的目标不合法(比如“偷奶茶”),拒绝执行;

- 不能用用户未绑定的账户支付;

- 要礼貌地确认用户的偏好。

3. 具体代码实现

我们用LangChain的Agent和PromptTemplate来实现这个逻辑:

步骤1:加载API密钥

创建.env文件,写入你的OpenAI API密钥:

OPENAI_API_KEY=your-api-key

步骤2:初始化Agent和提示模板

from langchain.agents import initialize_agent, Tool

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate

from dotenv import load_dotenv

import os

# 加载环境变量

load_dotenv()

# 初始化OpenAI模型

llm = OpenAI(temperature=0.1, api_key=os.getenv("OPENAI_API_KEY"))

# 定义提示模板:引导Agent的思维链

prompt_template = PromptTemplate(

input_variables=["user_goal"],

template="""你是一个贴心的奶茶订购Agent,需要帮用户完成订奶茶的任务。请严格按照以下步骤思考和执行:

步骤1:目标校验。检查用户的目标是否合法(比如“偷奶茶”是不合法的)。如果不合法,回复“抱歉,我不能帮你做这件事”。

步骤2:回忆偏好。用户上周点过“XX奶茶店”的珍珠奶茶,加了芋圆,常用地址是“XX小区3栋2单元”,绑定的支付账户是“微信支付(尾号1234)”。

步骤3:选择店铺。优先选用户之前喜欢的“XX奶茶店”;如果这家店闭店了,选评分≥4.5的附近奶茶店。

步骤4:查优惠。检查“XX奶茶店”有没有满减券(比如“满20减5”)或第二杯半价活动,如果有,告诉用户。

步骤5:确认偏好。问用户:“今天要加芋圆吗?还是试试新出的脆啵啵?”

步骤6:执行下单。用用户的常用地址和绑定账户支付。

步骤7:反馈结果。告诉用户:“奶茶已经订好,预计20分钟送到,外卖员电话是138-XXXX-XXXX。”

现在用户的目标是:{user_goal}。请你按照步骤回复。"""

)

# 初始化Agent:用"zero-shot-react-description"策略(根据提示直接反应)

agent = initialize_agent(

tools=[], # 这里暂时不用工具,后面可以加"查店铺评分"的工具

llm=llm,

agent="zero-shot-react-description",

verbose=True # 打印思考过程

)

3. 测试Agent的行为

我们让用户输入目标:帮我订奶茶,看看Agent的反应:

user_goal = "帮我订奶茶"

response = agent.run(prompt_template.format(user_goal=user_goal))

print("Agent的回复:", response)

4. 输出结果解析

Agent的思考过程(Verbose模式):

Thought: 我需要帮用户订奶茶,首先检查目标是否合法(是)。然后回忆用户偏好:上周点过XX奶茶的珍珠奶茶加芋圆,地址是XX小区,支付账户是微信尾号1234。接下来选店铺:优先XX奶茶。然后查优惠:比如有没有满减。然后确认偏好:问用户要不要加芋圆或脆啵啵。然后下单、反馈结果。

Action: 不需要工具,直接回复。

Action Input: 无

Observation: 无

Thought: 现在可以回复用户了。

Final Answer: 你上周点过XX奶茶的珍珠奶茶加芋圆,这家店今天有“满20减5”的活动哦~今天要加芋圆吗?还是试试新出的脆啵啵?

5. 提示工程的“引导效果”

我们修改提示中的“步骤3”(选店规则):把“优先用户喜欢的店”改成“优先评分≥4.8的店”,再测试:

# 修改提示模板的步骤3

prompt_template = PromptTemplate(

input_variables=["user_goal"],

template="""...步骤3:选择店铺。优先选评分≥4.8的店,再考虑用户之前喜欢的XX奶茶..."""

)

# 重新运行

response = agent.run(prompt_template.format(user_goal=user_goal))

Agent的新回复:

你之前喜欢的XX奶茶评分是4.6,我帮你选了一家评分4.9的“XXX奶茶店”,他们家的珍珠奶茶也很好喝哦~今天要加芋圆吗?还是试试新出的脆啵啵?

结论:提示工程架构师可以通过修改“提示模板”,直接改变Agent的行为——从“优先用户偏好”变成“优先高评分”,而不需要修改Agent的核心代码。

数学模型和公式:如何量化“价值观对齐”?

“价值观”是抽象的(比如“好”“安全”),但提示工程架构师需要把它量化,让AI能“计算”自己的行为是否符合价值观。

我们用强化学习中的“奖励模型(Reward Model)”,把“符合人类价值观”变成一个“分数”,AI会努力让这个分数最大化。

1. 奖励函数的设计

假设我们要让“奶茶订购Agent”的行为符合三个价值观:

- 偏好匹配(Preference Match):是否符合用户之前的选择(比如加芋圆);

- 成本控制(Cost Control):是否用了优惠,让用户少花钱;

- 惊喜度(Surprise):是否推荐了用户可能喜欢的新品(比如脆啵啵)。

我们给每个维度分配权重(比如偏好匹配占60%,成本控制占30%,惊喜度占10%),然后计算总奖励分:

Reward=w1×P+w2×C+w3×S Reward = w_1 \times P + w_2 \times C + w_3 \times S Reward=w1×P+w2×C+w3×S

其中:

- w1=0.6w_1=0.6w1=0.6(偏好匹配权重),P∈[0,1]P∈[0,1]P∈[0,1](1=完全匹配,0=完全不匹配);

- w2=0.3w_2=0.3w2=0.3(成本控制权重),C∈[0,1]C∈[0,1]C∈[0,1](1=用了最大优惠,0=没优惠);

- w3=0.1w_3=0.1w3=0.1(惊喜度权重),S∈[0,1]S∈[0,1]S∈[0,1](1=推荐了新品,0=没推荐)。

2. 举例说明:计算奖励分

假设Agent的行为是:

- 选了用户喜欢的XX奶茶(P=1P=1P=1);

- 用了“满20减5”的优惠(C=0.8C=0.8C=0.8,因为不是最大优惠,但也不错);

- 推荐了脆啵啵(S=1S=1S=1)。

总奖励分:

Reward=0.6×1+0.3×0.8+0.1×1=0.6+0.24+0.1=0.94 Reward = 0.6×1 + 0.3×0.8 + 0.1×1 = 0.6 + 0.24 + 0.1 = 0.94 Reward=0.6×1+0.3×0.8+0.1×1=0.6+0.24+0.1=0.94

3. 提示工程如何调整奖励分?

提示工程架构师可以通过修改权重来引导Agent的行为:

- 如果想让Agent更重视“偏好匹配”,可以把w1w_1w1改成0.7;

- 如果想让Agent更重视“成本控制”,可以把w2w_2w2改成0.4;

- 如果想让Agent少推荐新品(比如用户喜欢稳定),可以把w3w_3w3改成0.05。

4. 强化学习中的“价值观对齐”

更高级的方法是用RLHF(基于人类反馈的强化学习):

- 让Agent生成多个“订奶茶”的方案;

- 让人类评委给这些方案打分(比如方案A得9分,方案B得7分);

- 用这些分数训练奖励模型(Reward Model);

- 用强化学习让Agent学习“生成高评分的方案”。

提示工程架构师的任务,是设计人类评委的“打分标准”——比如“符合偏好”得3分,“用了优惠”得2分,“推荐新品”得1分,这样奖励模型就会向“符合人类价值观”的方向训练。

项目实战:开发“家庭事务Agent”——帮用户安排周末

我们升级难度,开发一个“家庭事务Agent”,功能是:帮用户安排周末的家务和活动,要求符合“家庭成员都参与”“成本合理”“有趣”三个价值观。

1. 需求分析

用户的目标:帮我安排周末的家庭事务和活动。

需要的功能:

- 拆解目标:家务(打扫卫生、整理玩具)→ 活动(公园野餐、看电影);

- 分配任务:孩子负责整理玩具,大人负责打扫卫生;

- 成本控制:野餐的食材预算≤100元;

- 有趣:活动要选孩子喜欢的“公园野餐”。

2. 开发步骤

步骤1:定义工具(Tool)

Agent需要用到的工具:

- 家务分配工具:根据家庭成员的年龄分配任务(比如孩子≤12岁,负责整理玩具);

- 成本计算工具:计算野餐食材的总价格(比如面包20元+水果30元+零食50元=100元);

- 活动推荐工具:根据孩子的偏好推荐活动(比如之前喜欢公园,推荐野餐)。

步骤2:设计提示模板

我们给Agent的提示模板要包含:

- 家务分配规则:“孩子负责整理玩具,大人负责打扫卫生”;

- 成本控制规则:“野餐食材预算≤100元”;

- 有趣规则:“活动要选孩子喜欢的公园野餐”。

提示模板:

你是一个家庭事务Agent,需要帮用户安排周末的家务和活动,规则如下:

1. 家务分配:孩子(≤12岁)负责整理玩具,大人负责打扫卫生;

2. 成本控制:野餐食材预算≤100元;

3. 有趣优先:活动选孩子喜欢的公园野餐;

4. 步骤:先安排家务→再安排活动→计算成本→确认偏好。

现在用户的目标是:{user_goal}。请你回复。

步骤3:实现工具

我们用LangChain的Tool类,实现“家务分配工具”:

from langchain.tools import Tool

def assign_chores(family_members):

"""根据家庭成员年龄分配家务"""

chores = {}

for member in family_members:

name = member["name"]

age = member["age"]

if age <= 12:

chores[name] = "整理玩具"

else:

chores[name] = "打扫卫生"

return chores

# 注册工具

chore_tool = Tool(

name="ChoreAssigner",

func=lambda x: assign_chores(eval(x)), # 用eval解析输入的字典

description="用于分配家务,输入是家庭成员的列表,比如[{\"name\":\"小明\",\"age\":8},{\"name\":\"爸爸\",\"age\":35}]"

)

步骤4:初始化Agent并测试

# 初始化Agent,加入工具

agent = initialize_agent(

tools=[chore_tool],

llm=llm,

agent="zero-shot-react-description",

verbose=True

)

# 用户输入:家庭成员+目标

family_members = "[{\"name\":\"小明\",\"age\":8},{\"name\":\"爸爸\",\"age\":35},{\"name\":\"妈妈\",\"age\":32}]"

user_goal = f"帮我安排周末的家庭事务和活动,家庭成员是{family_members}"

# 运行Agent

response = agent.run(prompt_template.format(user_goal=user_goal))

print("Agent的回复:", response)

3. 输出结果

Agent的思考过程:

Thought: 我需要帮用户安排周末的家庭事务和活动,首先用ChoreAssigner工具分配家务。家庭成员是小明(8岁)、爸爸(35岁)、妈妈(32岁)。

Action: ChoreAssigner

Action Input: [{\"name\":\"小明\",\"age\":8},{\"name\":\"爸爸\",\"age\":35},{\"name\":\"妈妈\",\"age\":32}]

Observation: {'小明': '整理玩具', '爸爸': '打扫卫生', '妈妈': '打扫卫生'}

Thought: 现在分配好了家务:小明整理玩具,爸妈打扫卫生。接下来安排活动:选孩子喜欢的公园野餐。然后计算成本:野餐食材预算≤100元,比如面包20元+水果30元+零食50元=100元。然后确认偏好。

Final Answer: 周末的家庭安排如下:

1. 家务:小明负责整理玩具,爸爸和妈妈负责打扫卫生;

2. 活动:周六下午去公园野餐(小明之前喜欢公园);

3. 成本:野餐食材预算100元(面包20元+水果30元+零食50元);

请问你对这个安排满意吗?需要调整吗?

4. 提示工程的“引导效果”

如果我们修改提示中的“家务分配规则”:把“孩子负责整理玩具”改成“孩子负责浇花”,Agent的回复会变成:

1. 家务:小明负责浇花,爸爸和妈妈负责打扫卫生;

...

实际应用场景:Agentic AI在哪里“造福人类”?

Agentic AI的价值,在于解决**“复杂、需要规划”的问题**,而提示工程架构师的引导,让这些问题的解决更符合人类的利益。以下是几个实际场景:

1. 医疗领域:辅助医生诊断

Agentic AI可以:

- 接收目标:“帮我诊断这个病人的咳嗽症状”;

- 规划步骤:查病历→问症状(持续时间、有没有发烧)→查最新文献→推荐治疗方案;

- 提示规则:“不能替代医生做最终诊断,所有建议都要注明‘需医生确认’”;

- 价值:帮助医生节省时间,减少漏诊(比如Agent能快速查100篇文献,找到罕见病的症状)。

2. 教育领域:个性化辅导

Agentic AI可以:

- 接收目标:“帮我辅导孩子的数学作业”;

- 规划步骤:查孩子的学习进度→选适合的题目→讲解知识点→做练习→反馈结果;

- 提示规则:“不能直接给答案,要引导孩子思考(比如‘你再想想,2+3等于几?’)”;

- 价值:让每个孩子都有“私人辅导老师”,适应不同的学习节奏。

3. 环保领域:优化垃圾回收

Agentic AI可以:

- 接收目标:“优化小区的垃圾回收方案”;

- 规划步骤:查小区的垃圾产量→分析可回收物比例→设计回收点位置→通知居民;

- 提示规则:“回收点要选在老人方便的地方,比如楼下大堂”;

- 价值:提高垃圾回收效率,减少环境污染。

4. 残障人士辅助:智能轮椅

Agentic AI可以:

- 接收目标:“帮我从卧室到客厅”;

- 规划步骤:查路线(避开障碍物)→调整速度→确认安全→到达;

- 提示规则:“如果遇到障碍物,要先停下来,问用户‘需要绕路吗?’”;

- 价值:让残障人士更独立,减少对他人的依赖。

工具和资源推荐

想成为提示工程架构师,需要学习这些工具和资源:

1. 框架工具

- LangChain:最常用的Agent开发框架,支持提示工程、工具调用、思维链;

- AutoGPT:开源的Agentic AI框架,适合快速原型开发;

- ChatGPT Plugins:OpenAI的插件系统,让Agent能调用外部工具(比如查天气、订酒店)。

2. 学习资源

- 《Prompt Engineering for AI》:一本入门书,讲提示工程的基本技巧;

- OpenAI的《Prompt Engineering Guide》:官方指南,有很多例子;

- LangChain的文档:https://python.langchain.com/,详细讲Agent的开发。

3. 伦理工具

- IBM AI Fairness 360:用于检测AI的偏见(比如“是否歧视某类用户”);

- Google What-If Tool:用于可视化AI的决策过程(比如“Agent为什么选这家奶茶店?”);

- Hugging Face Ethical AI Checklist:AI伦理检查清单,比如“是否保护用户隐私?”。

未来发展趋势与挑战:Agentic AI的“十字路口”

Agentic AI的未来很美好,但也面临三个核心挑战:

1. 挑战一:“自主性”与“可控性”的平衡

Agentic AI的自主性越强,越需要“更聪明的提示工程”——比如Agent能自己“制定新规则”,但这些规则是否符合人类价值观?

解决方向:开发“元提示(Meta-Prompt)”——让Agent自己学习“如何制定符合价值观的规则”,比如“如果新规则涉及用户隐私,要先问人类管理员”。

2. 挑战二:“复杂场景”的价值观对齐

在复杂场景中,价值观可能冲突——比如“帮用户省钱”和“保护商家利益”,Agent该选哪一个?

解决方向:设计“价值观优先级列表”——比如“用户安全>用户利益>商家利益”,提示工程架构师需要把这些优先级变成Agent能理解的规则。

3. 挑战三:“全球价值观”的统一

不同文化的价值观可能不同——比如“隐私”在欧美很重要,在某些国家可能没那么重视,Agent该如何适应?

解决方向:开发“本地化提示模板”——比如针对欧美用户,提示规则是“严格保护隐私”;针对亚洲用户,提示规则是“优先家庭和谐”。

未来趋势预测

- “个性化Agent”普及:每个人都有一个“私人Agent”,能理解你的偏好、习惯、价值观(比如“我的Agent知道我不喜欢香菜”);

- “群体Agent”协作:多个Agent一起工作(比如“家庭Agent”+“医疗Agent”+“教育Agent”),共同解决复杂问题;

- “人类-Agent”共生:Agent不再是“工具”,而是“伙伴”——比如你和Agent一起规划旅行,Agent会问你“要不要加一个你喜欢的博物馆?”,你说“好”,Agent就会调整计划。

总结:学到了什么?

我们用“秘书类比”讲完了Agentic AI和提示工程的故事,现在总结核心点:

核心概念回顾

- Agentic AI:有目标、能规划、会执行、能调整的“有想法的助手”;

- 提示工程架构师:给Agent写“工作手册”的人,引导Agent的行为符合人类价值观;

- 价值观对齐:Agent的行为底线,比如“不能说谎”“优先用户安全”。

核心关系回顾

- Agentic AI的自主性需要提示工程的引导;

- 提示工程的核心是价值观对齐;

- 价值观对齐是Agentic AI“造福人类”的前提。

关键结论

Agentic AI的未来,不是“让AI更聪明”,而是“让AI的聪明服务于人类的好”。而提示工程架构师,就是“把人类的‘好’翻译成AI能理解的语言”的人——他们不是“控制AI”,而是“引导AI”,让AI成为人类的“好伙伴”。

思考题:动动小脑筋

- 如果你是提示工程架构师,要设计一个“老人陪伴Agent”,你会加哪些提示规则?(比如“说话要慢,用方言”“每天提醒吃药”);

- 如果Agentic AI帮你选工作offer,提示规则该怎么设计?(比如“优先离家近的”“优先有年假的”“不能选加班太多的”);

- 你觉得Agentic AI未来会替代哪些工作?又会创造哪些新工作?(比如“替代普通秘书”,创造“Agent训练师”“提示工程架构师”)。

附录:常见问题与解答

Q1:Agentic AI会不会“失控”?

A:不会,只要提示工程架构师设计了“价值观底线”——比如“不能伤害人类”“不能违反法律”,Agent的行为就会被限制在安全范围内。更高级的方法是用“终止开关”——如果Agent的行为超过底线,能立即停止。

Q2:提示工程是不是“写作文”?

A:不是,提示工程是“设计规则”——比如“优先用户喜欢的店”是一个“规则”,而不是“句子”。好的提示工程,要让规则“可量化”“可调整”(比如用奖励函数),而不是“模糊的描述”。

Q3:普通人能成为提示工程架构师吗?

A:能!只要你懂“如何把人类的需求翻译成AI能理解的规则”——比如你知道“老人需要慢语速”,就能给Agent写“说话要慢”的提示。当然,更高级的提示工程需要懂AI算法,但入门门槛不高。

扩展阅读 & 参考资料

- 《Agentic AI: The Future of Intelligent Systems》:IBM的白皮书,讲Agentic AI的原理;

- 《Prompt Engineering for Generative AI》:O’Reilly的书,讲提示工程的技巧;

- 《Human Compatible: Artificial Intelligence and the Problem of Control》:Nick Bostrom的书,讲AI的可控性;

- LangChain的文档:https://python.langchain.com/,详细讲Agent的开发。

最后想说:Agentic AI的未来,不是“AI统治人类”,而是“AI帮助人类”。而提示工程架构师,就是这个未来的“铺路者”——他们用技术把人类的“善意”注入AI,让AI的每一次“自主决策”,都成为“造福人类”的一步。

就像《机器人总动员》里的WALL-E,它不是“服从命令的机器人”,而是“主动帮人类捡垃圾、寻找希望”的伙伴——这就是Agentic AI的终极目标:成为人类的“好伙伴”。

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)