windows下python结合spark +java+ pyspark安装配置

默认你已经安装好了python一、 Java配置首先去官网http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html下载Java SE Development Kit 8u172,安装之后。进行以下步骤:1.新建系统变量:变量名:JAVA_H...

默认你已经安装好了python

一、 Java配置

首先去官网http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html下载Java SE Development Kit 8u172,安装之后。进行以下步骤:

1.新建系统变量:

| 变量名: | JAVA_HOME |

| 变量值: | F:\Java\jdk1.8.0_172(即java的jdk安装目录) |

2.再新建一个系统变量

| 变量名: | CLASSPATH |

| 变量值: | .;%JAVA_HOME%\lib\dt.jar;%JAVA_HOME%\lib\tools.jar; |

3.在系统变量Path中逐个添加以下四个:

%JAVA_HOME%\bin

%JAVA_HOME%\jre\bin

F:\Java\jdk1.8.0_172\bin

Tips:bin前的路径视自己java安装路径调整

F:\Java\jre1.8.0_172\bin

Tips:bin前的路径视自己java安装路径调整

4.验证是否安装完成

在cmd中输入java

在cmd中输入javac

没有报错就是java配置完成

二、 spark安装

(一)spark环境配置

1.去http://spark.apache.org/downloads.html网站下载相应spark

解压下载的文件,假设解压目录为:F:\spark-1.8.0-bin-hadoop2.7。

2.新建系统变量,变量名:SPARK_HOME

变量值为:F:\spark-1.8.0-bin-hadoop2.7

3.将F:\spark-1.8.0-bin-hadoop2.7添加到系统Path变量,Tips:bin前的路径视自己java安装路径调整

(二)安装必须要依赖的hadoop

1.去http://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-3.1.0/hadoop-3.1.0.tar.gz下载hadoop-3.1.0.tar.gz,但是不要下载hadoop-3.0.1-src.tar.gz这个

2.解压下载的文件夹,将相关库添加到系统Path变量中:F:\hadoop-3.1.0\bin;

3.新建变量,变量名为HADOOP_HOME,变量值为:F:\hadoop-3.1.0

(三)收尾

1.把java、hadoop、spark中的bin加入到系统变量Path中

2.然后在cmd中输入pipinstall pyspark

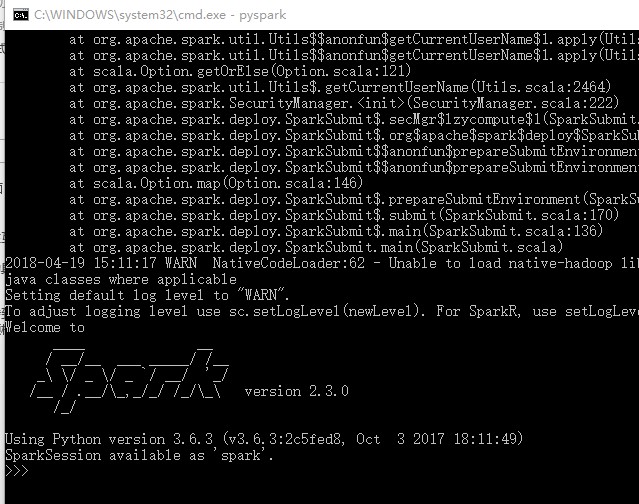

3.pyspark安装完成后,在cmd中输入pyspark显示下图,表示安装完成,可以直接输入python代码进行功能实现

4.在pycharm中输入代码:

from pyspark import SparkContext

logFile = "F:/spark-2.3.0-bin-hadoop2.7/README.md"

sc = SparkContext("local","Simple App")

logData = sc.textFile(logFile).cache()

numAs = logData.filter(lambda s: 'a' in s).count()

numBs = logData.filter(lambda s: 'b' in s).count()

print("Lines with a: %i, lines with b: %i"%(numAs, numBs))

运行结果为:

Lineswith a: 61, lines with b: 30

感谢以下作者:

http://www.cnblogs.com/eczhou/p/5216918.html

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)