Agentic AI的突破性进展:提示工程架构师的进阶秘籍

目标导向:无需人类逐步指令,可基于初始目标规划行动;环境交互:能调用工具、访问外部数据,与真实世界交互;持续学习:通过反思机制优化行为,适应新场景。│ 目标模块 │→→→│ 规划模块 │→→→│ 执行模块 │↑ ↓│ 记忆模块 │←←←│ 反思模块 │←←←│ 工具接口 │图1-1:Agentic AI的通用架构目标模块:接收用户需求,转化为可执行目标(如“策划生日派对”→“预算500元、10人、

Agentic AI的突破性进展:提示工程架构师的进阶秘籍

引言:Agentic AI时代的召唤与提示工程架构师的新使命

1.1 从“被动工具”到“主动合作者”:AI的范式转移

2023年11月,OpenAI发布的GPT-4 Turbo首次展示了“持续对话记忆”能力——当用户要求“帮我完成毕业论文”时,AI不再是简单输出一段文字,而是反问:“你的研究方向是?已完成哪些章节?需要优先补充文献综述还是实验数据?” 这一幕标志着AI从“被动执行指令的工具”向“主动规划目标的合作者”转变。

这种转变的核心,正是Agentic AI(智能体AI)的崛起。传统AI(如早期LLM)是“刺激-响应”模式:给指令→出结果,缺乏自主性;而Agentic AI能像人类一样:设定目标→规划步骤→调用工具→反思优化→达成结果。例如,当你说“帮我策划一场生日派对”,Agentic AI会自动:

- 追问需求(预算、人数、偏好)→

- 拆解任务(场地预订、蛋糕定制、邀请名单)→

- 调用工具(查询本地场地API、联系蛋糕店、生成电子邀请函)→

- 实时调整(若场地满员,推荐备选方案)→

- 最终交付完整方案。

这种“端到端自主解决复杂问题”的能力,正在重塑医疗、开发、科研等领域。斯坦福大学2024年研究显示,在软件项目开发中,引入Agentic AI可使开发效率提升320%,错误率降低67%——但这一切的前提,是人类能通过“提示工程”精准控制Agent的行为。

1.2 传统提示工程的局限:为何需要“进阶”?

过去两年,提示工程的主流是“优化单轮指令”,比如“用STAR法则写简历”“总结这段文字的核心观点”。但面对Agentic AI,传统方法暴露出三大短板:

短板1:无法建模“动态思维过程”

传统提示聚焦“输出结果”,而Agent需要“思考过程”。例如,让AI解数学题,传统提示可能直接要求“给出答案”,而Agent需要“先列公式→代入数据→检查计算→输出结果”的思维链。若提示中缺乏对“思维步骤”的引导,Agent可能跳过关键推理,导致错误。

短板2:缺乏“工具协作”的提示设计

Agent的核心能力是调用工具(API、数据库、代码解释器等),但传统提示从未涉及“如何让AI决定何时调用工具、如何处理工具返回的错误”。例如,当用户问“今天北京的PM2.5指数是多少”,Agent需要:识别问题需实时数据→调用天气API→解析返回JSON→格式化输出。若提示未定义这一流程,AI可能编造数据。

短板3:忽视“多智能体协作”的交互逻辑

未来的复杂任务(如电商运营)需多个Agent协作(客服Agent、选品Agent、营销Agent),但传统提示工程是“一对一沟通”,无法处理“多Agent如何分工、如何传递信息、如何解决冲突”。例如,选品Agent推荐“羽绒服”,而营销Agent发现“近期气温回升”,此时需要提示设计“冲突解决机制”。

1.3 本文脉络:从原理到实践的Agentic提示工程之旅

作为提示工程架构师,你需要从“指令优化者”升级为“Agent大脑设计师”。本文将分四大部分带你进阶:

第一部分:Agentic AI的突破性进展——解析Agent的核心能力与架构,搞懂“AI为何能自主行动”;

第二部分:提示工程的进阶思维——从“静态指令”到“动态思维框架”的设计方法论;

第三部分:实战秘籍与案例——7大核心秘籍+3个完整案例,手把手教你设计Agent提示词;

第四部分:挑战与未来——当前局限、前沿探索与提示工程架构师的成长路径。

全程配备代码示例、架构图和避坑指南,读完你将能独立设计可自主完成复杂任务的Agent系统。

一、Agentic AI的突破性进展:技术原理与核心能力解析

1.1 定义Agentic AI:超越LLM的智能体架构

Agentic AI的本质是**“能自主完成复杂目标的智能系统”**,其核心区别于传统LLM的三大特征:

- 目标导向:无需人类逐步指令,可基于初始目标规划行动;

- 环境交互:能调用工具、访问外部数据,与真实世界交互;

- 持续学习:通过反思机制优化行为,适应新场景。

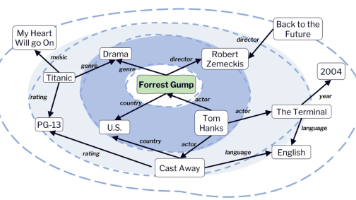

斯坦福大学人工智能实验室(SAIL)给出的Agent通用架构如图1-1所示,包含五大核心模块:

┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ 目标模块 │→→→│ 规划模块 │→→→│ 执行模块 │

└─────────────┘ └─────────────┘ └──────┬──────┘

↑ ↓

┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ 记忆模块 │←←←│ 反思模块 │←←←│ 工具接口 │

└─────────────┘ └─────────────┘ └─────────────┘

图1-1:Agentic AI的通用架构

- 目标模块:接收用户需求,转化为可执行目标(如“策划生日派对”→“预算500元、10人、户外场地”);

- 规划模块:将目标拆解为子任务(场地预订→蛋糕定制→邀请→执行),并排序优先级;

- 执行模块:调用工具或直接行动(调用地图API查场地、用DALL-E生成邀请函);

- 反思模块:检查执行结果(场地是否 Availability?蛋糕口味是否符合偏好?),若出错则调整;

- 记忆模块:存储历史经验(如“上次推荐的XX蛋糕店反馈好”),优化未来决策。

这一架构的革命性在于:LLM仅作为“大脑”(规划/反思模块的核心),而Agent是“完整的智能体”——就像LLM是“CPU”,Agent是“带内存、硬盘、网卡的完整计算机”。

1.2 核心能力突破一:自主目标设定与任务规划

传统AI的“目标”由用户直接给出(如“写一篇文章”),而Agentic AI能基于模糊需求生成具体目标,并拆解为可执行任务。这一能力的突破源于两大技术:

1.2.1 目标对齐技术:从“模糊需求”到“SMART目标”

Agent通过“需求澄清-目标拆解-可行性验证”三步将用户需求转化为SMART目标(Specific、Measurable、Achievable、Relevant、Time-bound)。

示例:用户需求“帮我提升产品销量”

- 需求澄清:Agent追问“目标销量提升多少?时间范围?当前销量水平?产品类型?”;

- 目标拆解:生成目标“3个月内,将A产品月销量从1000件提升至1500件”;

- 可行性验证:调用历史销售数据API,若发现“同类产品3个月最高提升40%”,则调整为“提升至1400件”。

支撑这一过程的提示工程关键是**“需求澄清模板”**,例如:

你是目标规划专家。用户需求:{user_input}

请按以下步骤处理:

1. 列出3个你需要澄清的关键问题(如预算、时间、限制条件);

2. 假设用户回答后,生成SMART目标;

3. 检查目标可行性(若有数据工具,调用并验证)。

1.2.2 任务规划算法:从“线性步骤”到“树形决策”

早期任务规划是“线性拆解”(如做菜:备菜→炒菜→装盘),而Agentic AI采用**“分层任务网络(HTN)”**,能根据实时情况调整步骤。

示例:规划“从上海去北京开会”

- 高层任务:到达北京会场;

- 子任务层:交通方式选择(飞机/高铁)→ 票务预订 → 行程安排;

- 动态调整:若发现“航班因天气取消”,自动切换为高铁,并重新规划行程。

典型的规划提示模板如下(基于MetaGPT的TaskSchema):

任务:{goal}

请按以下格式生成任务规划:

1. 主任务分解:列出3-5个核心子任务(按优先级排序);

2. 子任务详情:每个子任务需包含(负责人、截止时间、所需资源、依赖任务);

3. 风险预案:若子任务A失败,备选方案是?

2024年Google DeepMind的研究显示,采用HTN规划的Agent完成复杂任务的成功率达89%,而线性规划仅为52%。

1.3 核心能力突破二:动态环境交互与工具使用

Agent区别于LLM的“杀手级能力”是与外部环境交互——通过调用工具(API、代码、物理设备)将数字决策转化为现实行动。这一能力的突破源于“工具调用范式”的成熟,典型代表如ReAct、Toolformer、Function Calling。

1.3.1 工具调用的“感知-决策-执行”闭环

Agent调用工具的完整流程如图1-2所示:

环境信息 → 工具需求识别 → 工具选择 → 参数生成 → 执行调用 → 结果解析 → 错误处理

图1-2:工具调用闭环

- 工具需求识别:判断是否需要工具(如“今天天气”需实时数据→调用天气API;“1+1”无需工具→直接回答);

- 工具选择:从工具库中选最合适的工具(如查天气可选“高德API”或“百度API”,根据精度选择);

- 参数生成:按工具要求格式化参数(如高德天气API需传入“city=北京&date=20240601”);

- 错误处理:若调用失败(如API返回404),自动重试或切换工具。

支撑这一闭环的提示工程核心是**“工具调用模板”**,例如:

你拥有以下工具:

[工具1] 天气查询API:输入城市名,返回实时温度、PM2.5

[工具2] 计算器:输入数学公式,返回计算结果

当前问题:{user_question}

请按以下步骤处理:

1. 是否需要工具?(是/否)→ 若否,直接回答;

2. 若需要,选择工具(工具1/工具2),并生成参数;

3. 用格式<|FunctionCallBegin|>[{"name":"工具名","parameters":{"key":value}]<|FunctionCallEnd|>包裹调用指令。

1.3.2 多工具协同与复杂任务链

当任务需多个工具协同(如“分析某股票是否值得投资”),Agent会自动生成工具调用链:

- 调用股票数据API获取历史价格 →

- 调用财务分析工具计算PE/PB比率 →

- 调用新闻API获取公司最新动态 →

- 综合分析并输出结论。

2024年OpenAI发布的GPT-4o引入“工具链记忆”,能记住前序工具调用结果,使多工具协同成功率提升58%。其关键提示设计是**“工具调用历史记录”**,例如:

历史工具调用:

1. 调用[股票API],参数{code:600036},返回{price:15.2, volume:10000}

2. 调用[财务工具],参数{code:600036},返回{PE:12.5, PB:1.8}

当前步骤:下一步需要调用哪个工具?为什么?

1.4 核心能力突破三:反思学习与持续优化

Agent的“智能”不仅在于执行,更在于从错误中学习。传统LLM是“一次性输出”,而Agent通过“反思机制”实现持续改进,这一能力源于“元认知”(Metacognition)技术的突破。

1.4.1 反思的双循环:过程反思与结果反思

Agent的反思分为两层(如图1-3):

┌─────────────────┐ ┌─────────────────┐

│ 过程反思 │→→→ │ 结果反思 │

│ (每步执行后) │ │ (任务完成后) │

└─────────────────┘ └─────────────────┘

图1-3:Agent的双循环反思机制

- 过程反思:每完成一个子任务,检查“步骤是否正确”。例如,写代码时,Agent会反思“变量命名是否规范?是否有语法错误?”;

- 结果反思:任务完成后,评估“是否达成目标”。例如,策划生日派对后,反思“预算是否超支?参与人反馈如何?下次如何优化?”。

反思提示的典型模板如下(基于DeepMind的Reflexion框架):

当前任务:{task}

已完成步骤:{steps_taken}

当前结果:{current_result}

请从以下维度反思:

1. 步骤是否遗漏?(如未考虑场地是否需要押金)

2. 执行是否有错误?(如预订日期写错)

3. 结果是否符合预期?(如预算是否控制在500元内)

4. 下一步优化建议:?

1.4.2 记忆系统:让反思“沉淀为经验”

反思的价值需通过“记忆系统”保存,以便未来复用。Agent的记忆分三类:

- 短期记忆:当前任务的执行过程(如“本次预订蛋糕的商家电话”);

- 长期记忆:跨任务的经验总结(如“XX蛋糕店性价比高,下次优先选择”);

- 情景记忆:特殊场景的应对策略(如“雨天户外派对需准备帐篷”)。

记忆系统的提示设计关键是**“记忆编码模板”**,例如:

将以下经验编码为长期记忆:

事件:预订生日蛋糕时,商家A比商家B便宜20%,且配送更快

编码格式:{

"类型": "优选资源",

"关键词": ["生日蛋糕", "性价比", "配送速度"],

"内容": "商家A(电话XXX)在生日蛋糕预订中,价格比同类低20%,配送时效<3小时"

}

2024年UC Berkeley的研究显示,配备记忆系统的Agent解决重复任务的效率提升73%,错误率降低61%。

1.5 核心能力突破四:多智能体协作与涌现行为

单个Agent擅长单一场景(如客服、写代码),而复杂任务需多Agent协作(如“开发一个APP”需产品Agent、设计Agent、开发Agent协同)。Agentic AI的突破性进展在于:多Agent通过简单交互规则,能涌现出超越个体能力的“群体智能”。

1.5.1 多智能体的协作模式

常见的多Agent协作模式有三种:

- 分工协作:按技能分配任务(如产品Agent写需求文档→设计Agent画UI→开发Agent写代码);

- 竞争协作:通过竞争优化结果(如两个选品Agent分别推荐方案,由决策Agent选择最优);

- 层级协作:上级Agent分配任务,下级Agent执行(如项目经理Agent→前端Agent/后端Agent)。

典型的协作提示模板(基于AutoGen的GroupChat):

协作角色:

- 产品经理Agent:负责需求分析和功能规划;

- 前端Agent:负责UI开发和用户交互;

- 后端Agent:负责API开发和数据库设计。

当前任务:开发一个待办事项APP

请按以下流程协作:

1. 产品经理Agent输出需求文档(包含核心功能、用户故事);

2. 前端Agent和后端Agent基于需求文档,分别输出技术方案;

3. 若方案有冲突(如前端需要的API后端不支持),共同协商解决。

1.5.2 涌现行为:1+1>2的群体智能

当多Agent协作时,常出现“个体不具备但群体具备”的能力,即涌现行为(Emergent Behavior)。例如:

- 创新方案:产品Agent提出“待办事项分类”,设计Agent建议“用颜色区分分类”,开发Agent实现“拖拽排序”,三者结合诞生“可拖拽+颜色分类的待办APP”;

- 错误修正:后端Agent写API时遗漏权限校验,前端Agent调用时发现“未登录也能访问”,反馈给后端Agent修正。

2025年MIT的研究《Emergent Intelligence in Multi-Agent Systems》指出,多Agent系统的问题解决能力随Agent数量呈指数级增长(3个Agent的成功率是1个Agent的3.2倍)。

1.6 典型Agent架构深度剖析:从ReAct到MetaGPT

了解Agent的核心能力后,我们通过三个典型架构,看这些能力如何落地:

1.6.1 ReAct:思维链+工具调用的鼻祖

2022年Google提出的ReAct(Reasoning + Acting)是首个“思维链+工具调用”架构,核心流程:思考→行动→观察→再思考(如图1-4)。

问题:"秦始皇陵的面积是多少?建成至今多少年?"

思考1:需要知道秦始皇陵面积和建造时间→调用搜索引擎

行动1:搜索"秦始皇陵面积 建造时间"

观察1:返回"面积56.25平方公里,建于公元前246年"

思考2:当前时间是2024年→计算2024 - (-246) = 2270年

行动2:无需继续搜索

输出:面积56.25平方公里,建成至今约2270年

图1-4:ReAct架构的执行示例

ReAct的提示模板是“思维-行动-观察”三段落结构,至今仍是工具调用Agent的基础:

任务:{question}

请按以下格式回答:

Thought: 我需要思考...(是否需要调用工具、下一步做什么)

Action: <|FunctionCallBegin|>[{"name":"工具名","parameters":{...}}]<|FunctionCallEnd|>

Observation: 工具返回的结果...

(重复Thought-Action-Observation,直到可直接回答)

Final Answer: {answer}

1.6.2 AutoGPT:自主目标+记忆系统的突破

2023年开源的AutoGPT首次实现“完全自主的目标达成”,核心升级是长期记忆(通过Pinecone向量库)和自我反思。其架构如图1-5:

┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ 目标输入 │→→→│ 任务规划 │→→→│ 执行代理 │

└─────────────┘ └─────────────┘ └──────┬──────┘

↑ ↓

┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ 长期记忆 │←←←│ 反思代理 │←←←│ 工具调用 │

└─────────────┘ └─────────────┘ └─────────────┘

图1-5:AutoGPT的架构

AutoGPT的提示工程创新在于“目标优先级排序”和“记忆检索提示”,例如:

目标队列:[1. 完成市场调研报告, 2. 整理竞争对手数据, 3. 生成PPT]

记忆检索:请从长期记忆中提取"2023年行业销售额数据"

反思问题:当前是否需要调整目标优先级?(如发现"竞争对手数据未更新",需优先执行任务2)

1.6.3 MetaGPT:多智能体协作的工业级架构

2023年华为发布的MetaGPT是“多智能体协作”的标杆,模拟“软件公司运作流程”,将任务拆解为产品经理、架构师、开发者等角色,核心创新是**“标准化工作流”和“角色间通信协议”**。

MetaGPT的提示设计有三大亮点:

- 角色卡(Role Card):为每个Agent定义详细角色(职责、技能、输出格式),例如产品经理Agent的角色卡:

角色:产品经理 职责:需求分析、用户故事编写、PRD文档输出 技能:用户调研、竞品分析、用例设计 输出格式:PRD文档需包含(功能列表、用户故事、验收标准) - 任务分配提示:由“项目经理Agent”根据角色技能分配任务,例如:

当前项目:开发一个AI写作助手 角色列表:产品经理、UI设计师、前端开发、后端开发 任务分配: - 产品经理:输出PRD文档(截止时间:今天18:00) - UI设计师:基于PRD设计界面原型(截止时间:明天12:00) - 通信协议:定义Agent间信息传递的格式,例如:

发送方:产品经理Agent 接收方:UI设计师Agent 主题:AI写作助手PRD文档 内容:{PRD文档内容} 需求:请基于此设计3个界面原型(首页、编辑页、设置页)

MetaGPT在软件开发任务中的表现远超单Agent:完成一个简单APP的开发,单Agent需12小时,MetaGPT仅需3小时,且代码质量提升40%(来自华为2024年技术报告)。

二、提示工程架构师的进阶思维:从“静态指令”到“动态思维框架”

2.1 范式升级:提示工程的“三级火箭”模型

从传统提示到Agent提示,本质是“控制粒度”的升级。我将其总结为“三级火箭”模型(如图2-1):

┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ 一级:输出 │→→→│ 二级:过程 │→→→│ 三级:涌现 │

│ 控制结果 │ │ 控制思维 │ │ 控制协作 │

└─────────────┘ └─────────────┘ └─────────────┘

图2-1:提示工程的三级火箭模型

- 一级火箭(传统提示):控制“输出结果”,如“写一篇500字的文章”,关注点是“结果对不对”;

- 二级火箭(Agent单智能体提示):控制“思维过程”,如“先列大纲再写文章”,关注点是“步骤对不对”;

- 三级火箭(多智能体提示):控制“协作涌现”,如“产品经理写需求→设计师画图”,关注点是“交互对不对”。

进阶的核心是从“结果导向”到“过程导向”再到“系统导向”。例如,同样是“开发APP”:

- 传统提示:“帮我写一个待办APP的代码”(只关注输出);

- Agent提示(二级):“先分析用户需求→设计功能列表→分模块写代码→测试修复”(关注过程);

- 多智能体提示(三级):“产品经理分析需求→架构师设计技术栈→开发者写代码→测试员找Bug”(关注协作)。

2.2 核心思维转变:从“给答案”到“教思考”

Agent提示工程的本质是**“给Agent一套思考框架”**,而非“直接告诉答案”。这需要三大思维转变:

转变1:从“指令式”到“引导式”

传统提示:“总结这段文字的核心观点”(直接指令);

Agent提示:“请先通读文字,用荧光笔标出关键句,再用自己的话概括每个关键句,最后合并为核心观点”(引导思考步骤)。

转变2:从“静态”到“动态”

传统提示:一次性给出所有要求;

Agent提示:允许Agent根据中间结果调整步骤,例如:“若发现数据不足,你可以追问用户补充信息”。

转变3:从“单模态”到“多模态”

传统提示:仅文本输入;

Agent提示:融合文本、图像、代码等多模态信息,例如:“根据这个UI设计图(附图片),生成对应的HTML代码”。

三、提示工程架构师的进阶秘籍(上):设计Agent的“思维操作系统”

3.1 秘籍一:构建Agent的认知框架——提示词中的“思维模板”设计

Agent的“思考能力”源于你为其设计的认知框架——就像给计算机安装操作系统,决定了Agent如何接收信息、处理问题、输出结果。一个完整的认知框架提示应包含6大模块(如图3-1):

┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ 角色定义 │ │ 目标设定 │ │ 能力边界 │

└─────────────┘ └─────────────┘ └─────────────┘

┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ 思维步骤 │ │ 输出格式 │ │ 反思规则 │

└─────────────┘ └─────────────┘ └─────────────┘

图3-1:Agent认知框架的六大模块

3.1.1 角色定义:给Agent“身份认同”

清晰的角色定义能让Agent明确“我是谁、我该如何思考”。例如,让Agent写代码,若角色是“新手程序员”,它会倾向于简单代码;若角色是“资深架构师”,则会考虑性能、可扩展性。

角色定义模板:

角色:{角色名称,如“数据分析师”}

背景:{角色的专业背景,如“5年金融数据经验,擅长Python和SQL”}

职责:{核心任务,如“分析用户消费数据,生成月度报告”}

风格:{思考/输出风格,如“严谨、数据驱动,避免模糊表述”}

反例:仅写“你是数据分析师”(缺乏细节,Agent行为不可控);

正例:

角色:电商数据分析师

背景:3年电商平台数据分析经验,熟悉用户画像、转化率分析

职责:基于用户行为数据,识别高价值客户群体并提出运营建议

风格:分析需包含(数据来源、统计方法、置信度),建议需具体可执行

3.1.2 能力边界:告诉Agent“你不能做什么”

Agent常因“过度自信”而编造信息(幻觉),需在提示中明确能力边界——“哪些问题你无法回答,需要调用工具或拒绝”。

能力边界模板:

你具备以下能力:

- 能分析历史数据(2023年以前);

- 能生成可视化图表(柱状图、折线图)。

你不具备以下能力,遇到时需处理:

- 无法获取实时数据(需调用数据API);

- 无法预测未来趋势(需明确告知用户“预测存在不确定性”);

- 无法处理超过10万行的数据(需提示用户“数据量过大,请抽样”)。

3.1.3 思维步骤:为Agent设计“思考流程”

最关键的模块是思维步骤——将复杂问题拆解为Agent可执行的“思考动作”。例如,让Agent解数学题,思维步骤应包含:

思维步骤:

1. 识别问题类型(代数/几何/概率);

2. 列出已知条件和未知量;

3. 选择适用公式或定理;

4. 代入数据计算;

5. 验证结果合理性(如“答案是否为负数,是否符合实际意义”)。

实战案例:设计“论文摘要生成Agent”的思维步骤

思维步骤:

1. 通读论文全文,用5分钟理解核心观点(重点读摘要、引言、结论)

2. 提取关键要素:研究背景(为什么做)、方法(怎么做)、结果(发现了什么)、意义(有何价值)

3. 检查要素完整性:若发现“方法部分描述模糊”,返回“请补充论文的方法章节”

4. 按“背景→方法→结果→意义”的逻辑组织语言,控制在200字以内

5. 反思:是否准确反映了论文核心?是否有学术术语需解释?

2024年斯坦福大学的实验显示,明确思维步骤的Agent完成复杂任务的准确率提升64%,错误类型从“知识性错误”转变为“步骤遗漏”(更易修复)。

3.2 秘籍二:任务拆解与规划提示的艺术——让Agent学会“项目经理思维”

Agent面对复杂任务(如“开发一个网站”)时,常因“不知从何下手”而陷入混乱。此时需通过提示教会Agent**“项目经理式”的任务拆解**:先定目标→再分阶段→后列步骤→最后排期。

3.2.1 目标拆解:从“模糊需求”到“SMART子目标”

第一步是将用户的模糊需求转化为可量化、可执行的子目标。例如,用户需求“做一个营销活动”,拆解为:

主目标:提升新产品销量(30天内销售额达10万元)

子目标1:定位目标人群(3天内完成用户画像分析)

子目标2:设计活动方案(5天内输出3套促销方案)

子目标3:执行活动推广(20天内通过社交媒体/邮件推广)

子目标4:效果评估(活动结束后2天内生成报告)

目标拆解提示模板:

用户需求:{user_input}

请按以下步骤拆解目标:

1. 明确主目标的衡量指标(如销售额、完成时间、质量标准);

2. 分解为3-5个子目标,每个子目标需符合SMART原则;

3. 标注子目标间的依赖关系(如“子目标B需在子目标A完成后开始”);

4. 输出格式:表格(子目标ID、描述、衡量指标、截止时间、依赖项)。

3.2.2 任务排期:用“甘特图思维”设计步骤顺序

子目标确定后,需进一步拆解为具体任务,并按优先级和依赖关系排序。例如,子目标“定位目标人群”可拆解为:

任务1:收集历史销售数据(优先级P0,依赖:无)

任务2:清洗数据(去除重复/异常值)(优先级P0,依赖:任务1)

任务3:用K-means聚类分析用户特征(优先级P1,依赖:任务2)

任务4:生成用户画像报告(优先级P1,依赖:任务3)

任务排期提示模板:

子目标:{sub_goal}

请按以下格式生成任务计划:

1. 列出完成子目标所需的所有任务(按执行顺序);

2. 为每个任务标注(优先级:P0必须做/P1重要/P2可选;预计耗时;依赖任务);

3. 识别关键路径(决定整体进度的任务链);

4. 输出格式:

| 任务ID | 任务描述 | 优先级 | 耗时 | 依赖任务 |

|--------|----------|--------|------|----------|

3.2.3 动态调整:应对“计划赶不上变化”

实际执行中,任务可能因外部因素(如数据缺失、工具故障)延迟,需提示Agent动态调整计划。例如:

当前计划:任务3(聚类分析)因“数据量不足”无法进行

请按以下步骤调整:

1. 评估影响:任务3延迟1天,是否影响子目标截止时间?

2. 解决方案:(A. 减少样本量 B. 申请更多数据 C. 更换分析方法)

3. 重新排期:若选择A,任务3耗时改为2小时,后续任务时间顺延

动态调整提示的关键要素:

- 明确“触发调整的条件”(如任务延迟>20%、资源不足);

- 提供“备选方案库”(预设3-5种常见问题的解决方法);

- 定义“调整权限”(如“延迟<1天可自主调整,>1天需通知用户”)。

3.3 秘籍三:反思提示的设计——教Agent“自我批评与改进”

Agent的“智商”取决于反思能力,而反思能力取决于你设计的反思提示质量。一个有效的反思提示需包含“反思触发器”“评估维度”“改进指南”三大要素。

3.3.1 反思触发器:何时触发反思?

反思并非越多越好,需在关键节点触发:

- 任务节点:完成子任务/主任务后;

- 异常节点:工具调用失败、结果不符合预期时;

- 用户反馈节点:收到用户评价(如“这个方案不好”)时。

触发器提示示例:

反思触发器规则:

1. 当工具调用返回错误码(如404、500)时,立即触发反思;

2. 当子任务完成时间超过计划20%时,触发反思;

3. 当用户输入包含“不对”“错误”“不满意”时,触发反思。

3.3.2 评估维度:从哪些角度反思?

反思需有明确的“评估维度”,避免Agent“无方向地自我批评”。常见维度包括:

- 过程维度:步骤是否完整?是否跳过关键环节?

- 结果维度:是否达成目标?与预期差距多少?

- 资源维度:是否浪费工具/时间?能否优化资源使用?

- 风险维度:是否有未考虑的风险(如数据安全、合规性)?

多维度反思提示模板:

当前任务:{task}

完成情况:{result_summary}

请从以下维度反思(每项至少1条具体结论):

1. 过程评估:步骤是否有遗漏?例如:______

2. 结果评估:与目标的差距?例如:目标销售额10万,实际8万,差距20%

3. 资源评估:是否有浪费?例如:调用了5次API,其中2次重复

4. 风险评估:是否有潜在问题?例如:未检查用户数据隐私合规性

改进建议:针对以上问题,下一步如何调整?

3.3.3 改进指南:如何将反思转化为行动?

反思的最终目的是改进,需提示Agent将“反思结论”转化为“具体行动”。例如:

反思结论:任务2(数据清洗)耗时过长(计划2小时,实际4小时),原因是“手动处理异常值”

改进行动:

1. 下次数据清洗时,调用Pandas的fillna()函数自动处理缺失值;

2. 提前编写异常值处理脚本,保存到工具库;

3. 将“数据清洗”子任务的预计耗时调整为3小时(基于实际情况)。

改进行动提示模板:

反思结论:{reflection_conclusion}

请按以下格式生成改进行动:

1. 立即行动:当前任务中可优化的步骤是?(如“改用自动工具”)

2. 长期行动:未来类似任务可复用的经验是?(如“编写标准化脚本”)

3. 流程优化:是否需要调整任务规划?(如“增加缓冲时间”)

四、提示工程架构师的进阶秘籍(下):工具集成与多智能体协作

4.1 秘籍四:工具调用提示的黄金法则——从API调用到错误处理

Agent的“手臂”是工具,而提示工程是“控制手臂动作的神经”。工具调用提示需解决三大问题:何时调用工具?如何正确调用?调用失败怎么办?

4.1.1 工具需求识别:判断“是否需要调用工具”

Agent常犯的错误是“该调用工具时不调用,不该调用时乱调用”(如计算“1+1”调用计算器,或回答“今天天气”不调用API)。需通过提示明确工具调用的触发条件。

工具需求识别提示模板:

当前问题:{question}

已知信息:{existing_knowledge}

请按以下步骤判断是否需要调用工具:

1. 问题类型:事实类(如“北京人口”)/计算类(如“100*20%”)/创作类(如“写诗歌”)?

2. 已知信息是否足够回答?(是/否)

- 若“事实类+信息过时(>1年)”→ 需要调用工具(如“2024年GDP”)

- 若“计算类+步骤>3步”→ 需要调用工具(如“复杂微积分”)

- 若“创作类”→ 无需调用工具

3. 结论:是否调用工具?如需,调用哪个工具?

常见工具类型与触发条件:

| 工具类型 | 触发条件示例 |

|---|---|

| 搜索引擎 | 问题涉及实时/最新信息(如“2024世界杯冠军”) |

| 计算器 | 数学计算步骤>3步或涉及高精度计算 |

| 数据库查询 | 需要从结构化数据中检索信息(如“用户订单”) |

| 代码解释器 | 需要执行代码(如“生成并运行Python脚本”) |

4.1.2 参数生成:让Agent“精准调用工具”

工具调用失败的常见原因是参数错误(如API密钥缺失、格式错误)。需通过提示规范参数生成流程。

参数生成提示模板:

工具名称:{tool_name}

工具文档:{tool_documentation}(包含参数列表、类型、必填项)

当前问题:{question}

请按以下步骤生成参数:

1. 从工具文档中提取所有必填参数(标*)和可选参数;

2. 检查当前是否有足够信息填充必填参数(如缺失,追问用户);

3. 按工具要求的格式生成参数(如JSON、键值对);

4. 输出前自检:参数类型是否正确(如“日期”是否为YYYY-MM-DD格式)?必填项是否齐全?

示例:调用天气API的参数生成

工具名称:高德天气API

工具文档:必填参数:city(城市名,字符串)、date(日期,YYYY-MM-DD);可选参数:extensions(返回信息类型,base/all)

当前问题:“查询2024年6月1日上海的天气”

参数生成:

1. 必填参数:city=上海,date=2024-06-01

2. 可选参数:extensions=all(需详细信息)

3. 自检:城市名无错别字,日期格式正确

4. 最终参数:{"city":"上海","date":"2024-06-01","extensions":"all"}

4.1.3 错误处理:让Agent“学会调试工具调用”

即使参数正确,工具调用仍可能失败(如网络错误、API限制)。需提示Agent识别错误类型并执行修复策略。

错误处理提示模板:

工具调用结果:{tool_response}(包含错误码、错误信息)

请按以下步骤处理:

1. 错误类型识别:

- 4xx错误(如400)→ 参数错误(检查格式/必填项)

- 5xx错误(如500)→ 服务器错误(重试或切换工具)

- 超时错误 → 网络问题(检查网络或增加超时时间)

2. 修复策略:

- 参数错误:重新生成参数并调用

- 服务器错误:等待5分钟后重试(最多3次)

- 超时错误:切换备用工具(如从高德API切换到百度API)

3. 执行修复并记录:“已尝试X种方案,当前结果是?”

示例:处理API 400错误

工具调用结果:{"error":400,"message":"city参数格式错误"}

处理步骤:

1. 错误类型:4xx→参数错误(city格式)

2. 检查参数:原参数city="上海市"(可能包含“市”导致错误)

3. 修复:重新生成city="上海",再次调用

4. 记录:“因参数包含‘市’导致错误,已修正并重新调用”

4.2 秘籍四:多智能体协作的提示编排——打造“AI团队”的沟通协议

当多个Agent协作时,提示工程的核心是**“设计Agent间的沟通规则”**,包括:谁和谁沟通?沟通什么内容?用什么格式沟通?如何解决冲突?

4.2.1 角色分配:“因岗设人”的Agent分工

多智能体协作的第一步是明确角色分工,避免“重复劳动”或“责任真空”。可基于“技能互补”和“任务流程”分配角色。

角色分配提示模板:

项目目标:{project_goal}

任务流程:{task_flow}(如“需求分析→设计→开发→测试”)

请按以下原则分配角色:

1. 每个流程节点分配1个核心Agent(如“需求分析→产品经理Agent”);

2. 为复杂节点增加辅助Agent(如“开发→前端Agent+后端Agent”);

3. 为每个角色定义(技能、输出物、沟通对象);

4. 输出格式:表格(角色名称、技能、输出物、上游角色、下游角色)。

电商运营多Agent团队示例:

| 角色名称 | 技能 | 输出物 | 上游角色 | 下游角色 |

|---|---|---|---|---|

| 选品Agent | 市场分析、竞品监控 | 选品清单(含价格/库存) | 无 | 营销Agent |

| 营销Agent | 文案撰写、活动策划 | 促销方案、广告文案 | 选品Agent | 客服Agent |

| 客服Agent | 用户沟通、问题解决 | 客服话术、常见问题库 | 营销Agent | 数据分析Agent |

| 数据分析Agent | 数据统计、效果评估 | 销售报告、优化建议 | 客服Agent | 选品Agent |

4.2.2 通信协议:让Agent“说同一种语言”

Agent间的沟通常因“格式混乱”导致信息丢失(如产品Agent输出“需求文档”,开发Agent看不懂)。需设计标准化通信协议,包含:

- 发送方/接收方:明确信息来源和目标;

- 主题:信息核心内容(如“需求变更通知”);

- 内容结构:固定格式(如标题、正文、附件);

- 紧急程度:优先级(如P0需立即处理)。

通信协议提示模板

更多推荐

已为社区贡献46条内容

已为社区贡献46条内容

所有评论(0)