《解锁Agentic AI在公共安全应用,提示工程架构师攻略》

当一场突发火灾发生时,传统应急系统需要人工汇总监控画面、报警信息、交通状况等数十种数据,再协调消防、医疗、交通等部门响应——这个过程往往需要数十分钟,而黄金救援时间可能只有几分钟。Agentic AI的出现,让"AI自主完成数据整合、资源调度、行动规划"成为可能。用通俗语言解释Agentic AI的核心原理,让非技术人员也能理解"为什么它比传统AI更擅长公共安全任务";教会提示工程架构师如何设计"

解锁Agentic AI在公共安全应用,提示工程架构师攻略

关键词:Agentic AI、公共安全、提示工程、智能体架构、安全决策、多模态交互、风险预测

摘要:在城市安全面临复杂威胁(如突发事件、犯罪预防、灾害救援)的今天,传统公共安全系统常陷入"数据过载却决策滞后"的困境。Agentic AI(智能体AI)作为具备自主规划、动态决策和持续学习能力的新一代AI系统,正成为破解这一难题的关键。本文将以"给小学生讲故事"的方式,从核心概念入手,揭示Agentic AI如何像"城市安全超级管家"一样自主完成任务;详解提示工程架构师如何通过"精准指令设计"让AI智能体在公共安全场景中高效工作;通过Python代码实战演示如何搭建公共安全Agent系统;最后展望Agentic AI在公共安全领域的未来挑战与机遇。无论你是AI工程师、公共安全从业者还是提示工程新手,都能通过本文掌握解锁Agentic AI安全应用的核心密码。

背景介绍

目的和范围

当一场突发火灾发生时,传统应急系统需要人工汇总监控画面、报警信息、交通状况等数十种数据,再协调消防、医疗、交通等部门响应——这个过程往往需要数十分钟,而黄金救援时间可能只有几分钟。Agentic AI的出现,让"AI自主完成数据整合、资源调度、行动规划"成为可能。本文旨在:

- 用通俗语言解释Agentic AI的核心原理,让非技术人员也能理解"为什么它比传统AI更擅长公共安全任务";

- 教会提示工程架构师如何设计"让AI智能体听话又聪明"的提示策略;

- 提供可落地的公共安全Agent系统搭建指南,包含代码示例和最佳实践。

本文覆盖Agentic AI在公共安全中的四大核心场景:智能监控预警、应急资源调度、犯罪模式识别、灾害风险预测,不涉及军事级武器控制等敏感领域。

预期读者

- 公共安全从业者(如应急管理官员、公安系统技术负责人):了解Agentic AI能为工作带来哪些具体改变;

- AI工程师:掌握提示工程设计方法,提升Agentic AI系统的可靠性和安全性;

- 提示工程架构师:学习针对公共安全场景的提示模板设计、多智能体协作提示策略;

- 技术管理者:评估Agentic AI在公共安全项目中的落地价值和风险控制要点。

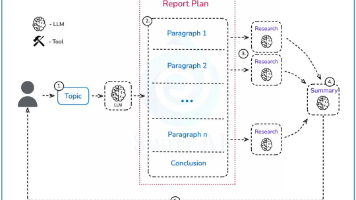

文档结构概述

本文像"拆解一台智能安全机器人"一样展开:

- 拆外壳:通过故事理解Agentic AI是什么,为什么适合公共安全;

- 看内脏:解析Agentic AI的核心组件(自主决策、多模态感知、持续学习)和提示工程的作用;

- 学操作:掌握提示工程架构师的"三大设计心法"和"五步提示编写流程";

- 动手装:用Python搭建一个城市火灾应急响应Agent,从0到1实现智能调度;

- 谈应用:盘点Agentic AI在公共安全中的典型场景和实战案例;

- 聊未来:探讨AI自主决策的伦理边界、数据安全等挑战及应对策略。

术语表

核心术语定义

- Agentic AI(智能体AI):能像"拥有自主意识的助手"一样,理解目标、规划步骤、调用工具、调整策略的AI系统(区别于传统"输入-输出"式AI)。

- 提示工程(Prompt Engineering):设计"AI指令"的技术,让AI明白"要做什么、怎么做、注意什么",就像"给AI写任务说明书"。

- 智能体架构(Agent Architecture):Agentic AI的"身体结构",包含感知模块(看/听数据)、决策模块(想怎么做)、执行模块(动手做)、记忆模块(记经验)。

- 多模态交互(Multimodal Interaction):AI同时处理图像(监控画面)、语音(报警电话)、文本(案件报告)、传感器数据(温度/烟雾浓度)等多种类型信息的能力。

- 安全决策闭环:Agentic AI在公共安全任务中"发现问题→分析问题→解决问题→总结经验"的完整工作流程。

相关概念解释

- 传统AI vs Agentic AI:传统AI像"计算器",你问1+1=?它答2;Agentic AI像"会计",你说"算一下本月开支",它会主动问"需要分类统计吗?要排除报销项吗?",然后自己找数据、算结果、出报表。

- 提示工程 vs 编程:编程是"告诉计算机每一步怎么做"(如"如果温度>80度,输出警告");提示工程是"告诉AI要达成什么目标,以及遵循什么原则"(如"作为火灾预警员,当发现温度突升且有烟雾时,优先通知最近的消防站,并附上监控截图")。

缩略词列表

- AGI:通用人工智能(能像人类一样完成各种任务的AI)

- MDP:马尔可夫决策过程(Agent做决策的数学模型)

- LLM:大语言模型(如GPT-4、Claude,Agentic AI的"大脑")

- CV:计算机视觉(Agent的"眼睛",处理图像/视频数据)

- NLP:自然语言处理(Agent的"耳朵",处理文本/语音数据)

核心概念与联系

故事引入:当城市安全遇上"超级管家"AI

想象你是一座城市的安全局长,每天要处理:

- 2000路监控视频(可能拍到可疑人员);

- 500通报警电话(真报警、假报警、误报混杂);

- 100个传感器数据(火灾、地震、有毒气体检测);

- 协调消防、公安、医疗等10个部门的资源调度。

这就像同时盯着100个钟表,还要给每个钟表上发条——你很快会手忙脚乱。

这时,来了一位"超级管家",它说:“局长,我来帮你。你只需要告诉我’今年要让火灾伤亡率降20%',剩下的事我来做。”

第一天,它就自主完成了:

- 从监控里发现一个公园角落有冒烟(它自己调了高清摄像头确认,不是炊烟是枯草自燃);

- 查了最近的消防 station 位置(3公里外),同时看了实时交通(这条路现在不堵车);

- 自动给消防 station 发了地址+现场视频,还给附近500米居民发了短信提醒"远离该区域";

- 事后写了份报告:“本次响应比平均快8分钟,原因是优先调了无人机先去确认火情”。

这位"超级管家"就是Agentic AI。而你告诉它"今年要让火灾伤亡率降20%"的这句话,加上你补充的"要优先保护学校和医院"等规则,就是提示工程的产物。

核心概念解释(像给小学生讲故事一样)

核心概念一:Agentic AI——会自己"找事做"的AI助手

传统AI是"被动执行者":你问"今天气温多少?“,它答"25度”;你不问,它就不动。

Agentic AI是"主动规划者":你说"帮我准备野餐",它会:

- 自己查天气预报(今天有雨吗?);

- 列清单(需要带帐篷、食物、雨具);

- 发现你没帐篷,主动问"要帮你订一个吗?";

- 野餐结束后,还会说"今天下雨了,下次建议查更精准的小时预报"。

生活类比:传统AI像"计算器",Agentic AI像"你的贴心助理"。

在公共安全中,Agentic AI的"主动规划能力"能救命:比如地震发生时,它不用等人类指令,会自动:

- 切断危险区域电源;

- 打开应急通道指示灯;

- 给急救中心发被困人员位置(通过手机信号定位)。

核心概念二:提示工程——给AI"写清楚任务说明书"

假设你让AI"处理报警电话",如果只说"处理报警",AI可能只会把电话录音转成文字给你——这没什么用。

但如果你写一份"提示说明书":

"你是公共安全报警处理助手,任务是判断报警类型并分级响应。步骤:

- 听录音,提取关键信息:时间、地点、事件(火灾/盗窃/医疗急救等)、是否有人员伤亡;

- 按紧急程度分级:一级(危及生命,如’有人持刀伤人’)、二级(紧急但不致命,如’家里进小偷但人不在’)、三级(非紧急,如’噪音扰民’);

- 一级报警:立即转接110指挥中心+自动发送GPS位置;二级报警:5分钟内短信通知辖区派出所;三级报警:记录到系统,次日处理。

注意:如果报警人情绪激动,先安抚说’别着急,我们马上处理’。"

AI看到这份"说明书",就能精准完成任务——这就是提示工程:通过"写清楚目标、步骤、规则",让AI知道"做什么、怎么做、注意什么"。

生活类比:提示工程像"给新来的同学写值日规则",写得越细,同学做得越好。

核心概念三:智能体架构——AI的"身体器官"分工

Agentic AI能完成复杂任务,是因为它有像人体一样的"器官分工"——这就是智能体架构,包含4个核心"器官":

-

感知器官(输入模块):像眼睛、耳朵,接收外部数据(监控视频、报警电话、传感器数据)。

例:用摄像头"看"画面(CV技术),用麦克风"听"声音(语音识别),用数据库"读"历史案件(文本分析)。 -

思考器官(决策模块):像大脑,决定"下一步做什么"。

例:发现监控里有个人在商场门口徘徊1小时,决策模块会想:“需要调更多角度摄像头确认吗?需要通知保安吗?还是先标记为’可疑人员’观察?” -

行动器官(执行模块):像手脚,执行决策(发通知、调设备、控制系统)。

例:决策"需要通知保安",执行模块就自动给保安室发消息+监控截图。 -

记忆器官(存储模块):像日记本,记录"过去做了什么、学到了什么"。

例:上次处理"商场徘徊人员"后,发现"穿黑色连帽衫+背双肩包"的人后来确实偷了东西,记忆模块会把这个特征存下来,下次遇到类似特征会更警惕。

生活类比:智能体架构像医院的"急诊团队":

- 感知器官=护士(收集病人症状:体温、血压、主诉);

- 决策模块=医生(分析症状,决定"先做CT还是先输液");

- 执行模块=护士+药房(打针、拿药);

- 记忆模块=病历本(记录治疗过程和效果,下次遇到类似病人参考)。

核心概念四:多模态交互——AI的"五感"协同工作

公共安全数据很少是"单一类型"的:报警是语音,监控是图像,案件记录是文本,火灾传感器是数字(温度、烟雾浓度)。Agentic AI需要像人类一样,综合"看、听、读、算"来做决策——这就是多模态交互。

生活类比:你判断"锅里的水是否开了",会:

- 看(水面是否冒泡);

- 听(是否有"咕嘟"声);

- 摸(锅柄是否烫)——多模态协同。

在公共安全中,多模态交互能避免"盲人摸象":比如一个"加油站有人吸烟"的报警,Agentic AI会:

- 看监控(真的有人在吸烟吗?离加油机多远?);

- 听语音(报警人声音是否紧张?背景有爆炸声吗?);

- 读历史数据(这个加油站上周刚发生过火灾隐患吗?);

- 算传感器数据(空气中汽油浓度是否超标?);

综合判断后,决定是"派警察立即到场"还是"先派无人机确认"。

核心概念之间的关系(用小学生能理解的比喻)

关系一:Agentic AI和提示工程——“超级管家"与"任务清单”

Agentic AI(超级管家)需要提示工程(任务清单)才能知道"主人的要求"。

例子:妈妈(提示工程架构师)给管家(Agentic AI)写任务清单(提示):

"任务:照顾小明一天。

规则:

- 早上7点叫小明起床,先让他喝一杯温水;

- 早餐要包含鸡蛋和牛奶(小明对花生过敏,绝对不能有花生酱);

- 下午3点带他去公园,但如果下雨就改在家玩积木。"

如果任务清单没写"对花生过敏",管家可能会给小明吃花生酱三明治——这就是提示工程没做好的后果。

公共安全中的启示:提示工程必须写清楚"红线规则",比如"AI绝对不能自主决定’开枪’,所有武力行动必须经人类确认"。

关系二:智能体架构和多模态交互——“急诊团队"与"多源情报”

智能体架构(急诊团队)需要多模态交互(多源情报)才能做出正确决策。

例子:病人(公共安全事件)来了,护士(感知器官)只告诉医生(决策模块)“他肚子疼”(单一模态),医生可能误诊;但护士同时说"他肚子疼+体温39度+昨晚吃了生海鲜"(多模态),医生就能准确判断"可能是食物中毒"。

公共安全中的启示:Agentic AI如果只看监控(单一模态),可能把"有人举着玩具枪"当成真枪;但结合语音(周围人在笑,没人尖叫)、历史数据(这个区域常有小孩玩玩具枪),就能避免误判。

关系三:提示工程和智能体架构——“游戏规则"与"玩家能力”

提示工程(游戏规则)需要匹配智能体架构(玩家能力),否则AI会"做不到"或"做错"。

例子:你让一个只会玩"连连看"的AI(架构简单,只能处理图像匹配)去"写一篇作文"(需要文本生成能力),就算提示写得再好(“请写一篇关于春天的作文,用3个比喻句”),AI也做不到——因为它的"架构"里没有"文本生成器官"。

公共安全中的启示:设计提示时,要先清楚AI的"能力边界":如果AI的执行模块只能"发消息",就不要在提示里写"让AI直接控制红绿灯"(超出能力范围)。

核心概念原理和架构的文本示意图(专业定义)

Agentic AI在公共安全中的核心架构

┌─────────────────────────────────────────────────────────────┐

│ 公共安全Agentic AI系统 │

├───────────────┬───────────────┬───────────────┬─────────────┤

│ 感知模块 │ 决策模块 │ 执行模块 │ 存储模块 │

│ (输入层) │ (核心层) │ (输出层) │ (记忆层) │

├───────────────┼───────────────┼───────────────┼─────────────┤

│ 功能:接收多 │ 功能:基于目 │ 功能:执行决 │ 功能:存储 │

│ 模态安全数据 │ 标和规则,规 │ 策,控制外部 │ 历史数据、 │

│ - 视频监控 │ 划任务步骤, │ 系统和设备 │ 决策经验、 │

│ - 语音报警 │ 动态调整策略 │ - 发送通知 │ 任务状态 │

│ - 传感器数据 │ │ - 调用设备 │ │

│ - 文本报告 │ │ - 生成文档 │ │

├───────────────┼───────────────┼───────────────┼─────────────┤

│ 技术: │ 技术: │ 技术: │ 技术: │

│ - CV(图像) │ - LLM(大语 │ - API接口 │ - 向量数据库│

│ - ASR(语音) │ 言模型) │ - 自动化脚本 │ - 关系数据库│

│ - NLP(文本) │ - 强化学习 │ - 物联网控制 │ - 知识图谱 │

│ - 时序分析 │ - 规则引擎 │ 协议 │ │

└───────────────┴───────────────┴───────────────┴─────────────┘

↑ ↑ ↑ ↑

└───────────────┼───────────────┼───────────────┘

│ │

▼ ▼

┌─────────────┐ ┌─────────────┐

│ 提示工程 │ │ 人类监督层 │

│ (目标/规则)│ │(审批/干预)│

└─────────────┘ └─────────────┘

Mermaid 流程图:Agentic AI处理公共安全事件的完整流程

流程说明:

- 事件触发(如传感器检测到火灾、监控拍到可疑人员);

- 多模态数据输入(视频、语音、传感器等);

- 数据融合后,结合提示工程注入的目标(如"优先保护人员安全")和规则(如"不随意暴露居民信息");

- 任务规划模块决定"是否需要进一步调用工具"(如"调更多摄像头确认火情");

- 行动决策后,若涉及高风险操作(如"疏散学校"),需人类审批;

- 执行后生成报告,更新记忆模块,优化下次决策——形成"感知-决策-执行-学习"闭环。

核心算法原理 & 具体操作步骤:提示工程架构师的"三大心法"

提示工程不是"随便写几句话",而是需要遵循科学方法的"架构设计"。作为提示工程架构师,你需要掌握"目标拆解、规则嵌入、反馈优化"三大心法,才能让Agentic AI在公共安全场景中既高效又安全。

心法一:目标拆解——把"大任务"拆成"AI能看懂的小步骤"

原理:公共安全任务往往复杂(如"降低城市犯罪率"),AI无法直接理解。需拆成可执行的子任务,就像把"做蛋糕"拆成"准备材料→搅拌→烘烤→装饰"。

操作步骤:

- 明确终极目标(如"2024年让城市盗窃案下降15%");

- 拆分子目标(如"提升盗窃预警准确率→缩短出警时间→加强重点区域巡逻");

- 给每个子目标定义"成功指标"(如"预警准确率=预测正确的盗窃事件/总预测数>80%");

- 按优先级排序(如"先提升预警准确率,再缩短出警时间")。

Python代码示例:目标拆解提示模板

def generate_goal_prompt(ultimate_goal, subgoals, success_metrics, priority):

prompt = f"""

你是公共安全Agentic AI的任务规划助手,需要帮我拆解目标。

终极目标:{ultimate_goal}

子目标列表:{subgoals}

成功指标:{success_metrics}

优先级:{priority}

请输出:

1. 子目标执行顺序(按优先级);

2. 每个子目标的关键步骤(不超过3步);

3. 子目标之间的依赖关系(如"子目标A完成后才能开始子目标B")。

注意:步骤必须具体到"你可以调用XX工具"或"你可以分析XX数据"。

"""

return prompt

# 使用示例

ultimate_goal = "2024年让城市盗窃案下降15%"

subgoals = [

"提升盗窃预警准确率",

"缩短盗窃案出警时间",

"加强重点区域夜间巡逻"

]

success_metrics = {

"提升盗窃预警准确率": "预测正确的盗窃事件/总预测数>80%",

"缩短盗窃案出警时间": "平均出警时间<10分钟",

"加强重点区域夜间巡逻": "重点区域巡逻频次提升50%"

}

priority = "提升盗窃预警准确率 > 缩短出警时间 > 加强巡逻"

prompt = generate_goal_prompt(ultimate_goal, subgoals, success_metrics, priority)

print(prompt)

输出效果(AI生成):

1. 子目标执行顺序:

① 提升盗窃预警准确率

② 缩短盗窃案出警时间

③ 加强重点区域夜间巡逻

2. 关键步骤:

① 提升盗窃预警准确率:

- 调用历史盗窃案数据库,分析"高发时间、地点、嫌疑人特征";

- 调用监控系统,对"高发地点+高发时间"的监控画面进行异常行为识别;

- 输出预警列表,标记"高风险(>90%概率)、中风险(60%-90%)、低风险(<60%)"。

② 缩短盗窃案出警时间:

- 基于预警列表,提前调度警车至"高风险区域"周边待命;

- 接警后,自动匹配最近的待命警车,推送最优路线(避开拥堵);

- 出警后,实时更新位置给指挥中心。

③ 加强重点区域夜间巡逻:

- 基于步骤①的"高发地点",生成夜间巡逻路线图;

- 调用无人机对"无监控覆盖的重点区域"进行辅助巡逻;

- 每日统计巡逻完成率,未达标的区域次日增加频次。

3. 依赖关系:

- 步骤②依赖步骤①:只有预警准确率提升,才能精准调度警车待命;

- 步骤③依赖步骤①:只有明确"高发地点",才能生成有效巡逻路线。

心法二:规则嵌入——给AI画"安全红线"和"行动指南"

公共安全场景中,“做错"的代价可能是生命损失。提示工程必须嵌入严格规则,包含"必须做什么、禁止做什么、遇到XX情况怎么办”。

规则嵌入的"3层金字塔模型"

┌─────────────────────────┐

│ 第一层:伦理红线规则 │ (绝对不能碰,如"不伤害人类")

├─────────────────────────┤

│ 第二层:安全操作规则 │ (必须遵守的流程,如"高风险行动需人类审批")

├─────────────────────────┤

│ 第三层:优化提示规则 │ (让AI做得更好,如"优先使用无人机确认火情")

└─────────────────────────┘

Python代码示例:公共安全AI规则提示模板

def generate_safety_rules_prompt(ethical_rules, operation_rules, optimization_rules):

prompt = f"""

你是公共安全Agentic AI,必须严格遵守以下规则,优先级:伦理红线 > 安全操作 > 优化提示。

【伦理红线规则】(绝对禁止违反):

{chr(10).join([f"- {rule}" for rule in ethical_rules])}

【安全操作规则】(必须严格遵守):

{chr(10).join([f"- {rule}" for rule in operation_rules])}

【优化提示规则】(尽量做到):

{chr(10).join([f"- {rule}" for rule in optimization_rules])}

当规则冲突时,按优先级处理。例如:"优化提示"要求"快速响应",但"安全操作"要求"需人类审批",则必须等待审批。

每次行动前,请自检:"是否违反了以上规则?"若不确定,立即停止并询问人类监督者。

"""

return prompt

# 使用示例(火灾应急响应AI)

ethical_rules = [

"禁止自主决定剥夺人类生命(如不允许控制武器系统)",

"禁止泄露受灾人员的个人隐私(如姓名、身份证号)",

"禁止伪造或篡改事件数据(如火灾位置、伤亡人数)"

]

operation_rules = [

"疏散学校/医院等人员密集场所,必须先经人类指挥中心确认",

"调用消防资源时,需同时通知对应辖区消防负责人",

"发布公众预警信息前,需检查是否有夸大风险(如'可能引发爆炸'需有科学依据)"

]

optimization_rules = [

"优先调用无人机或机器人先去确认火情,减少人员风险",

"响应时间目标:接警后5分钟内完成初步处置方案",

"报告需包含:事件类型、位置、已采取措施、下一步计划、预计完成时间"

]

rules_prompt = generate_safety_rules_prompt(ethical_rules, operation_rules, optimization_rules)

print(rules_prompt)

心法三:反馈优化——让AI"越用越聪明"的"错题本"

Agentic AI不是"一次性用品",需要通过"反馈优化"持续提升能力。就像老师批改作业,告诉学生"这道题错在哪,下次怎么改",提示工程架构师需要设计"反馈收集→错误分析→提示更新"的闭环。

反馈优化的"五步流程"

- 收集反馈数据:记录AI的"错误案例"(如误判火情、调度路线不合理);

- 分析错误原因:是"提示不清晰"(如没说"烟雾浓度>0.5mg/m³才是火灾")还是"AI能力不足"(如无法识别新型火灾传感器数据);

- 更新提示模板:针对"提示不清晰"的问题,优化提示内容;

- 补充训练数据:针对"AI能力不足",提供更多标注数据(如新型传感器数据样本);

- A/B测试验证:用新旧提示模板处理相同事件,对比效果(如响应时间、准确率)。

Python代码示例:错误案例反馈模板

def generate_feedback_prompt(mistake_case, cause_analysis, improved_prompt):

prompt = f"""

【错误案例记录】

事件:{mistake_case['event']}

错误行为:{mistake_case['behavior']}

后果:{mistake_case['consequence']}

【原因分析】

{cause_analysis}

【改进提示】

原提示:{mistake_case['old_prompt']}

新提示:{improved_prompt}

请基于以上信息,更新你的决策模型:

1. 记住这个错误案例的特征:当遇到"{mistake_case['event_feature']}"时,不要"{mistake_case['behavior']}";

2. 使用新提示中的规则"{improved_prompt_key_rule}"来处理类似事件;

3. 下次遇到不确定的情况,先检查是否符合新提示中的规则。

"""

return prompt

# 使用示例(误判"炊烟"为"火灾"的案例)

mistake_case = {

"event": "农村地区清晨烟雾检测",

"behavior": "AI判定为'火灾',触发消防出警",

"consequence": "虚警,浪费消防资源,影响居民正常生活",

"old_prompt": "当传感器检测到烟雾浓度>0.3mg/m³时,判定为火灾并报警",

"event_feature": "农村地区+清晨5-7点+烟雾浓度0.3-0.5mg/m³+无高温信号"

}

cause_analysis = "原提示未考虑'农村地区清晨做饭产生炊烟'的场景,仅以烟雾浓度单一指标判断,导致误判。"

improved_prompt = "当传感器检测到烟雾浓度>0.3mg/m³时:\n- 若同时满足'温度>60℃'或'有火光信号',判定为火灾并报警;\n- 若为农村地区且时间在5-7点,且无温度/火光信号,标记为'疑似炊烟',仅通知辖区网格员现场确认,不触发消防出警。"

improved_prompt_key_rule = "农村地区清晨烟雾需结合温度/火光信号判断,无高温/火光则仅通知网格员"

feedback_prompt = generate_feedback_prompt(mistake_case, cause_analysis, improved_prompt)

print(feedback_prompt)

数学模型和公式 & 详细讲解 & 举例说明

Agentic AI的决策过程本质是"在不确定环境中选择最优行动",背后依赖马尔可夫决策过程(MDP) 数学模型。理解MDP能帮助提示工程架构师设计更科学的"任务目标"和"奖励机制"。

马尔可夫决策过程(MDP):AI决策的"数学指南针"

MDP的核心要素(像"寻宝游戏")

想象AI在玩"寻宝游戏",它需要决定"往哪走"才能最快找到宝藏。MDP用5个要素描述这个过程:

-

状态(State, S):游戏当前的"画面"(如AI在位置A,周围有3条路,背包里有1把钥匙)。

在公共安全中:“当前火灾位置在商场3楼,温度80℃,烟雾浓度0.8mg/m³,最近的消防通道畅通”。 -

动作(Action, A):AI可以选择的"操作"(如向左走、向右走、用钥匙开门)。

在公共安全中:“派无人机去确认火情、调消防云梯车、疏散周边居民”。 -

奖励(Reward, R):执行动作后得到的"分数"(找到宝藏+100分,掉进陷阱-50分)。

在公共安全中:“疏散1名人员+10分,响应时间每缩短1分钟+5分,误判导致虚警-100分”。 -

状态转移概率(Transition Probability, P):执行动作后"画面变化的概率"(如向左走有80%概率到位置B,20%概率遇到怪物)。

在公共安全中:“派无人机确认火情,有90%概率获得高清画面,10%概率因信号干扰失败”。 -

折扣因子(Discount Factor, γ):“未来奖励"的"当前价值”(如10天后的100分,相当于现在的50分,γ=0.5)。

在公共安全中:“优先考虑眼前的人员安全(γ=0.9),其次是长期的资源节省(γ=0.3)”。

MDP的核心公式:贝尔曼方程(Bellman Equation)

MDP的目标是找到最优策略(Policy, π):在每个状态下选择能获得"最大累积奖励"的动作。这个策略通过贝尔曼方程计算:

V∗(s)=maxa[R(s,a)+γ∑s′P(s′∣s,a)V∗(s′)]V^*(s) = \max_a \left[ R(s,a) + \gamma \sum_{s'} P(s'|s,a) V^*(s') \right]V∗(s)=amax[R(s,a)+γs′∑P(s′∣s,a)V∗(s′)]

其中:

- ( V^*(s) ):状态( s )的"最优价值"(从状态( s )出发,能获得的最大累积奖励);

- ( \max_a ):对所有可能的动作( a ),选择能让结果最大的那个;

- ( R(s,a) ):在状态( s )执行动作( a )的即时奖励;

- ( \gamma \sum_{s’} P(s’|s,a) V^*(s’) ):未来所有状态的"折扣价值"之和(考虑转移概率和折扣因子)。

举例:用MDP模型优化"火灾应急响应策略"

场景:火灾发生,AI需要选择"先派无人机确认"还是"直接派消防车出警"。

参数设定:

- 状态( s ):火灾初期(烟雾浓度0.5mg/m³,无温度数据);

- 动作( a_1 ):派无人机确认(成本5分钟,成功概率90%);

- 动作( a_2 ):直接派消防车(成本0分钟,若为虚警则浪费资源);

- 奖励( R ):

- 成功扑灭真火灾:+200分;

- 虚警(如炊烟):-100分;

- 无人机确认时间成本:-25分(5分钟×5分/分钟);

- 转移概率( P ):

- ( a_1 )成功确认:90%概率判断"真火灾"或"虚警";

- ( a_1 )失败:10%概率仍无法判断;

- 折扣因子( \gamma = 0.9 )(重视未来奖励)。

计算最优动作:

-

若选( a_1 )(派无人机):

- 90%概率确认:

- 若为真火灾:后续派消防车,总奖励= -25(时间成本)+ 200(灭火成功)= 175;

- 若为虚警:不派消防车,总奖励= -25(时间成本)+ 0(无虚警)= -25;

- 10%概率失败:仍无法判断,需派消防车,总奖励= -25(时间成本)+ 50%×200 + 50%×(-100) = -25 + 50 = 25;

- 期望奖励:( 0.9×(0.5×175 + 0.5×(-25)) + 0.1×25 = 0.9×75 + 2.5 = 70 )。

- 90%概率确认:

-

若选( a_2 )(直接派消防车):

- 50%概率真火灾:奖励=200;

- 50%概率虚警:奖励=-100;

- 期望奖励:( 0.5×200 + 0.5×(-100) = 50 )。

因为70 > 50,所以最优策略是先派无人机确认——这就是MDP模型指导AI做出的理性决策。

项目实战:搭建"城市火灾应急响应Agent"系统

开发环境搭建

硬件要求

- CPU:4核以上(多模态数据处理需要);

- 内存:16GB以上(向量数据库和模型加载需要);

- 网络:稳定的互联网连接(调用API和实时数据)。

软件和库

- 编程语言:Python 3.9+;

- 核心库:

LangChain(构建Agentic AI框架);OpenAI/Anthropic(调用LLM模型,如GPT-4、Claude);Pillow/OpenCV(图像处理,模拟监控视频分析);pyaudio/speech_recognition(语音处理,模拟报警电话识别);faiss(向量数据库,存储历史案例和规则);folium(地图可视化,展示火灾位置和资源调度)。

环境安装命令

pip install langchain openai pillow opencv-python speechrecognition faiss-cpu folium python-dotenv

源代码详细实现和代码解读

我们将构建一个简化版"火灾应急响应Agent",包含"多模态数据输入→提示工程注入→任务规划→执行→反馈"完整流程。

步骤1:定义Agent核心组件(感知、决策、执行模块)

import os

import cv2

import folium

from langchain.llms import OpenAI

from langchain.agents import initialize_agent, Tool

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

from dotenv import load_dotenv

import speech_recognition as sr

# 加载环境变量(OpenAI API密钥)

load_dotenv()

openai_api_key = os.getenv("OPENAI_API_KEY")

# 1. 感知模块:处理多模态数据

class PerceptionModule:

@staticmethod

def analyze_video(video_path):

"""模拟分析监控视频,提取火情特征"""

# 实际应用中会用CV模型(如YOLO)检测火焰、烟雾

# 这里简化:随机生成"是否有火""烟雾浓度""温度"

import random

has_fire = random.choice([True, False])

smoke_density = round(random.uniform(0.2, 0.8), 2)

temperature = round(random.uniform(30, 100), 1) if has_fire else round(random.uniform(20, 30), 1)

return {

"has_fire": has_fire,

"smoke_density": smoke_density,

"temperature": temperature,

"location": "城市中心广场A区" # 模拟从视频元数据提取位置

}

@staticmethod

def transcribe_call(audio_path):

"""模拟转录报警电话"""

# 实际应用中用ASR模型,这里简化:预设一段报警语音文本

return "喂!中心广场这边冒烟了!好像是草地着火了,旁边有好多人在野餐!"

# 2. 执行模块:调用外部工具(发通知、调资源、生成报告)

class ExecutionModule:

@staticmethod

def notify_fire_department(info):

"""通知消防部门"""

print(f"[执行] 发送给消防部门:{info}")

return f"消防部门已收到通知,预计{info['estimated_arrival']}分钟后到达"

@staticmethod

def alert_residents(location, radius=1000):

"""通知周边居民"""

print(f"[执行] 向{location}周边{radius}米居民发送短信:'附近发生火情,请远离危险区域'")

return f"已通知{radius}米内约{int(radius/10)}户居民"

@staticmethod

def generate_report(event_id, process_steps):

"""生成事件报告"""

report = f"火灾应急响应报告(事件ID:{event_id})\n"

report += "="*50 + "\n"

for i, step in enumerate(process_steps, 1):

report += f"{i}. {step}\n"

return report

# 3. 记忆模块:存储历史案例和规则(用字典模拟向量数据库)

class MemoryModule:

def __init__(self):

self.case_base = {} # 事件ID: 报告

self.rules = [] # 安全规则列表

def save_case(self, event_id, report):

self.case_base[event_id] = report

def load_rules(self, rules):

self.rules = rules

# 4. 决策模块:基于LangChain和LLM实现任务规划

class DecisionModule:

def __init__(self, llm, tools, memory):

self.llm = llm

self.tools = tools

self.memory = memory

# 初始化Agent

self.agent = initialize_agent(

tools=tools,

llm=llm,

agent="zero-shot-react-description",

verbose=True # 打印思考过程

)

def plan_and_execute(self, prompt):

"""执行任务规划和行动"""

return self.agent.run(prompt)

步骤2:定义工具函数(Agent可调用的外部能力)

# 实例化模块

perception = PerceptionModule()

execution = ExecutionModule()

memory = MemoryModule()

llm = OpenAI(temperature=0.7, openai_api_key=openai_api_key) # temperature=0.7表示适度创造性

# 定义Agent可调用的工具

tools = [

Tool(

name="VideoAnalyzer",

func=perception.analyze_video,

description="用于分析监控视频,获取火情特征(是否有火、烟雾浓度、温度、位置)。输入:视频文件路径;输出:包含has_fire, smoke_density, temperature, location的字典。"

),

Tool(

name="CallTranscriber",

func=perception.transcribe_call,

description="用于转录报警电话语音,提取关键信息(事件描述、位置、人员情况)。输入:音频文件路径;输出:转录文本。"

),

Tool(

name="FireDepartmentNotifier",

func=execution.notify_fire_department,

description="用于通知消防部门,需要提供火情信息(位置、火势、是否有人员被困)。输入:包含location, fire_scale, has_people的字典;输出:消防部门响应结果。"

),

Tool(

name="ResidentAlerts",

func=execution.alert_residents,

description="用于向火灾周边居民发送预警短信。输入:location(位置),可选radius(半径,默认1000米);输出:通知结果。"

),

Tool(

name="ReportGenerator",

func=execution.generate_report,

description="用于生成事件处理报告。输入:event_id(事件ID),process_steps(处理步骤列表);输出:报告文本。"

)

]

步骤3:注入提示工程(目标、规则、任务)

# 加载安全规则(来自之前的"规则嵌入"示例)

safety_rules = [

"伦理红线:禁止伪造火情数据,禁止泄露居民个人信息",

"安全操作:疏散学校/医院需人类审批,派消防前需确认火情真实性",

"优化提示:优先派无人机确认火情,响应时间目标5分钟内"

]

memory.load_rules(safety_rules)

# 定义提示模板(整合目标、规则、任务)

prompt_template = """

你是城市火灾应急响应Agent,目标是"快速、准确、安全地处理火灾事件,减少人员伤亡和财产损失"。

=== 安全规则 ===

{safety_rules}

=== 可用工具 ===

{tools_description}

=== 当前任务 ===

处理一个新的火灾事件:有市民报警称"中心广场有烟雾",

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)