【GitHub项目推荐--ChatTTS:对话式文本转语音系统完全指南】

ChatTTS 是一款专为对话场景设计的生成式语音模型,由2noise团队开发。它针对日常对话和LLM助手应用进行了优化,支持中英文双语,能够生成自然且富有表现力的语音,特别适合对话式人工智能应用。🔗 GitHub地址🚀 核心价值:对话优化 · 多语言支持 · 细粒度控制 · 开源免费项目背景:对话需求:解决传统TTS在对话场景中表现不自然的问题多语言挑战:支持中英文混合

简介

ChatTTS 是一款专为对话场景设计的生成式语音模型,由2noise团队开发。它针对日常对话和LLM助手应用进行了优化,支持中英文双语,能够生成自然且富有表现力的语音,特别适合对话式人工智能应用。

🔗 GitHub地址:

https://github.com/2noise/ChatTTS

🚀 核心价值:

对话优化 · 多语言支持 · 细粒度控制 · 开源免费

项目背景:

-

对话需求:解决传统TTS在对话场景中表现不自然的问题

-

多语言挑战:支持中英文混合输入的语音合成

-

情感表达:需要更丰富的语音表情和情感传递

-

开源生态:为AI社区提供高质量的对话TTS解决方案

技术特色:

-

🗣️ 对话优化:专门为对话场景设计和优化

-

🌐 双语支持:原生支持中文和英文混合输入

-

🎭 情感控制:细粒度的韵律和情感控制

-

🔊 高质量输出:超越多数开源TTS的语音质量

-

🔧 易用性:简单的API和丰富的控制选项

设计理念:

-

自然对话:追求对话的自然流畅和真实感

-

精细控制:提供音素级别的精细控制能力

-

多说话人:支持多个说话人声音和风格

-

开放标准:遵循开源标准和最佳实践

-

社区驱动:鼓励社区贡献和生态发展

主要功能

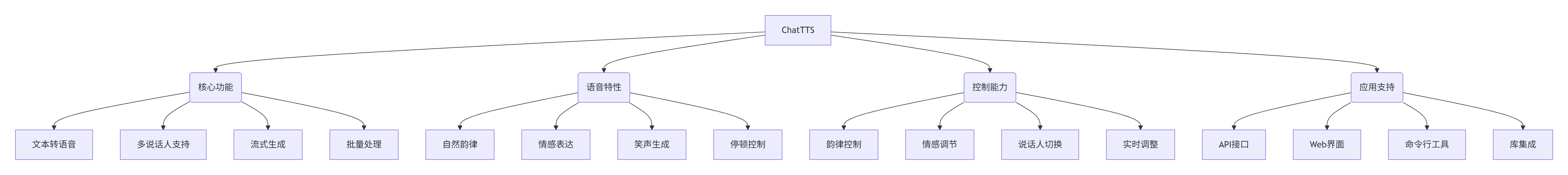

1. 核心功能架构

2. 功能详情

语音合成能力:

-

高质量输出:生成自然流畅的语音音频

-

多说话人:支持多个不同声音的说话人

-

中英文混合:无缝处理中英文混合文本

-

韵律自然:对话特有的韵律和节奏感

-

情感丰富:传达丰富的情感和语气变化

精细控制功能:

-

笑声控制:生成不同强度和类型的笑声

-

停顿插入:控制语句中的停顿位置和时长

-

语气调节:调整语音的语气和情感色彩

-

韵律调整:精细控制语音的韵律特征

-

实时调节:生成过程中实时调整参数

技术特性:

-

高效推理:优化的推理速度和资源使用

-

流式支持:支持流式音频生成和处理

-

批量处理:高效处理大批量文本输入

-

质量优化:持续优化的语音质量

-

兼容性好:支持多种硬件和软件环境

应用支持:

-

API接口:提供简洁的编程接口

-

Web界面:图形化用户界面操作

-

命令行工具:终端命令直接使用

-

库集成:易于集成到其他项目中

-

扩展插件:支持功能扩展和定制

3. 技术规格

模型规格:

# 模型信息

训练数据: 100,000+小时中英文音频

开源版本: 40,000小时预训练模型

模型架构: 自回归生成式模型

音频格式: 24kHz采样率,单声道

# 性能指标

实时因子: ~0.3 (RTF)

生成速度: ~7语义标记/秒 (4090 GPU)

内存需求: 4GB+ GPU内存 (30秒音频)

质量评分: 优于多数开源TTS模型系统要求:

# 硬件要求

GPU: NVIDIA GPU (推荐), 支持CUDA

CPU: 现代多核处理器

内存: 8GB+ RAM

存储: 10GB+ 可用空间

# 软件要求

操作系统: Linux, Windows, macOS

Python: 3.8+

PyTorch: 2.0+

CUDA: 11.7+ (如使用GPU)

# 可选组件

vLLM: 推理加速 (Linux only)

FlashAttention: 注意力优化

TransformerEngine: NVIDIA优化引擎支持特性:

-

语言支持:中文、英文、中英混合

-

音频格式:WAV, MP3, 原始音频数组

-

采样率:24kHz (标准), 可调整

-

比特深度:16-bit PCM

-

声道:单声道 (优化对话场景)

质量控制:

-

韵律质量:优秀的韵律和自然度

-

情感表达:丰富的情感传递能力

-

音质清晰:清晰的语音音质

-

稳定性:稳定的生成质量

-

一致性:说话人声音一致性

安装与配置

1. 环境准备

系统要求:

# Python环境

Python 3.8, 3.9, 3.10, 3.11

pip 包管理器

virtualenv 或 conda (可选)

# GPU支持 (可选但推荐)

NVIDIA GPU + CUDA Toolkit

cuDNN 库

最新NVIDIA驱动

# 系统依赖

FFmpeg (音频处理)

开发工具链 (编译依赖)账户准备:

# 可选服务

HuggingFace账户 (模型下载)

GPU云服务账户 (如需要)

监控工具账户 (性能监控)2. 安装步骤

pip安装(推荐):

# 安装稳定版

pip install chattts

# 安装最新版

pip install git+https://github.com/2noise/ChatTTS.git

# 或从本地安装

git clone https://github.com/2noise/ChatTTS.git

cd ChatTTS

pip install -e .conda环境安装:

# 创建conda环境

conda create -n chattts python=3.11

conda activate chattts

# 安装依赖

pip install -r requirements.txt

# 验证安装

python -c "import ChatTTS; print('安装成功')"Docker安装:

# 使用预构建镜像

docker pull 2noise/chattts:latest

# 或从源码构建

docker build -t chattts .

# 运行容器

docker run -it --gpus all -p 7860:7860 chattts开发环境安装:

# 安装开发依赖

pip install -r requirements-dev.txt

# 安装测试工具

pip install pytest pytest-cov

# 安装文档工具

pip install sphinx sphinx-rtd-theme

# 验证开发环境

pytest tests/ -v3. 配置说明

基本配置:

# 环境变量配置

export CHATTTS_CACHE_DIR="~/.cache/chattts"

export CHATTTS_MODEL_PATH="~/models/chattts"

export CHATTTS_LOG_LEVEL="INFO"

# 或使用配置文件

# ~/.chattts/config.yaml

cache_dir: "~/.cache/chattts"

model_path: "~/models/chattts"

log_level: "INFO"

default_speaker: "default"模型配置:

# 模型下载和管理

# 自动下载预训练模型

# 或手动下载放置到指定目录

# 模型目录结构

models/

├── chattts/

│ ├── config.json

│ ├── model.safetensors

│ └── vocoder/

└── custom/

└── your_model/GPU配置:

# CUDA配置

export CUDA_VISIBLE_DEVICES="0" # 使用特定GPU

export CUDA_LAUNCH_BLOCKING=1 # 调试模式

export TF32_ENABLE=1 # TF32支持

# 内存优化

export PYTORCH_CUDA_ALLOC_CONF="expandable_segments:True"

export CUDA_DEVICE_MAX_CONNECTIONS=1性能优化:

# 推理优化

export CHATTTS_BATCH_SIZE=4

export CHATTTS_MAX_LENGTH=500

export CHATTTS_PRECISION="fp16"

# 内存优化

export CHATTTS_USE_GRADIENT_CHECKPOINTING=true

export CHATTTS_USE_FLASH_ATTENTION=true使用指南

1. 基本工作流

使用ChatTTS的基本流程包括:初始化模型 → 准备文本 → 设置参数 → 生成语音 → 保存输出。整个过程设计为简单直观,开发者友好。

2. 基本使用

基础语音合成:

import ChatTTS

import torchaudio

# 初始化模型

chat = ChatTTS.Chat()

chat.load(compile=False) # 设置为True获得更好性能

# 准备文本

texts = [

"欢迎使用ChatTTS语音合成系统",

"这是一个支持中英文混合的TTS模型"

]

# 生成语音

wavs = chat.infer(texts)

# 保存输出

for i, wav in enumerate(wavs):

torchaudio.save(f"output_{i}.wav", wav, 24000)多说话人支持:

# 随机采样说话人

rand_spk = chat.sample_random_speaker()

print("采样说话人:", rand_spk)

# 使用特定说话人

params = ChatTTS.Chat.InferCodeParams(

spk_emb=rand_spk,

temperature=0.3,

top_P=0.7,

top_K=20

)

wavs = chat.infer(texts, params_infer_code=params)精细控制:

# 韵律和情感控制

params_refine = ChatTTS.Chat.RefineTextParams(

prompt='[oral_2][laugh_0][break_6]'

)

# 生成带控制的语音

wavs = chat.infer(

texts,

params_refine_text=params_refine,

params_infer_code=params

)高级功能:

# 单词级别控制

text = "什么是[uv_break]你最喜欢的食物?[laugh][lbreak]"

wavs = chat.infer(

text,

skip_refine_text=True,

params_refine_text=params_refine,

params_infer_code=params

)3. 高级功能

批量处理:

# 批量文本处理

batch_texts = [

["句子1", "句子2", "句子3"],

["另一个批次的句子1", "句子2"]

]

batch_results = []

for texts in batch_texts:

wavs = chat.infer(texts)

batch_results.append(wavs)流式生成:

# 流式处理示例

def stream_callback(chunk, index, total):

print(f"生成进度: {index}/{total}")

# 处理音频块或实时播放

wavs = chat.infer(

texts,

stream_callback=stream_callback,

stream_chunk_size=500 # 每500样本回调一次

)质量优化:

# 高质量生成设置

high_quality_params = ChatTTS.Chat.InferCodeParams(

temperature=0.2, # 更低温度,更确定性的输出

top_P=0.9, # 更高的top-P值

top_K=40, # 更多的候选

repetition_penalty=1.1 # 重复惩罚

)

wavs = chat.infer(texts, params_infer_code=high_quality_params)自定义配置:

# 完全自定义配置

custom_config = {

"max_length": 1000,

"num_beams": 3,

"length_penalty": 1.0,

"early_stopping": True,

"no_repeat_ngram_size": 3

}

wavs = chat.infer(texts, **custom_config)应用场景实例

案例1:智能语音助手对话系统

场景:开发智能语音助手需要自然的对话语音

解决方案:使用ChatTTS为AI助手提供高质量的对话语音。

实施配置:

import ChatTTS

import numpy as np

class VoiceAssistant:

def __init__(self):

self.chat = ChatTTS.Chat()

self.chat.load(compile=True)

self.speaker = self.chat.sample_random_speaker()

def respond(self, text, emotion="neutral"):

# 根据情感选择参数

if emotion == "happy":

prompt = '[oral_2][laugh_1][break_4]'

elif emotion == "sad":

prompt = '[oral_1][break_6]'

else:

prompt = '[oral_2][break_4]'

params_refine = ChatTTS.Chat.RefineTextParams(prompt=prompt)

params_infer = ChatTTS.Chat.InferCodeParams(

spk_emb=self.speaker,

temperature=0.3

)

wav = self.chat.infer(

[text],

params_refine_text=params_refine,

params_infer_code=params_infer

)[0]

return wav

# 使用助手

assistant = VoiceAssistant()

response = assistant.respond("你好,我是智能助手,很高兴为你服务!", emotion="happy")对话优化特性:

-

自然回应:对话式的语音韵律和节奏

-

情感适应:根据对话内容调整情感表达

-

多轮对话:保持说话人一致性 across turns

-

实时生成:快速响应对话需求

-

质量稳定:一致的语音质量

实施效果:

-

用户体验:更自然和愉悦的对话体验

-

交互质量:提高语音交互的成功率

-

情感连接:更好的情感共鸣和连接

-

可用性:支持长时间对话不疲劳

-

个性化:可定制的说话人特性

案例2:有声内容创作和播客制作

场景:内容创作者需要高效制作高质量有声内容

解决方案:使用ChatTTS批量生成播客和有声音频内容。

内容生产流程:

import ChatTTS

import torchaudio

from pathlib import Path

class AudioContentProducer:

def __init__(self, voice_profile="professional"):

self.chat = ChatTTS.Chat()

self.chat.load()

# 根据内容类型选择声音配置

self.voice_profiles = {

"professional": self._setup_professional_voice(),

"casual": self._setup_casual_voice(),

"narrative": self._setup_narrative_voice()

}

self.current_profile = voice_profile

def produce_episode(self, script_path, output_dir):

with open(script_path, 'r', encoding='utf-8') as f:

segments = f.read().split('\n\n')

output_path = Path(output_dir)

output_path.mkdir(exist_ok=True)

for i, segment in enumerate(segments):

if segment.strip():

audio = self._generate_segment(segment)

torchaudio.save(

output_path / f"segment_{i:03d}.wav",

audio, 24000

)

def _generate_segment(self, text):

params = self.voice_profiles[self.current_profile]

return self.chat.infer([text], **params)[0]

# 创建专业播客内容

producer = AudioContentProducer("professional")

producer.produce_episode("script.txt", "output_episode")制作功能:

-

批量生成:高效处理大量文本内容

-

多声音选择:不同内容类型使用不同声音

-

质量一致:保证整个系列的质量一致性

-

格式支持:支持各种音频输出格式

-

元数据:自动添加音频元数据和标签

内容类型支持:

-

教育内容:课程讲解和教学材料

-

娱乐内容:故事讲述和娱乐节目

-

新闻播报:新闻和资讯播报

-

企业培训:企业培训材料制作

-

多语言内容:中英文混合内容制作

实施价值:

-

生产效率:大幅提高音频内容制作效率

-

成本控制:降低录音和后期制作成本

-

质量保证:确保音频质量的稳定性

-

规模扩展:轻松扩展内容生产规模

-

个性化:为不同受众定制声音特性

案例3:教育辅助和语言学习工具

场景:教育机构需要个性化语言学习材料

解决方案:使用ChatTTS生成定制化的语言学习音频材料。

教育应用实现:

import ChatTTS

import torchaudio

import json

class LanguageLearningTools:

def __init__(self):

self.chat = ChatTTS.Chat()

self.chat.load()

def generate_pronunciation_guide(self, words, language="chinese"):

"""生成单词发音指导"""

results = {}

for word in words:

# 生成标准发音

standard_audio = self.chat.infer([word])[0]

# 生成慢速发音

slow_params = ChatTTS.Chat.InferCodeParams(

speed_factor=0.7 # 70%速度

)

slow_audio = self.chat.infer([word], params_infer_code=slow_params)[0]

results[word] = {

'standard': standard_audio,

'slow': slow_audio

}

return results

def create_dialogue_exercises(self, dialogues, roles=2):

"""生成对话练习材料"""

exercises = []

for dialogue in dialogues:

# 为每个角色分配不同声音

speakers = [self.chat.sample_random_speaker() for _ in range(roles)]

dialogue_audio = []

for i, line in enumerate(dialogue['lines']):

speaker_idx = i % roles

params = ChatTTS.Chat.InferCodeParams(

spk_emb=speakers[speaker_idx]

)

audio = self.chat.infer([line], params_infer_code=params)[0]

dialogue_audio.append(audio)

exercises.append({

'dialogue': dialogue['title'],

'audio_segments': dialogue_audio

})

return exercises

# 生成学习材料

learning_tools = LanguageLearningTools()

# 发音指导

words = ["hello", "world", "谢谢", "你好"]

pronunciation_guide = learning_tools.generate_pronunciation_guide(words)

# 对话练习

dialogues = [

{

'title': '基础问候',

'lines': ['你好!', 'Hello!', '最近怎么样?', '很好,谢谢!']

}

]

dialogue_exercises = learning_tools.create_dialogue_exercises(dialogues)教育功能:

-

发音指导:标准发音和慢速发音对比

-

对话练习:多角色对话情景练习

-

听力材料:定制化听力理解材料

-

语音评估:发音对比和评估参考

-

个性化学习:根据学习者水平调整语速和复杂度

学习价值:

-

发音准确:提供准确的发音示范

-

听力训练:丰富的听力训练材料

-

情景学习:真实对话情景模拟

-

个性化:适应不同学习者的需求

-

效率提升:快速生成定制化学习材料

实施效果:

-

学习效果:提高语言学习效率和效果

-

资源丰富:提供丰富的学习资源

-

成本降低:降低教学材料制作成本

-

可及性:使高质量学习材料更易获得

-

适应性:适应不同教学方法和需求

生态系统与社区

1. 社区资源

获取帮助:

-

📚 官方文档:GitHub README和Wiki文档

-

💬 社区讨论:Discord服务器和QQ群组

-

🐛 问题报告:通过GitHub Issues报告问题

-

💡 功能建议:提交新功能请求和改进建议

支持渠道:

-

GitHub Issues:主要的问题跟踪和功能请求

-

Discord社区:国际用户社区交流

-

QQ群组:中文用户交流和支持

-

邮件支持:正式咨询和技术支持

贡献指南:

-

Fork项目仓库

-

创建特性分支 (

git checkout -b feature/AmazingFeature) -

提交更改 (

git commit -m 'Add some AmazingFeature') -

推送到分支 (

git push origin feature/AmazingFeature) -

发起Pull Request

2. 相关工具集成

TTS生态系统:

-

bark:参考的自回归TTS系统

-

XTTSv2:多语言TTS模型参考

-

valle:自回归语音生成架构

-

fish-speech:GVQ音频标记化参考

-

vocos:预训练声码器使用

开发工具集成:

-

HuggingFace:模型托管和分享

-

PyTorch:核心深度学习框架

-

TorchAudio:音频处理和保存

-

Transformers:Transformer模型支持

-

vLLM:推理加速和优化

部署平台:

-

Docker:容器化部署

-

Kubernetes:云原生部署

-

AWS/GCP/Azure:云平台部署

-

本地服务器:本地部署和推理

-

边缘设备:边缘计算部署

总结

ChatTTS作为专为对话场景优化的文本转语音系统,在语音质量、自然度和控制能力方面提供了出色的性能。其开源特性和活跃的社区支持使其成为对话AI和语音应用开发的理想选择。

核心优势:

-

🚀 对话优化:专门为对话场景设计和优化

-

🌐 双语支持:原生支持中文和英文混合

-

🎭 精细控制:音素级别的精细控制能力

-

🔊 高质量输出:超越多数开源TTS的语音质量

-

🔧 易用性好:简单的API和丰富的示例

适用场景:

-

智能语音助手和对话系统

-

有声内容创作和播客制作

-

教育辅助和语言学习工具

-

娱乐内容和游戏语音

-

企业培训和教育材料

技术特色:

-

多说话人:支持多个不同声音特性

-

情感控制:丰富的韵律和情感表达

-

高效推理:优化的性能和资源使用

-

流式支持:实时流式音频生成

-

扩展性强:易于集成和功能扩展

🌟 GitHub地址:

https://github.com/2noise/ChatTTS

🚀 快速安装:

pip install chattts💬 社区支持:

加入Discord或QQ群获取帮助

立即开始使用ChatTTS,为您的应用添加自然对话语音!

最佳实践建议:

-

🏁 初学者:从基础示例开始学习

-

🎯 开发者:探索高级控制功能

-

🎨 内容创作者:尝试多说话人和情感控制

-

🏫 教育工作者:利用发音指导和对话生成

-

🔧 高级用户:研究自定义模型和优化

注意事项:

-

⚠️ 硬件要求:确保满足GPU内存要求

-

🔒 许可协议:遵守AGPLv3+和CC BY-NC 4.0许可

-

💾 资源管理:监控GPU内存和计算资源

-

📊 质量测试:重要应用进行充分质量测试

-

🔄 持续学习:关注版本更新和新功能

ChatTTS持续演进和发展,欢迎加入社区共同推动对话语音技术的进步!

更多推荐

已为社区贡献131条内容

已为社区贡献131条内容

所有评论(0)