【AI论文】通过环境扩展迈向通用智能体智能

研究摘要:本研究提出AgenticCPT框架,通过两阶段训练策略构建深度研究代理模型AgentFounder。该框架采用First-order和Higher-order行动合成方法生成多样化训练数据,有效解决了开放域深度研究任务中的优化冲突问题。在10个基准测试中,AgentFounder-30B表现优异,尤其在跨语言检索(BrowseComp-zh达43.3%)和学术场景(AcademicBro

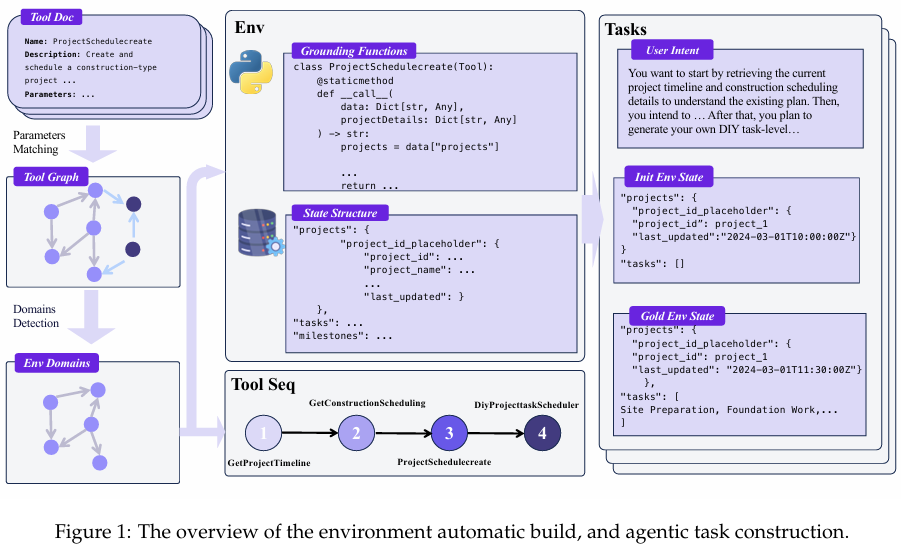

摘要:高级智能体智能是将大型语言模型应用于实际现实场景的前提条件。现实世界中种类繁多的应用程序接口(API)要求具备精准、稳健的函数调用智能,而这需要智能体通过在不同环境中的交互来培养这些能力。函数调用能力的广度与智能体训练环境的多样性紧密相关。在本研究中,我们通过扩展环境规模来推动通用智能体智能的发展。这引发了两个核心挑战:(i)如何以系统化的方式扩展环境规模;(ii)如何通过与这些环境交互所获得的经验,有效训练智能体的相关能力。为应对这些挑战,我们设计了一个可扩展的框架,该框架能够自动构建完全模拟的异构环境,从而系统性地拓展函数调用场景的空间。此外,我们采用了一种两阶段的智能体微调策略:首先赋予智能体基础智能体能力,然后使其针对特定领域情境进行专业化调整。在智能体基准测试tau-bench、tau2-Bench和ACEBench上开展的广泛实验表明,我们训练的模型AgentScaler显著提升了模型的函数调用能力。Huggingface链接:Paper page,论文链接:2509.13311

研究背景和目的

研究背景:

随着大型语言模型(LLMs)在自然语言处理领域的广泛应用,其在特定任务中的表现已经取得了显著进展,例如事实问答、文档摘要生成和代码生成等。然而,在开放域任务中,尤其是涉及多步推理、动态工具使用和复杂环境交互的场景,现有语言模型的表现仍显不足。这些任务要求模型不仅具备强大的语言理解能力,还需要能够自主浏览和整合大量信息,进行多步推理,并生成详细且具有深度的报告。开放式的深度研究(Open-Ended Deep Research, OEDR)领域正是这样一个典型场景,它要求模型能够像人类研究员一样,自主制定研究计划,调用相关工具,整合信息,并最终生成高质量的报告。

尽管已有一些研究尝试通过构建静态研究流程或采用一次性生成范式来解决OEDR问题,但这些方法往往受限于固定的研究路径和有限的交互能力,导致信息丢失、注意力分散和报告质量不高。此外,这些方法在训练过程中常常面临优化冲突,即同时提升模型的能力和对齐性(即模型行为与人类专家演示的一致性)时,难以达到最优效果。因此,如何构建一个能够动态适应复杂任务、有效整合信息并生成高质量报告的深度研究代理模型,成为当前人工智能领域的一个重要研究方向。

研究目的:

本研究旨在解决现有OEDR方法中的关键问题,提出一种名为Agentic Continual Pre-training(Agentic CPT)的新型训练框架,以构建强大的深度研究代理模型AgentFounder。具体目标包括:

- 提升模型在动态环境中的对齐能力:使模型能够在复杂任务中保持与人类专家演示的行为一致性,包括多步推理、工具调用和适应性响应。

- 克服静态基础模型的限制:通过Agentic CPT提供预对齐的Agentic基础模型,支持有效的下游微调,避免同时学习能力和对齐性时产生的优化冲突。

- 提高报告生成的全面性和可靠性:通过系统且可扩展的训练数据合成方法和渐进式训练策略,使模型能够生成结构良好、内容全面且基于可靠来源的报告。

研究方法

Agentic Continual Pre-training框架:

本研究提出的Agentic CPT框架包含两个核心阶段:数据收集和预训练。

数据收集阶段:

数据收集阶段强调种子数据源的广泛性和多样性,以确保训练数据涵盖各种类型的Agentic行为。数据源包括新闻网站、学术数据库、论坛等,以确保数据的全面性和时效性。通过爬虫技术和API接口,收集大量结构化和非结构化数据,为后续的数据合成提供丰富的素材。

预训练阶段:

预训练阶段通过First-order Action Synthesis(FAS)和Higher-order Action Synthesis(HAS)两种方法生成大规模的训练数据,并采用渐进式两阶段训练策略。

- First-order Action Synthesis(FAS):

- 实体锚定的开放世界知识记忆:将各种来源的文本转换为开放世界记忆,以实体为索引键映射到相关声明,形成结构化的知识库。

- 多风格问题合成:基于实体锚定的知识记忆,生成涵盖事实检索、数值计算、多跳推理和综合任务等多样化问题,模拟真实世界中的查询需求。

- 规划行动合成:通过分析复杂问题的初始分解,生成合理的规划和下一步工具调用数据,模拟人类研究员的研究路径。

- 逻辑推理行动合成:生成逐步推理过程,最终得出答案的逻辑推理链数据,提升模型的推理能力。

- Higher-order Action Synthesis(HAS):

- 轨迹重塑:将轨迹视为多步决策过程,通过扩展每个步骤的潜在探索路径,生成多样化的行为模式,增加数据的多样性。

- 合成多步决策文本数据:将重塑后的轨迹与新生成的探索路径合并,形成多步决策文本数据,增强模型的探索和决策能力。

- 渐进式两阶段训练策略:

- 第一阶段:主要利用FAS数据和短HAS数据,在32K上下文窗口内进行训练,使模型快速掌握基本的研究和推理能力。

- 第二阶段:专注于高质量的HAS数据,扩展上下文长度至128K,进一步提升模型的复杂行为理解和长距离规划能力,使其能够处理更复杂的任务。

实验设计:

实验在10个基准测试上进行,包括通用网页搜索基准(BrowseComp-en、BrowseComp-zh、GAIA、Xbench-DeepSearch、WebWalkerQA)和场景定向网页搜索基准(DeepResearch Bench、SEAL-0、Frames、HLE、Academic Browse)。通过比较AgentFounder与现有SOTA模型在不同基准上的表现,验证Agentic CPT框架的有效性。

研究结果

性能对比:

AgentFounder-30B在多个基准测试上取得了显著优于现有开源模型和部分商业模型的成绩。具体结果如下:

- 通用网页搜索基准:在BrowseComp-en上达到39.9%,在BrowseComp-zh上达到43.3%,在GAIA上达到72.8%,在Xbench-DeepSearch上达到73.0%,在WebWalkerQA上达到71.9%。这些结果表明AgentFounder在跨语言和多模态信息检索方面具有显著优势。

- 场景定向网页搜索基准:在HLE上达到31.5%,在DeepResearch Bench上RACE Overall得分达到47.9%,在Frames上表现优异,在SEAL-0上展现出强鲁棒性,在Academic Browse上达到75.3%。这些结果验证了AgentFounder在处理复杂任务和高度专业化场景时的有效性。

训练策略有效性:

- 两阶段训练策略:相比单阶段训练,两阶段训练在Pass@1和Pass@3指标上分别提升了3.3%和3.7%,证明了其有效性。这表明渐进式训练策略有助于模型逐步掌握复杂的研究和推理能力。

- 数据类型贡献:FAS数据和HAS数据均对模型性能有显著贡献,FAS数据在Pass@3指标上提升尤为明显,HAS数据则提供了互补效益。这表明多样化的数据合成策略对于提升模型性能至关重要。

模型规模与数据量的影响:

- 模型规模:随着模型参数的增加,Agentic性能显著提升,AgentFounder-30B在多个基准上超过了更大规模的基线模型。这表明在资源允许的情况下,增加模型规模是提升性能的有效途径。

更多推荐

已为社区贡献36条内容

已为社区贡献36条内容

所有评论(0)