Qwen模型系列演进:从Qwen1到Qwen3-Next的技术革新之路

摘要:本文系统梳理了阿里通义千问大模型从Qwen1到Qwen3-Next的技术演进历程。Qwen1(2023)奠定了RoPE位置编码、PreRMSNorm等基础架构;Qwen1.5(2024)引入稀疏专家系统(MoE)和GQA注意力;Qwen2(2024)全面采用GQA并扩展训练数据至7T tokens;Qwen2.5(2024)实现100万tokens长文本处理;Qwen3(2025)创新性提出

Qwen模型系列演进:从Qwen1到Qwen3-Next的技术革新之路

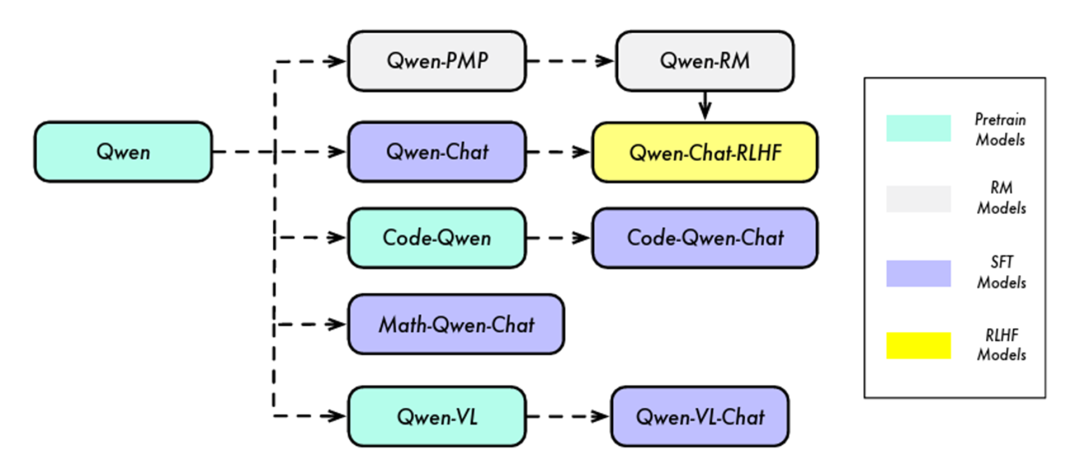

在项目中使用最多的是国内阿里通义千问大模型,我深度研究了阿里巴巴通义千问团队从2023年8月发布的Qwen1到2025年9月最新发布的Qwen3-Next的整个技术演进过程。

这个系列模型的发展历程清晰地展现了当前大语言模型技术发展的主要脉络:从基础架构优化到稀疏专家系统,从简单的指令微调到复杂的推理能力训练。本文将详细解析每个版本的核心改进点,深入探讨技术原理,为大家呈现一个完整的技术发展图景。

Qwen1:奠定基础架构(2023年8月)

模型结构设计

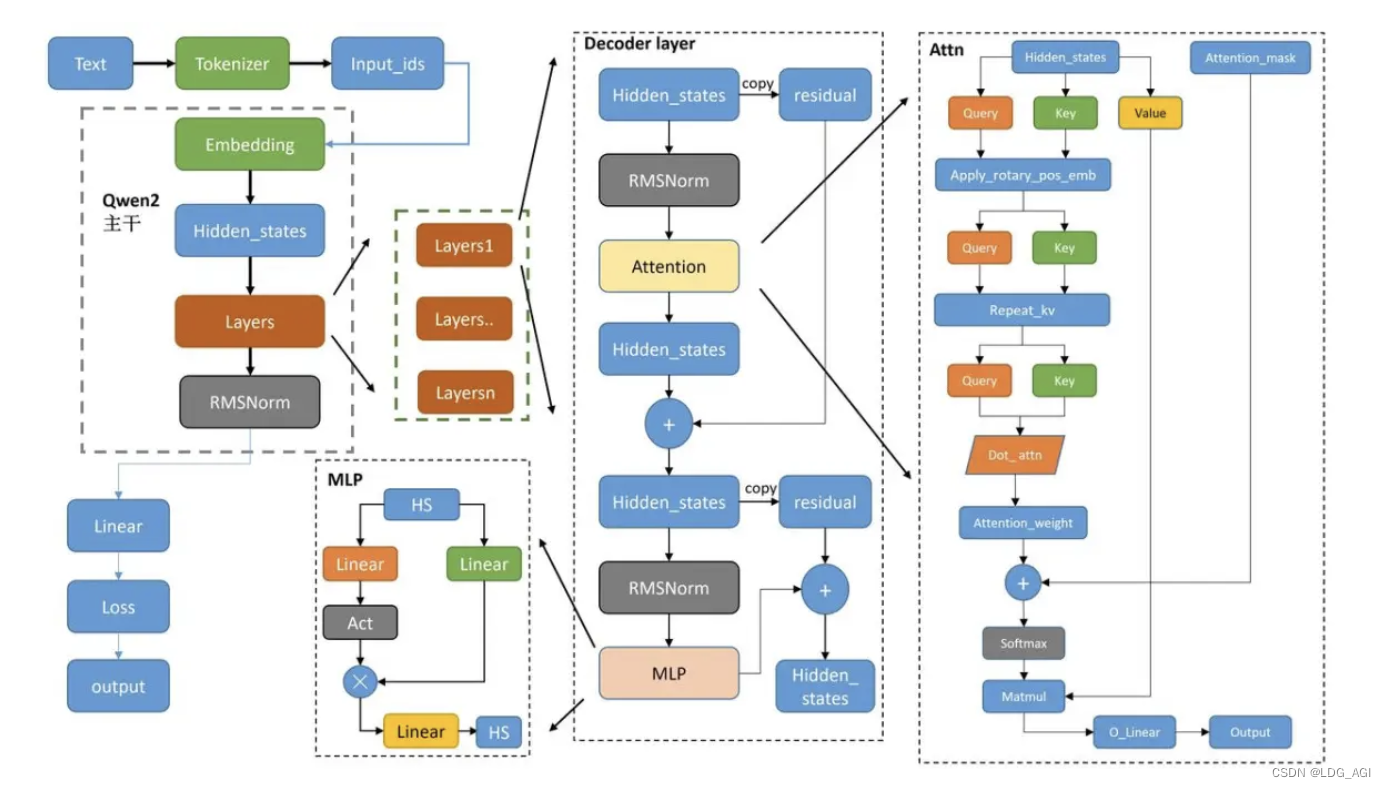

Qwen1的架构设计基于当时主流的LLaMA架构,但进行了多项关键改进。在Transformer的基础架构上,Qwen1采用了三个重要的技术组件:

RoPE位置编码机制:相比传统的绝对位置编码,RoPE(Rotary Position Embedding)通过旋转变换的方式将位置信息融入到注意力计算中。具体来说,RoPE将位置信息编码为复数形式的旋转矩阵,使得相对位置关系在任意长度的序列中都能保持一致。这种设计的数学原理基于复数的乘法运算,使得模型能够更好地理解序列中不同位置之间的相对关系。

PreRMSNorm标准化:传统的LayerNorm被替换为PreRMSNorm,这种改进将标准化操作前置到每个子层之前,而不是之后。PreRMSNorm通过移除LayerNorm中的重心化操作(减去均值),仅保留缩放操作(除以RMS),不仅减少了计算量,还提升了训练稳定性。这种设计特别适合大规模模型的训练,因为它能够有效缓解梯度爆炸和梯度消失问题。

SwiGLU激活函数:替代传统的ReLU或GELU,SwiGLU采用了门控机制的激活函数。其计算公式为SwiGLU(x) = Swish(xW + b) ⊙ (xV + c),其中⊙表示逐元素乘法。这种门控机制允许模型选择性地激活不同的神经元,提高了模型的表达能力和训练效率。

线性层bias优化:Qwen1移除了QKV线性层之外的所有bias参数。这个看似简单的改进实际上基于深度学习中的一个重要发现:在足够深的网络中,bias参数的作用相对有限,移除它们可以减少参数量,降低过拟合风险,同时加快训练速度。

训练优化策略

FlashAttention加速:Qwen1采用了FlashAttention技术来优化注意力机制的计算。传统的注意力计算需要存储完整的注意力矩阵,内存复杂度为O(N²)。FlashAttention通过分块计算和在线softmax的方式,将内存复杂度降低到O(N),使得模型能够处理更长的序列。

混合精度训练:使用AdamW优化器进行BF16混合精度训练。BF16(Brain Floating Point 16)相比FP16有更大的数值范围,避免了FP16训练中常见的数值溢出问题,特别适合大规模模型的训练。

NTK插值法扩展上下文:训练时使用2048的上下文长度,然后通过NTK(Neural Tangent Kernel)插值法将上下文长度外推到8192。这种方法的核心思想是调整RoPE中的频率基数,使得模型能够处理比训练时更长的序列,而不需要重新训练整个模型。

Qwen1.5:引入稀疏专家系统(2024年4月)

核心架构改进

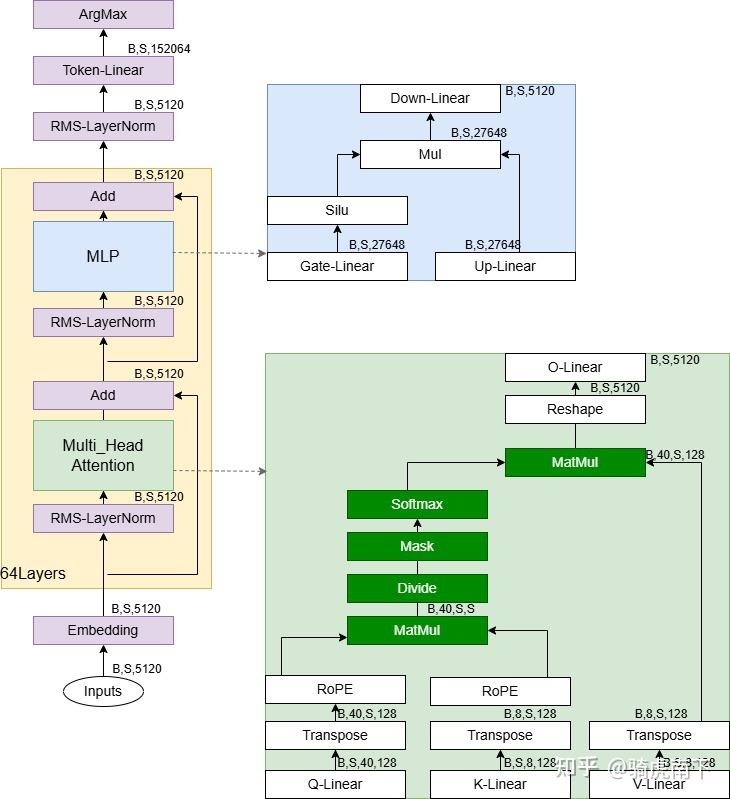

GQA注意力机制:Qwen1.5引入了分组查询注意力(Grouped Query Attention),不过只有Qwen1.5-32B使用了这一技术。GQA的核心思想是将多个查询头共享同一组键值头,从而在保持性能的同时大幅减少KV缓存的大小。

假设原始的多头注意力有h个头,GQA将这h个查询头分成g个组,每组共享一对键值头。这样,键值头的数量从h减少到g,大幅降低了推理时的内存占用。数学上,这相当于:

Q = [Q₁, Q₂, ..., Qₕ] # h个查询头

K = [K₁, K₂, ..., Kₘ] # g个键头(g < h)

V = [V₁, V₂, ..., Vₘ] # g个值头

MoE专家系统:Qwen1.5-14B-A2.7B是系列中第一个MoE模型,采用了4个共享专家加60个细粒度专家的设计。每次推理时激活4个专家网络。

MoE的基本原理是通过门控网络选择最相关的专家来处理输入:

y = Σᵢ Gᵢ(x) * Eᵢ(x)

其中Gᵢ(x)是门控函数的输出,Eᵢ(x)是第i个专家的输出。共享专家始终被激活,而门控网络根据输入选择最相关的细粒度专家。

训练方法创新

PPO与DPO联合训练:Qwen1.5在后训练阶段同时使用了PPO(Proximal Policy Optimization)和DPO(Direct Preference Optimization)。PPO通过强化学习的方式优化模型输出,而DPO直接从人类偏好数据中学习,两者结合提高了模型对齐的效果。

32K上下文支持:全系列模型都支持32K的上下文窗口,这对长文档处理能力是一个重要提升。

Qwen2:全面拥抱GQA和大规模预训练(2024年6月)

结构和Qwen1.5基本类似

全系列GQA部署:Qwen2将GQA技术扩展到全系列模型,实现了40%的KV缓存减少。这个改进的影响是革命性的:在处理长序列时,内存占用显著降低,使得模型能够在更小的硬件配置下运行。

YaRN+DCA长上下文技术:YaRN(Yet another RoPE extensioN method)是对RoPE的进一步改进,通过动态调整不同频率分量的缩放因子来更好地处理长序列。DCA(Dual Chunk Attention,双块注意力机制)则将长序列分割成多个块进行并行处理。

DCA的核心思想是:

- 将输入序列分成多个重叠的块

- 每个块内进行全注意力计算

- 块间通过特殊的跨块注意力机制进行信息交互

这种设计既保持了全注意力的表达能力,又通过并行计算提高了效率。

训练数据的大规模扩展

预训练数据规模提升:从3T tokens扩展到7T tokens,数据规模的提升带来了更好的世界知识和语言理解能力。更重要的是,Qwen2引入了高质量的代码、数学和多语言数据,这种数据组成的优化对模型能力的提升起到了关键作用。

精细化SFT流程:构建了超过50万条标注的指令数据集,覆盖指令跟随、编码、数学、逻辑推理、角色扮演和多语言等多个领域。训练过程分为两个时期,逐步降低学习率,这种渐进式的微调策略确保了模型在不同任务上的均衡表现。

两阶段RLHF优化:

- 离线阶段:利用预编译的偏好数据集,使用DPO进行训练

- 在线阶段:模型与奖励模型实时交互,选择最受欢迎和最不受欢迎的响应,形成新的偏好对用于DPO训练

这种在线学习机制使得模型能够持续从新的交互中学习和改进。

Qwen2.5:长上下文和推理能力的突破(2024年9月)

模型规模的系统化布局

Qwen2.5提供了从0.5B到72B的7种不同尺寸,这种系统化的模型规模设计满足了不同应用场景的需求。小模型适合边缘部署,大模型适合复杂推理任务。

训练数据的进一步扩展

预训练规模跃升:数据规模从7T tokens进一步扩展到18T tokens,其中特别强化了代码和数学数据集的比例。这种数据组成的调整直接针对模型的推理能力进行优化。

长文本处理能力:SFT阶段构建了专门的长文本数据集,将模型的输出长度从2K扩展到8K。这不仅仅是数量上的提升,更重要的是模型学会了如何在长篇输出中保持逻辑一致性和内容连贯性。

强化学习的双重策略

离线RL(DPO):使用约15万对高质量正负样本对进行DPO训练。这些样本对经过精心筛选,确保了训练数据的质量。

在线RL(GRPO):采用GRPO(Generalized Reward-based Policy Optimization)方法,基于奖励模型优化输出的真实性、帮助性和简洁性等人类偏好指标。GRPO相比传统的PPO有更好的稳定性和收敛性。

超长上下文适配:通过YaRN+DCA技术实现了100万tokens的超长文本处理能力,这在当时是业界领先的水平。

Qwen3:推理模式的革命性创新(2025年4月)

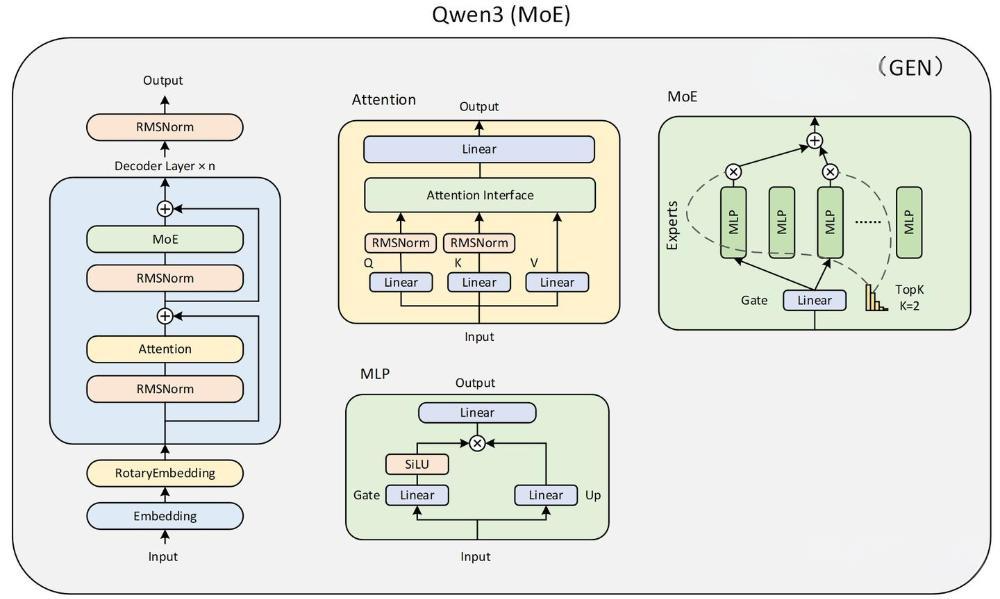

架构创新的新高度

QK-RMSNorm技术:在Dense模型中引入QK-RMSNorm,这是对注意力机制的进一步优化。传统的注意力计算中,查询(Q)和键(K)的向量可能存在幅度差异,QK-RMSNorm分别对Q和K进行标准化,确保注意力权重的计算更加稳定。

MoE架构的重新设计:Qwen3-MoE取消了共享专家,采用更细粒度的分割专家设计,并引入全局批量负载平衡损失。这种设计的优势在于:

- 每个专家都能根据输入进行选择,增加了模型的灵活性

- 全局负载平衡确保各个专家的使用率相对均衡,避免某些专家过度使用而其他专家被忽略

动态思考机制:这是Qwen3最重要的创新。单个模型可以动态调节思考/非思考模式,根据任务复杂度选择合适的推理方式。

思考模式的工作原理:

- 简单任务:直接输出答案(非思考模式)

- 复杂任务:先进行内部推理(思考模式),再输出最终答案

- 模型通过特殊的prompt标识来切换模式

超大规模模型的探索

Qwen3-235B-A22B:总参数235B,激活参数22B的超大规模MoE模型

Qwen3-Coder-480B-A35B:专门针对代码任务优化的480B参数模型

这些大模型的训练需要解决数据并行、模型并行、流水线并行等多种并行策略的协调问题。

训练流程的复杂化

预训练数据翻倍:从18T tokens扩展到36T tokens,这种规模的数据需要强大的数据处理和存储基础设施支持。

多阶段后训练流程:

- CoT冷启动微调:使用思维链数据进行初始微调

- GRPO强化推理:对query-verifier数据集进行强化学习

- 思考能力学习:使用无推理路径的数据学习动态切换能力

- 场景化强化学习:针对特定应用场景进行最终优化

数据蒸馏技术:使用KL散度将小模型与大模型对齐,这种知识蒸馏技术使得小模型也能获得大模型的部分能力。

Qwen3-2507:架构分离和专业化(2025年7月)

模型架构的专业化分离

思考/非思考模型分离:不再使用单一模型进行模式切换,而是训练专门的思考模型和非思考模型。这种分离设计的优势:

- 每个模型可以针对特定任务进行深度优化

- 避免了模式切换可能带来的性能损失

- 简化了推理逻辑

256K超长上下文:支持更长的上下文窗口,这对处理长文档、代码仓库等任务至关重要。

垂直领域的专业化

Qwen3-Coder编程模型:专门针对代码生成、理解、调试等编程任务优化

Qwen-MT翻译模型:专门用于多语言翻译任务

这种垂直化的专业模型趋势反映了大模型应用的成熟化发展。

Qwen3-Next:混合架构的终极优化(2025年9月)

革命性的混合架构设计

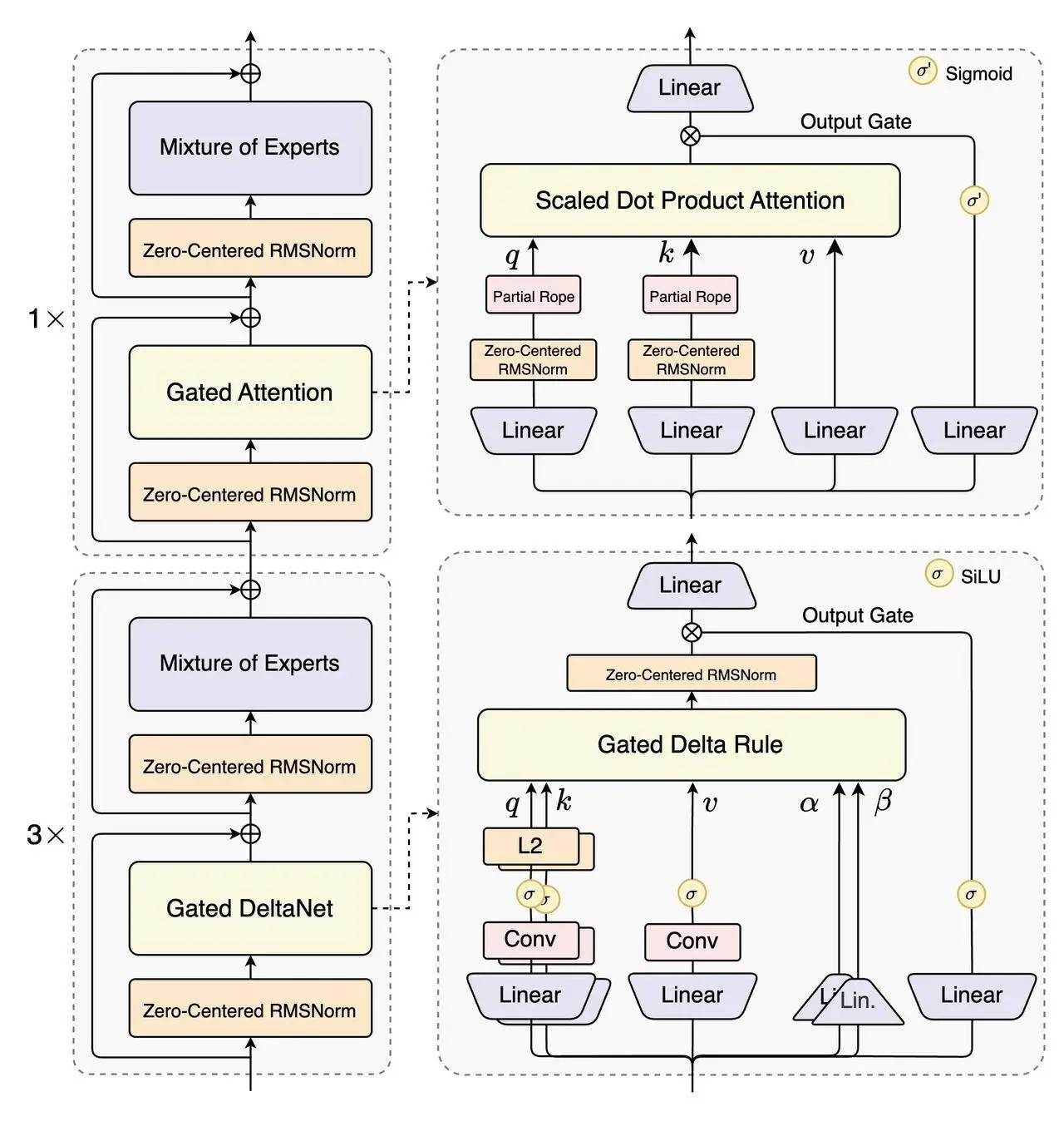

Qwen3-Next采用了全球首创的Gated DeltaNet和Gated Attention混合架构,实现了更快的处理速度、更强的效果和更省的资源消耗。这个架构的核心创新包括:

Gated DeltaNet机制:这是一种全新的序列建模方法,结合了循环神经网络的记忆能力和Transformer的并行计算优势。DeltaNet通过状态空间模型(State Space Model)的方式处理序列信息,而门控机制则控制信息的流动。

Gated Attention混合设计:传统的注意力机制与门控线性单元相结合,通过门控机制选择性地关注重要信息。这种设计在保持注意力机制表达能力的同时,显著提高了计算效率。

超稀疏MoE的极致优化

Qwen3-Next将稀疏性推向极致,MoE层的激活比例达到1:50,在80B-A3B旗舰模型中,每个token只激活3B参数,仅占总参数的3.7%。

这种超稀疏设计的技术细节:

- 512个总专家:10个路由专家 + 1个共享专家

- Zero-Centered RMSNorm:增强训练稳定性

- 改进的MoE路由器初始化:确保专家选择的均衡性

多Token预测机制(MTP)

Qwen3-Next引入MTP(Multiple-Token Prediction)机制,通过并行生成多个tokens,再进行后验证,实现显著的速度提升,达到SOTA闭源模型的100+ tokens/秒。

MTP的工作原理:

- 并行生成:模型同时预测多个可能的下一个token

- 概率评估:对每个候选token计算概率分布

- 后验证:通过验证机制选择最优的token序列

- 流式输出:将验证后的tokens流式输出给用户

训练效率的revolutionary提升

相比之前的模型,Qwen3-Next实现了约10倍的训练成本降低和10倍的推理速度提升,仅需要Qwen3-32B 9.3%的计算成本。

这种效率提升来自多个方面:

- 稀疏激活:大幅减少了实际参与计算的参数数量

- 混合架构:DeltaNet的线性复杂度降低了长序列处理成本

- 优化的专家调度:智能的负载均衡减少了通信开销

- 内存优化:高效的KV缓存管理

长上下文能力的再突破

Qwen3-Next支持256K到1M tokens的超长上下文处理能力,这种长上下文能力的实现依赖于:

- 混合注意力机制:结合了全注意力和稀疏注意力的优势

- 分层处理策略:不同层使用不同的上下文长度处理策略

- 动态内存管理:根据序列长度动态调整内存分配

性能基准的新高度

据报告,Qwen3-Next的性能超越了Gemini-2.5-Flash-Thinking,接近更高级别的闭源模型。这种性能提升体现在:

- 推理速度:100+ tokens/秒的生成速度

- 计算效率:仅激活3.7%的参数实现卓越性能

- 长上下文处理:在百万token级别的文档中保持高质量输出

- 多模态能力:支持文本、代码等多种模态的处理

技术发展总结与展望

演进脉络分析

回顾Qwen系列的发展历程,可以清晰地看到三个主要的技术演进方向:

架构优化路径:从基础的Transformer改进(Qwen1)到引入GQA(Qwen1.5/2),再到MoE的深度优化(Qwen2.5/3),最终发展为革命性的混合架构(Qwen3-Next)。

训练方法演进:从简单的监督学习到复杂的多阶段RLHF,再到思考能力的培养,训练方法越来越精细化和专业化。

应用能力拓展:从基础的文本生成到长上下文处理,从单一模态到多模态,从通用能力到垂直领域专业化。

关键技术突破

稀疏计算的极致优化:从最初的密集计算到MoE的稀疏激活,再到Qwen3-Next的超稀疏设计,实现了计算效率的数量级提升。

长上下文处理的革新:从2K到百万级别的上下文处理能力,背后是多种技术的综合创新:位置编码优化、注意力机制改进、内存管理优化等。

推理能力的系统性提升:从简单的指令跟随到复杂的思维链推理,模型的认知能力实现了质的飞跃。

未来发展趋势

基于Qwen系列的发展轨迹,可以预测未来大语言模型的几个发展方向:

更高效的稀疏架构:稀疏性将进一步提升,可能出现激活率更低但性能更强的模型架构。

多模态融合的深化:文本、图像、音频、视频等多种模态的深度融合将成为标配。

专业化模型生态:针对不同垂直领域的专业化模型将形成完整的生态系统。

推理能力的进一步提升:模型的逻辑推理、数学推理、科学推理能力将持续增强。

Qwen系列的发展历程为我们展现了大语言模型技术快速发展的精彩画卷。从基础架构的优化到革命性混合架构的创新,从简单的文本生成到复杂的推理能力,这个系列模型的每一次迭代都代表着技术边界的推进。作为大模型算法工程师,我们不仅要掌握这些技术的原理和实现,更要理解它们背后的设计思想和发展逻辑,这样才能在快速变化的技术浪潮中保持前瞻性和竞争力。

Qwen3-Next的发布标志着大语言模型进入了一个新的发展阶段:超稀疏架构与混合计算的结合将成为下一代模型的主流方向。这种技术路线不仅解决了计算资源和推理效率的矛盾,也为模型规模的进一步扩展提供了可能。相信在不久的将来,我们将看到更多基于这种架构思想的创新模型涌现,推动整个人工智能领域向更高的水平发展。

更多推荐

已为社区贡献52条内容

已为社区贡献52条内容

所有评论(0)