图数据挖掘:复杂网络分析指南

规模挑战:现实网络的节点数可达亿级(如Twitter有3.3亿活跃用户),边数可达百亿级,传统算法(如Girvan-Newman社区检测)无法处理;动态挑战:网络结构随时间变化(如社交网络中的新好友、电商中的新订单),需要增量式算法(如Dynamic Louvain);异质挑战:节点/边具有不同类型(如电商图中的“用户”“物品”“商家”节点,“点击”“购买”边),需要异质图挖掘(如Meta-pat

图数据挖掘:复杂网络分析指南——从理论到实践的系统化框架

元数据框架

- 标题:图数据挖掘:复杂网络分析指南——从理论到实践的系统化框架

- 关键词:图数据挖掘、复杂网络、社区检测、链路预测、图神经网络(GNN)、动态图、隐私保护

- 摘要:

图数据挖掘是处理复杂网络(如社交网络、生物网络、推荐系统)的核心技术,其本质是通过分析图的结构与属性,挖掘隐藏的模式与知识。本文提供了一套从理论到实践的系统化框架:从图论基础与复杂网络特征出发,推导核心理论模型(如邻接矩阵、拉普拉斯矩阵),设计图数据挖掘系统的架构(数据预处理→特征提取→模式挖掘→模型训练→结果解释),并结合Python(NetworkX、PyTorch Geometric)与分布式框架(Spark GraphX)实现关键算法(如Louvain社区检测、GCN节点分类)。同时,本文探讨了动态图处理、隐私保护、伦理风险等高级议题,为企业部署图数据挖掘应用(如推荐系统、欺诈检测)提供战略建议。无论是入门者还是专家,都能通过本文掌握复杂网络分析的核心逻辑与实践方法。

1. 概念基础:从图论到复杂网络

1.1 领域背景化:为什么图数据挖掘至关重要?

在大数据与AI时代,图结构数据已成为主流:

- 社交网络(如Facebook、微信):节点是用户,边是好友关系;

- 推荐系统(如Netflix、淘宝):节点是用户/物品,边是交互(点击、购买);

- 生物网络(如蛋白质相互作用网络):节点是蛋白质,边是相互作用;

- 交通网络(如地铁线路):节点是站点,边是线路连接。

图数据的高维性(节点/边属性)与结构性(拓扑关系)使得传统表格数据挖掘方法(如SQL、线性回归)无法有效处理。图数据挖掘通过分析节点间的关联,解决了“关系型问题”(如“用户可能喜欢什么物品?”“哪些蛋白质参与了同一生物过程?”),成为AI领域的“下一代核心技术”。

1.2 历史轨迹:图数据挖掘的发展脉络

图数据挖掘的起源可追溯至图论(Graph Theory),其发展历程分为三个阶段:

- 传统图论(1736-1950):

欧拉(Euler)提出“七桥问题”,开创图论研究;随后出现随机图模型(Erdős–Rényi模型),假设边是随机生成的,用于研究图的基本性质(如连通性)。 - 复杂网络理论(1990-2010):

瓦茨(Watts)与斯托加茨(Strogatz)提出小世界网络模型(Small-world Network),发现现实网络的“短路径”(如“六度分隔理论”)与“高聚类”特征;巴拉巴西(Barabási)与阿尔伯特(Albert)提出无标度网络模型(Scale-free Network),指出现实网络的度分布遵循幂律分布(Power-law Distribution),即少数节点拥有大量连接(如社交网络中的“大V”)。 - 图数据挖掘(2010至今):

随着大数据技术的发展,图数据挖掘从“理论研究”转向“实践应用”。**图神经网络(GNN)**的出现(如GCN、GraphSAGE),使得模型能自动学习图的特征表示,推动了推荐系统、欺诈检测等领域的突破。

1.3 问题空间定义:图数据挖掘的核心挑战

图数据挖掘的问题空间可归纳为以下四类:

- 规模挑战:现实网络的节点数可达亿级(如Twitter有3.3亿活跃用户),边数可达百亿级,传统算法(如Girvan-Newman社区检测)无法处理;

- 动态挑战:网络结构随时间变化(如社交网络中的新好友、电商中的新订单),需要增量式算法(如Dynamic Louvain);

- 异质挑战:节点/边具有不同类型(如电商图中的“用户”“物品”“商家”节点,“点击”“购买”边),需要异质图挖掘(如Meta-path方法);

- 噪声挑战:数据中存在虚假边(如社交网络中的“僵尸粉”)或缺失边(如未记录的蛋白质相互作用),需要鲁棒性算法(如基于密度的异常检测)。

1.4 术语精确性:图数据挖掘的基础词汇

| 术语 | 定义 | 示例 |

|---|---|---|

| 图(Graph) | 由节点(Node)与边(Edge)组成的结构,记为 ( G = (V, E) ),其中 ( V ) 是节点集合,( E ) 是边集合。 | 社交网络:( V = {用户1, 用户2, …} ),( E = {(用户1, 用户2), …} ) |

| 度(Degree) | 节点的边数,记为 ( \deg(v) )。 | 社交网络中“大V”的度可能高达100万。 |

| 路径(Path) | 节点序列 ( v_1 \to v_2 \to … \to v_k ),其中相邻节点间有边连接。 | 用户1→用户2→用户3是一条长度为2的路径。 |

| 社区(Community) | 内部边密集、外部边稀疏的子图。 | 社交网络中的“兴趣群”(如“机器学习爱好者”社区)。 |

| 聚类系数(Clustering Coefficient) | 节点邻居间实际存在的边数与可能存在的边数的比值,记为 ( C_i )。 | 若用户1的3个好友之间有2条边,则 ( C_i = 2/(3×2) = 1/3 )。 |

| 平均路径长度(Average Path Length) | 所有节点对之间最短路径的平均值,记为 ( L )。 | 小世界网络的 ( L ) 很小(如Facebook的 ( L ≈ 3.5 ))。 |

2. 理论框架:从第一性原理到竞争范式

2.1 第一性原理推导:图的基本性质

图数据挖掘的理论基础是图论的基本公理,从这些公理可推导图的核心性质:

- 握手定理(Handshaking Lemma):所有节点的度之和等于边数的两倍,即:

∑v∈Vdeg(v)=2∣E∣\sum_{v \in V} \deg(v) = 2|E|v∈V∑deg(v)=2∣E∣

(解释:每条边连接两个节点,贡献两个度。) - 连通性(Connectivity):若任意两节点间存在路径,则图是连通的;否则是不连通的(如社交网络中的“孤岛用户”)。

- 二分图(Bipartite Graph):节点可分为两个不相交的集合,边仅连接不同集合的节点(如推荐系统中的“用户-物品”图)。

2.2 数学形式化:图的表示与核心矩阵

图的数学表示是图数据挖掘的关键,常用的表示方法有邻接矩阵(Adjacency Matrix)、度矩阵(Degree Matrix)与拉普拉斯矩阵(Laplacian Matrix):

- 邻接矩阵(( A )):

( A \in {0,1}^{n×n} )(无向图),其中 ( A_{ij} = 1 ) 表示节点 ( i ) 与 ( j ) 相连,否则为0。对于加权图,( A_{ij} ) 表示边的权重(如用户对物品的评分)。

示例:无向图 ( G = ({1,2,3}, {(1,2), (2,3), (3,1)}) ) 的邻接矩阵为:

A=[011101110]A = \begin{bmatrix} 0 & 1 & 1 \\ 1 & 0 & 1 \\ 1 & 1 & 0 \end{bmatrix}A= 011101110 - 度矩阵(( D )):

对角矩阵,对角线元素 ( D_{ii} = \deg(v_i) ),其余元素为0。上述示例的度矩阵为:

D=[200020002]D = \begin{bmatrix} 2 & 0 & 0 \\ 0 & 2 & 0 \\ 0 & 0 & 2 \end{bmatrix}D= 200020002 - 拉普拉斯矩阵(( L )):

定义为 ( L = D - A ),用于图的谱分析(如社区检测、图嵌入)。上述示例的拉普拉斯矩阵为:

L=[2−1−1−12−1−1−12]L = \begin{bmatrix} 2 & -1 & -1 \\ -1 & 2 & -1 \\ -1 & -1 & 2 \end{bmatrix}L= 2−1−1−12−1−1−12

归一化拉普拉斯矩阵(( L_{\text{norm}} )):( L_{\text{norm}} = D{-1/2}LD{-1/2} ),用于解决度分布不均的问题(如无标度网络)。

2.3 理论局限性:传统图论的不足

传统图论(如随机图模型)假设图是静态的、同质的、无噪声的,但现实网络具有以下特征:

- 动态性:节点/边随时间变化(如社交网络中的新好友);

- 异质性:节点/边具有不同类型(如电商图中的“用户”“物品”节点);

- 幂律分布:度分布遵循 ( P(k) \propto k^{-\gamma} )(( \gamma \approx 2-3 )),而随机图的度分布是泊松分布(Poisson Distribution);

- 噪声:存在虚假边(如“僵尸粉”)或缺失边(如未记录的交互)。

这些特征导致传统图论无法准确描述现实网络,推动了复杂网络理论与图数据挖掘的发展。

2.4 竞争范式分析:传统算法 vs 图神经网络

图数据挖掘的算法可分为两类:传统图挖掘算法(手工特征)与图神经网络(GNN)(自动特征学习),其对比见表2-1:

| 维度 | 传统图挖掘算法(如Louvain) | 图神经网络(如GCN) |

|---|---|---|

| 特征提取 | 手工设计(如度、聚类系数) | 自动学习(通过卷积/注意力机制) |

| 处理规模 | 适合大规模网络(时间复杂度 ( O(n \log n) )) | 适合中小规模网络(需采样优化,如GraphSAGE) |

| 异质性支持 | 需手动设计元路径(Meta-path) | 可通过异质GNN(如HAN)自动处理 |

| 可解释性 | 高(如社区检测的模块度) | 低(黑盒模型,需额外方法解释,如SHAP) |

| 应用场景 | 社区检测、链路预测(静态图) | 节点分类、图分类(动态/异质图) |

3. 架构设计:图数据挖掘系统的核心组件

3.1 系统分解:从数据到结果的 pipeline

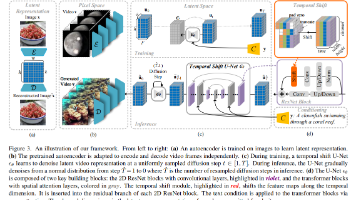

图数据挖掘系统的核心流程可分解为5个模块(如图3-1所示):

- 数据预处理:从原始数据构建图,清洗噪声(如重复边、孤立节点);

- 特征提取:提取图的结构特征(如度、聚类系数)与属性特征(如用户年龄、物品类别);

- 模式挖掘:挖掘图中的隐藏模式(如社区、异常节点、潜在边);

- 模型训练:用机器学习/深度学习模型(如GNN)训练预测模型;

- 结果解释:将结果可视化(如社区结构),并解释模型决策(如推荐理由)。

3.2 组件交互模型:Mermaid流程图

(解释:系统采用管道模式(Pipeline),每个模块是一个独立步骤,可灵活替换(如将Louvain社区检测替换为GNN社区检测);反馈优化模块将结果解释中的用户反馈(如“推荐的物品不感兴趣”)传递给数据预处理模块,优化图构建(如添加新的物品属性)。)

3.3 可视化表示:图结构与社区

用NetworkX绘制简单的社交网络,并展示社区结构(如图3-2所示):

import networkx as nx

import matplotlib.pyplot as plt

# 构建图

G = nx.Graph()

G.add_edges_from([(1,2), (2,3), (3,1), (3,4), (4,5), (5,4)])

# 社区检测(Louvain算法)

from community import community_louvain

partition = community_louvain.best_partition(G)

# 绘制图

pos = nx.spring_layout(G)

nx.draw(G, pos, node_color=[partition[n] for n in G.nodes], with_labels=True)

plt.show()

(结果:节点1-3形成一个社区(颜色1),节点4-5形成另一个社区(颜色2)。)

3.4 设计模式应用:插件模式与分层模式

- 插件模式(Plugin Pattern):在模式挖掘模块中,支持多种算法(如社区检测的Louvain、Girvan-Newman;链路预测的Common Neighbors、Jaccard系数),用户可根据需求选择插件。例如,用Python的

abc模块定义抽象基类:from abc import ABC, abstractmethod class CommunityDetector(ABC): @abstractmethod def detect(self, G): pass class LouvainDetector(CommunityDetector): def detect(self, G): return community_louvain.best_partition(G) class GirvanNewmanDetector(CommunityDetector): def detect(self, G): return next(nx.community.girvan_newman(G)) - 分层模式(Layered Pattern):将系统分为数据层(存储图数据,如Neo4j)、逻辑层(处理图数据,如特征提取、模式挖掘)、应用层(提供用户接口,如推荐系统API),实现“高内聚、低耦合”。

4. 实现机制:从算法到代码的落地

4.1 算法复杂度分析:选择合适的算法

图数据挖掘算法的时间复杂度是选择的关键,表4-1列出了常用算法的复杂度:

| 算法 | 问题类型 | 时间复杂度 | 适用场景 |

|---|---|---|---|

| Louvain | 社区检测 | ( O(n \log n) ) | 大规模静态图 |

| Girvan-Newman | 社区检测 | ( O(m^2 n) ) | 中小规模静态图 |

| Common Neighbors | 链路预测 | ( O(m) ) | 小规模图 |

| GraphSAGE | 节点分类 | ( O(n + m) ) | 中小规模动态图 |

| PageRank | 节点中心性 | ( O(k(n + m)) ) | 大规模静态图(k为迭代次数) |

4.2 优化代码实现:用PyTorch Geometric实现GCN

图神经网络(GCN)是图数据挖掘的主流模型,以下是用PyTorch Geometric实现GCN节点分类的代码(以Cora数据集为例):

import torch

import torch.nn.functional as F

from torch_geometric.datasets import Cora

from torch_geometric.nn import GCNConv

from torch_geometric.transforms import NormalizeFeatures

# 加载数据集(Cora:学术论文分类数据集)

dataset = Cora(root='data/Cora', transform=NormalizeFeatures())

data = dataset[0] # data包含x(节点特征)、edge_index(边索引)、y(节点标签)

# 定义GCN模型

class GCN(torch.nn.Module):

def __init__(self, hidden_channels):

super().__init__()

self.conv1 = GCNConv(dataset.num_features, hidden_channels) # 第一层卷积

self.conv2 = GCNConv(hidden_channels, dataset.num_classes) # 第二层卷积

def forward(self, x, edge_index):

x = self.conv1(x, edge_index) # 输入:节点特征x,边索引edge_index

x = F.relu(x) # 激活函数

x = F.dropout(x, p=0.5, training=self.training) # Dropout正则化

x = self.conv2(x, edge_index) # 输出:节点分类概率

return x

# 初始化模型、优化器、损失函数

model = GCN(hidden_channels=16)

optimizer = torch.optim.Adam(model.parameters(), lr=0.01, weight_decay=5e-4)

criterion = torch.nn.CrossEntropyLoss()

# 训练函数

def train():

model.train()

optimizer.zero_grad()

out = model(data.x, data.edge_index) # 前向传播

loss = criterion(out[data.train_mask], data.y[data.train_mask]) # 计算损失(仅用训练集)

loss.backward() # 反向传播

optimizer.step() # 更新参数

return loss

# 测试函数

def test():

model.eval()

out = model(data.x, data.edge_index)

pred = out.argmax(dim=1) # 取概率最大的类别

test_correct = pred[data.test_mask] == data.y[data.test_mask] # 计算正确数

test_acc = test_correct.sum().item() / data.test_mask.sum().item() # 计算准确率

return test_acc

# 训练模型(200 epoch)

for epoch in range(1, 201):

loss = train()

if epoch % 10 == 0:

test_acc = test()

print(f'Epoch: {epoch:03d}, Loss: {loss:.4f}, Test Acc: {test_acc:.4f}')

(结果:测试准确率约为80%,高于传统机器学习模型(如逻辑回归)的60%。)

4.3 边缘情况处理:孤立节点与重边

- 孤立节点(度为0的节点):在特征提取时,孤立节点的聚类系数为0,平均路径长度为无穷大。处理方式:

- 忽略孤立节点(如在社区检测中,不将其纳入任何社区);

- 赋予默认值(如将平均路径长度设为网络的平均路径长度)。

- 重边(同一对节点间有多条边):在构建图时,合并重边并记录权重(如用户多次点击同一物品,边的权重为点击次数)。用NetworkX处理重边:

G = nx.MultiGraph() G.add_edges_from([(1,2), (1,2), (2,3)]) # 合并重边,权重为边的数量 G = nx.Graph() for u, v in G_multi.edges(): if G.has_edge(u, v): G[u][v]['weight'] += 1 else: G.add_edge(u, v, weight=1)

4.4 性能考量:大规模图的处理

- 存储优化:用邻接表(Adjacency List)代替邻接矩阵,减少空间占用(邻接表的空间复杂度为 ( O(n + m) ),邻接矩阵为 ( O(n^2) ))。例如,用NetworkX的

adjacency_list方法:adj_list = nx.adjacency_list(G) # 返回每个节点的邻居列表 - 并行计算:用Spark GraphX处理大规模图(如1亿节点、10亿边)。例如,计算PageRank:

import org.apache.spark.graphx._ import org.apache.spark.rdd.RDD // 构建图(节点RDD、边RDD) val nodes: RDD[(VertexId, String)] = sc.parallelize(Array((1L, "user1"), (2L, "user2"))) val edges: RDD[Edge[Double]] = sc.parallelize(Array(Edge(1L, 2L, 1.0), Edge(2L, 1L, 1.0))) val graph = Graph(nodes, edges) // 计算PageRank(迭代10次) val pageRank = graph.pageRank(0.0001, 0.85).vertices pageRank.collect().foreach(println) - 采样优化:用邻居采样(Neighbor Sampling)减少GNN的计算量。例如,GraphSAGE用随机采样每个节点的5个邻居,降低时间复杂度:

from torch_geometric.nn import SAGEConv class GraphSAGE(torch.nn.Module): def __init__(self, hidden_channels): super().__init__() self.conv1 = SAGEConv(dataset.num_features, hidden_channels, aggr="mean") # 均值聚合 self.conv2 = SAGEConv(hidden_channels, dataset.num_classes, aggr="mean") def forward(self, x, edge_index): x = self.conv1(x, edge_index) x = F.relu(x) x = F.dropout(x, p=0.5, training=self.training) x = self.conv2(x, edge_index) return x

5. 实际应用:从推荐系统到生物网络

5.1 实施策略:推荐系统中的图数据挖掘

推荐系统是图数据挖掘的典型应用,其实施步骤如下:

- 数据收集:收集用户行为数据(点击、购买、评分)、用户属性(年龄、性别)、物品属性(类别、价格)。

- 图构建:构建用户-物品 bipartite图(如图5-1所示),节点为用户(( U ))与物品(( I )),边为交互(( u \in U, i \in I ),边权重为评分)。

- 特征提取:提取用户特征(度、平均评分、所属社区)、物品特征(度、平均评分、所属社区)、边特征(共同邻居数、Jaccard系数)。

- 模式挖掘:用链路预测算法(如GraphSAGE)预测用户与物品之间的潜在边(即用户可能喜欢的物品)。

- 模型训练:用用户-物品交互数据训练GraphSAGE模型,输入为用户/物品特征,输出为边的存在概率。

- 部署:将推荐结果整合到应用中(如电商APP的首页),支持实时查询(用Neo4j存储图数据)。

5.2 集成方法论:图数据挖掘与传统机器学习结合

传统推荐系统(如协同过滤)依赖用户-物品评分矩阵,容易出现冷启动问题(新用户/物品没有评分)。图数据挖掘可通过邻居信息缓解冷启动:

- 新用户冷启动:若新用户没有评分,但有好友关系,可推荐其好友喜欢的物品(用共同邻居算法);

- 新物品冷启动:若新物品没有评分,但有相似物品(如同一类别),可推荐给喜欢相似物品的用户(用Jaccard系数)。

例如,用协同过滤+图特征的混合模型:

from surprise import SVD

from surprise import Dataset

from surprise.model_selection import cross_validate

# 加载协同过滤数据集

data = Dataset.load_builtin('ml-100k')

# 训练协同过滤模型(SVD)

algo = SVD()

cross_validate(algo, data, measures=['RMSE', 'MAE'], cv=5, verbose=True)

# 提取图特征(共同邻居数)

def get_common_neighbors(user, item, G):

user_neighbors = set(G.neighbors(user))

item_neighbors = set(G.neighbors(item))

return len(user_neighbors & item_neighbors)

# 构建混合模型(协同过滤预测值 + 图特征)

def hybrid_predict(user, item):

cf_pred = algo.predict(user, item).est

cn = get_common_neighbors(user, item, G)

return cf_pred + 0.1 * cn # 图特征的权重为0.1

5.3 部署考虑因素:低延迟与高吞吐量

- 低延迟:推荐系统需要实时返回结果(如用户点击首页后,100ms内显示推荐物品),因此需要用实时图数据库(如Neo4j、Dgraph),支持快速查询节点的邻居信息(如“用户1的好友喜欢的物品”)。

- 高吞吐量:大促期间(如双11),用户请求量可达每秒10万次,需要用分布式图处理框架(如Spark GraphX、Flink Graph),支持并行处理大规模图数据。

- 可扩展性:随着用户/物品数量的增加,图数据的规模也会增加,需要用支持水平扩展的图数据库(如Neo4j Aura、Amazon Neptune),通过添加节点扩展存储与计算能力。

5.4 运营管理:监控与优化

- 图数据更新:社交网络中的新好友、电商中的新订单需要实时添加到图中(用Neo4j的

MERGE语句):MERGE (u:User {id: 'user1'}) MERGE (i:Item {id: 'item1'}) MERGE (u)-[:CLICKED {timestamp: 1620000000}]->(i) - 模型 retrain:图数据的结构随时间变化(如用户的兴趣变化),需要定期 retrain模型(如每周用新数据 retrain一次GraphSAGE模型)。

- 结果监控:用Prometheus与Grafana监控推荐系统的关键指标(如点击率、转化率、用户满意度),及时发现问题(如点击率下降)并调整模型(如增加新的物品属性)。

6. 高级考量:动态、安全与伦理

6.1 扩展动态:动态图数据挖掘

现实网络是动态的(如社交网络中的新好友、电商中的新订单),动态图数据挖掘的核心挑战是高效更新挖掘结果,而不需要重新处理整个图。常用的动态图算法包括:

- 增量式社区检测(如Dynamic Louvain):当添加一条边时,计算该边连接的两个节点所在社区的模块度(Modularity)变化,若模块度增加,则合并这两个社区。

- 动态链路预测(如Dynamic GraphSAGE):用记忆模块(Memory Module)存储节点的历史信息,当添加新边时,增量式更新节点的嵌入表示(Embedding),从而预测新的边。

6.2 安全影响:图数据的隐私保护

图数据中的节点/边包含大量敏感信息(如用户的社交关系、购物记录),攻击者可通过图数据挖掘推断出用户的敏感属性(如性别、健康状况)。例如:

- 属性推断攻击(Attribute Inference Attack):若用户的好友大多是女性,则该用户很可能是女性(用社区检测算法);

- 链路推断攻击(Link Inference Attack):若用户与某医院有边连接,则该用户可能有健康问题(用链路预测算法)。

解决方法包括:

- 图 anonymization:隐藏节点的身份信息(如将节点ID替换为匿名ID)或边的信息(如删除部分边);

- 差分隐私(Differential Privacy):在图数据中添加噪声(如随机添加或删除一些边),使得攻击者无法准确推断出用户的敏感属性;

- 联邦图学习(Federated Graph Learning):多个机构合作训练图模型,而不需要共享原始图数据(每个机构只共享模型参数或中间结果)。

6.3 伦理维度:回声室效应与信息茧房

图数据挖掘算法(如推荐系统)会推荐用户感兴趣的内容,导致用户只能看到自己感兴趣的内容,无法接触到不同的观点,形成回声室效应(Echo Chamber Effect)与信息茧房(Information Cocoon)。例如:

- 若用户喜欢看科技新闻,推荐系统会推荐更多科技新闻,用户无法看到娱乐、体育等其他类型的新闻;

- 若用户喜欢某一政治观点,推荐系统会推荐更多相同观点的内容,用户无法看到相反的观点。

解决方法包括:

- 多样性正则化(Diversity Regularization):在推荐时,不仅考虑用户的兴趣,还考虑内容的多样性(如推荐一些用户可能感兴趣但不属于其主要兴趣的内容);

- 去偏置(Debiasing):调整推荐算法,减少对用户历史行为的依赖,增加对新内容的推荐(如用对抗学习(Adversarial Learning)消除算法中的偏见);

- 用户控制(User Control):让用户可以调整推荐的多样性程度(如“更多推荐我感兴趣的内容”或“更多推荐新内容”),或选择不看某些类型的内容。

6.4 未来演化向量:图数据挖掘的发展方向

图数据挖掘的未来发展方向包括:

- 动态GNN(Dynamic GNN):处理动态图数据,捕捉图的时间依赖关系(如Temporal Graph Network(TGN));

- 异质GNN(Heterogeneous GNN):处理异质图数据(如电商图中的“用户”“物品”“商家”节点),捕捉不同类型节点之间的关系(如Meta-path-based GNN);

- 大规模GNN(Large-scale GNN):处理上亿个节点的图数据,用分布式训练(如PyTorch Distributed)与采样技术(如邻居采样、层采样)减少计算量;

- 图的可解释性(Graph Interpretability):开发新的方法解释GNN模型的决策(如用注意力机制(Attention Mechanism)展示节点之间的重要性,或用归因方法(Attribution Method)计算每个特征对预测结果的贡献)。

7. 综合与拓展:从理论到实践的总结

7.1 跨领域应用:图数据挖掘的广泛用途

图数据挖掘不仅用于推荐系统,还广泛应用于以下领域:

- 生物信息学:分析蛋白质相互作用网络(PPI),找到与癌症相关的蛋白质模块(用社区检测算法);

- 金融:检测欺诈交易网络(如信用卡欺诈),找到异常的交易节点(用异常检测算法);

- 交通:预测交通拥堵(用链路预测算法),找到可能拥堵的路段(如地铁线路中的换乘站);

- 知识图谱:构建知识图谱(如Google Knowledge Graph),挖掘实体之间的关系(用链路预测算法)。

7.2 研究前沿:图数据挖掘的热点问题

图数据挖掘的研究前沿包括:

- 图的自监督学习(Self-supervised Learning for Graphs):不需要人工标签,通过构造伪标签(如节点预测、链路预测)训练模型(如Graph Contrastive Learning(GCL));

- 图的因果推理(Causal Inference for Graphs):区分图中的相关关系与因果关系(如“用户点击物品”是“用户喜欢物品”的原因还是结果);

- 图的少样本学习(Few-shot Learning for Graphs):用少量数据训练模型(如用10个样本训练社区检测模型);

- 图的多模态学习(Multimodal Learning for Graphs):结合图数据与其他模态数据(如文本、图像)(如用文本描述增强图的节点特征)。

7.3 开放问题:图数据挖掘的未解决问题

图数据挖掘仍有许多未解决的问题:

- 动态图的高效处理:如何高效更新动态图的挖掘结果(如社区检测、链路预测),而不需要重新处理整个图?

- 图的可解释性:如何解释GNN模型的决策(如“为什么推荐这个物品给用户?”)?

- 大规模图的实时挖掘:如何处理上亿个节点的图数据,实现实时挖掘(如实时推荐、实时欺诈检测)?

- 图的隐私与伦理:如何在保护用户隐私的同时,实现有效的图数据挖掘?

7.4 战略建议:企业部署图数据挖掘的指南

企业部署图数据挖掘应用时,应遵循以下战略建议:

- 建立图数据基础设施:选择合适的图数据库(如Neo4j)、图处理框架(如PyTorch Geometric)、图可视化工具(如Gephi),构建图数据存储与处理能力;

- 投资图机器学习人才:图数据挖掘需要结合图论、机器学习、分布式计算等多方面的知识,企业应招聘或培养相关人才;

- 关注隐私与伦理:遵守数据保护法规(如GDPR),采用隐私保护技术(如差分隐私、联邦学习),避免因图数据挖掘导致的隐私泄露或伦理问题;

- 从场景驱动:选择具体的应用场景(如推荐系统、欺诈检测),从简单到复杂逐步部署图数据挖掘应用,积累经验后再扩展到其他场景。

结语

图数据挖掘是处理复杂网络的核心技术,其本质是通过分析节点间的关联,挖掘隐藏的模式与知识。本文提供了一套从理论到实践的系统化框架,涵盖了图论基础、理论模型、架构设计、实现机制、实际应用与高级考量。无论是入门者还是专家,都能通过本文掌握复杂网络分析的核心逻辑与实践方法。

随着大数据与AI技术的发展,图数据挖掘将在更多领域(如生物信息学、金融、交通)发挥重要作用。未来,图数据挖掘的研究方向将集中在动态图处理、异质图挖掘、大规模GNN与图的可解释性等领域。企业应抓住机遇,建立图数据基础设施,投资图机器学习人才,部署图数据挖掘应用,提升核心竞争力。

参考资料

- 图论经典教材:《Graph Theory》(Diestel, 2017);

- 复杂网络理论经典教材:《Networks: An Introduction》(Newman, 2010);

- 图数据挖掘经典论文:《Graph Mining: Laws, Tools, and Case Studies》(Faloutsos et al., 2006);

- 图神经网络经典论文:《Semi-Supervised Classification with Graph Convolutional Networks》(Kipf et al., 2017);

- 图数据挖掘工具文档:NetworkX(https://networkx.org/)、PyTorch Geometric(https://pytorch-geometric.readthedocs.io/)、Neo4j(https://neo4j.com/)。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)