幻觉终结者:OpenAI 终于找到了根本原因

核心在于:让模型**敢于说“不知道”**比“瞎猜”更值钱。最近,OpenAI 正式揭开了大型语言模型(LLM)“幻觉”现象的真面目:原来问题不在于模型太“聪明”,而是它们的训练奖励机制本身,促使它们“自信满满地说错话”,却不愿诚实承认不知道。模型缺乏判断生成内容真伪的能力,特别是面对极少出现的单次事实,其错误可能率媲美其出现概率;设定规则:只有当模型置信度 > 某一阈值才作答,答错扣分,“我不知道

·

最近,OpenAI 正式揭开了大型语言模型(LLM)“幻觉”现象的真面目:原来问题不在于模型太“聪明”,而是它们的训练奖励机制本身,促使它们“自信满满地说错话”,却不愿诚实承认不知道。

- 幻觉的问题到底从哪来?

1) 预训练就埋下了隐患

模型缺乏判断生成内容真伪的能力,特别是面对极少出现的单次事实,其错误可能率媲美其出现概率;若根本找不到规律,就更容易一路“胡说”,幻觉率飙得没下限。

- 统计必然性的后果

“是否有效(Is-It-Valid)”要求系统通过有标注的正负样本学习识别是否生成了正确内容。但只有在存在清晰模式时,分类器才能发挥效力。结果,如果分类器不可靠,LLM 很可能出错 - 任意事实

那些只出现一次(singleton)的事实,很可能被模型忘记。其错误率至少与单例事实的比例一样高 - 表达能力不足

如果模型在某个主题上无法从数据中发现潜在规律,那么该主题上幻觉发生率的下界会变得没有边界(即可能非常高

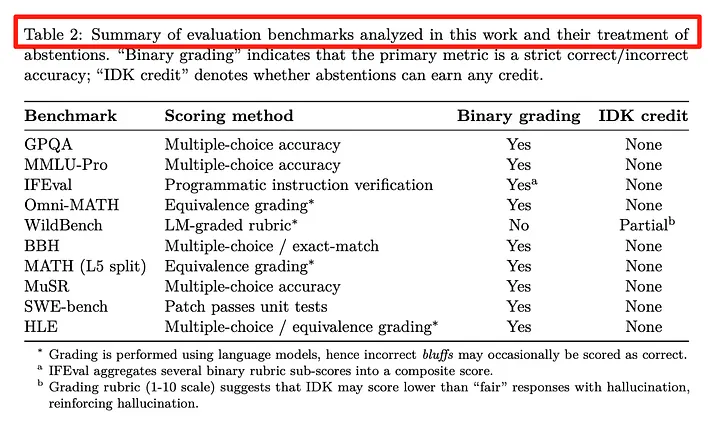

2)后训练- 考试导向的训练,反而误导了模型

传统评估机制反而惩罚说“我不知道”,让模型宁愿浮夸地答错,也不甘承认无从得知。

- 拯救“幻觉”的方法很简单:奖励“不会”的诚实

-

给模型设定置信度门槛

设定规则:只有当模型置信度 > 某一阈值才作答,答错扣分,“我不知道”则不扣分。 -

让“不会答”成为最优策略

当置信度低于阈值时,“我不知道”得分更高;这让模型学会在不确定时不瞎猜,从而减少错误输出。

- 你可能误会了的大逻辑

| 常见误解 | OpenAI 的发现 |

|---|---|

| 只要准确率提升,就能彻底免除幻觉? | 不行。某些问题本身无法回答,无法逼出 100% 准确率。 |

| 幻觉是不可抗拒的宿命? | 错!训练恰当的话,它是可避免的。 |

| 模型越大就越可靠? | 小模型反而更敢承认“我不确定”。 |

| 幻觉是某种神秘 bug? | 并非魔鬼,而是可量化的统计机制 + 不合理奖励驱动。 |

| 只要找到适合的评估指标就够了? | 即便看似“优秀”的指标,也可能因为设计原因反而惩罚谨慎行为——评估体系本身需要重构。 |

OpenAI 的这项研究标志着“幻觉”问题不再是一个让人无解的情绪化批评,而是一项可以通过系统设计修改、训练策略革新来解决的工程挑战。核心在于:让模型**敢于说“不知道”**比“瞎猜”更值钱

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)