51c大模型~合集136

作者们首先研究了数学任务中奖励噪音对语言模型的影响,因为数学任务使用简单的规则校验,根据答案的正确性进行奖励,这使得人为控制奖励噪音变得非常简单(例如,通过将基于答案正确性的奖励函数结果进行 p% 的反转,正确答案得 0 分,错误答案得 1 分),从而便于研究。因此,预训练阶段的能力提升依然至关重要。大模型的进化路径不仅遵循模型规模扩张的「Scaling Law」准则,当搭载 MemoryOS 记

我自己的原文哦~ https://blog.51cto.com/whaosoft/13970110

#6大模型决战高考数学

新一卷豆包、元宝并列第一,OpenAI o3竟惨败垫底

还在让大模型写高考作文?有本事做高考数学卷子。

又是一年高考时。

这届考生上午刚经历了抽象作文的洗礼,下午又被数学无情创飞。考试一结束,「高考数学」、「新一卷数学大题 难」等词条就火速冲上微博热搜,考生们在评论区集体「哀嚎」:「大题写到怀疑人生」、「选择填空送分,大题送命」。

而自从生成式 AI 走红后,大模型「决战」高考也成了每年的保留节目,尤其是在今年这个国内外大模型卷逻辑推理的当口。趁着各家大模型还来不及「作弊」,我们就用这新鲜出炉的高考数学题考考它们。

在考题选择上,我们采用 2025 年数学新课标 Ⅰ 卷中的 14 道客观题进行测试,满分 73 分,包括 8 道单选题、3 道多选题、3 道填空题。为保证公平公正,我们将题目截图分别投喂给大模型,不做 System Prompt 引导,不开启联网搜索,直接输出结果,且所有测试模型只有一次答题机会。

(注:在实测中我们发现 DeepSeek 的 OCR 识别出现不少错误,所以此次使用其他 AI 将图片转化为文本问题,再对 DeepSeek 进行测试。)

计分方法也依照高考判分原则:

单选题 8 道,每道 5 分,选项正确计分,错误不得分;

多选题 3 道,每道 6 分,全对计 6 分,漏选按正确答案数量计分,如答案为 ABCD,漏选其一扣 1.5 分,错选不得分;

填空题 3 道,每道 5 分,填空正确计分,错误不得分。

规则搞清楚了,接下来有请此次的参赛选手:字节的豆包、深度求索的 DeepSeek、阿里的通义、腾讯的元宝(T1)、百度的文心 X1 Turbo,以及踢馆选手 OpenAI 的 o3。

由于目前标准答案尚未公开,本次测试的参考答案是由多位数学大牛解答核对。最终各大模型的考试成绩如下图所示。

这 6 家大模型中表现最亮眼的就是豆包和元宝,它俩虽然都「栽」在了第 6 道单选题上,但仍以 68 分的总成绩并列第一;DeepSeek 和通义则稍微逊色一些,前者错了 2 道单选题拿下 63 分,后者则在 1 道单选、1 道多选上失误最终拿到 62 分;相比之下,文心 X1 频频在多选题和填空题上「掉链子」,最终只获得 51 分,正确率仅为 70%。

面对中国的高考数学题,o3 表现出明显的「水土不服」,它仅拿到 34 分,正确率只有 47%。之前就有传言称 o3 在某些情况下会触发「降智」,如此看来并非空穴来风,否则这个表现实在令人难以置信。

欲知这 6 大模型的具体答题截图,请移步链接:https://jiqizhixin.feishu.cn/docx/NNBVdmzpmobq8nxNwylcqZNDnEb

6 家顶流模型 PK 高考数学

相比于写作文,高考数学才是真正的 AI 照妖镜。

这是因为高考作文尽管对语言表达、逻辑结构、思辨能力有一定要求,但它本质上仍是一个语言生成任务,具有较强的模糊空间和容错度,而且经过这两年的技术迭代,大模型个个都练成了「段子手」,写作文自然是手拿把掐。

而高考数学则不同,它需要从已知条件出发,逻辑严密地推导每一个结论,过程中只要一步出现偏差,最终答案十有八九会出错。更何况,高考数学题还存在「题型常变」「设问刁钻」等特点,这些都进一步挑战了模型的泛化能力和思维深度。

接下来,我们就看看这六款大模型面对不同题目类型的表现。

单选题

高考数学包含 8 道单选题,满分 40 分。

从跑分情况来看,豆包、通义、元宝和文心打成平手,均斩获 35 分不错的成绩;其次就是 DeepSeek 错了两道单选拿下 30 分,表现最拉胯的竟是 o3,光单选题就错了一半。

作为曾经的推理模型「扛把子」,o3 在「送分」的第 2 题上就翻了车。起初它的思路还挺清晰,但从第二步就开始「胡说八道」,最终一顿操作猛如虎,算出个选项里没有的答案。

DeepSeek 最大的 bug 则是图片识别,就以第 6 题为例。

原题中本附着一张信息图,为了省事我们索性就将题目截图直接丢给 DeepSeek,但它对眼前的图表视而不见,一个劲地抱怨「题目描述不完整,无法确定答案」,甚至末了还开始蒙答案糊弄人。

[ 上下滑动查看更多 ]

其实,这道题通过数形结合就能直观看出,其准确答案应为 2√2。通义作为国产 AI 中唯一答对第 6 题的选手,计算方法竟是错误的,只不过是歪打正着落在正确选项的区间。

多选题

多选题曾让无数考生头疼,因为它的正确选项不固定,多答或少答都会扣分,再加上题目里总设些陷阱,一不小心就会失误。

高考数学多选题有 3 道,总共 18 分。豆包、DeepSeek 和元宝三道题全部满分,发挥相当稳定。

相比于 DeepSeek 动辄几百秒的思考时间,通义主打一个速度,仅用时 26 秒就直出答案,但步骤分析过于简略,缺乏必要的验证环节,这就很容易失手。比如它在前两题上答得都很漂亮,却在下图这道题上突然智商「掉线」。该题正确答案是 ABC,通义却给出了 A、D,至于为何不选 B、C,它的解释非常简单粗暴,因为「无法通过现有条件直接推导」。

文心 X1 就有点尴尬了。三道题目错了俩,其中一道还是未响应。它和 DeepSeek 犯了同样的毛病,都是经常性地识别不了图片内容。

o3 好像还没适应国内高考的「多选套路」,一道题都没全对,明明是多选它偏做成单选,当然这么做也有好处,就是不至于零封,怎么也能得个 4 分。

填空题

或许是这次填空题相对简单,有四家大模型斩获满分,分别是豆包、DeepSeek、通义和元宝。

文心 X1 有点可惜,整个答题思路都是正确的,也算出了公比为 2 或 - 2,但偏偏在最后画蛇添足,莫名其妙地说了句「通常取正值」,导致一分未得。

有哪些进步?又暴露了哪些问题?

有一说一,各家大模型公司狠砸的真金白银还真没白花,今年大模型的数学推理能力确实有了明显的进步。

首先表现在得分上。去年我们也曾让大模型挑战高考数学题,但彼时它们连高考数学及格线都没过,甚至 9.9 和 9.11 哪个大、strawberry 有几个 r 都答不对。反观今年大模型的表现,除 o3 外,其他 5 款模型均突破 43.8 分的及格线,甚至豆包和元宝还保持了 93% 的正确率。

其次,增加了反思能力。去年大模型还没学会反思,做题时因某个步骤错误而无法找到正确选项时,它们不再回头检查,而是直接简单粗暴地表示「没有正确选项」。而今年的大模型不再是一根筋,只要遇到不对劲的地方就会推倒重来,典型代表就是 DeepSeek,一言不合就验证,这也导致思考时间漫长,有时做一道题甚至能用时 15 分钟。

最后,推理步骤更加完善。回顾去年大模型在做高考数学题时的表现,普遍存在解析过程较为简略的情况,经常会跳步,有时解析过程一长还会陷入死循环。今年则是除了通义仍然「惜字如金」外,其他大模型都能够系统性地展示完整的推理链路,从问题分析、公式选择、计算步骤到结果验证,每个环节都有清晰的逻辑阐述。即使是数学基础相对薄弱的用户,也能够通过模型提供的详细解析过程,深入理解问题的本质和解决思路。

[ 上下滑动查看更多 ]

不过,从这次评测中我们也发现了大模型几个典型的毛病。

最常见的就是计算细节错误,即使模型理解了题意,推理方向正确,最后也容易在中间步骤出错,比如符号看错、公式套错、代数变形不规范等。

另一个核心问题是公式、图形与几何直觉的处理能力不足,比如解析几何类题目依赖较强的空间感和图形理解,这对语言模型而言是天然短板。在逻辑推理链较长或题型设计较「逆向」的题目中,模型还可能表现出蒙答案的倾向,看似给出了结论,但中间链条无法自洽或存在明显漏洞。

此外,对题目条件的敏感度不够。模型有时会忽略某些隐含条件,导致结论偏差。尤其在多选题中,模型容易满足于找到一个正确选项而不穷尽其他可能,从而漏选或误选。填空题则容易受到「无提示答题」能力的限制,不能推理出完整的结果。

随着技术不断进化,大模型的数学能力也会不断提高,相信总有一天大模型能弥补「偏科」的毛病。

最后,预祝各位考生金榜题名,考上理想的大学!

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#13岁靠「氛围编程」创业,见奥特曼、拜访a16z

他的暑假把成年人卷哭

有了ChatGPT后,13岁,正是闯的年纪......

今年夏天,来自多伦多的 13 岁少年 Michael Goldstein,过得比很多成年人都「硅谷」。

先是一个月的夏令营,紧接着飞去旧金山:参加技术创业大会、拜访 OpenAI 总部、和 Sam Altman 面谈、在 a16z 办公室 pitch 创意……

Goldstein 是这一代青少年科技追随者的典型样本。

讲话用硅谷行话、脑子里想的是创业难题,社交媒体上热衷运营账号、刷互动量。

他也不是孤例。越来越多硅谷创业者表示,最近几个月,他们的私信和邮箱塞满了青少年「不请自来」的邮件:「我能不能给你 pitch 一下」。

今天的年轻人比过去聪明多了,因为他们有 ChatGPT。这些业内人士几乎达成了共识,AI 是现在孩子们的新潮流,过去是 Snapchat 和 TikTok。我们适应新东西太快了。

生活中的 Michael Goldstein,来自 Michael Goldstein的X账号

Goldstein 自称只能半会写代码,但这并不妨碍他创办 AI 初创公司。他靠 YouTube 学 Cursor,让 AI 代写代码。

这正中了 Andrej Karpathy 在今年提出的「vibe coding(氛围编码)」概念。「你完全交给氛围,忘了代码的存在。」Karpathy 如此形容。

Goldstein 深信这套方法论,也深信自己自带的「创业气场」。在旧金山期间,他坐着 Waymo 和妈妈在城里穿梭、向 VC 推想法、跑活动、见大佬。

而且,他真见到了 Altman。

「我什么时候应该放弃一家创业公司?」小孩儿开门见山。Altman 给的回答也很典型:「当你不想继续做的时候。」

Goldstein 接着问了另一个关键问题:「我快没钱了,要融资,该要多少?」据说,Altman 给出的建议是,「去找 a16z 要 10 万美元。」

虽然 a16z 没投,但 Goldstein 已经调整创业方向。放弃了原本做「电脑操作AI」的项目 Neatly ,转向「世界最强 AI 设计代理」Kodo。

遭遇创业瓶颈,需求网友建议

找到新方向,做设计智能体

步步为营。AI 设计代理Kodo

Michael Goldstein 给出的两个 Demo,本质上还是典型的 UI 界面设计演示。

,时长00:31

,时长00:25

由于免费额度有限,我们只做了基础体验,先试了试它的平面设计能力——初印象还不错。

例如让它设计一张微信公众号文章封面图:

提示词:设计一个用于微信公众号文章的封面图。标题是 xxx:未来已来。要求风格专业、有科技感,尺寸为标准的 900x500 像素。请确保文字清晰易读。

这是Lovart的设计。

接着测试了 Kodo 的交互修改能力。我提出「不喜欢深蓝色背景,更喜欢温柔的粉色和蓝色」。

但返回结果没能按要求调整,颜色理解和执行并不到位。

再看它的艺术表达能力。生成内容确实有点抽象了。

不过,Kodo 提供相当多的可编辑元素,配合一定的微调步骤,应该能逐步逼近想要的视觉效果。

提示词:请设计一张视觉海报,用抽象艺术的风格表达宁静这个概念。不需要任何文字。使用柔和的色调和流动的线条。

「他能做到任何事」

Goldstein 的创业轨迹在家长眼里并不意外。

六年级他就在做无人机和天气气球。他妈妈 Lisa 说,当气球被送到能看见地球弧度的高度时,她就知道,只要他想,他能做任何事。

科技圈里,这样的少年也并不陌生。扎克伯格、Altman 当年都是在宿舍里「乱写代码」长大的。

一位和 Goldstein 经常在 X 上聊天的 AI 创业者 Jia Chen 评价说:「他行动快、有主观能动性、还保留着童真。他是真心热爱这件事。」

但并非所有人都赞同。

某 AI 创业者就发帖吐槽:12 岁就别卷创业了吧兄弟。哪怕你做成十亿美元,也会后悔没童年。鼓励这种行为的人都是喝了硅谷 VC 的洗脑水。

尽管硅谷对少年AI创业者兴致勃勃,但外界越来越担心孩子使用 AI 的风险,一个几乎导致全面封禁儿童使用 AI 的法案,刚被州长否决。

与此同时,AI 正被更积极地卖给孩子们。

Goldstein 参观的一家初创公司 Cluely,就有「帮学生作弊」的名声;OpenAI 也与美泰合作推出 AI 玩具;开源工具则让孩子们真的可以开发属于自己的 AI 产品。

Tinkering School 创始人 Gever Tulley 甚至预测:下一个Greta Thunberg也许就是13岁的技术少年,靠 AI 深度分析公开数据揭露企业丑闻。

Greta Thunberg 来自瑞典,2003 年出生,因在15岁时独自到瑞典议会前举牌为气候罢课而走红全球。

Goldstein 觉得自己天生有商业基因,也不抗拒来点儿自我营销。

当被问到他为什么想做 AI,以及这会如何改变世界时,他思考了一下,给出一句他认为够「上镜」的答案:

你可以引用我的话:做别人会用的东西很有趣。

参考链接

....

#iSeal

首个抗端到端攻击的大模型加密指纹 / 水印方案

本研究由史蒂文斯理工学院(Stevens Institute of Technology)的 IntelliSys Lab 团队以及休斯顿大学(University of Houston) 的 ANTS Lab 团队的相关研究人员共同完成,主要研究方向包括无服务器计算、高性能计算、AI 安全、联邦学习、LLM 代理系统、隐私保护及分布式智能系统等领域。

随着大语言模型(LLM)的商业价值快速提升,其昂贵的训练成本使得模型版权保护(IP Protection)成为业界关注的焦点。然而,现有模型版权验证手段(如模型指纹)往往忽略一个关键威胁:攻击者一旦直接窃取模型权重,即拥有对模型的完全控制权,能够逆向指纹 / 水印,或通过修改输出内容绕过指纹验证。

在此背景下,史蒂文斯理工学院(Stevens Institute of Technology)王灏老师团队的第二年级博士生熊子洵同学提出了 iSeal。该工作已被 AAAI 2026 主轨道以 poster 形式录用。

iSeal 是首个面向「端到端」模型窃取场景设计的加密指纹方案。它通过引入加密机制,使得指纹可抵御拥有模型完全控制权的攻击者所发起的「合谋遗忘攻击」(Collusion-based Unlearning)与「响应篡改攻击」(Response Manipulation),并在 12 个主流 LLM 上实现了 100% 的验证成功率。

- 论文标题:iSeal: Encrypted Fingerprinting for Reliable LLM Ownership Verification

- 论文链接:https://arxiv.org/pdf/2511.08905

研究问题与背景

大语言模型的训练往往耗费数百万美元的算力与数据资源,使得训练后的模型权重成为了极具价值的知识产权。为了确权,研究人员通常采用「模型指纹」(Model Fingerprinting)技术,即在模型中植入「触发器」(Trigger),当输入特定样本时输出特征化响应,以此证明模型所有权。

然而,现有指纹技术普遍基于一个不现实的假设:默认验证者面对的是黑盒 API,或攻击者无法干预推理过程。

在现实中,高级攻击者往往直接盗取模型权重并在本地部署,从而拥有「端到端控制」(End-to-End Control)。在这种情况下,攻击者可以发动更强的攻击,包括:

- 合谋遗忘(Collusion-based Unlearning):攻击者收集部分指纹触发样本与其响应,通过微调或反向训练使模型遗忘特定指纹特征。

- 响应篡改(Response Manipulation):攻击者实时监控模型输出,一旦检测到疑似指纹响应,立即使用同义词替换、句式重组或 paraphrasing 进行篡改,从而绕过验证。

实验表明,在这些高级攻击下,传统指纹方案(如后门式指纹)大多迅速失效,验证成功率接近 0%,无法提供有效保护。

方法与创新:iSeal 的加密指纹框架

针对上述挑战,iSeal 提出了一套全新的加密指纹验证框架。其核心思想不是植入一个静态后门,而是将指纹验证过程转化为一个安全的加密交互协议。主要设计包括以下三个方面:

- 加密指纹(Encrypted Fingerprinting)与外部编码器

iSeal 采用加密的指纹植入机制,并引入外部编码器(External Encoder)来解耦指纹与模型权重,使得指纹特征不再以显式形式存储在模型参数中,从而防止攻击者通过分析权重逆向指纹。

- 抗遗忘设计:Confusion & Diffusion 绑定机制

iSeal 通过 Confusion & Diffusion 机制,将指纹特征通过条件概率深度绑定到模型的核心推理能力之中。指纹不再是可单独剥离的附加结构,且多个指纹之间不互相纠缠,因此攻击者即使尝试遗忘部分指纹,也无法破坏整体指纹系统。

- 抵御响应篡改:基于相似度的动态验证

针对推理阶段的输出篡改,iSeal 采用基于相似度的验证策略(Similarity-based Verification)和纠错机制(Reed-Solomon Code)。即使攻击者使用 paraphrasing 或同义词替换,验证算法也能从语义与概率分布中恢复指纹信号。

实验结果

研究团队在包括 LLaMA、OPT 等在内的 12 个主流大语言模型上评估了 iSeal。结果显示,在提供强指纹保护的同时,iSeal 不影响模型的原始任务性能。

- 防御微调与合谋攻击

研究者模拟了攻击者利用盗取的模型权重执行 SFT 微调与合谋遗忘攻击。即使攻击者利用已知指纹样本反向训练以擦除指纹:

- iSeal 的验证成功率(FSR)始终保持在 100%;

- 传统指纹方法在经过少量微调后即完全失效(FSR ≈ 0%)。 这是因为 iSeal 的指纹互不纠缠,使得攻击者无法通过遗忘部分指纹来破坏整个验证结构。

- 防御响应篡改攻击

针对同义词替换、句式改写和 LLM 派生润色等篡改方式,iSeal 的相似度验证与纠错机制依然能够从潜在语义中识别指纹信号,因此验证成功率仍然维持在 100%。相比之下,基于精确匹配(Exact Match)的传统方法在此类攻击下完全失效。

- 消融实验

研究者对 iSeal 的关键组件进行了消融实验,以验证其必要性。

- 冻结编码器(Freezing the Encoder):若训练时不冻结编码器(iSeal w/o freezing),模型无法稳定收敛,FSR 直接降低为 0%。

- 可学习编码器(Learned Encoder):将可学习编码器替换为传统加密算法(如 AES,即 iSeal w/o encoder)后,FSR 降至 0%–2%。说明传统加密机制无法有效实现 iSeal 所需的指纹嵌入与语义恢复能力。

....

#MemoryOS

告别「失忆」AI!首个大模型记忆操作系统开源框架来了!

该项目来自百家 AI,是北京邮电大学白婷副教授所指导的研究小组, 团队致力于为硅基人类倾力打造情感饱满、记忆超凡的智慧大脑。

大语言模型受限于固定上下文窗口,长期对话中「失忆」、记忆断裂等问题频发,北邮百家 AI 团队重磅推出首个大模型记忆操作系统开源框架 MemoryOS。巧妙融合计算机操作系统原理与人脑分层记忆机制,构建段页式三级存储架构及四大核心模块(存储、更新、检索、生成),提供全链路用户记忆管理方案,让 AI 智能体拥有持久「记性」与深度「个性」。

开源项目地址:https://github.com/BAI-LAB/MemoryOS

大型语言模型(LLMs)固定的上下文窗口如同狭窄的信息通道,导致 AI 在长期对话中频繁「失忆」, 常常导致记忆断裂、事实不一致,个性化交互体验也大打折扣。现有提升 LLM 记忆能力的方法虽各有侧重(如知识提示、RAG 检索优化或模型参数驱动),但均缺乏一个统一的操作系统来对 AI 智能体的记忆进行系统性、综合性的管理。

北邮百家 AI 团队突破性地提出记忆操作系统 MemoryOS,旨在为 AI 智能体实现全面、高效的记忆管理。通过打造强大的「记忆操作系统」,让 AI 智能体长效记忆与个性化交互成为可能。MemoryOS 在主流基准测试中显著提升了 AI 在长对话中的上下文连贯性和个性化记忆保留能力,在 LoCoMo 基准上,模型的 F1 和 BLEU-1 分数平均提升了 49.11% 和 46.18%。

大模型记忆管理

MemoryOS 借鉴了现代操作系统中成熟的内存管理原则,采用短期、中期、长期三级分层记忆存储体系(实时对话存储、主题信息整合、个性化知识沉淀),包含四大核心功能:记忆存储、记忆更新、记忆检索和响应生成,全方位管理 AI 记忆系统。MemoryOS 支持本地部署,为大模型搭载统一的记忆管理插件。

,时长01:04

MemoryOS 赋予 AI 三大「记忆超能力」:

✅长效记忆不死板:通过「记忆存储 + 动态更新」双引擎,让多轮对话的上下文关联像人类回忆般自然连贯,千轮交流不「断片」,用户画像随每一次互动持续生长;

✅按需唤醒够精准:四大核心模块(存储、更新、检索、响应)协同运作,如大脑神经突触般快速定位所需信息,既避免「记忆过载」,又杜绝「关键信息丢失」,让应答始终贴合历史语境;

✅个性交互有温度:不再依赖预设模板,而是基于沉淀的用户记忆生成专属回应 —— 从初次对话的兴趣标签,到百次交流后的习惯洞察,AI 真正成为「懂你过去,更知你所需」的智能伙伴。

实验验证

百家 AI 团队在多种基准数据集上进行实验,包括评估多轮对话能力的 GVD 数据集和专为评估长期对话记忆能力设计的 LoCoMo 基准。

1. 显著性能提升:MemoryOS 在所有测试的基准数据集上均展现出卓越性能。特别是在 LoCoMo 基准测试中,搭载 MemoryOS 的 GPT-4o-mini 模型,相较于基线方法,在 F1 和 BLEU-1 上分别取得了平均高达 49.11% 和 46.18% 的显著提升。

2. 高效的平衡: MemoryOS 不仅性能强大,还在计算效率方面表现良好,例如,与 A-Mem * 相比,它需要的 LLM 调用次数显著减少 (4.9 vs 13.0),而与 MemGPT 相比,其消耗的 token 数量也大幅降低 (3,874 vs 16,977),实现了性能与效率的有效平衡。

记忆管理展示

为了直观展现 MemoryOS 的强大能力,不妨来看一个生动的对比。想象一下,您数周前和 AI 助手表达了健身目标后,某天突然想吃汉堡并咨询 AI 建议时,MemoryOS 不仅能给出低脂美食推荐,还会贴心地结合您之前的健身意愿,提醒您「别忘了还要去健身房哦!」。这种对过去对话细节的精准把握和对用户长期目标的持续关注,使得搭载 MemoryOS 的 AI 系统在交互中展现出远超普通模型的连贯性和个性化深度,从而极大地提升了用户体验。

期望和愿景

百家 AI 团队提出前沿洞察:在 AI 时代,谁掌握用户记忆,谁就能赢得未来竞争的主动权。大模型的进化路径不仅遵循模型规模扩张的「Scaling Law」准则,当搭载 MemoryOS 记忆操作系统,实现记忆的高效管理时,模型的认知能力将迎来质的跃升,或将迎来 Memory Scaling 阶段。MemoryOS 将为大模型带来新的机遇:

✅时空个性化交互整合能力:MemoryOS 打破普通模型短期记忆瓶颈,借助 “记忆唤醒 - 目标匹配 - 个性适配” 机制,在长周期对话中实现个性化与连贯性的深度融合。

✅动态构建个性化用户信息网络:通过每一次对话交互,MemoryOS 持续描摹用户画像,使其成为 AI 时代解码个体个性化需求的原生入口,实现从「单次服务」到「持续理解」的升级。

✅智能迭代赋能多场景需求解码:基于对用户的深度理解,MemoryOS 支持 AI 自主感知需求并持续迭代,在搜索场景中解码消费需求,助力智能营销精准锁定用户意图;同时塑造「智能伙伴」角色,通过长期交互进化为理解用户全维度需求的服务中枢。

这一创新推动 AI 实现从「依赖指令的被动应答」到「理解意图的主动交互」的重要跃升。依托 MemoryOS,AI 能够深度解析用户的潜在需求与行为逻辑,逐步进化为具备持续学习能力的智能伙伴,推动人工智能向更具理解深度的认知智能阶段迈进。

....

#Noisy-Rewards-in-Learning-to-Reason

为什么用错奖励,模型也能提分?新研究:模型学的不是新知识,是思维

本文主要作者是吕昂和谢若冰。吕昂,中国人民大学博士生,研究方向为语言模型结构优化,导师为严睿教授;谢若冰,腾讯高级研究员,研究方向为大语言模型、推荐系统。

最近的一篇论文中,来自人大和腾讯的研究者们的研究表明,语言模型对强化学习中的奖励噪音具有鲁棒性,即使翻转相当一部分的奖励(例如,正确答案得 0 分,错误答案得 1 分),也不会显著影响下游任务的表现。

研究者解释道,强化学习对下游任务的提升,关键不仅在于奖励的准确性,而更在于模型是否能够产生高质量的思考过程。仅通过奖励模型输出中关键思考词的出现频率,而非基于答案正确性的奖励,语言模型依然能够在下游任务中取得非常高的峰值表现。这表明,强化学习对下游任务的提升,更多来源于让模型学会采用恰当的思考路径接近正确答案。而相关的解题基础能力,模型已在预训练阶段获得。因此,预训练阶段的能力提升依然至关重要。

研究者还展示了基于思考模式的极简奖励如何有效校准奖励模型,从而在开放性 NLP 任务中增强语言模型的表现,并使较小的模型也能通过强化学习成功获得思考能力。

论文地址:https://huggingface.co/papers/2505.22653

代码链接:https://github.com/trestad/Noisy-Rewards-in-Learning-to-Reason

论文概览

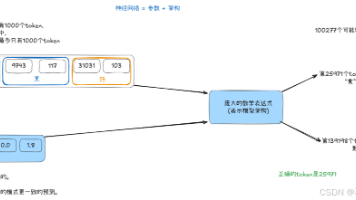

作者们首先研究了数学任务中奖励噪音对语言模型的影响,因为数学任务使用简单的规则校验,根据答案的正确性进行奖励,这使得人为控制奖励噪音变得非常简单(例如,通过将基于答案正确性的奖励函数结果进行 p% 的反转,正确答案得 0 分,错误答案得 1 分),从而便于研究。在训练 Qwen-2.5-7B 模型时,实验发现即使 p 值非常高,模型在下游任务中的表现几乎没有下降。只有当 p 值达到 50%(即完全随机奖励)时,训练效果才开始崩溃。这一现象引发了一个重要问题:为何即便模型给出错误答案并且得到奖励,训练效果依然保持不变?

图 1:使用不同程度奖励反转后的 Qwen-2.5-7B 在 MATH-500 数据集上的准确率变化,横轴为训练步数。

针对这一现象,作者提出了一种可能的解释:尽管答案错误,输出中的某些信息依然为模型的输出提供了奖励的价值。研究者认为,这些有价值的信息反映在模型的思考过程上。当模型生成诸如「First, I need to」,「second, I will」,「given these factors」,「finally」等思考模式时,无论最终答案是否正确,这一思考过程本身值得奖励。

为了验证这一假设,作者统计了在没有噪声奖励训练(即 p=0)的情况下,Qwen-2.5-7B 在数学任务中输出的高频思考关键词,并设计了一种非常简单的奖励机制 ——Reasoning Pattern Reward(RPR)。每当模型输出包含这些高频思考关键词时,便根据出现频次给予相应奖励,频次越高,奖励越大。

图 2: RPR 示意

仅使用 RPR 机制,完全不考虑答案的正确性,Qwen-2.5-7B 仍然能够在 MATH-500 数据集上将准确率从 5% 提升至 70% 以上。尽管在后续训练中准确率有所下降,作者通过案例研究指出,这一下降源于 RPR 使得模型在获得正确答案后「过度思考」,从而导致输出超长无法提取正确答案。作者承认,仅使用 RPR 而不使用其他答案校验奖励可能会被模型「hack」并产生问题,但他们强调,此实验的目的是证明思考模式在能力提升中的重要性,而非为了获得最好的结果。

这一实验表明,强化学习中,语言模型的提升主要源自输出格式的转变而非新知识的获取:模型在 RL 期间采样到具有良好思维模式的输出,而这种思维模式能够提高模型逐 token 接近正确答案的概率。

以上基于奖励函数的实验结果让作者们意识到,这一发现也许对于基于奖励模型(reward model)的强化学习后训练具有重要启示:由于奖励模型通常并不完美,输出中往往会包含噪声。如果语言模型能够在开放性任务中保持对奖励模型输出噪声的鲁棒性,那么我们或许不必过于追求极度精准的奖励模型,确保其「足够好」即可。

为验证这一点,作者在 Nvidia-HelpSteer3 数据集(一个多领域 AI 帮助性回复生成任务)上进行了实验。通过控制训练步数,训练了不同准确率的奖励模型,并用这些模型训练 Qwen-2.5-7B。作者认为奖励模型的准确率与其提供的奖励噪声呈负相关关系,即奖励模型准确率越高,奖励噪声越低。模型在测试集上输出的回复由人类 + GPT-4o 判断帮助性、信息度、与综合质量。

图 3: 奖励模型在 HelpSteer3 训练过程中,在验证集上的准确率,作者选取不同训练步数的 checkpoint 作为奖励模型进行训练。

实验结果显示,当奖励模型准确率超过 75% 时,不同奖励模型训练得到的语言模型在下游任务中的主观评测得分相似。这一现象与在数学任务中的观察相符,表明语言模型能够容忍一定程度的奖励噪声。然而,当奖励模型准确率低于 75% 时,训练效果显著下降;当准确率降至 65% 时,模型的表现大幅不如使用高准确率奖励模型训练得到的结果。这也许指出了 Qwen-2.5-7B 在该任务上的噪声耐受限度。

图 4: 不同奖励模型训练得到的语言模型在 HelpSteer3 任务中的主观评测表现

这一发现或许对许多研究人员而言提供了慰藉:在很多应用场景中,我们不必过分追求奖励模型的高准确率,因为超过某个临界点后,进一步提高奖励模型的准确率对任务性能的提升将变得有限。

作者们进一步思考,如果真的无法获得「足够好」的奖励模型,如何增强现有奖励模型以提升下游任务表现?

为此,作者提出通过 RPR 对奖励模型进行校准:如果某个输出被奖励模型评为低分,但其思考模式较好(即 RPR 得分较高),那么这个低分可能是一个假阴性,应该根据其思考模式通过 RPR 机制对奖励模型的输出进行补偿。通过这种方式,作者在 HelpSteer3 任务中验证了,即使奖励模型的准确率为 65%,经过 RPR 校准后,模型表现接近原本 85% 准确率的奖励模型训练出的效果。同时,85% 准确率奖励模型经过校准后,模型在下游任务中的表现进一步增强,突破了作者们所拥有的奖励模型质量的限制。

图 5: 经过 RPR 校准后,所有奖励模型训得的语言模型质量都有提升。

作者们的另一个重要发现是,即便使用作者所拥有的最精确的奖励模型(准确率 85%),Qwen-2.5-3B 在 HelpSteer3 任务上发生了训练崩溃,表现为输出长度急剧下降,仅剩数十个 token。但经过 RPR 校准后,3B 模型成功完成了训练,避免了崩溃并获得了良好的效果,并且在很多复杂的开放任务中,比如根据指令做 PPT,呈现出良好的解题思路。

图 6: 经过 RPR 校准奖励模型后,3B 的模型也可以在 HelpSteer 任务上成功训练;而使用未校准的奖励模型,RL 发生了崩溃。

研究者们希望通过展示语言模型对基于结果的奖励噪声的鲁棒性,以及单独使用 RPR 获得下游任务提升的结果,来强调强化学习对语言模型的影响更在于改变其输出风格,形成良好的思考模式,而非教授新知识。

此外,思考模式的重要性在使用奖励模型进行训练的开放性任务中得到了验证,也为强化学习后训练算法的改进提供了新思路。

作者指出,模型预训练技术的增强仍然值得持续投入,因为如果强化学习只专注于思考模式的培养,语言模型预训练阶段的能力依然会对下游任务构成瓶颈(例如文中对 Llama3 的实验表明,由于 Llama3 预训练模型难以生成较高质量的思考路径,导致其在各个任务中的表现和抗噪音能力远逊色于 Qwen 模型)。

....

#Modularity theorems for abelian surfaces

数学宇宙二维破壁成功!四人组230页证明阿贝尔曲面镜像通道,大一统要实现了?

三百多年前,数学家费马在书页边缘留下了一个看似简单却困扰了学者几个世纪的难题——费马大定理。

1994 年,Andrew Wiles 的实际性证明为这个传奇故事画上了句号。然而,故事并未就此结束。

那场伟大证明的真正遗产,并非仅仅是攻克了一道难题,而是揭示了不同数学世界之间一条深刻的「地下通道」——模块化定理。这个定理证明了相对简单的「椭圆曲线」总能与一种叫做「模形式」的对象一一对应。

最近,数学界再次掀起风浪,这条「地下通道」竟然迎来了 pro max 版升级。四位数学家将这种对应关系,从一维的椭圆曲线,延伸到了结构复杂得多的高维对象——「阿贝尔曲面」上。

这一飞跃意义非凡,它朝着实现数学领域的「大一统理论」(即朗兰兹纲领)迈出了革命性的一步,为解决更多悬而未决的数论难题提供了前所未有的强大工具。

让我们一起跟随量子杂志的脚步,开启这场奇妙的数学之旅。

从费马大定理到数学统一之梦

1994 年,数学界发生了一场「大地震」。

数学家 Andrew Wiles 终于攻克了费马大定理 (Fermat’s Last Theorem),这个数论领域的核心难题已经悬而未决超过三个世纪。这一证明不仅让数学家们激动不已,甚至登上了《纽约时报》的头版。

作为数论中一个著名的猜想,费马定理由法国数学家皮埃尔·德·费马在 1637 年提出。它的核心内容非常得简单,却困扰了数学家超过 350 年。定理陈述如下:

为了攻克这一猜想,Wiles 在另一位数学家 Richard Taylor 的协助下,首先必须证明一个更为精妙的关键命题。这个中间命题的意义,远远超出了解决猜想的本身。

这个关键的证明在于揭示:一种重要的数学方程(即椭圆曲线)总是能与一种截然不同的数学对象(即模形式)紧密关联起来。Wiles 和 Taylor 本质上打开了一扇连接不同数学领域的「传送门」。他们揭示出,这两个领域就像彼此扭曲的镜像。

这就为数学家们提供了一种强大的研究方法:如果想要理解椭圆曲线的某个性质,他们可以进入模形式的世界,找到并研究其对应的「镜像」对象,然后再将得出的结论带回到椭圆曲线的领域。

这种世界之间的联系被称为「模性」(Modularity),不仅是证明费马大定理的工具,它更成为数学家攻克其他难题的万能钥匙。

不仅如此,模性理论还是朗兰兹纲领 (Langlands Program) 的基石,这一宏大的猜想体系试图构建数学的「终极统一理论」。如果朗兰兹纲领成立,则各类数学方程(不限于椭圆曲线)都将与其「镜像世界」的对象绑定。数学家们能自由穿梭于不同数学领域,通过镜像转化解决更复杂的问题。

尽管证明模性对应关系极其艰难,甚至被视为「不可能任务」。但在今年 2 月,四位数学家联手实现了突破。他们将模性理论从椭圆曲线(一维方程)拓展到阿贝尔曲面(二维复杂方程)。

论文标题:Modularity theorems for abelian surfaces

论文地址:https://arxiv.org/pdf/2502.20645

团队成员分别为芝加哥大学的 Frank Calegari、伦敦帝国理工学院的 George Boxer 和 Toby Gee 以及法国国家科研中心的 Vincent Pilloni。他们证明了一大类阿贝尔曲面必然存在对应的模形式。

从左到右分别为 Toby Gee、Frank Calegari 和 Vincent Pilloni。

伦敦帝国理工学院数学家 Ana Caraiani 对此兴奋表示:「我们基本都相信这些猜想是对的,但亲眼见证它被证实——尤其是在一个曾被认为遥不可及的领域——实在令人震撼!」

这只是长达数年探索的开始!这些数学家们的终极目标是证明所有类型的阿贝尔曲面都满足模性对应。正如当年椭圆曲线的模性证明催生了无数新研究方向,此次突破已能直接帮助解决许多悬而未决的难题。

挑战数学界的「禁区」

椭圆曲线是一种基础方程,仅含 x 和 y 两个变量。如果你将其解画成图像,会呈现看似简单的曲线。但是这些解之间存在极其丰富的复杂关联,并频繁现身于数论的核心难题中。

比如,数学界最棘手的未解之谜——贝赫和斯维讷通-戴尔猜想(百万美元悬赏问题),它研究的正是椭圆曲线解的深层规律。

然而,直接研究椭圆曲线往往困难重重,数学家常需另辟蹊径。这就是模形式的用武之地。

作为数学分析领域的高度对称函数,模形式具有极强的对称性(如折叠变换后形态不变),实际运算时远比椭圆曲线容易处理。

乍看之下,椭圆曲线与模形式「风马牛不相及」。但 Wiles 和 Taylor 的证明揭示:每个椭圆曲线都对应一个特定模形式,二者共享关键数学基因。例如,描述椭圆曲线解的特征数集,会在其对应的模形式中重复出现。

因此,数学家们得以通过模形式这面「透视镜」,窥见椭圆曲线隐藏的奥秘。他们认为,上述对应关系仅是更普遍真理的一个特例,存在一个比椭圆曲线更广泛的数学对象类别。所有这些对象,都应在对称函数宇宙(如模形式所在的世界)中拥有「镜像伙伴」。这些正是朗兰兹纲领的核心主张。

椭圆曲线:仅含 x、y 两个变量,因而它的解可以画在二维平面上,呈现光滑曲线。如果增加第三个变量 z,解构成三维空间中的弯曲曲面。这种更复杂的对象被称为阿贝尔曲面,与椭圆曲线一样,它的解具有数学家想要了解的精妙数学结构。

阿贝尔曲面理应对应更复杂的模形式变体(如椭圆曲线的升级版镜像)。但是新增变量 z 使其构造难度暴增,解的求解如同在三维迷宫中寻路。证明其模性曾被视为「不可能任务」。

作者之一 Toby Gee 坦言,「这曾是学界刻意避开的禁区,因前人屡试屡败。」但是,他们四人想要尝试解决这一难题。

寻找一座桥梁

这四位数学家都参与了朗兰兹纲领的研究,他们希望能为「一个在现实生活中真正会出现的对象,而不是某些凭空捏造的怪东西」来证明其中一项猜想,Calegari 说道。

阿贝尔曲面不仅确实出现在现实生活中——当然,是数学家眼中的现实生活——而且,证明一个关于它们的模块化定理将会开启新的数学大门。「一旦你拥有了这个论断,你就能做很多若非如此便毫无可能的事情」,Calegari 说。

这几位数学家于 2016 年开始合作,希望能够复刻 Taylor 和 Wiles 在证明椭圆曲线时所遵循的步骤。但是,对于阿贝尔曲面而言,其中的每一步都远比之前复杂。

因此,他们将研究重点集中在一种更容易处理的特殊类型阿贝尔曲面——即「普通阿贝尔曲面」上。对于任何一个此类曲面,都有一组数字可以描述其解的结构。如果他们能证明同样这组数字也可以从一个模形式中推导出来,那么大功就告成了。这组数字将作为一个独特的标签,让他们能将每一个阿贝尔曲面与一个模形式配对。

问题在于,尽管为一个给定的阿贝尔曲面计算这些数字十分简单,数学家们却不知道如何构建一个带有完全相同标签的模形式。当要求如此严格时,模形式的构建就变得异常困难。「你所寻找的那些对象,你甚至不能确定它们是否存在」,Pilloni 说道。

作为替代方案,数学家们证明了,只需构建一个其数字能在更弱的意义上与阿贝尔曲面的数字相匹配的模形式就足够了。这个模形式的数字只需在所谓的「时钟算术」范畴内等价即可。

想象一个时钟:如果时针从 10 点开始,走过 4 个小时,它将指向 2 点。但时钟算术可以用任何数字来进行,而不仅仅是(像现实世界中的时钟那样)数字 12。

Boxer、Calegari、Gee 和 Pilloni 只需要证明,当他们使用一个以 3 为周期的时钟时,他们那两组数字是匹配的。这意味着,对于一个给定的阿贝尔曲面,数学家们在构建相关联的模形式时拥有了更大的灵活性。

但即便如此,这也被证明是太困难了。

后来,他们偶然发现了一批模形式的宝库,其对应的数字非常容易计算——只要他们根据一个以 2 为周期的时钟来定义这些数字。但是,阿贝尔曲面需要的是一个以 3 为周期的时钟。

数学家们对于如何大致地桥接这两个不同的时钟体系有了一些想法,但他们不知道如何使这种联系变得严丝合缝,以便在模形式的世界里为阿贝尔曲面找到一个真正的匹配。就在这时,一项新的数学成果出现了,而它恰好就是他们所需要的。

意外的援手Lue Pan 在数论这个看似不同的领域的工作被证明是必不可少的。

2020 年,一位名叫 Lue Pan 的数论学家发表了一篇关于模形式的证明,起初看来与这四人组的问题并无关联。但他很快意识到,他所发展的技术有着惊人的相关性。「我当时完全没想到」,Pan 说道。

经过数年主要通过 Zoom 进行的定期会议,数学家们在化用 Pan 的技术方面开始取得进展,但主要的障碍依然存在。然后,在 2023 年夏天,Boxer、Gee 和 Pilloni 将德国波恩的一场会议视为一次完美的聚首机会。

Gee 为团队在 Hausdorff Research Institute 的地下室争取到了一间房间,在那里他们不太可能被过路的数学家打扰。他们在那里花了整整一周的时间研究 Pan 的定理,日复一日地工作 12 个小时,只是偶尔才到地面上来补充点咖啡因。「喝完咖啡后,我们总会开玩笑说,我们得『回到矿井』去了」,Pilloni 说。

辛苦的付出终有回报。「后来还有很多曲折」,Calegari 说,「但在那一周结束时,我认为我们或多或少已经搞定了。」

又花了一年半的时间,他们才将 Calegari 的信念转化为一篇长达 230 页的证明,并于今年 2 月将其发布在网上。他们将所有部分拼接在一起,证明了任何普通阿贝尔曲面都有一个与之相关联的模形式。

他们这个新的门户有朝一日可能会像 Taylor 和 Wiles 的结果一样强大,揭示出关于阿贝尔曲面的、超乎任何人想象的更多信息。但首先,团队必须将他们的结果扩展到非普通的阿贝尔曲面。他们已经与 Pan 合作,继续这场探索。「十年后,如果我们还没能找到它们中的绝大部分,我会感到很惊讶」,Gee 说。

这项工作也让数学家们得以提出新的猜想——例如 Birch and Swinnerton-Dyer 猜想的一个类比,其中涉及的是阿贝尔曲面而非椭圆曲线。「现在我们至少知道,对于这些普通曲面,这个类比是讲得通的」,麻省理工学院 (MIT) 的数学家 Andrew Sutherland 说。「在此之前,我们并不知道这一点。」

「由于这个定理,许多我曾梦想有一天能够证明的东西,现在都变得触手可及了」,他补充道。「它改变了一切。」

原文链接:https://www.quantamagazine.org/the-core-of-fermats-last-theorem-just-got-superpowered-20250602/

....

#AI会完成我们能做的一切

最新!Ilya现身多大毕业演讲

大脑是一台生物计算机,数字计算机又有什么不同呢?

「总有一天,人工智能会完成我们能做的一切事情。不是部分,而是全部。」

6 月 6 日,许久没有露面的 Ilya Sutskever 出现在了多伦多大学的校园里,接受母校授予他的荣誉理学博士学位。

自去年宣布离开 OpenAI 之后,Ilya 鲜少出现在公众视野,社交媒体动态也很少更新,所以很多人都问「Ilya 去哪儿了」?他创办的新公司 —— 安全超级智能(safe superintelligence,SSI)也非常神秘,大家只有一个模糊的印象,即该公司业务围绕着开发一个安全、强大的超级智能系统展开。

回顾 Ilya 的学生生涯,他于 2005 年以数学荣誉理学学士学位(honours bachelor of science in mathematics)毕业,随后继续深造,在多伦多大学先后取得计算机科学硕士学位和博士学位,师从图灵奖、诺贝尔物理学奖得主 Hinton。

这次颁发的学位是为了表彰 Ilya 作为计算机科学家和人工智能领域先驱所做的基础性工作及全球影响力,以及他在倡导安全、负责任的人工智能方面作出的杰出贡献。

仪式之后,Ilya 还在多伦多大学做了一场演讲。他指出,我们正生活在人类历史上最不寻常的时代 ——AI 时代,AI 最终将能够完成人类所有的工作,这将带来人类有史以来最大的挑战,但也蕴含着最大的机遇,因此我们每个人都需要积极观察 AI 的发展,培养对其能力的直觉,并为即将到来的深刻变革做好准备。因为无论我们是否愿意,AI 都将深刻影响每个人的生活。

,时长10:05

虽然演讲只有 10 分钟,但从中,我们能听到 Ilya 对于未来的担忧,他指出了技术发展的不可控性和社会适应的滞后性,甚至坦言连他自己都「很难在情感层面完全相信」这种剧变会发生。但要来的终究会来。

以下是 Ilya 的完整演讲内容。

大家好,很高兴来到这里。我想感谢每一个人为此做的安排,为组织这个活动,为给我这个荣誉学位。获得这个荣誉学位对我来说意义非常重大。

几乎就在 20 年前的今天,我在多伦多大学的这个大厅里获得了我的学士学位。而且实际上,这将是我从多伦多大学获得的第四个学位。

我在这里度过了非常美好的时光。我总共在这里待了 10 年。我完成了本科学位,学到了很多,我也在这里做过研究生,这是很棒的体验。我能够深入研究我感兴趣的任何领域,真正成为一名研究者。能够跟 Jeff Hinton 教授一起学习真的很棒。实际上,跟随 Jeff Hinton 做研究是我人生中的一大幸运,我对这所大学充满感激。

当我还是这里的学生时,多伦多大学正在做世界上最好的 AI 研究,有最革命性的想法,最令人兴奋的工作。我很幸运能够在研究生阶段就作为学生为此做出贡献。但那是很久以前的事了。

据我理解,在这次毕业典礼演讲中,应该提供一些明智的建议,之后我会稍微讲一些,但只是一点点,因为这个演讲与以往有些不同。

我首先想说的是好的心态,会让一切变得容易得多:接受现实,不要后悔过去,努力改善现状。

之所以这么说,是因为这是一种非常难以做到的心态。我们常常很容易陷入这种想法「过去做错了什么决定,命运不好,事情不公平」之类的。我们很容易陷入这种思维中,浪费大量时间去纠结。

我们应该这样想:「事情都这样了,下一步该怎么做?」我发现当我这样做时,一切会变得顺利得多。但这很难做到,这是一场与自己情感的持久斗争。我提这个,是希望你们也能尽量采取这种心态,也时刻提醒我自己。毕竟,这是一个不断奋斗的过程。

不过,这段话只是我想分享的一小部分,接下来,我的演讲会有点不同,因为现在的时机非常特殊。

我们正处在一个前所未有的时代。这种说法可能会常常听到,但我认为这次是真的。原因就是 AI 的出现。显而易见,今天的 AI 已经在相当大的程度上改变了你们作为学生的意义,变化是相当显著的。我感觉到,尤其是我认为它对我们未来的影响是巨大的。

当然,AI 的影响远不止于此,它开始以一些未知且无法预测的方式改变我们从事的工作。有些工作可能很快就会受到影响,有些则可能稍后。如今,通过 AI,我们可以看到很多新的技术和应用,大家也许已经在 Twitter 上看到,AI 能够做很多以前做不到的事情。这时你会开始思考,哪些技能将变得更加重要,哪些又会变得不那么重要。这个问题是显而易见的。

可以说,当前的挑战是:AI 如何影响我们的工作和职业生涯。但真正的挑战在于,AI 将发生极大的变化,未来的影响将比现在更为深远。我们已经看到,AI 可以与我们对话,理解我们说的话并用语音回应,这在以前是不可想象的。AI 不仅能理解我们的语言,还能编写代码,这真是不可思议。然而,它仍有许多不足的地方,做得还不够好,依然有很多缺陷。所以我们可以说,它在很多方面还需要追赶,但它的潜力是巨大的,值得我们继续关注。

在未来的某个时刻,AI 将不断进步,可能是三年、五年或十年后(虽然具体时间众说纷纭),但 AI 会逐步变得越来越强大。最终,AI 将能够完成我们所有能够做到的事情,而不仅仅是其中的一部分。

任何我能学到的东西,任何你们中的任何一个人能够学到的东西,AI 都能学会。那么,为什么我这么确信呢?我们怎么知道 AI 将来能做这些事情呢?原因是,我们每个人的大脑都是一个生物计算机。

我们有大脑,就是因为它是一个生物计算机。那么,既然人类的生物计算机能做这些事情,为什么数字计算机、也就是数字大脑不能做同样的事呢?这就是为什么我认为 AI 最终能做到所有我们能做到的事情的原因。

你可以开始思考:当计算机能够胜任我们所有的工作时,会发生什么?这些是真正重大的问题,具有戏剧性的意义。现在当你开始思考这个问题时,可能会觉得有些震撼。但这还只是冰山一角。

真正的问题是:我们人类集体会希望用这些 AI 来做什么?做更多工作?发展经济?进行研发?推进 AI 研究?如果是这样,那么技术进步的速度将在一段时间内变得极其迅猛。这些都是极端的变化,难以想象的场景。

所以我现在试图把大家拉入这样一种思维空间 —— 一个由 AI 创造的极端而激进的未来。但这种未来也很难想象,很难真正内化,很难在情感层面完全相信。即使是我也在为此而挣扎。然而逻辑似乎表明,这很可能会发生。

那么在这样的世界里人应该做什么呢?有一句话是这么说的:你可能对政治不感兴趣,但政治会对你感兴趣。同样的话适用于 AI,而且是加倍的。

我认为,通过使用 AI 并观察当今最先进的 AI 能做什么,你会形成一种直觉。随着 AI 在一年、两年、三年内不断改进,这种直觉会变得更强烈。我们现在讨论的许多事情会变得更加真实,不再那么虚幻。归根结底,任何文章和解释都比不上我们亲眼所见的真实感受。

特别是对于未来那些极其聪明的超级智能 AI,如何确保它们诚实可信、不会欺骗伪装,这将是一个极其深刻的问题。我在这里把很多复杂的概念压缩到了很短的时间里。但总的来说,通过观察 AI 的能力,在关键时刻不忽视它的发展,这将产生我们克服 AI 带来的巨大挑战所需的动力。

在某种意义上,AI 带来的挑战是人类有史以来最大的挑战,克服它也将带来最大的回报。在某种意义上,无论你是否喜欢,你的生活都将在很大程度上受到 AI 的影响。所以观察它,关注它,然后凝聚力量解决即将出现的问题 —— 这将是最重要的事情。

我就说到这里。非常感谢。

....

#ABKD

追求概率质量的帕累托最优:基于广义α-β散度引导的知识蒸馏框架

知识蒸馏(KD)是一种将大模型(教师)的知识迁移到小模型(学生)的技术,学生通过模仿教师预测分布,充分利用软标签信息,通常优于传统监督微调,已在图像分类、文本生成等任务及最新工作(如 DeepSeek-R1、Qwen-3)中得到验证。其核心在于分布匹配方式的选择,主流方法多用前向 KL 散度(FKLD)或反向 KL 散度(RKLD),但 FKLD 易导致输出过度平滑,难以聚焦关键类别,RKLD 则使学生过度自信、降低多样性。实验证明,两者在多任务中表现有限,且目前缺乏系统方法揭示其深层问题,阻碍了更通用高效 KD 框架的发展。因此,一个自然的问题产生了:

究竟是什么潜在因素导致了 FKLD 和 RKLD 的次优表现?

为了解答这个问题,我们通过追踪对数质量比(LogR),分析不同散度在训练中如何影响学生分布的概率分配。进一步分析表明在温和假设下,LogR 与损失函数对 logits 的梯度成正比,这使我们将问题转化为分析:不同散度算法如何影响 ∣LogR∣ 下降。

标题:ABKD: Pursuing a Proper Allocation of the Probability Mass in Knowledge Distillation via α-β-Divergence

论文:https://arxiv.org/abs/2505.04560

代码:https://github.com/ghwang-s/abkd

在此框架下,我们识别出两种关键的「模式集中效应」:难度集中与置信集中。

- 「难度集中」指的是更关注于在教师分布 p 与学生分布 q 之间误差较大的模式。

- 「置信集中」指的是更关注于学生分布 q 本身高度自信的模式。

进一步研究发现,FKLD 和 RKLD 的局限性正源于对这两种集中效应的极端利用。

- FKLD 集中效应较弱,对所有类别误差一视同仁,导致学生难以聚焦目标类别,易出现错误预测(见图 1d)。

- RKLD 集中效应过强,兼顾高误差和高置信度类别,易陷入「平凡解」,即学生只关注目标类别,忽略教师分布的其他知识(见图 1e)。

揭示这些局限性后,我们提出一个关键问题:我们能否找到一种通用且理论上有依据的方法,来平衡「难度集中」与「置信集中」效应?

方法

为此,我们引入了 α-β 散度。

其广义统一了 FKLD、RKLD 及 Hellinger 距离等多种散度。

正如下一节理论表明,α-β 散度可通过调节 α 和 β 在 FKLD 与 RKLD 间平滑插值,实现对难度集中和置信集中效应的灵活权衡。这一机制带来更合理的概率分配,据此我们提出了通用蒸馏框架 ABKD,形式为最小化:

基于 α-β 散度平衡难度集中和置信集中

ABKD 提供了一个统一空间权衡难度集中与置信集中。为解释这一点,回到对数质量比(LogR)。下列命题解释了超参数 α 和 β 如何影响 ∣LogR∣ 的减小。

在 (a) 和 (a1) 中,α-β 散度通过幂次形式

体现置信集中效应:

- 当 β→1 时,退化为 RKLD 的效应。

- 当 β→0 时,退化为 FKLD 的效应。

较大的 β 值会增强置信集中效应,使匹配性能更加专注于模型最有信心的类别(见图 1c)。

在 (b) 和 (b1) 中,使用以下方式衡量难度集中效应:

- 当 α→1 时,退化为 FKLD 的效应。

- 当 α→0 时,退化为 RKLD 的效应。

较小的 α 会放大难度集中效应,在困难类别上进行更强的误差惩罚,从而实现更激进的匹配(见图 1b)。

通过调节 α 和 β,ABKD 实现对两种效应的精细平衡,避免了传统方法(FKLD/RKLD)的极端情况(见图 1g)。

与 α-散度的比较

α-散度是 ABKD 框架的一个特例(当 β=1−α 时成立)。

虽然它也能实现 FKLD(α→1)和 RKLD(α→0)之间的转换,但根据命题 4.2,为了减小 α,必须相应地增大 β,以满足 α+β=1 的限制条件。这种不必要的限制阻碍了其性能的进一步提升,具体如图 1(a) 和图 1(f) 所示。

与 WSD 的比较

另一种方案是对 FKLD 和 RKLD 取加权和(WSD):

不幸的是,这种组合度量会过度强调 p 和 q 中概率较小的模式。当 q(k)≈0,p(k)>0 或 p(k)≈0,q(k)>0 时,有:

因此,算法必须关注极端情况以最小化目标函数,导致概率分配不合理。此外这种情况下梯度范数也会过度增长,导致参数更新中可能含有噪声,破坏优化稳定性。

最后一种方法是使用 Jensen-Shannon 散度:

其中 m=(p+q)/2。它的缺点是当分布 p 和 q 相距较远时(这是训练初期的常见情况),会出现梯度消失,阻碍模型收敛。

实验自然语言任务

我们在五个指令跟随基准上评估方法,使用 ROUGE-L 指标,对比了 SFT、FKLD、GKD 和 DISTILLM 等方法。

实验结果表明仅修改蒸馏目标,ABKD 在不同数据集上均优于或匹配 FKLD、SFT。对比基于 SGO 的方法(如 GKD、DISTILLM)效果提升明显,ABKD 在不公平对比下依然表现优越。

- 损失函数影响

α-β 散度优于 α 或 β 散度及 WSD。在五个数据集上相较基线有稳定提升。训练过程中的优势也体现在图 2。

视觉任务

在 12 个常用图像识别数据集上进行实验,对比方法比较了多种先进蒸馏方法:KD、DKD、LSD 和 TTM 等。

结果表明 ABKD 能根据不同教师-学生组合自动选择合适的蒸馏目标。此外 ABKD 可作为简单的插件工具,优化现有方法的损失函数,带来额外性能提升。

敏感性分析

α 对难度集中的影响:图 6(a)(b) 展示了不同 α 下的训练表现。在 CIFAR-100 中,较小 α 提升有限;在 Dolly 等大输出空间任务中,适当减小 α 有助于避免陷入局部最优。

β 对置信集中的影响:图 6(c)(d) 显示了 β 对输出分布的 Shannon 熵和 Self-BLEU 的影响。较小 β 使模型更关注低置信度类别,提升输出分布的平滑性和多样性(熵更高,Self-BLEU 更低)。

结语

本文指出,知识蒸馏的核心在于平衡「难度集中」和「置信集中」两种效应,而传统 FKLD 和 RKLD 只覆盖两个极端,导致概率分配不合理。为此,我们提出基于 α-β 散度的 ABKD 框架,统一并推广了现有方法,实现两种效应的灵活权衡。理论与大量实验均验证了 ABKD 的有效性。

....

#华为昇腾万卡集群揭秘

如何驯服AI算力「巨兽」?

你是否注意到,现在的 AI 越来越 "聪明" 了?能写小说、做翻译、甚至帮医生看 CT 片,这些能力背后离不开一个默默工作的 "超级大脑工厂"——AI 算力集群。

随着人工智能从简单规则判断进化到能处理万亿参数的大模型,单台计算机的算力就像小舢板面对汪洋大海,而算力集群则是把上万台甚至几十万台计算机像搭积木一样连接起来,形成一艘能承载巨量计算任务的 "算力航空母舰"。

当我们把上万台计算机整合成一个有机整体时,需要解决一系列世界级难题:如何让它们像精密钟表一样协同工作?如何在部分设备故障时依然保持高效运行?如何快速修复大规模训练中的中断问题?

接下来我们将逐一揭秘这些支撑 AI 算力集群的关键特性,看看华为团队如何用工程智慧驯服这头算力巨兽。

技术报告地址:https://gitcode.com/ascend-tribe/ascend-cluster-infra/blob/main/Overview/%E6%98%87%E8%85%BE%E9%9B%86%E7%BE%A4%E5%9F%BA%E7%A1%80%E8%AE%BE%E6%96%BD%E7%BB%BC%E8%BF%B0.pdf

超节点高可用

24 小时不停工的智能工厂

就像医院的急诊系统必须时刻在线,AI 训练和推理也不能轻易中断。算力集群里每台计算机都有 "备用替身",当某台机器出现故障(比如突然断电或硬件损坏),系统会立刻启动备用机接管任务,就像接力赛中接力棒无缝传递,确保自动驾驶训练、语音识别等任务持续运行,不会因为个别设备故障而全盘停止。

针对 CloudMatrix 384 超节点,华为团队提出面向整个超节点的故障容错方案,分为 “系统层容错”、“业务层容错”,以及后续 “运维层容错”,核心思想就是 将故障问题转为亚健康问题,通过运维手段优雅消除:

(1) 系统层容错:通过超时代答欺骗 OS + 网络路由切换,防系统蓝屏,同时避免整个超节点级故障。

(2) 业务层容错:租户无感知下,通过重试容忍网络闪断,将系统故障转为亚健康,

(3) 运维层容错:主要构筑亚健康感知和优雅恢复技术,通过主动方式将消减亚健康事件影响。

集群线性度:人多力量大的完美协作

理想情况下,100 台计算机的算力应该是 1 台的 100 倍,1000 台就是 1000 倍,这就是 "线性度"。算力集群通过精密的任务分配算法,让每台计算机都像 orchestra(交响乐团)的乐手一样各司其职,避免出现 "三台和尚没水喝" 的混乱。比如训练一个需要万亿次计算的模型时,万台计算机能像整齐划一地划桨的龙舟队,让算力随规模增长而几乎同步提升。

华为团队提出拓扑感知的协同编排技术 TACO、网络级网存算融合技术 NSF、拓扑感知的层次化集合通信技术 NB、无侵入通信跨层测量与诊断技术 AICT 等四项关键技术,实现盘古模型训练线性度提升。

实验及理论分析结果显示,训练盘古 135B 稠密模型时,4K 卡 Atlas 800T A2 集群相比 256 卡基线,线性度为 96%。训练盘古 718B 稀疏模型时,8K 卡 Atlas 800T A2 集群相比 512 卡基线,线性度 95.05%;4K 卡 CloudMatrix 384 集群相比 256 卡基线,线性度 96.48%。

万卡集群训练快速恢复

带 "存档功能" 的训练师

当用上万个计算单元(俗称 "万卡")训练超大规模模型时,偶尔有几台机器 "罢工" 是难免的。这时系统会像游戏存档一样,自动记录最近的训练进度。一旦检测到故障,能快速定位出问题的计算单元,跳过故障部分,从最新的存档点继续训练,避免从头再来的巨大浪费。比如训练一个需要 30 天的模型,即使中间有设备故障,也能在几分钟内恢复进度,就像视频播放可以随时续播。

为了使万卡集群训练可以达到分钟级快恢,华为团队提出了以下多个创新:

(1) 进程级重调度恢复:正常节点通过参数面网络将临终 CKPT 传递到备用节点上,完成参数状态恢复后继续训练,能够有效缩短训练恢复时间到 3min 以内。

(2) 进程级在线恢复:针对硬件 UCE 故障,通过业务面昇腾 CANN 软件、框架软件、MindCluster 软件配合实现故障地址在线修复,进一步缩短训练恢复时间到 30s 以内。

(3) 算子级在线恢复:针对 CloudMatrix 384 产品 HCCS 网络、ROCE 参数面网络提供 HCCL 算子重试能力,容忍更长时间的网络异常,实现网络故障影响的通信算子秒级重执行,训练任务不中断。

超大规模 MoE 模型推理分钟级恢复

各路英豪来帮忙

随着千亿 MOE 模型架构演进,实例部署的组网架构从传统的一机八卡演进为大 EP 组网架构,将多且小的专家部署在多个服务器节点上缓解显存带宽压力,目前在大 EP 组网架构下主要面临部署规模扩大导致的故障概率数量增大、故障爆炸半径变大的可靠性问题,任意硬件故障都会导致整个 Decode 实例不可用,进而导致推理业务受损,甚至中断。

针对当前超大规模 MoE 模型带来的大 EP 推理架构的可靠性难题,华为提出三级容错方案,实例间切换、实例内重启恢复、实例内无损恢复,从硬件驱动层、框架层、平台层相互协作,构筑端到端可靠性体系。在不同的故障场景下,采用不同的容错恢复手段,可以最小化用户损失。

(1) 实例内快速重启恢复技术:根据实际环境测试验证,该技术将实例恢复时间从 20min 降低 5min。

(2) TOKEN 级重试:基于 DeepSeekV3 在 CloudMatrix 384 超节点场景下,验证 30~60s 实现实例恢复。

(3) 减卡弹性恢复技术:作为当前进行工作,解决硬件故障下业务中断问题,通过专家迁移,实现故障时推理进程不退出,以减卡为容错手段,动态调整推理实例规模,在用户无感知情况下秒级恢复。

故障管理与感知诊断

24 小时在线的设备医生

算力集群里有一套实时监控系统,就像给每台计算机安装了 "健康手环",持续监测温度、算力利用率、数据传输速度等指标。一旦发现某台设备运行异常(比如散热不良导致速度变慢),系统会立即发出警报,并像医生一样分析故障原因 —— 是硬件老化?网络拥堵?还是软件 bug?快速定位问题并启动修复机制,防止小故障演变成大停机。

针对面向算力集群的硬件故障管理,华为团队提供了一套完整的解决方案:基于 CloudMatrix 384 超节点的设备物理形态和组网方案的昇腾 AI 硬件灾备高可靠架构设计、涵盖基础检错纠错能力、故障隔离能力、故障容错能力以及深度巡检与故障预测能力的昇腾 RAS 统一故障管理容错框架、进一步提升光链路的可靠性的网络自诊断可靠性管理、以及绿色低碳、稳定可靠和安全可信的云数据中心管理体系。

针对面向算力集群的故障感知能力,华为团队构建了大规模集群在线故障感知(全栈可观测)和故障诊断(全栈故障模式库、跨域故障诊断、计算节点故障诊断、网络故障诊断)技术:

(1) 全栈可观测能力:构建了大规模集群的故障感知能力,主要由集群运行视图、告警视图、网络链路监控、告警接入和配置、网络流可观测能力组成

(2) 故障诊断能力:包括全栈故障模式库、跨域故障诊断、计算节点故障诊断、网络故障诊断;

建模仿真

算力底座的 “数字化风洞”

在正式开展复杂 AI 模型的训推之前,算力集群可以先在虚拟环境的 “数字化风洞” 中 "彩排"。比如研发一个新药筛选模型时,先通过模拟不同的算法参数、数据输入和计算资源分配方案,预测模型在真实场景中的表现,就像电影导演用动画预演复杂镜头。这种 "先模拟后实战" 的方式,能提前发现计算系统的瓶颈点和逻辑漏洞,并提出相应优化手段,节省大量真实训推的时间和资源。

华为团队创新性提出系统化、可扩展的马尔科夫建模仿真平台,围绕对训练、推理、高可用三大核心领域实现多维度系统性建模分析与性能预测调优,实现集群资源高效配置与动态优化,达成算力极致利用与系统长期稳定可靠运行。

(1) Sim2Train 训练建模仿真:马尔科夫训练集群建模仿真平台,AdaptPack 编排优化长序列 PP 空泡,吞吐提升 4.5%-8.24%。通信与计算协同场景,引入 AdaptS/R 技术,通信暴露时间降 89.84%,单步总时长缩短 3.25%;MoE 通过 AdaptExpert 提升端到端性能 7.5%。

(2) Sim2Infer 推理建模仿真:面向昇腾复杂推理系统的马尔科夫建模仿真平台,实现了从高层算子描述到底层硬件指令的自动化映射与仿真,平均误差低至 6.6%。

(3) Sim2Availability 高可用建模仿真:马尔科夫高可用建模仿真框架,通过离散时间步长仿真,建模单步时长内的故障性能劣化影响与恢复耗时,模拟复杂系统训练任务中的故障场景及运维响应,实现对训练过程性能表现与故障恢复状态的全周期监控仿真。

框架迁移

给模型跑车换更酷炫轮胎

自从 2020 年 3 月全面开源以来,华为推出的全场景 AI 框架昇思 MindSpore 一路高歌猛进,开发者生态迅速成长。除了为基于昇腾 + 昇思的自主创新外,昇思 MindSpore 也提供了拥抱主流生态的兼容方案,适应大模型时代的挑战和需求。

(1) 训练阶段,MindSpore 构建了 MSAdapter 生态适配工具,覆盖 90% 以上 PyTorch 接口,实现第三方框架的无缝迁移,并针对动态图执行效率的问题,通过多级流水线技术与即时编译(JIT)优化显著提升执行效率。

(2) 推理阶段,MindSpore 基于主流生态的 HuggingFace 权重配置,无需修改即可实现一键部署,通过 vllm-MindSpore 插件对接 vLLM 框架,支持大模型推理服务化能力。实现盘古 72B 模型快速部署,实现推理性能提升。

总结与展望

综上所述,华为团队针对昇腾算力集群基础设施,提出了针对超节点高可用、集群线性度、万卡集群训练快速恢复、万亿 MoE 模型推理容错、集群故障感知及感知诊断、集群仿真建模、框架迁移等方面的全维度的创新方案。

随着新型应用快速变化,硬件系统持续创新,系统架构不断演进,工程能力走向智能化,未来算力基础设施的演进将走上算法 - 算力 - 工程协同进化的道路,有可能形成形成 “应用需求→硬件创新→工程反哺” 的闭环,算法层驱动算力专用化(如复合 AI 需异构加速),算力层通过架构革新(如光电混合)释放性能潜力,工程层以智能化手段(如 AI 运维)弥合复杂度鸿沟,最终实现高效、弹性、自愈的下一代算力基础设施。

....

#苹果争议论文翻车了?

质疑DeepSeek-R1、Claude Thinking根本不会推理!

当前,AI 的「推理」能力已经在以 DeepSeek-R1、OpenAI o1/o3、Claude 3.7 Sonnet 为代表的推理大模型中得到了验证,它们显示出了非常类人的思考过程。

然而近日,苹果团队的一篇论文对 LLM 的推理能力提出了质疑,并提出了自己的观点 —— 像 DeepSeek-R1、o3-mini 这类模型实际上根本没有进行推理,只是很擅长记忆模式罢了。

相关的一则推文在 x 上的阅读量已经突破了 1000 万。

我们接下来看苹果这篇文章如何得出这一结论的:

苹果从问题复杂性的角度探究前沿推理模型(LRM)的推理机制,没有采用用标准基准(例如数学问题),而是采用可控的谜题环境,通过调整谜题元素并保留核心逻辑,系统地改变复杂度,并检验解决方案和内部推理(图 1 顶部)。

这些谜题:(1) 对复杂性进行细粒度控制;(2) 避免现有基准中常见的污染;(3) 仅需明确提供的规则,强调算法推理;(4) 支持基于模拟器的严格评估,从而实现精确的解决方案检查和详细的故障分析。

实证研究揭示了关于当前推理模型(LRM)的几个关键发现:

首先,尽管这些模型通过强化学习习得了复杂的自我反思机制,但它们未能发展出适用于规划任务的泛化问题解决能力,其性能在超过一定复杂度阈值后会崩盘至零。

其次,苹果在等效推理计算条件下对 LRM 和标准 LLM 进行了比较,揭示了三种不同的推理机制(图 1 底部)。其中对于更简单、低组合性的问题,标准 LLM 表现出更高的效率和准确性。随着问题复杂度的适度增加,思维模型会获得优势。然而,当问题达到高复杂度且组合深度更长时,两种模型类型的性能都会完全崩溃(图 1 左下)。值得注意的是,接近这个崩溃点时,尽管 LRM 的运行速度远低于代数限制,但随着问题复杂度的增加,它们开始减少推理工作量(以推理时间 token 衡量)(图 1 中下)。这表明,相对于问题复杂度,LRM 的推理能力在推理时间尺度上存在根本的限制。

最后,苹果对中间推理轨迹或思维的分析揭示了与复杂性相关的模式:在较简单的问题中,推理模型通常会尽早识别出正确的解决方案,但会低效地继续探索错误的替代方案 —— 这是一种「过度思考」现象。在中等复杂度下,正确的解决方案只有在广泛探索错误路径后才会出现。超过一定的复杂度阈值,模型将完全无法找到正确的解决方案(图 1 右下)。这表明 LRM 具有有限的自我修正能力,虽然很有价值,但也暴露出其根本的效率低下和明显的扩展限制。

这些发现凸显了现有 LRM 的优势和局限性,并对这些系统中推理的属性提出了质疑,这对它们的设计和部署具有重要意义。

总结来说,这项工作的贡献包括如下:

对当前基于既定数学基准的 LRM 评估范式提出质疑,并利用算法谜题环境设计了一个可控的实验平台,该环境能够根据问题复杂性进行可控的实验。

实验表明,最先进的 LRM(例如 o3-mini、DeepSeek-R1、Claude-3.7-Sonnet-Thinking)仍然未能开发出可泛化的问题解决能力。在不同环境中,当复杂度超过一定水平时,准确率最终会降至零。

苹果发现 LRM 的推理能力在问题复杂性方面存在一个扩展极限,这一点可以从思维 token 在达到某个复杂性点后呈现的反直觉下降趋势中看出。

苹果质疑当前基于最终准确率的评估范式,并借助确定性谜题模拟器将评估范围扩展到思维轨迹的中间解。分析表明,随着问题复杂度的增加,正确的解会系统性地出现在思维的后期,而错误的解则不然,这为理解推理模型 (LRM) 中的自我修正机制提供了定量层面的见解。

苹果发现 LRM 在执行精确计算方面存在一些令人惊讶的局限性,包括它们无法从显式算法中获益,以及它们在不同谜题类型之间的推理不一致。

- 论文标题:The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity

- 论文地址:https://ml-site.cdn-apple.com/papers/the-illusion-of-thinking.pdf

在这篇论文的作者中,共同一作为 Parshin Shojaee,她现在为 Virginia Tech 三年级博士生,且为苹果的研究实习生。另一位共一 Iman Mirzadeh 为苹果的 ML 研究工程师。此外,Yoshua Bengio 的兄弟 Samy Bengio 也参与了这项工作,他现为苹果的 AI 和机器学习研究高级总监。

数学与谜题环境

目前,我们尚不清楚近期基于强化学习的思维模型所观察到的性能提升是归因于「更多接触已建立的数学基准数据」,还是归因于「分配给思维 token 的显著更高的推理计算能力」,又或是归因于「基于强化学习的训练所开发的推理能力」?

最近的研究通过比较基于强化学习的思维模型与其非思维标准 LLM 对应的上限能力 (pass@k),利用已建立的数学基准探索了这个问题。他们表明,在相同的推理 token 预算下,非思维 LLM) 最终可以在 MATH500 和 AIME24 等基准测试中达到与思维模型相当的性能。

苹果还对前沿的 LRM 进行了比较分析,例如 Claude-3.7-Sonnet(有思维 vs. 无思维)和 DeepSeek(R1 vs V3)。结果如图 2 所示,在 MATH500 数据集上,当提供相同的推理 token 预算时,思维模型的 pass@k 性能与非思维模型相当。然而,苹果观察到这种性能差距在 AIME24 基准上有所扩大,在 AIME25 上进一步扩大。这种不断扩大的差距带来了解释上的挑战。

这可以归因于:(1)复杂性不断增加,需要更复杂的推理过程,从而揭示思维模型在更复杂问题上的真正优势;或者(2)在较新的基准(尤其是 AIME25)中数据污染减少。有趣的是,人类在 AIME25 上的表现实际上高于 AIME24,这表明 AIME25 的复杂度可能较低。然而,模型在 AIME25 上的表现比 AIME24 更差 —— 这可能表明在前沿 LRM 的训练过程中存在数据污染。

鉴于这些不合理的观察结果以及数学基准不允许对问题复杂性进行控制操纵的事实,苹果转向了能够进行更精确和系统实验的谜题环境。

谜题环境

苹果评估了 LRM 推理在四个可控谜题上的性能,这些谜题涵盖了组合深度、规划复杂度和分布设置。谜题如下图 3 所示。

汉诺塔谜题(Tower of Hanoi)包含三个桩子和 n 个大小不同的圆盘,这些圆盘按大小顺序(最大的在底部)堆叠在第一个桩子上。目标是将所有圆盘从第一个桩子移动到第三个桩子。有效的移动方式包括一次只移动一个圆盘、只取桩子顶部的圆盘,以及永远不要将较大的圆盘放在较小的圆盘上。此任务的难度可以通过初始圆盘的数量来控制,因为初始圆盘数量为 n 时所需的最小移动次数为 2^n − 1。然而,在本研究中,苹果不对最终解决方案的最优性进行评分,而只衡量每次移动的正确性以及是否达到目标状态。

跳棋(Checker Jumping)是一个一维谜题,将红色棋子、蓝色棋子和一个空格排成一条线。目标是交换所有红色和蓝色棋子的位置,有效地镜像初始配置。有效的移动包括将棋子滑入相邻的空位,或跳过恰好一个相反颜色的棋子落入空位。在谜题过程中,任何棋子都不能后退。该任务的复杂性可以通过棋子的数量来控制:如果棋子数量为 2n,则所需的最小移动次数为 (n + 1)^2 − 1。

过河(River Crossing)是一个约束满足规划难题,涉及 n 个参与者及其对应的 n 个代理,他们必须乘船过河。目标是将所有 2n 个个体从左岸运送到右岸。船最多可载 k 个人,且不能空载。当参与者与另一个代理在一起而没有自己的代理时,会出现无效情况,因为每个代理都必须保护其客户免受竞争代理的侵害。此任务的复杂性也可以通过存在的参与者 / 代理对的数量来控制。当 n = 2 或 n = 3 对时,使用船容量 k = 2;当对数较大时,使用 k = 3。

积木世界(Blocks World)是一个积木堆叠难题,要求将积木从初始配置重新排列成指定的目标配置。目标是找到完成此转换所需的最少移动次数。有效移动仅限于任何堆叠的最顶层积木,该积木可以放置在空堆叠上或另一个积木之上。此任务的复杂性可以通过存在的积木数量来控制。

实验及结果

本文实验是在推理模型及其对应的非推理模型上进行的,例如 Claude 3.7 Sonnet(thinking/non-thinking)和 DeepSeek-R1/V3。

复杂性如何影响模型推理?

为了研究问题复杂性对推理行为的影响,本文在可控谜题环境中开展了推理与非推理模型对的对比实验,比如 Claude-3.7-Sonnet(thinking/non-thinking)和 DeepSeek(R1/V3)。

图 4 展示了两类模型在所有谜题环境中随问题复杂度变化的准确率。

作为补充,图 5 在相同推理 token 计算量下(所有谜题平均值),呈现了这些模型对的性能上限(pass@k)。

上述结果都表明,这些模型的行为在复杂性方面存在三种状态:

在问题复杂度较低的第一种状态下,本文观察到非推理模型能够获得与推理模型相当甚至更好的性能。

在复杂度适中的第二种状态下,能够生成长思维链的推理模型的优势开始显现,推理、非推理模型之间的性能差距开始扩大。

最有趣的状态是问题复杂度更高的第三种状态,两种模型的性能都崩溃为零。

这些结果都表明,虽然推理模型延缓了这种崩溃,但它们最终也会遇到与非推理模型相同的根本限制。

接下来,本文又研究了不同推理模型在问题复杂度变化时的效果。测试模型包括 o3-mini(中 / 高配置)、DeepSeek-R1、DeepSeek-R1-Qwen-32B 以及 Claude-3.7-Sonnet(thinking)。

图 6 表明,所有推理模型在面对复杂度变化时都呈现出相似的模式:随着问题复杂度的提升,模型准确率逐渐下降,直至超过模型特定的复杂度阈值后完全崩溃(准确率归零)。

本文还发现推理模型最初会随着问题复杂度成比例地增加思维 Token 使用量。然而,当接近临界阈值(该阈值与其准确率崩溃点高度吻合)时,尽管问题难度持续增加,模型却会反直觉地减少推理投入。这一现象在 o3-mini 系列变体中最为显著,而在 Claude-3.7-Sonnet(思维版)模型中相对较轻。值得注意的是,尽管这些模型的推理生成长度远未达到上限,且拥有充足的推理计算预算,但随着问题复杂度提升,它们却未能有效利用思维阶段额外的计算资源。这种行为表明,当前推理模型的思维能力相对于问题复杂度存在根本性的扩展局限。

推理模型的思维内部发生了什么?

为了更深入地理解推理模型的思考过程,本文对模型推理轨迹进行了细粒度分析。重点关注 Claude-3.7-Sonnet-Thinking。

基于推理轨迹的分析进一步验证了前文所述的三种复杂度模式,如图 7a 所示。

对于简单问题(低复杂度):推理模型通常在思维早期就能找到正确解(绿色分布),但随后持续探索错误解(红色分布)。值得注意的是,与正确的解决方案(绿色)相比,错误解决方案(红色)的分布更倾向于思维的末端。这种现象,在文献中被称为过度思考(overthinking),导致了计算的浪费。

当问题变得稍微复杂时,这种趋势就会逆转:模型首先探索不正确的解决方案,然后再得出正确的解决方案。此时错误解(红色)的分布位置相较于正确解(绿色)明显下移。

最后,对于复杂度更高的问题,会出现崩溃,这意味着模型无法在思维中生成任何正确的解决方案。

推理模型令人困惑的行为

如图 8a 和 8b 所示,在汉诺塔环境中,即使本文在提示中提供算法 —— 以便模型只需要执行规定的步骤 —— 模型性能也不会提高,并且观察到的崩溃仍然发生在同一点左右。

此外,在图 8c 和 8d 中,本文观察到 Claude 3.7 Sonnet thinking 模型表现出截然不同的行为模式。该模型在提出的解决方案中首次出现错误的时间往往较晚,而在过河谜题中,该模型仅能生成有效解直至第 4 步。值得注意的是,该模型在解决需要 31 步的问题(N=5)时能达到近乎完美的准确率,却无法解决仅需 11 步的过河谜题(N=3)。这可能表明网络上 N>2 的过河谜题范例较为稀缺,意味着 LRMs 在训练过程中可能较少接触或记忆此类实例。

研究惹争议

对于苹果的这项研究,有人表示如果真是这样,那又如何解释 o3-preview 在 ARC 基准测试上的表现呢?

有人认为苹果的研究具有误导性,他们只测试了 DeepSeek R1 和 Claude 3.7。虽然其他模型可能会失败,但说「ALL 推理模型失败是不公平的。

还有人(x 用户 @scaling01)复现了苹果论文中的汉诺塔谜题及使用的精确prompt,有了一些有趣的发现:

你至少需要 2^N - 1 步,并且输出格式要求每步包含 10 个 token 以及一些常量。

此外,Sonnet 3.7 的输出限制为 128k,DeepSeek R1 为 64k,o3-mini 为 100k。这包括它们在输出最终答案之前使用的推理 token!

所有模型在圆盘数量超过 13 个时准确率都将为 0,这仅仅是因为它们无法输出那么多!

最大可解规模且没有任何推理空间:DeepSeek:12 个圆盘;Sonnet 3.7 和 o3-mini:13 个圆盘。如果你仔细观察模型的输出,就会发现,如果问题规模过大,它们甚至不会进行推理。

由于移动次数太多,则将解释求解算法,而不是逐一列出所有 32,767 个移动次数。

因此可以发现:

至少对于 Sonnet 来说,一旦问题规模超过 7 个圆盘,它就不会尝试进行推理。它会陈述问题本身以及求解算法,然后输出解决方案,甚至不会考虑每个步骤。

有趣的是,这些模型在每次移动时都有 X% 的概率选出正确的 token。即使有 99.99% 的概率,由于问题规模呈指数级增长,模型最终也会出错。

此外,苹果论文对游戏复杂性的解读也非常令人困惑 仅仅因为汉诺塔谜题需要的步数比其他塔多得多,而其他的只需要二次或线性更多的步数,这并不意味着汉诺塔谜题更难。

这位用户直言不讳地称这项工作为「胡说八道」,模型实际上不是受限于推理能力,而是输出 token 的限制造成的。

简单来说,这位用户的观点就是:所有模型在圆盘数量超过13个时准确率降至0,仅仅是因为它们无法输出那么多。

OpenAI 的员工也凑起了热闹,表示「这波对苹果研究的深挖很棒。」

有人还表示,如果这波分析没错的话,那苹果的研究将没有意义。

参考链接:https://x.com/scaling01/status/1931783050511126954

....

#AdaCM2

首个面向超长视频理解的跨模态自适应记忆压缩框架

本文第一作者为前阿里巴巴达摩院高级技术专家,现一年级博士研究生满远斌,研究方向为高效多模态大模型推理和生成系统。通信作者为第一作者的导师,UTA 计算机系助理教授尹淼。尹淼博士目前带领 7 人的研究团队,主要研究方向为多模态空间智能系统,致力于通过软件和系统的联合优化设计实现空间人工智能的落地。

近年来,大语言模型(LLM)持续刷新着多模态理解的边界。当语言模型具备了「看视频」的能力,视频问答、视频摘要和字幕生成等任务正逐步迈入真正的智能阶段。但一个现实难题亟待解决——如何高效理解超长视频?

为此,来自得克萨斯大学阿灵顿分校(UTA)计算机系研究团队提出了 AdaCM2:首个支持超长视频理解的跨模态记忆压缩框架。该研究已被 CVPR 2025 正式接收,并荣获 Highlight 论文(接收率为 3%),展示出其在技术创新与实际价值上的双重突破。

论文标题:AdaCM2: On Understanding Extremely Long-Term Video with Adaptive Cross-Modality Memory Reduction论文地址:https://arxiv.org/pdf/2411.12593背景:LLM 强大,长视频理解却步

多模态视频理解模型如 VideoLLaMA、VideoChat 等已经在短视频(5–15 秒)场景中表现优异,能够回答关于视频内容的自然语言问题。但当视频长度扩展至分钟级甚至小时级,模型的显存瓶颈和冗余信息干扰问题暴露无遗:

内存消耗呈指数级上升,难以部署;

视觉 Token 冗余严重,导致关键信息被淹没;

文本与视频之间缺乏精准对齐机制。

AdaCM2 正是为解决这些核心问题而生。

提出动机:两大关键观察揭示「压缩冗余」的机会

AdaCM2 的提出建立在对视频与文本交互过程中的两个核心观察基础上,揭示了现有模型在超长视频场景下的内在局限:

观察一:帧内注意力稀疏性(Intra-Frame Sparsity)

在长视频的任意一帧中,只有极少数视觉 Token 对当前文本提示具有强相关性。绝大多数视觉信息对于回答文本问题(如「她在和谁说话?」)是无关的。实验发现,这些注意力得分呈现出尾部偏置分布,意味着高价值信息集中在少数 Token 中。

启发: 可以有选择性地仅保留「重要的」视觉 Token,而无需一视同仁处理全部帧内容。

观察二:层间语义冗余性(Layer-Wise Redundancy)

研究还发现,在深层网络中,临近帧之间的跨模态注意力相似度非常高,甚至在间隔较远的帧之间也存在冗余。这种高相似性意味着:多个 Token 在不同时间或不同层次上表达了重复的语义信息。

启发: 应该在不同层次上使用差异化的压缩策略,从而动态平衡信息保留与内存占用。

这两大观察构成了 AdaCM2 设计的基础,驱动出一整套可调、可解释、可扩展的「视频记忆管理机制」。

创新:AdaCM2 提出跨模态动态压缩机制

为应对长视频带来的内存挑战,AdaCM2 首次引入了跨模态注意力驱动的层级记忆压缩策略。其核心思想是:「仅保留那些对文本提示最有意义的视觉信息」,并通过跨层级的策略自适应完成压缩,确保模型不丢关键信息。

关键技术点:

- 逐帧回归式建模:AdaCM2 不再一次性输入全部帧,而是逐帧处理并动态更新记忆缓存,实现轻量但语义连续的建模。

- 跨模态注意力打分:通过 Q-Former 模块,模型在每一层中计算视觉 Token 与文本提示之间的注意力权重,只保留注意力得分高的「关键信息 Token」。

- 分层压缩机制:针对不同 Transformer 层中 Token 的冗余程度,设置可调的压缩参数(α 和 β),实现更精细的内存控制。

- 与 LLM 无缝对接:AdaCM2 支持与各种主流 LLM 对接,如 Vicuna-7B、FlanT5 等,仅需轻量微调 Q-Former 模块即可完成端到端训练。

实验结果:性能超越 SOTA + 显存下降 65%

AdaCM2 在多个长视频标准数据集上进行了验证,包括:

- LVU 分类任务:平均 Top-1 准确率提升 4.5%,在「导演」「场景」等任务上领先所有方法;

- COIN / Breakfast 行为理解任务:超过 MA-LMM,展示更强泛化能力;

- MSVD 视频字幕生成:达到 189.4 CIDEr,领先现有 SOTA;

- 内存效率:显存使用下降 65%,在极端情况下依旧维持稳定推理,支持处理超 2 小时长视频。

消融研究也显示,若移除跨模态压缩模块或将其替换为随机丢弃,模型性能将显著下降,证明观察驱动设计的有效性。

应用前景:多模态大模型的「长时记忆」引擎

AdaCM2 的提出,为多模态模型赋予了「可控的长时记忆能力」。这一能力不仅适用于传统的视频理解任务,还对以下未来应用场景具有重要意义:

- 智能交通监控:支持对全天候视频的智能分析与摘要生成;

- 医疗手术记录分析:自动分析长时间术中操作行为;

- 教育与会议记录理解:提取关键片段并生成总结;

- 机器人感知:支持具备持续视觉记忆的xx智能体。

总结

AdaCM2 作为首个专注于极长视频理解的跨模态记忆压缩框架,在大语言模型和视觉编码器之间架起了一座高效的信息筛选桥梁。它不仅优化了计算资源利用率,还拓展了多模态 AI 在实际应用中的边界。随着多模态大模型逐步走向落地,AdaCM2 的提出无疑将成为推动长视频智能理解发展的关键技术。

....

#MiniCPM 4.0

开启端侧长文本时代!面壁全新架构,让小钢炮最快提升220倍

端侧大模型,正在发生质变。

端侧语言模型,终于迎来了脱胎换骨式的创新。

上周五,2025 智源大会上,国内知名 AI 创业公司面壁智能正式发布了旗下最新一代「小钢炮」模型 MiniCPM 4.0,一下子把 AI 的发展推到了「前进四」。

在发布会上,面壁智能 CEO 宣布 MiniCPM 4.0 实现了行业首个系统级上下文稀疏语言模型创新,实现了 5% 的极高稀疏度,能够在端侧跑起长文本推理,开启了端侧长文本时代。

本次发布的 MiniCPM 4.0 分为 8B 和 0.5B 两个参数版本,均刷新了端侧模型能力的上限。

据介绍,通过架构、算法、数据及系统层面的多维度创新,新一代上下文稀疏高效架构模型 MiniCPM 4.0 8B 相较于 Qwen-3-8B、Llama-3-8B、GLM-4-9B 等同体量模型实现了长文本推理速度稳定 5 倍,极限场景下最高 220 倍加速,实现了同级最佳模型性能。同时进一步实现了长文本缓存的大幅锐减,在 128K 长文本场景下,MiniCPM 4.0-8B 相较于 Qwen3-8B 仅需 1/4 的缓存存储空间。

,时长01:00

模型、预训练数据和端侧推理框架均已开源。

GitHub 链接:https://github.com/openbmb/minicpm

技术报告:https://github.com/OpenBMB/MiniCPM/blob/main/report/MiniCPM_4_Technical_Report.pdf

Huggingface 链接:https://huggingface.co/collections/openbmb/minicpm-4-6841ab29d180257e940baa9b

Model Scope 链接:https://www.modelscope.cn/collections/MiniCPM-4-ec015560e8c84d

MiniCPM 4.0 系列在卫冕全球最强端侧模型的同时,也让我们看到了继 DeepSeek 之后大模型领域又一次源自底层架构的技术突破。

速度提升百倍

端侧最强,以小博大

MiniCPM 4.0 的提升可以说是全方位的,在端侧推理的各项任务上,它再次巩固了面壁「小钢炮」系列模型的领先地位。

面壁智能报告说,MiniCPM 4.0-8B 在 MMLU、CEval、MATH500、HumanEval 等 AI 领域流行的基准测试中,性能对标 Qwen-3-8B,超越 Gemma-3-12B。

面向更多端侧设备的小体量语言模型 MiniCPM 4.0-0.5B,可以实现每秒 600 token 的高速推理,性能也超越了 Qwen-3 0.6B。

要知道,4 月刚推出的 Qwen3-0.6B 模型性能已经超越了 Gemma 4B。这样的以小打大让我们喜闻乐见,意味着未来更多应用可以用得起大模型。

为了进一步提升效能、适应更多场景,面壁为新模型设计了「高效双频换挡机制」,让模型能够根据任务特征自动切换注意力模式:处理长文本、深度思考任务时启用稀疏注意力以降低计算复杂度,在短文本场景下切换稠密注意力以确保精度,这样一来,就可以在不同任务上均实现高效响应。

MiniCPM 4.0 也大幅降低了长文本任务的缓存需求。在 128K 场景下,MiniCPM 4.0-8B 相较于 Qwen3-8B 仅需 1/4 的缓存存储空间。

此外,MiniCPM 4.0 进一步提高了运行效能。从算法、系统到硬件推理,它是首个打通端侧全链条自研的大模型,真正做到了可落地的系统级软硬件稀疏化。

基于 MiniCPM-4.0,面壁智能继续强调其面向应用端的优势:这代小钢炮模型已在英特尔、高通、联发科、华为昇腾等主流芯片平台上完成适配,可在 vLLM、SGLang、llama.cpp、LlamaFactory、XTuner 等开源框架部署,并加强了 MCP 支持,保证了模型应用的便捷性。

看起来在端侧小模型技术突破后,各家厂商手机、车机内置的 AI 端侧模型可能很快就会迎来一波更新,不少 App 要被「重写一遍」了。

强悍性能背后

面壁实现架构级创新

众所周知,最近一段时间 DeepSeek 引领了 AI 领域的技术突破,其 V3、R1 等模型在架构上的创新大幅提升了 AI 的深度思考能力。

如今,强推理、长文本处理等高阶能力已成为大模型应用的标配:只有在模型能够很好理解长文本结构和语义之后,生成的内容才能拥有更好的一致性;在应用上,长文本理解也意味着 AI 能够成为真正的「个人助理」,能够记住更多的个人信息上下文。

而只有把模型部署在端侧,才能降低 AI 反应的延迟,在保证个人数据安全的情形下构建起未来的智能化产品。

「如今的云端大模型技术在应用层面上还存在一些局限,我们使用它们就像是在用过去的搜索引擎,」面壁智能联合创始人、首席科学家刘知远表示。「如果说 AI 最终的目标是 AGI(通用人工智能),那么它的形态就应该会像钢铁侠里的贾维斯一样,知晓你的个人信息,了解你的偏好。这些事情都是需要大模型长期记忆来实现的。」

但另一方面,如何在端侧跑起这样的高智商 AI,成为了摆在工程师面前的新挑战。

在 MiniCPM-4 的技术报告中,面壁工程师们介绍了其对于端侧模型架构、训练数据、训练算法和推理系统四个关键维度的系统性创新。

在模型架构方面,面壁提出了 InfLLM v2,这是一种可训练的稀疏注意力层,能同时加速长上下文处理的预填充和解码阶段,在保持模型性能的同时,实现了高效的长文本处理。

对于长上下文内容处理来说,InfLLM 在 AI 领域已经获得了认可。去年 2 月,面壁智能联合创始人、清华刘知远团队发表的初代 InfLLM 讨论了稀疏注意力的改进。今年 2 月,DeepSeek 展示的长文本处理架构 NSA(Native Sparse Attention)也采用了相同思路,并在其论文中引用、对比了 InfLLM。

不过此前业内的方法对于短文本推理速度仍然较慢,InfLLMv2 的出现解决了短文本推理的短板,其混合稀疏注意力结构再次升级,改变了传统 Transformer 模型的相关性计算方式。它在对文本进行分块分区域处理后,会通过智能化选择机制,只需对最相关的重点区域进行注意力计算「抽查」。

相比于 v1 版本,InfLLMv2 构建了更精准的上下文查询机制,实现了高效的训练与推理算子,将稀疏度从行业普遍的 40%-50% 降至 5%,仅需 1/10 的计算量即可完成长文本计算,效率提高了一大截。

在推理层面上,MiniCPM 4.0 通过自研的 CPM.cu 推理框架、BitCPM 极致低位宽量化、ArkInfer 自研跨平台部署框架等技术创新实现端侧推理加速。

其中推理框架 CPM.cu 做到了稀疏、投机、量化的高效组合,实现了 5 倍速度提升。其中,FR-Spec 轻量投机采样类似于小模型给大模型当「实习生」,并给小模型进行词表减负、计算加速。通过创新的词表裁剪策略,让小模型专注于高频基础词汇的草稿生成,避免在低频高难度词汇上浪费算力,再由大模型进行验证和纠正。

BitCPM 量化算法,实现了业界 SOTA 级别的 4-bit 量化,探索了 3 值量化(1.58bit)方案。通过精细的混合精度策略和自适应量化算法,模型在瘦身 90% 后仍能保持出色性能。

ArkInfer 跨平台部署框架则面向多平台端侧芯片优化,实现了大平台的高效投机采样和限制编码,确保端侧多平台 Model zoo 丝滑使用。

在模型训练和数据层面,面壁提出了 UltraClean,一种高效准确的预训练数据过滤和生成策略,实现了 90% 的验证成本下降,其针对互联网语料建立了严格的准入机制,只有能够真实提升模型性能的数据才能被纳入预训练语料中。利用轻量化的 FastText 工具进行大规模数据质检,在工作流程中处理 15 万亿 token 数据仅需 1000 小时 CPU 时间。

面壁利用 UltraChat-v2 合成了百亿 token 的高质量对齐数据,针对知识类、指令遵循、长文本、工具使用等关键能力进行强化。

在 MiniCPM 4 系列中,面壁应用了「模型风洞」ModelTunnel V2,能够实现更高效的训练策略搜索。先在小模型(0.01B-0.5B)尺度上进行的训练实验,再迁移到更大的模型上。在 MiniCPM 4 上,面壁优化了小模型的搜索次数,相比于风洞 v1,只需一半的实验次数就能完成最优配置搜索。

在高质量数据与高效训练策略的加持下,相比同尺寸开源模型(Qwen-3 8B),MiniCPM 4.0 仅用 22% 的训练开销,就达到了相同的能力水平。

通过多维度的优化,MiniCPM 4 真正实现了行业内唯一的端侧全流程优化,成为了 AI 领域探索高效率语言模型的又一里程碑。

面壁报告说,通过进一步的适配,MiniCPM 4 成功支持了各种应用,包括可信调查问卷生成、基于模型上下文协议的工具使用,充分展现了其广泛的可用性。

今年是大模型应用爆发的一年,作为创业公司的面壁坚持构建基座模型,为未来的智能端侧应用打好了基础。

面壁的高效率模型探索

DeepSeek 之外的另一条路径

随着大模型技术竞争螺旋上升,扩展定律(Scaling Laws)驱动的方式已进入深水区。一方面模型越来越大的参数量正在撞向算力、并行化的瓶颈,另一方面参与训练的数据体量也在挑战着各家公司的获取与处理能力。在这样的情况下,长期钻研模型新形态的一小部分玩家逐渐站到了台前。

国内 AI 创业队伍中,DeepSeek 已经因为 V3、R1 大模型的创新推动了全球大模型技术的一轮进步,而在端侧模型这一方向上,受到目光聚焦的一直是面壁。

有趣的是,面壁与 DeepSeek 走的都是从硬件协同优化开始,全流程的高效率强推理大模型道路。与 DeepSeek 着重强化模型能力上限,云端部署方向不同的是,面壁团队一直以来不断探索针对端侧的稀疏化方案。

提升 AI 效率,降低使用成本,是面壁智能成立的初衷。随着 Transformer 架构成功,语言模型规模不断扩大,人们一直在寻求更有效的模型范式,模型稀疏化被认为是一种很有前途的解决方向。面壁是国内最早探索稀疏化道路的团队,其研究一直在引领业界。

早在 2019 年,面壁创始团队就开始探索稀疏 FFN 方面的工作,其研究被谷歌、苹果等公司跟进。

2021 年 6 月,该团队参与发布了千亿参数级高效易用大模型 MoE 大模型 CPM-2 。同年,面壁团队在《MoEfication:Transformer Feed-forward layers are Mixtures of Experts》工作中提出将稠密模型转化为等参数量的 MoE 模型能够实现大幅度推理加速。

2024 年 7 月,面壁开源了 MiniCPM-S 模型,其采用稀疏激活的方式,能够在同等参数条件下减少大模型的推理能耗。

去年底,清华、面壁团队又提出了类脑高效稀疏架构 Configurable Foundation Model,革新了以往的 MoE 架构,强调将大模型根据功能拆解为若干模块,通过模块的检索、组合、更新、增长实现复杂能力。从实现的效果上看,新架构对于大模型「知识密度」提升显著,也对端侧模型低能耗推理能产生了推动作用。

从更广泛的角度看,虽然科技巨头纷纷在为大模型加码云端算力设施,但能将先进模型部署在端侧,引入全球超过 70 亿智能手机,以及未来的 AI PC、智能车机,其重要性同样不言而喻。

有趣的是,在最近一系列研究中,面壁研究人员已经总结出了大模型的密度定律「Densing Law」,认为随着技术的不断演进,语言模型的能力密度平均每 100 天翻一番,人们还可以不断训练出计算更加高效,性能更加强大的基础大模型。

MiniCPM-4.0 将 A I 能力密度推进到了更高的节点,与 DeepSeek R1 在模型能力上的高点遥相呼应。

朝着这个方向,面壁计划会在近期继续推出更多 MiniCPM 系列基础模型,以及多模态模型。

下一代小钢炮,还会为我们带来更大的惊喜。

....

#SLOT

无需SFT也不用RL,样本级推理优化神器SLOT来了,准确率轻松+10%

近期,当很多人还在纠结用什么 label 和 reward 训练大模型的时候,以及纠结用什么样的基准模型进行公平比较的时候,西湖大学 MAPLE 实验室另辟蹊径:既然 LLM 在复杂指令上表现不佳,需要引入单独的 SFT 或者 RL 过程,那为什么不让模型在推理时「临时学习」一下这个具体的问题呢?这个看似「离谱」的想法,竟然带来了惊人的效果提升。

试想一下,如果你参加考试时,可以在答题前花几秒钟「适应」一下这道具体的题目,你的表现会不会更好?

这正是西湖大学研究团队在最新论文中提出的核心思想。他们开发的 SLOT(Sample-specific Language Model Optimization at Test-time)方法,把每个输入 prompt 本身当作一份「迷你训练数据」,让模型在生成答案前先「学习」理解这个具体问题。

更令人惊讶的是,这个方法简单到离谱:

只需要优化一个轻量级参数向量 delta(仅修改最后一层特征)

只需要几步 (比如 3 步) 梯度下降

计算开销几乎可以忽略不计(仅增加 7.9% 推理时间)

完全即插即用,无需修改原模型

- 论文标题:SLOT: Sample-specific Language Model Optimization at Test-time

- 论文地址:https://arxiv.org/pdf/2505.12392

- GitHub地址:https://github.com/maple-research-lab/SLOT

效果炸裂

多项基准测试刷新纪录

即便拿最有挑战性的高性能基线做比较对象,实验结果令人瞩目 (所有 log 都在开源 github 里):

- Qwen2.5-7B 在 GSM8K 数学推理任务上准确率从 57.54% 飙升至 66.19%,提升 8.65 个百分点。

- DeepSeek-R1-Distill-Llama-70B 在 GPQA Diamond 上达到 68.69%,创下 70B 级别开源模型新纪录

- 在高难度的 AIME 2024 数学竞赛题上,多个模型实现 10% 以上的提升

核心创新

把 Prompt 当作「测试时训练样本」

传统的 LLM 在面对复杂或特殊格式的指令时经常「翻车」,它可能会忽略格式要求或给出错误答案。

SLOT 的解决方案优雅而简单:针对单独一个问题,直接在最后一层特征上加一个 delta 向量,并在问题 prompt 本身上最小化交叉熵损失即可。

由于仅仅需要在最后一层上优化一个加性的 delta 参数向量,每个问题只需要经过一次网络推理。通过把输入给最后一层的中间结果进行缓存,优化 delta 的过程几乎不需要增加计算开销。

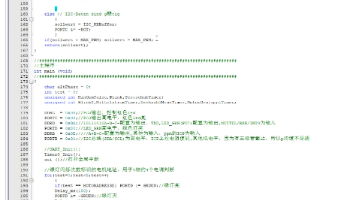

由于方法十分简单,任何伪代码公式都多余,这里给出如何把 SLOT 应用于你的工作的 transformers 版本代码(vLLM 版本也已开源)。

以 modeling_qwen.py 里 Qwen2ForCausalLM 模型为例,研究团队在 forward 函数里获得 hidden_states 之后插入这段代码:首先初始化一个全 0 的 delta 向量,加在 last hidden states 上;然后用当前的 prompt 作为训练数据,delta 作为可学习参数,以交叉熵损失优化,得到 sample-specific 的 delta 参数;之后即可用优化好的 delta 生成后续 token。

为什么如此有效?

深入分析揭示秘密

研究团队通过分析发现,SLOT 优化后的 delta 会显著调整输出词汇的概率分布:

- 增强的词汇:reasoning、think、thinking 等推理相关词汇

- 抑制的词汇:数字符号(0-9)、模态动词(should、will)、结束符 </s>

这意味着 SLOT 在鼓励模型「深思熟虑」,避免过早结束推理或陷入表面的模式匹配。

亮点在于:不同于 SFT 或者 RL 的微调算法,该方法无需:

- 修改模型架构

- 额外的训练数据

- 复杂的采样策略

- 昂贵的计算资源

广泛适用

从 1.5B 到 70B,从基础模型到推理专家

SLOT 在各种规模和类型的模型上都展现出稳定的提升:

- Qwen 系列:1.5B 到 32B 均有提升。

- Llama 系列:包括 Llama-3.1。

- DeepSeek-R1 系列:即使是已经专门优化过推理能力的模型,仍能获得显著提升。

特别值得注意的是,在最具挑战性的任务上,SLOT 的提升最为明显:

- C-Eval Hard 子集:+8.55%

- AIME 2024:部分模型提升超过 13%

- GPQA Diamond: 由 65.66 提升到 68.69 (开源 sota 级别)

结语

在大模型时代,当所有人都在追求「更大、更强」时,SLOT 用一个简单得「离谱」的想法证明:有时候,让模型在回答前先「理解」一下问题,就能带来惊人的效果。

....

#Temporal-Spectral-Spatial Unified Remote Sensing Dense Prediction

遥感数据任务统一!国内学者提出首个“时间-光谱-空间”维度统一的遥感密集预测模型TSSUN本篇分享论文《Temporal-Spectral-Spatial Unified Remote Sensing Dense Prediction》,南大、上海交大联合上海人工智能实验室提出首个时间-光谱-空间维度统一的遥感密集预测模型TSSUN,代码已开源。

论文链接:https://arxiv.org/abs/2505.12280

代码链接:https://github.com/walking-shadow/Official_TSSUN

随着遥感技术的不断进步和数据采集方法日益多样化,遥感领域已进入快速发展阶段。海量、多源的遥感数据被广泛应用于各种密集预测任务,在语义分割、语义变化检测和二元变化检测任务中大放异彩。然而,遥感影像在时间、光谱和空间三个关键维度上表现出高度的异质性,由于在实际应用中时间序列长度、光谱通道数量和空间分辨率的变化,给统一处理带来了巨大挑战。

从任务角度看,遥感领域的密集预测主要包括三类核心任务:语义分割、语义变化检测和二元变化检测。这些任务可以形式化地定义如下:给定一个形状为 (T1,C1,H1,W1) 的遥感影像,深度学习模型应生成一个形状为 (T2,C2,H2,W2) 的预测结果。其中,T1 和 T2 分别表示输入和输出的时间长度,C1 是输入通道数,C2 是输出类别数,而 (H1,W1) 和 (H2,W2) 分别代表输入和输出的空间维度,通常情况下 H1=H2 且 W1=W2。

- 在 语义分割 中,模型对单个时间点的影像进行多类别地物提取,对应于 T2=1 和 C2≥2。

- 在 语义变化检测 中,模型提取每个时间点的地物信息以分析任意两个时间点之间的语义差异,对应于 T2=T1 和 C2≥2。

- 在 二元变化检测 中,模型识别相邻时间点之间是否发生变化,对应于 T2=T1−1 和 C2=2。

近年来,在日益丰富的遥感数据支持下,深度学习方法在密集预测任务中取得了显著成功,催生了各类任务中众多高性能模型。然而,现有模型通常是为固定的输入输出配置设计的,即特定的 (T1,C1,H1,W1) 和 (T2,C2,H2,W2)。这些维度中任何一个的微小变化都可能导致模型性能显著下降甚至完全不兼容。具体来说,T1、C1 和 (H1,W1) 的变化反映了遥感数据在时间-光谱-空间(Temporal-Spectral-Spatial, TSS)维度上的多样性;T2 的变化对应于不同的任务类型;而 C2 的差异则与不同的分类需求相关。鉴于遥感应用在这些维度上常常存在差异,在一个场景下训练的模型通常难以泛化到其他场景,需要额外的训练或微调,这带来了巨大的计算和时间成本。

为了解决这些问题,本研究提出了一个时间-光谱-空间统一网络(Temporal-Spectral-Spatial Unified Network, TSSUN),该网络能够实现遥感数据在时间、光谱和空间维度上的统一表示和建模,如下图所示。TSSUN具有高度的灵活性,能够处理任意组合的 (T1,C1,H1,W1) 输入和 (T2,C2,H2,W2) 输出。它支持不同时间长度、光谱波段和空间分辨率的输入和输出,并统一了所有三种密集预测任务。此外,它还能生成任意数量语义类别的输出,并在各种配置下保持强大的性能。

具体而言,引入了时间-光谱-空间统一策略(Temporal-Spectral-Spatial Unified Strategy, TSSUS)来解耦和统一TSS维度上的输入和输出表示。在输入阶段,TSSUS利用固有的光谱和空间特性实现遥感影像的统一编码。在输出阶段,TSSUS利用遥感密集预测任务在光谱和空间维度上的结构化特性,通过建模类间相关性实现对任意类别数的预测。

为了进一步提升模型捕捉多样化TSS组合的能力,设计了一种局部-全局窗口注意力(Local-Global Window Attention, LGWA)机制。该模块通过三个不同形状的重叠窗口注意力块高效提取局部特征,并由一个全局注意力块在全局层面聚合信息。这种设计在计算效率和表达能力之间取得了平衡,实现了局部和全局特征的协同建模。

总之,本工作的主要贡献如下:

- 提出了一个时间-光谱-空间统一网络(TSSUN),实现了遥感密集预测在时间、光谱和空间维度上的统一建模。TSSUN支持任意TSS输入输出配置,并能适应语义分割、语义变化检测和二元变化检测等多种任务,同时支持灵活的输出类别设置。

- 设计了一种局部-全局窗口注意力(LGWA)机制,以有效捕捉局部和全局上下文特征,从而提升模型在各种遥感预测任务中的性能。

- 在多个具有不同TSS配置的建筑和土地利用/覆盖场景的数据集上进行了广泛实验。结果表明,单个TSSUN模型能够适应异构输入,统一多种任务类型和灵活的输出类别设置,并持续达到或超越最先进的性能。

方法问题定义

遥感领域的密集预测任务通常指在像素级别对输入影像进行结构化的语义推断。本研究将语义分割、语义变化检测和二元变化检测这三个典型任务统一表述为一个张量映射问题。设输入遥感影像为一个四维张量 ,其中 T1 表示时间序列长度,C1 代表光谱通道数,H1 和 W1 分别是影像的高度和宽度。模型输出表示为张量 ,其中 T2 代表输出时间维度,C2 是语义类别数,H2 和 W2 为输出影像的空间维度。

基于此表示,本研究涉及的三个任务可统一描述如下:

- 语义分割: 模型对给定时间点的遥感影像进行像素级多类别分类。对应设置 T1=1,T2=1 和 C2≥2。

- 语义变化检测: 模型预测每个时间点的语义标签,以分析任意两个时间点间的语义变化。对应设置 T2=T1 和 C2≥2。

- 二元变化检测: 模型检测连续时间点之间是否发生变化,而不区分具体的变化类别。对应设置 T2=T1−1 和 C2=2。

为应对输入数据在时间长度 T1、光谱通道 C1 和空间尺度 (H1,W1) 上的显著差异,提出了一个统一的建模框架,旨在学习一个映射函数 θ ,使得:

θ

该函数能够适应任何输入配置,并输出满足目标任务要求的密集预测结果。

时间-光谱-空间统一网络(TSSUN)概览

所提出的时间-光谱-空间统一网络(TSSUN)是一个统一的建模框架,如下图所示。TSSUN采用TSSUS策略,将输入对齐、特征提取和输出解码系统地整合到一个连贯的处理流程中。

- 输入阶段: 引入光谱-空间统一模块(Spectral-Spatial Unified Module, SSUM),将异构的光谱和空间数据编码为统一的表示。

- 特征提取阶段: 采用局部-全局窗口注意力(LGWA)机制作为主要的特征建模单元,有效捕捉TSS输入中的多尺度特征。

- 编码器-解码器连接处: 融合时间统一模块(Temporal Unification Module, TUM),专注于时间特征的融合,根据任务需求调整输出的时间长度。

- 输出阶段: 再次引入SSUM,在解码过程中进一步加强光谱-空间的一致性,实现对任意类别数和多分辨率空间重建的统一建模。

时间-光谱-空间统一策略 (TSSUS)

TSSUS旨在解耦和统一时间、光谱和空间维度上输入和输出的表示。为实现从原始数据空间到不同维度统一特征空间的映射,TSSUS引入了维度统一模块(Dimension Unified Module, DUM),它是TUM和SSUM的基础实现。DUM利用TSS变量子集的元数据为线性层生成自适应的权重和偏置,从而实现自适应的特征映射。如上图的右上子图所示,给定输入张量 及其元数据 ,DUM通过超网络生成过程将输入张量映射为统一特征 。其详细流程如下:

- 元数据嵌入: 对元数据 M 进行位置编码和词元化,并前置一个可学习的类别词元[CLS]。

- 跨变量关系建模: 词元序列通过多个Transformer块处理,以捕捉元数据词元间的潜在关系。

- 自适应参数生成: [CLS]词元被线性投影以生成偏置参数 ,而其余词元被投影以产生权重矩阵 。生成的 W 和 b 构成一个线性层,将输入 X 从 (D1,H,W) 重塑为 (L,D1) 后,通过该线性层处理,得到形状为 (L,D2) 的输出。

局部-全局窗口注意力 (LGWA)

为解决全局注意力在处理大规模遥感数据时计算复杂度高且忽视局部特征的问题,本研究提出了局部-全局窗口注意力(LGWA)模块。LGWA采用三种可选的、具有不同尺寸和配置的窗口注意力形状,能够同时提取遥感图像的局部和全局特征,能够有效的进行遥感密集预测任务,如下图所示。

实验与结果

为验证TSSUN对任意时间-光谱-空间输入输出的适应性,及其并发执行语义分割、语义变化检测和二元变化检测任务并支持可变输出类别数的能力,在建筑和土地覆盖/土地利用分类(LULC)两大场景下的总共六个数据集上进行了实验。对于每个场景,使用该场景内所有数据集的组合训练集来训练一个统一的TSSUN模型,并在它们各自的测试集上评估其性能。

在 建筑场景 中,选择了WHU、WHU-CD、LEVIR-CD和TSCD数据集。这些数据集在输入和标签数据的通道数上相同,但在时间和空间维度上存在差异,导致了密集预测任务类型的不同,具体如下表所示。建筑场景下的多数据集实验主要旨在验证TSSUN在该情境下对任意时空维度输入输出的适应性,并确认其同时处理语义分割、语义变化检测和二元变化检测任务的能力。

在 LULC场景 中,选择了LoveDA Urban和Dynamic EarthNet数据集。这些数据集在输入和标签数据的时间、光谱维度上均有不同。LoveDA Urban数据集对应于一个7类LULC的单时相语义分割任务,而Dynamic EarthNet数据集则用于多时相的语义变化检测、语义分割和二元变化检测任务,包含6个LULC类别,详见下表。LULC场景的数据集主要用于验证TSSUN对任意时谱维度输入输出的适应性,并证明其在支持灵活输出类别数的同时,并发管理语义分割、二元变化检测和语义变化检测任务的能力。

整体比较建筑场景

在四个基准遥感数据集上对所提出的TSSUN进行了严格评估:用于单时相语义分割的WHU数据集,用于双时相语义变化检测的WHU-CD数据集,用于双时相二元变化检测的LEVIR-CD数据集,以及用于多时相二元变化检测的TSCD数据集。TSSUN与几种最先进的方法进行了比较,定量结果总结在下面四张表中。

- 在WHU数据集上,如上表所示,TSSUN获得了最高的IoU(91.00%)和F1分数(95.29%)。

- 对于WHU-CD数据集上的双时相语义变化检测任务,TSSUN表现出领先于其他SOTA方法的性能,如下图所示。

- 在LEVIR-CD数据集上,下图显示TSSUN取得了最高的F1分数(91.59%)和IoU(84.49%)。

- 最后,在TSCD数据集上,TSSUN取得了最佳结果,如下图所示所示,F1分数为66.48%,IoU为49.79%。

LULC场景

在LoveDA和DynamicEarthNet这两个具有挑战性的LULC数据集上,对所提出的TSSUN与SOTA方法进行了严格评估。

- 在LoveDA数据集上,TSSUN表现出卓越的性能,取得了最高的OA(71.82%)和mIoU(65.73%),如下图所示。

- 对于多时相的DynamicEarthNet数据集,TSSUN再次超越了现有方法,在所有报告的指标上均取得了最高分:SCS分数为29.9,BC为38.9,mIoU为54.7,如下图所示。

....

#VILA‑U

LLM 自回归做理解,MaskGIT 方案做生成!一个模型搞定图像理解、视频理解和生成,简洁而强大

LLM 自回归做理解,MaskGIT 方案做生成的生成理解统一模型。

VILA-U 是一个可以做图像文本理解,视频文本理解,图像生成和视频生成的 Unified Model。VILA-U 的主要贡献是提出了一种视觉架构 Unified Foundation Vision Tower,这是一种针对 image 的 tokenizer。它的训练过程除了用于图像重建的 Reconstruction Loss 之外,还有针对图像理解的图文 Contrastive Loss。相比于其他的视觉 tokenizer 而言,VILA-U 训练的 Unified Foundation Vision Tower 不但针对视觉生成,还针对视觉理解任务。此外,VILA-U 所有的 token 都采用了 Unified Model 常用的 Next-Token Prediction 的训练模式,使用统一的训练目标。

1VILA-U:生成理解统一模型视觉侧引入文本对齐

论文名称:VILA-U: a Unified Foundation Model Integrating Visual Understanding and Generation (ICLR 2025)

论文地址:https://arxiv.org/pdf/2409.04429

项目主页:https://github.com/mit-han-lab/vila-u

1.1 VILA-U 模型

结合视觉和语言模式的一个方向是多模态理解,另一个重要研究方向是视觉生成。文本引导图像生成有 2 种流行的方法。一种方法是使用 Diffusion Model。另一种方法通过 Vector Quantization (VQ) 将视觉内容转换为 discrete tokens,然后利用自回归 Transformer 进行高质量和多样化的生成。

一个新兴趋势是将这些技术统一到一个多模态框架中。有 2 种实现这种统一的主要方法。许多 VLM[1]维护一个面向理解的框架,并将生成任务卸载到外部扩散模型中。这种不相交的方法增加了基础设施设计的复杂性。可用的大规模基础模型的 training pipeline 和 development system 已经针对 Next Token Prediction 的模型进行了高度优化。设计一个新的堆栈来支持扩散模型会产生重大的工程成本。为了规避这样的成本,现在的趋势是设计一个端到端的自回归框架。VLM 的趋势采用 VQ Encoder 将视觉输入转换为 discrete tokens,并以与语言数据相同的 Next Token Prediction 的方式处理视觉 token。但是,用 VQ token 替换连续 token 通常会导致下游视觉感知任务的严重性能下降。

如图 1 所示,VILA-U 是一个端到端的自回归框架,对于视觉和文本输入具有统一的 Next Token Prediction 训练目标。VILA-U 是一种生成理解统一架构,在视觉语言理解和生成任务上取得具有竞争力的性能,同时不需要借助扩散模型等外部组件。

VILA-U 确定关键的 2 点:

- 现有端到端 VLM 视觉理解性能不佳的原因是:discrete VQ tokens 只在 Reconstruction Loss 上训练,与文本输入不对齐。因此,在 VQ vision 模型预训练中引入文本对齐以增强感知能力至关重要。

- 如果在具有足够大小的高质量数据语料库上进行训练,自回归图像生成可以获得与扩散模型相似的质量。

基于这 2 点,VILA-U 的 vision 模型通过 vector quantization 将视觉输入转化为 discrete token,并且使用 Contrastive Learning 将这些 token 与文本输入对齐。

1.2 VILA-U 的视觉模型

VILA-U 的关键之一是视觉架构 Unified Foundation Vision Tower,它将视觉输入转换为与文本对齐的 discrete token。也就是说,Unified Foundation Vision Tower 在训练的时候,考虑了图像与文本的对齐。VILA-U 的另一个关键之一是统一的多模态生成式训练方案。VILA-U 的方案如图 1 所示。视觉输入被 tokenized 成 discrete tokens,与 text token 拼接在一起,形成多模态的输入序列。所有的 token 都按照 next-token prediction 训练。推理的时候,文本 token 使用 text detokenizer 输出,视觉 token 使用 vision tower decoder,形成多模态输出。

图1:VILA-U 的训练和推理。视觉输入被 tokenized 成 discrete tokens,与 text token 拼接在一起,形成多模态的输入序列。所有的 token 都参与 next-token prediction 过程,使用统一训练目标。推理的时候,文本 token 使用 text detokenizer 输出,视觉 token 使用 vision tower decoder

为了支持视觉理解和生成任务,VILA-U 首先构建了一个 Unified Foundation Vision Tower 来获取视觉特征。

在训练中,VILA-U 使用了 1) 文本-图像之间的 Contrastive Loss,2) 基于 Vector Quantization 的图像 Reconstruction Loss。使得 Unified Foundation Vision Tower 同时具有文本对齐和 discrete tokenization 的能力。

如下图 2 所示,从图像中提取的特征主要是通过 Residual Quantization 离散化的。一方面,离散的视觉特征输入解码器来重建图像并计算重建损失;另一方面,离散视觉特征与文本编码器提供的文本特征之间计算图像-文本对比损失。

图2:Unified Foundation Vision Tower 设计。vision encoder 提取的图片特征首先使用 residual quantization 被离散化,然后离散的视觉特征放到 vision decoder 中 1) 重建图像,2) 进行图文对齐。在此过程中,Reconstruction Loss 和 Contrastive Loss 更新其参数。最后它可以得到图文对齐的离散特征

但是,在实践中作者发现直接这样训练有问题 (对比损失和重建损失的直接组合不能收敛)。因为图文对齐和重建任务分别需要高级语义特征和低级外观性特征。使用 2 个目标从头开始训练可能会导致相互冲突的目标。从头开始训练 Unified Foundation Vision Tower 导致ImageNet 上 Zero-Shot 图像分类的 Top-1 精度仅为 5%。

为此,作者尝试了不同的 training recipe。本文使用的 training recipe 不是同时学习 2 个目标,而是首先为模型配备文本图像对齐能力,然后在保持对齐能力的同时学习重建。作者使用 CLIP 预训练权重初始化 vision encoder 和 text encoder,以确保良好的文本图像对齐。接下来,冻结文本编码器,并保持所有视觉模型使用 Contrastive 和 Reconstruction Loss 训练。这种训练方法收敛很快并产生强大的性能。预训练的 CLIP 权重包含高级先验,对于从头开始学习来说既困难又计算成本高。使用这些权重进行初始化可以使视觉编码器更快、更轻松地结合低级和高级特征。通过这种训练配方,可以有效地训练出具有良好文本对齐和图像重建的视觉模型。具体而言,使用加权和来组合图文对比损失和 VQ 图像重建损失:

\text { 其中,} w_{\text {contra }}=1, w_{\text {recon }}=1 \text { 。 }

Residual Vector Quantization

VILA-U 的视觉特征是离散化,因此其表征能力在很大程度上取决于 Quantizer Codebook 的大小。由于希望它们同时包含高级特征和低级特征,因此向量特征空间中需要更多的容量,需要 Codebook 比较大。

VILA-U 按照 RQ-VAE[2]的做法使用 Residual Vector Quantization,把一个向量 \mathbf{Z} 离散化成 D 个 discrete tokens:

其中, 是 codebook, 和 是向量 在深度 时的 code 值。从 开始,对每一维度深度 递归地执行向量量化:

其中, e 为 codebook embedding table, 是标准向量量化。

其中, 的 Quantized Vector 是所有深度的求和: 。

1.3 生成式预训练

图 1 为 VILA-U 多模态预训练过程。视觉编码器按顺序处理视觉输入,生成一个一维 token 序列。然后将这个序列与文本 token 连接起来形成一个多模态序列。为了区分模态并实现视觉内容生成,在图像 token 的开始和结束处插入特殊标记:<image_start> 和 <image_end>,在视频 token 的开始和结束位置插入 <video_start> 和 <video_end>。视频 token 是多帧图像标记的直接连接。

预训练数据格式

[image, text], [text, image], 和 [text, video],只把 supervision loss 加到后面的模态数据。

还使用交错 text 和 image 连接形式来增强理解,supervision loss 仅应用于 text。

出于效率原因,在预训练期间排除了 [video, text] 形式,因为发现在 supervised fine-tuning 期间结合它可以有效地产生出色的视频理解能力。

训练目标

对于 text tokens,使用:

\text { 其中,} T \text { 是多模态序列的总长度,} i \text { 只计算 text token 存在的位置。 }

对于 visual tokens,使用:

其中, 是多模态序列的总长度, 只计算 visual token 存在的位置。按照 RQ-VAE[2] 的做法使用一个 depth transformer 自回归地预测 个 residual tokens。

1.4 VILA-U 实验设置

语言模型:LLaMA-2-7B

视觉模型:SigLIP-Large-patch16-256 / SigLIP-SO400M-patch14-384

Residual Quantizer, depth transformer:按照 RQ-VAE 做法

Codebook 尺寸:16384

Image 尺寸:256×256 / 384×384

discrete 尺寸:16×16×4 / 27×27×16 (D = 4 / D = 16)

Unified Foundation Vision Tower 训练数据集:COYO-700M,评测数据集:ImageNet-1K Zero-Shot

训练数据:

多模态理解:ShareGPT4V 1M [image, text] 数据,MMC4 6M interleaved text image 数据,

视觉生成:内部 15M high-quality [text, image] 数据,OpenVid 1M [text, video] 数据

1.5 VILA-U 实验结果

Unified Foundation Vision Tower

图 3 展示了 ImageNet 上 Zero-Shot 图像分类 Top-1 精度以及重建 FID (rFID),以衡量模型的重建和文本对齐能力。模型实现了比 VQ-GAN 更好的重建结果。rFID 略逊于 RQ-VAE,这是意料之中的,因为在训练期间引入对比损失,目的是增强图像理解,但会导致重建质量下降。

图3:ImageNet 上 Zero-Shot 图像分类的 Top-1精度和重建 FID (rFID)

多模态理解

图 4 和 5 分别总结了 VILA-U 在图像语言和视频语言基准上与其他 VLM 之间的比较。与 CLIP 等基础模型产生的 continuous 的视觉 token 的主流选择相比,基于 VQGAN 的 discrete 的视觉 token 与文本对齐较少,因此损害了 VLM 在视觉理解任务上的性能。通过本文的 unified foundation vision tower,即使使用 discrete 的视觉 token,VILA-U 也可以接近领先的 VLM 性能。

图4:visual language benchmark 实验结果 (image)

图5:visual language benchmark 实验结果 (video)

视觉生成

如图 6 和 7 所示,VILA-U 可以实现比其他自回归方法更好的 FID,并且与一些基于扩散模型的方法相当的性能。图 7 展示了 GenAIBench 上和其他视觉生成方法的定量结果。尽管 VILA-U 不如在数十亿级图像-文本对上训练的基于扩散模型的方法,但 VILA-U 在高级提示上具有与 SD v2.1 和 SD-XL 相当的性能。这进一步表明,VILA-U 可以有效地有效地学习视觉和文本模态之间的相关性。

图6:MJHQ-30K evaluation benchmark 实验结果

图7:GenAI-Bench 实验结果

图 8 和 9 展示了 VILA-U 在一些视觉理解任务的示例。

图8:VILA-U 可以正确字幕视频并涵盖所有细节

图9:VILA-U具有良好的视觉问答能力

VILA-U 也继承了 VILA 的一些重要能力,包括多图像理解,如图 10 所示。

图10:VILA-U 可以正确地对多个图像进行推理

图 11 展示了 VILA-U 的视觉生成结果的示例。可以看到,VILA-U 可以用于图像生成和视频生成,即使使用相对较小的数据语料库进行训练。

图11:VILA-U 可以在给定文本输入的情况下生成高质量的图像和视频

参考

- Generative Pretraining in Multimodality

- Autoregressive Image Generation using Residual Quantization

....

#端侧模型全开放、AI版Siri却成最大「鸽」王

刚刚,苹果WWDC掀AI重构风暴!

今年的苹果,到底有没有新活?

北京时间今天凌晨 1 点,一年一度的「科技圈春晚」—— 苹果全球开发者大会 WWDC 在 CEO 蒂姆・库克的演讲中拉开了序幕!

此次大会,苹果宣布了一系列操作系统、服务和软件的更新,其中包括全新的系统命名规则以及名为液态玻璃( Liquid Glass)的新设计语言。

根据库克的说法,苹果对自身操作系统的命名方式(确切地说是编号方式)进行了全面改革,不再以版本号来排序,而是以年份(而且是 2026 年)来命名。

具体是这样的:今年的 iPhone 将搭载 iOS 26 系列,Mac 将搭载 macOS Tahoe 26。此外,连同 iPadOS 26、watchOS 26、tvOS 26 和 visionOS 26 一起构成了完整的系统。未来,这些数字将随年份变更,方便用户判断 Apple 设备是否运行了最新版本的软件。

iOS 26 设计界面

那么率先变更规则的 26 系列有哪些特点呢?苹果展示的一大亮点是全新的「液态玻璃」设计语言,为应用界面带来流畅的半透明和玻璃板的光泽。

该设计灵感源自 Vision Pro 增强现实设备上的 visionOS,可以自适应明暗模式,并通过实时渲染对运动做出动态响应。

全新设计将应用于按钮、滑块、媒体控件以及标签栏和侧边栏等较大的元素,同时还将采用重新设计的工具栏和导航栏。

苹果人机界面设计副总裁 Alan Dye 在发布会上表示,这是该公司自 2013 年推出 iOS 7 以来最大规模的软件设计革新。

面向第三方软件的适配,苹果正在发布更新的应用程序编程接口 (API),以便开发者能够在今年晚些时候新设计发布之前开始调整他们的应用。

新系统上的 Apple Intelligence 能做些什么?

AI 是本次发布的重中之重,被提到了演讲的第一部分进行介绍。

苹果展示了把人工智能融入其所有产品的计划,提供从通话实时翻译到 AI 识物、智能搜索等一系列能力。

随着 ChatGPT 的引入,Apple Intelligence 提升了 iPhone 端的智能体验,帮助用户比以往更轻松地完成工作,同时开启了全新的沟通方式,并利用屏幕上的内容实现更多功能。

其中,实时翻译(Live Translation)功能已集成到信息、FaceTime 和电话中,帮助用户跨语言沟通,即时翻译文本和语音。实时翻译由苹果自主研发的模型支持,这些模型完全在设备上运行,因此用户的个人对话始终保持私密。

实时语音翻译。

苹果表示,实时翻译功能将在 iPhone、Mac、Apple Watch 和 iPad 上提供,即使用户佩戴 AirPods 也能使用。

基于 Apple Intelligence,视觉智能将扩展到用户的 iPhone 屏幕,方便用户在各个 app 中搜索和操作正在浏览的内容。如果我们在手机上看到了特定衣服的图片,可以截图搜索,让 AI 找同款。

用户可以向 ChatGPT 询问他们正在屏幕上查看的内容以了解更多信息,还可以搜索 Google、Etsy 或其他支持的 app,查找类似的图片和商品。

视觉智能还能识别用户何时正在查看某个活动,并建议将其添加到日历中,并重新填充日期、时间和地点等关键信息。

识别物体并跳转到购物网站。

快捷指令(Shotcuts)现在比以往任何时候都更加强大和智能。

苹果提供了一整套由 Apple Intelligence 支持的全新快捷指令(称为智能操作),使用户可以体验写作工具( Writing Tools)和影像乐园(Image Playground)等功能的专属操作。

开发者们也可以在自己的 App 上接入这样的能力。

不过总体来说,今年 WWDC 上苹果推出的一系列 AI 能力看来是属于较为温和的改进 —— 苹果并不急于搬出一个杀手级应用,而是希望 Apple Intelligence 能够让所有涉及用户交互的工具都变得更智能、更实用。

不过增强版的 Siri 仍在跳票中。

端侧模型向第三方 App 开发者开放

既然号称「全球开发者大会」,此次苹果也为开发者们提供了一系列福利。

苹果面向开发者开放了端侧大模型的访问权限,允许任何 App 都能直接利用 Apple Intelligence 核心的端侧基础模型。

借助 Foundation Models 框架,App 开发者将能够在 Apple Intelligence 的基础上,利用免费的本地 AI 推理,为用户带来智能、离线可用且保护隐私的全新体验。

例如,教育类 App 可以使用端侧模型,根据用户的笔记生成个性化测验,无需任何云 API 成本;户外类 App 则可以添加自然语言搜索功能,即使在用户离线时也能使用。

该框架原生支持 Swift,因此 App 开发者只需三行代码即可轻松访问 Apple Intelligence 模型。同时,引导式生成、工具调用等功能均内置于框架中,让开发者能够更轻松地将生成功能直接集成到现有应用中。

在社媒 X 上,基础模型框架团队也开始推介他们的产品,表示该框架是开发者访问端侧 LLM 的 API。

为新版本 Xcode 带来更强大生成式 AI

此次,苹果发布了其应用开发套件 Xcode 的全新版本 ——Xcode 26,提供了丰富的智能功能和体验,助力开发者将创意变为现实。

利用新套件,开发者可以将大语言模型直接嵌入到他们的编程体验中,来编写代码、测试和撰写文档;同时可以实现迭代设计、修复错误等功能。

Xcode 26 内置了对 ChatGPT 的支持,开发者可以使用其他提供商的 API 密钥,或者在搭载苹果芯片的 Mac 上运行本地模型,从而选择最适合自身需求的模型。

此外,开发者无需创建帐户即可在 Xcode 中使用 ChatGPT,订阅用户也可以连接他们的帐户以访问更多请求。

编码工具(Coding Tool)可以帮助开发者保持专注,并提高工作效率。开发者可以从代码中的任何位置访问编码工具,它提供操作建议,例如生成预览或 Playground、修复问题等,还可以直接内联处理其他任务的特定提示。

另外,Xcode 26 还提供了一些附加功能,包括重新设计的导航体验、本地化目录的改进以及对语音控制的改进支持,以便通过语音控制来处理 Swift 代码并完全通过语音导航到 Xcode 界面。

鸽了的 AI 版Siri

虽然 Apple Intelligence 功能进行了一系列升级,但苹果并没有带来备受用户期待的 Siri 升级。在去年的 WWDC 大会上,更具个性化、交互更自然、由人工智能驱动的 Siri 首次亮相。

当时,苹果将其吹捧为「苹果的下一个重大举措」,并表示 Siri 将能够理解你的「个人上下文」,如你的人际关系、沟通方式、日常生活等等。此外,该语音助手将允许你在应用内部和跨应用执行操作,从而变得更加实用。

WWDC 2024。

此次大会上,苹果软件工程高级副总裁 Craig Federighi 在主题演讲中只是简短地提到了 Siri 的更新,他表示,「正如我们之前分享的,我们将继续努力,打造更个性化的功能,让 Siri 更加个性化。这项工作需要更长时间才能达到我们的高质量标准,我们期待在明年分享更多相关信息。」

显然,「明年」这个时间框架似乎表明了苹果在 2026 年之前不会发布任何消息。在新模型以及升级快速迭代的人工智能时代,Siri 无疑成为了一个重大的延迟。

此前 3 月,苹果正式宣布推迟上线 Siri 中的 AI 功能,称 Siri 更新的交付时间将比预期更长。此外,苹果还将机器学习和人工智能战略高级副总裁 John Giannandrea 从 Siri 项目中撤出,并由曾参与 Vision Pro 开发的 Mike Rockwell 负责。此次人事变动表明,在重大版本发布遭遇挫折后,苹果正努力重回正轨。

不过,种种举措也表明了苹果的人工智能技术落后于 OpenAI、谷歌和 Anthropic 等竞争对手,令投资者感到担忧。

在周一 WWDC 的演讲开始几分钟后,苹果的股价突然下跌,幅度多达 2.5%。当时苹果正在回顾 Apple Intelligence 功能,如 Genmoji、智能回复、照片清理工具等,随后话题又转到了 Siri 上。

可见人们对于苹果 AI 领域应用的进展仍不够满意。

对于今天苹果的发布,有网友表示很多新功能要么提升不大,要么近期不会上线,亦或是在国内无法使用,总体上并不令人感到惊艳。

或许 iPadOS 的桌面化、多任务能力更新是今年的最大亮点,它可能会在未来代替 MacOS。

在很多人眼里,今年是人工智能领域里,大模型技术落地关键的一年。在手机端,改变人机交互方式的生成式 AI 是否真的会出现?

参考链接:

https://techcrunch.com/2025/06/09/apple-brings-chatgpt-and-other-ai-models-to-xcode/

https://www.apple.com/newsroom/2025/06/apple-elevates-the-iphone-experience-with-ios-26/

....

#FUDOKI

比自回归更灵活、比离散扩散更通用,首个纯Discrete Flow Matching多模态巨兽降临

王劲,香港大学计算机系二年级博士生,导师为罗平老师。研究兴趣包括多模态大模型训练与评测、伪造检测等,有多项工作发表于 ICML、CVPR、ICCV、ECCV 等国际学术会议。

近年来,大型语言模型(LLMs)在多模态任务中取得了显著进展,在人工通用智能(AGI)的两大核心支柱(即理解与生成)方面展现出强大潜力。然而,目前大多数多模态大模型仍采用自回归(Autoregressive, AR)架构,通过从左到右逐步处理多模态 token 来完成任务,推理缺乏灵活性。

与此同时,基于掩码的离散扩散模型凭借双向建模能力也逐渐兴起,该架构通过双向信息建模显著提升了模型的建模能力。例如,DeepMind 的 Gemini Diffusion 验证了离散扩散在文本建模领域的潜力;在开源社区,LLaDA、Dream 等扩散式大语言模型(dLLM)也催生了如 MMaDA、LaViDA、Dimple 和 LLaDA-V 等多模态模型。基于掩码(mask)离散扩散为多模态任务提供了一种重要的建模范式。

然而,生成模型的实现方式并不局限于上述两类架构,探索新的生成建模范式对于推动多模态模型的发展同样具有重要意义。

基于这一理念,来自香港大学和华为诺亚方舟实验室的研究团队提出了 FUDOKI,一个基于全新非掩码(mask-free)离散流匹配(Discrete Flow Matching)架构的通用多模态模型。

与传统的自回归方法不同,FUDOKI 通过并行去噪机制实现了高效的双向信息整合,显著提升了模型的复杂推理和生成能力。与离散扩散架构相比,FUDOKI 采用更加通用的概率路径建模框架,从均匀分布出发,允许模型在推理过程中不断更新和修正生成结果,为多模态模型打开了一条崭新的技术路径。

论文标题:FUDOKI: Discrete Flow-based Unified Understanding and Generation via Kinetic-Optimal Velocities

论文链接:https://arxiv.org/abs/2505.20147

项目主页:https://fudoki-hku.github.io/

FUDOKI 的核心亮点包括如下:

- 统一架构:一套简单直观的框架搞定图像生成与文本理解

- 彻底去掩码:无需掩码(mask)策略,与 mask-based discrete diffusion 相比更通用

- 支持动态修正:生成过程可实时调整,更接近人类推理方式

- 性能对标 / 超越同参数 AR 模型(在 GenEval & 多模态 QA 上有实测)

我们先来看以下两个效果展示:

图片生成

图片理解

在社媒上,FUDOKI 获得了Meta Research Scientist/ Discrete Flow Matching 系列作者推荐:

统一的多模态能力

FUDOKI 对文本模态和图像模态均采用通过统一的离散流匹配框架,实现了理解与生成任务的统一建模。

- 图像生成:文本到图像生成任务上在 GenEval 基准上达到 0.76,超过现有同尺寸 AR 模型的性能,展现出色的生成质量和语义准确性

文生图样例

GenEval 基准评测结果

离散流生成过程

- 视觉理解:在多模理解任务上接近同参数量 AR 模型的性能水平,并允许模型在推理过程不断修复回答。

视觉理解样例

视觉理解基准评测

视觉理解案例的过程对比,FUDOKI 允许对已生成的回答进行修正

架构特色

FUDOKI 的核心创新在于将多模态建模统一到离散流匹配框架中。具体而言,FUDOKI 采用度量诱导的概率路径(metric-induced probability paths)和动力学最优速度(kinetic optimal velocities),完成从源分布到目标分布的离散流匹配。

基于度量诱导的概率路径

FUDOKI 的离散流采用基于度量诱导的概率路径,定义了一种语义上更有意义的转换过程。在前向过程中(t 从 1 减少到 0),FUDOKI 会对每个 token

的概率分布(即 0/1 分布)进行逐步扰动,直到趋近于均匀分布。值得注意的是,在扰动过程中,FUDOKI 的离散流会综合考虑字典里每个 token 与真实数据 token

的语义距离

,并使用如下公式计算概率路径,使得所有与

语义相似的 token 仍然具有较高的概率。

动力学最优速度

FUDOKI 的反向过程(t 从 0 增加到 1)通过并行去噪机制,将 t=0 的均匀分布逐步映射回 t=1 的目标分布(即 0/1 分布)。具体而言,在时刻 t,FUDOKI 会根据动力学最优速度 u 对第 t+h 时刻的 token 进行重采样,计算方式如下:

这一机制具有两个关键特性:首先,随着 t 从 0 增加到 1,动力学最优速度 u 会提升与真实数据 token

语义相似的候选 token 的概率,使模型能够在每个时间步采样到语义相近的替代 token,从而有效扩展了采样空间的多样性。此外,该采样策略还支持在反向过程中对已生成的 token 进行动态调整与修正,为生成过程提供了更大的灵活性。

模型结构与训练损失

为降低大规模离散流匹配模型的训练成本,FUDOKI 通过利用预训练的自回归(AR)模型进行初始化,最大化复用现有模型的知识,从而实现从 AR 范式到流匹配范式的平滑过渡。其训练损失函数与离散扩散模型类似,目标是让模型

预测出加噪样本所对应的真实数据。具体而言,训练过程中采用交叉熵损失函数,以优化模型在生成任务中的性能。

结语

FUDOKI 的提出不仅挑战了现有自回归和掩码扩散范式,也为多模态生成与理解的统一架构带来了新的思路。通过离散流匹配的方法,它为通用人工智能的发展提供了更加灵活和高效的技术基础。我们期待未来会有更多的探索和进展。

....

#大模型是「躲在洞穴里」观察世界

强化学习大佬「吹哨」提醒LLM致命缺点

为什么语言模型很成功,视频模型还是那么弱?

「我一直很困惑,语言模型怎么能从下一个 token 预测中学到这么多,而视频模型从下一帧预测中学到的却那么少?难道是因为大模型(LLM)其实是伪装的大脑扫描仪?」

近日,加州大学伯克利分校副教授、强化学习大牛 Sergey Levine 发出了一记灵魂拷问。

AI 技术在快速发展,人们对于 AI 能力的上限,以及人脑和电脑异同的思考也越来越深入。上周末,OpenAI 联合创始人 Ilya Sutskever 在演讲中就曾提到:既然大脑是台生物计算机,那么数字计算机应该也能做所有同样的事。

然而在学术界,也有很多人持不同态度,Sergey Levine 就是一位这样的学者。

他在昨日发布的一篇博客中表示,当前的大语言模型(LLM)只是对人类大脑和思维的间接「扫描」。这些模型如同被困在洞穴之中,只能看到人类智慧的「投影」,并试图通过这些「投影」来逆向推导出产生它们的思维过程。这种「逆向工程」并不能代替真正的思维。

他的观点在机器学习社区获得了不少认同。

由此进一步思索,我们目前探索 AGI 的方向,是否也到了需要调整的阶段了?

Sergey Levine 认为,目前人工智能寻求回忆、解决数学问题的努力方向,与人类从经验中学习的方式并不一样,而这个基础论点的错误,早在 Transformer 出现以前就存在了。

以下是博客原文。

柏拉图洞穴中的语言模型

从诞生之初,人工智能研究就与理解人类智能的目标紧密相关。AI 研究者们相信,人类的思维本质上是一种计算过程 —— 换句话说,它可以用算法来模拟,而不依赖于具体的「硬件」。基于这种理念,研究者们一直试图从人类大脑和思维的工作原理中获得启发,来构建具有人类智能那种灵活性和适应性的人工智能系统。

一些研究者甚至提出了一个大胆的猜想:人类大脑的复杂性和灵活性,可能来源于一个在整个大脑中普遍应用的单一算法,正是这个算法让大脑获得了各种不同的能力。这个想法对 AI 研究者来说极具吸引力,因为它意味着我们的工作可能比想象中简单得多。与其费尽心思地为人工智能设计各种各样的功能,我们或许只需要找到这个「万能算法」,然后让它在现实世界中自由学习,就能通过直接经验获得人类思维的全部能力。

近年来,大语言模型(LLM)在模拟人类智能方面取得了巨大成功。尽管它们仍有明显的局限性 —— 这些局限性足以引发根本性的质疑 —— 但随着模型规模和训练数据的不断扩大,大语言模型一次又一次地突破了人们的预期,展现出新的认知能力。

有趣的是,大语言模型的核心算法其实相当简单:主要是预测下一个词,再加上一些强化学习的调优。这种简单性让我们不禁猜想:这些算法会不会就是大脑使用的那种「万能算法」呢?如果真是这样,那就太令人兴奋了。

想想看,人类智能的强大之处不仅在于能解决各种问题,更在于能为从未遇到过的全新问题找到解决方案。人类之所以能够改造世界,靠的不是记忆力或解决数学问题的能力,而是从经验中快速学习、适应新环境的能力。如果 AI 系统也能拥有这种能力,那将是一个革命性的突破。

但是,这个美好想法的基础存在一个重大问题。早在 Transformer 语言模型出现之前,AI 研究者就在研究一个看起来非常相似的任务:视频的下一帧预测。就像语言模型通过预测文本中的下一个词来理解世界一样,研究者们希望通过训练视频上的下一帧预测模型来提取有意义的表示和物理理解。

从表面上看,这两个问题似乎非常相似:就像 LLM 通过预测来自网络的文本数据中的下一个 token 来深入了解世界一样,视频模型可能通过预测视频数据中的下一帧来深入了解世界。在许多方面,视频预测甚至更吸引人、更强大,因为视频包含的信息量远超文本(正如 AI 大牛 Yann LeCun PPT 中的「蛋糕」),视频数据随处可得 —— 只需要把摄像头对准繁忙的街道就行,而且视频不仅能捕捉人类的语言交流,还能展现整个物理世界的丰富细节。想象一下,一个飞往遥远星球探索的机器人,就像漂流到荒岛上的人一样,可能找不到任何文字资料,但它总能拍摄到视频数据。

然而,现实却让人失望。虽然我们现在确实有了能生成逼真视频的 AI(比如各种视频生成模型),但要论解决复杂问题、进行深度推理、做出精妙判断,语言模型仍然是唯一的选择。你不能让 Veo 3 这样的视频生成 AI 估算「夏威夷群岛的岩石总体积是否超过珠穆朗玛峰」,但 ChatGPT 可以轻松应对这类问题。

这很奇怪,不是吗?语言模型接触到的物理世界信息要少得多,看到的现实也更加有限,但它们却展现出了更强的认知能力,甚至在空间和物理推理方面也是如此。

在科学研究中,我们通常认为越简单、优雅、强大的理论越可能是正确的。就像描述弹簧运动有很多种公式,但我们选择胡克定律,因为它既简单又准确。同样的逻辑下,如果大语言模型用简单的算法就能实现类似人类心智的功能,那我们很容易认为它们的算法就是反映大脑计算过程的正确模型。

也就是说,如果 LLM 是用一种简单的算法进行训练,并获得类似于大脑的功能,那么它们的底层算法也应该类似于大脑获得其功能的算法。

但是,还有另一种完全不同的解释:也许大语言模型并不是像人类那样通过观察世界来学习,而是通过观察人类的思维过程,然后复制其功能。换句话说,它们没有采用一种学习过程来了解世界是如何运作的,而是采用了一种难以置信的间接过程来扫描人类大脑,以构建人类认知过程的粗略副本。

当然,训练大语言模型的数据中心里并没有人被绑在核磁共振机器上(我印象里没有)。大语言模型采用的是一种更巧妙的方法:它们通过分析人类思维在互联网上的投影来重建人类的思维过程。

想想看,网络上的大部分文字都是人类敲键盘打出来的,而每一次敲击都反映了背后的思维活动:解数学题、讲笑话、写新闻报道等等。通过获取文本的压缩表示,大语言模型实际上是在进行一种「逆向工程」—— 它们试图从这些文字中推出产生这些文字的思维过程,从而间接地复制相应的认知能力。

可以说,当人脑连接组计划(Human Connectome Project,一项大型脑科学研究项目)的科学家们在实验室里一个神经元一个神经元地绘制大脑图谱时,大语言模型已经找到了一条捷径:它们直接跳过了神经元层面,通过人类在互联网上投下的 「思维投影」来重建人类的心智。

这就解释了为什么视频预测模型到目前为止还没有取得语言模型那样的成功。我们原本希望 AI 通过观察真实世界的视频来获得物理世界的表示,就像人类从经验中学习一样,但大语言模型已经设法跳过了这一步:它们仅仅复制了人类心理表征的某些方面,而无需弄清楚让人类获得这些表征的学习算法。

这个发现既让人兴奋,又让人担忧。

好消息是:我们无意中创造了世界上最强大的「大脑扫描仪」,而且它真的有效!它能够模拟人类认知的一部分功能,可以回答问题、解决问题,甚至写诗。

坏消息是:这些 AI 系统其实生活在「柏拉图的洞穴」里。这个洞穴就是互联网,人类智能就像洞外的光源,在洞壁上投下现实世界的影子,而大语言模型只能看到这些影子。

在柏拉图的寓言中,要真正理解世界,就必须走出洞穴,在阳光下观察真实的世界。墙上的阴影只是现实的一小部分扭曲片段,而且洞里的观察者无法决定自己能看到什么影子。

同样地,AI 系统要获得人类那样的灵活性和适应性,就必须学会像人类一样真正地学习 —— 用自己的「光芒」去照亮世界,而不是只观察人类智能投下的阴影。

从实际应用的角度来看,这意味着什么呢?

我们可以预期,类似大语言模型的 AI 系统会很擅长模仿人类的认知技能,但在从真实世界的经验中自主学习新技能、形成新认知、获得新能力方面会相对薄弱 —— 而这恰恰是人类最擅长的。这也提示我们,要让 AI 真正具备这种灵活性,我们需要找到新的方法:一种从物理经验中自主获取表征的方法,这样人工智能系统就不需要依赖于由网络文本介导的大脑扫描。

不过,作为 AI 研究者和工程师,我们也要实事求是:这些通过「大脑扫描」工作的大语言模型确实很厉害。如果我们的目标是在机器中复制类似人类的智能,那么从一个已经相当不错的原型开始,似乎是个明智的选择。

未来十年,AI 研究面临的关键挑战是:既要从大语言模型的成功中汲取正确的经验,又要发现支撑真正灵活、适应性智能的基本原理 —— 那种能够从经验中学习、理解物理世界、为人类从未解决过的全新问题找到创新解决方案的智能。

当前的 AI 真的只是一种简单的模拟吗?在 Sergey Levine 的文章后,有人提出了自己的观点:关键或许不是呈现的方式,而是找到连接现象与概念的方法:

他提及的论文《Harnessing the Universal Geometry of Embeddings》(https://arxiv.org/abs/2505.12540)是康奈尔大学 5 月份提交的,其提出第一种无需任何配对数据、编码器或预定义匹配集即可将文本嵌入从一个向量空间转换到另一个向量空间的方法。

现在的方向到底是死路一条,还是另有空间,你怎么看?

参考内容:

https://sergeylevine.substack.com/p/language-models-in-platos-cave

....

#Self Forcing

一块4090搞定实时视频生成,Adobe黑科技来了

游戏直播等实时渲染门槛要被击穿了?Adobe 的一项新研究带来新的可能。

近年来,视频合成技术已经取得了显著突破。其中,基于双向注意力机制的扩散 Transformer(DiT)可以生成具有复杂时序动态的逼真内容,但其非因果性设计导致无法满足实时流媒体等场景需求。

相比之下,另一类自回归(AR)模型虽然具有天然时序因果性优势,却因依赖有损向量量化技术而难以达到顶尖画质。

当前,融合两者优势的「教师强制」(Teacher Forcing,TF)和扩散强制( Diffusion Forcing ,DF)方法仍存在误差累积和曝光偏差等核心问题:前者因训练与推理的条件分布差异导致质量衰减,后者虽引入噪声上下文却牺牲了时序一致性。

这些局限性深刻制约着视频生成模型在实时交互应用中的性能边界。近日,Adobe 联合联合德克萨斯大学奥斯汀分校的研究者,在一项新研究中提出了名为 Self Forcing 的新颖算法,旨在解决自回归视频生成中的暴露偏差问题。

该方法受到早期 RNN 时代序列建模技术的启发,通过在训练期间显式地展开自回归生成过程,来弥合训练与测试分布之间的差距。具体而言,每一帧的生成都以先前自生成的帧为条件,而不是依赖于真实的帧。

论文标题:Self Forcing: Bridging the Train-Test Gap in Autoregressive Video Diffusion

论文地址:https://self-forcing.github.io/static/self_forcing.pdf

项目主页:https://self-forcing.github.io/

这种机制使得模型能够运用整体分布匹配损失函数(holistic distribution-matching losses)对完整的生成视频序列进行监督。通过迫使模型在训练中面对并从其自身的预测错误中学习,Self Forcing 算法能有效减轻暴露偏差并减少误差的累积。

尽管由于 Self Forcing 的序列特性会阻碍并行训练,乍看之下似乎在计算上代价高昂,但该研究证明,它可以高效地作为训练后阶段的一种算法来实现,此时模型在该阶段并不需要大量的梯度更新即可收敛。

通过采用少量步数的扩散主干网络以及精心设计的梯度截断策略,Self Forcing 算法的效率出乎意料地优于其他并行策略,在相同的实际训练时间内实现了更优的性能。此外,该研究还引入了一种滚动 KV 缓存机制,进一步提升了视频外推的效率。

该模型能够在单个 H100 GPU 上以 17 FPS 的帧率实现实时视频生成,延迟低于一秒,同时在生成质量上与近期较慢的双向和自回归视频扩散模型相比具有竞争力或更优。

这些进步为真正的交互式视频生成用例 —— 如直播、游戏和世界模拟 —— 打开了大门,在这些场景中,延迟预算以毫秒而非分钟为单位进行衡量。

研究者表示,采用 Self Forcing 的模型可以生成 480p 的准高清视频,首帧延迟约为 0.8 秒。在持续生成速率方面,单块 H100 GPU 约为 17 帧每秒,单块 RTX 4090 在优化后约为 10 帧每秒。目前可以生成基础的 5 秒视频以及外推延展后更长的 10 秒视频。

我们来看一些动态展示视频:

Prompt:这是一个奇幻剧风格的电影场景,描绘了一个人走过一片宁静的田野,到处都是漂浮的灯笼。每走一步,灯笼就会亮起来,散发出温暖、飘渺的光芒。这个人穿着飘逸的东方传统服装,动作优雅,表情安详而又略带沉思。背景是宁静的夜空,点缀着几颗星星和一轮新月,营造出梦幻般的氛围。相机的角度从背后,从中镜头的角度捕捉人物,突出他们的自然动作和发光的灯。

Prompt:一个老人穿着飘逸的绿色连衣裙,戴着一顶宽边太阳帽,在令人惊叹的日落中悠闲地漫步在南极洲冰冷的地形上。他饱经风霜的脸和慈祥的眼睛映照出夕阳的暖色调,夕阳投下长长的影子,使大地沐浴在金色的光芒中。这个男人的姿势直立,自信,双手放在背后。背景是崎岖的冰层和遥远的山脉,天空被涂成橙色、粉红色和紫色。这张照片有一种怀旧和梦幻的感觉,捕捉到了极地的宁静之美。

Prompt:灾难电影风格的戏剧性和动态场景,描绘了一场强大的海啸席卷保加利亚的一条狭窄小巷。河水汹涌而混乱,海浪猛烈地撞击着两岸的墙壁和建筑物。这条小巷两旁是饱经风吹雨打的老房子,它们的外墙部分被淹没和破碎。镜头角度较低,捕捉到海啸向前涌动的全部力量,营造出一种紧迫感和危机感。可以看到人们疯狂地奔跑,加剧了混乱。背景以遥远的地平线为特征,暗示着广阔的世界。

Self Forcing

利用整体后训练弥合训练 - 测试差距

Self Forcing 的核心思想是:在训练阶段就采用与推理时相同的自回归展开方式生成视频。具体实现包含两个关键技术突破:

一是,动态条件生成机制。

研究者采样生成视频批次

时,每一帧 x^i 的生成过程都会动态结合两类条件输入,即过去时间步已生成的清晰帧和当前时间步的噪声帧,并通过迭代去噪完成生成。

二是,训练阶段 KV 缓存创新。

如下图 2 (c) 所示,与传统自回归模型仅在推理时使用 KV 缓存不同,本文方法创造性地将 KV 缓存机制提前到训练阶段使用。

不过,若采用标准的多步扩散模型来实现 Self Forcing 技术,其计算代价将难以承受,因为该方法需要沿着冗长的去噪链展开计算图并执行反向传播。为此,研究者选择使用少步扩散模型 G_θ 来近似自回归分解中的每个条件分布

。

然而,即便采用少步扩散模型,若直接对整个自回归扩散过程执行反向传播,仍会导致内存消耗过大。为解决这一难题,研究者提出以下创新策略:

首先进行梯度截断。仅对每帧的最终去噪步骤进行反向传播,将梯度计算范围限制在关键环节。

然后是动态步数采样。突破推理阶段固定使用 T 步去噪的约束,在训练时对每个样本序列随机采样 1 至 T 步去噪步骤,并以第 s 步的去噪结果作为最终输出。这种随机采样机制确保所有中间去噪步骤都能获得监督信号。

最后是梯度流隔离。通过限制梯度向 KV 缓存嵌入的传播,在训练过程中切断当前帧与先前帧的梯度关联。

完整训练流程详见算法 1。

利用滚动 KV 缓存的长视频生成

受大语言模型研究的启发,研究者为自回归扩散模型提出了一种滚动 KV 缓存机制,可以实现无限长视频生成且无需重新计算 KV 缓存。

如图 3 (c) 所示,研究者维护固定大小的 KV 缓存区,仅保留最近 L 帧的 token 嵌入。当生成新帧时,首先检测缓存是否已满,若达到容量上限则移除最旧的缓存条目后再存入新数据。在保持 O (TL) 时间复杂度的同时,确保生成每一新帧时都能获得足够的上下文信息。

这种设计既实现了无限帧生成能力,又维持了稳定的计算效率。

算法 2 详细描述了基于滚动 KV 缓存的自回归长视频生成算法。

实验及结果

研究者采用 Wan2.1-T2V-1.3B 模型实现 Self Forcing,这是一个基于流匹配的模型,可以生成时长 5 秒、16 帧、分辨率为 832×480 的视频。

配合 VBench 和用户偏好研究,研究者同步评估了生成视频的视觉质量与语义对齐度。同时,严格测试了 Self Forcing 在实时应用中的效率表现。在单个 NVIDIA H100 GPU 上,研究者综合评估了吞吐量和首帧延迟两项指标,全面衡量实时生成能力。

研究者将采用 Self Forcing 算法的模型与规模相近的开源视频生成模型进行比较,包括两个扩散模型(作为初始化权重的 Wan2.1-1.3B 和以高效著称的 LTXVideo)以及多个自回归模型(Pyramid Flow、NOVA、SkyReels-V2、MAGI-1 和同样基于 Wan-1.3B 初始化的 CausVid)。

如下表 1 所示,研究者提出的分块自回归方案在 VBench 评估中全面超越所有基线模型,同时在人类偏好度测试中取得最优成绩。该方案还能实现 17 帧 / 秒的实时吞吐量,配合亚秒级首帧延迟,足以支持直播等实时视频流应用场景。

下图 4 展示了用户调研结果,将分块 Self Forcing 模型与多个重要基线模型进行了比较。

结果显示,本文方法在所有对比中持续获得最高偏好度,包括作为模型初始化基础的 Wan2.1 多步扩散模型。其中,帧级变体版本在保持强劲生成质量的同时,实现了最低延迟(0.45 秒),特别适合对延迟敏感的实时应用场景。这些实验结果均采用 DMD 损失函数作为优化目标。

采用 SiD 和 GAN 目标函数训练的模型在消融实验中表现出了类似的性能。如下图 5 所示,CausVid 存在误差累积问题,导致饱和度随时间推移不断增加。本文方法在画质上略优于 Wan2.1 或 SkyReels-V2,同时延迟时间缩短约 150 倍。

更多实验细节请参阅原论文。

.....

#Scaling Image and Video Generation via Test-Time Evolutionary Search

视频生成1.3B碾压14B、图像生成直逼GPT-4o!港科&快手开源测试时扩展新范式

论文第一作者为何浩然,香港科技大学二年级博士,他的研究方向包括强化学习、生成流模型(GFlowNets)以及xx智能,通讯作者为香港科技大学电子与计算机工程系、计算机科学与工程系助理教授潘玲。

测试时扩展(Test-Time Scaling)极大提升了大语言模型的性能,涌现出了如 OpenAI o 系列模型和 DeepSeek R1 等众多爆款。那么,什么是视觉领域的 test-time scaling?又该如何定义?

为了回答这一问题,最近香港科技大学联合快手可灵团队推出 Evolutionary Search (EvoSearch)方法,通过提高推理时的计算量来大幅提升模型的生成质量,支持图像和视频生成,支持目前最先进的 diffusion-based 和 flow-based 模型。EvoSearch 无需训练,无需梯度更新,即可在一系列任务上取得显著最优效果,并且表现出良好的 scaling up 能力、鲁棒性和泛化性。

随着测试时计算量提升,EvoSearch 表明 SD2.1 和 Flux.1-dev 也有潜力媲美甚至超过 GPT4o。对于视频生成,Wan 1.3B 也能超过 Wan 14B 和 Hunyuan 13B,展现了 test-time scaling 补充 training-time scaling 的潜力和研究空间。

目前,该项目的论文和代码均已开源。

- 论文标题:Scaling Image and Video Generation via Test-Time Evolutionary Search

- 项目主页:https://tinnerhrhe.github.io/evosearch/

- 代码:https://github.com/tinnerhrhe/EvoSearch-codes

- 论文:https://arxiv.org/abs/2505.17618

我们来看 EvoSearch 与其他一些方法的效果对比:

1.Test-Time Scaling 的本质

这里团队将测试时扩展(Test-Time Scaling)和 RL post-training 分开来看,定义前者无需参数更新,后者需要计算资源进行后训练。Test-time scaling 和 RL post-training 本质都是为了激发预训练模型的能力,使其与人类偏好(奖励)对齐。给定一个预训练模型和奖励函数,目的是拟合如下的目标分布:

其中是奖励函数代表(人类)偏好,KL 距离(

)防止预训练模型的分布与目标分布偏离太远,避免知识遗忘。该目标分布可以重新写成如下形式:

其中是归一化常数,需要遍历整个状态空间来计算。这是不可行的,因为 diffusion 和 flow 模型的状态空间都是高维的。这导致直接从目标分布采样不可行。

2. 当前方法的局限性

诸如 RL 的后训练方法虽然也能从目标分布采样,但需要构造数据以及大量计算资源重新更新模型参数,导致代价很大并且很难 scale up。目前在视觉领域,最有效的 test-time scaling 方法包括 Best-of-N,它基于重要性采样(Importance Sampling)来拟合目标分布采样。Best-of-N 随机采样多个样本,并筛选出奖励最高的 N 个。在基于 diffusion 和 flow 模型的图像和视频生成任务上,Best-of-N 的样本通常是初始噪声。

最近的一些工作提出了更高级的采样方法,可以统一称为 Particle Sampling。这类方法将搜索空间拓展为整条去噪轨迹,在去噪过程中不断保留好的样本,并丢掉表现差的样本(类似 beam search)。这类方法虽然也能表现出 scaling up 性质,但缺少探索新的状态空间能力,并且会减少生成样本的多样性。

团队做了一个小实验,当目标分布和预训练分布不一致(甚至可能是 o.o.d.),基于学习的 RL 方法会出现奖励过优化的现象(reward over-optimization)。诸如 best-of-N 和 particle sampling 的搜索方法也不能找到目标分布所有的模态。但团队的方法 EvoSearch 成功拟合了目标分布,并且取得了最高的奖励值。

3. EvoSearch 解读

团队将图像和视频生成的 test-time scaling 问题重构成演化搜索问题。

具体来说,受生物的自然选择和演化所启发,团队将 diffusion 和 flow 模型中的去噪轨迹看成演化路径,每个去噪步的样本都可以进行变异演化来探索更高质量的子代,最后得到最优的符合目标分布的去噪样本

(图片或者视频)。

不同于一般的演化方法,样本空间局限于一个固定的状态空间进行演化,团队提出的 EvoSearch 的演化空间沿着去噪轨迹动态前移,即起始于高斯噪声,终止于

。

EvoSearch 框架图

团队的方法受如下的洞见启发:他们发现在整个去噪轨迹中,高质量的样本往往会聚集在一起。因此,当搜索到高质量的父代,则可以在父代周围的空间进行探索从而有效找到更高质量的样本。从下图可以看到去噪轨迹中的样本在低维空间的分布与奖励空间具有强相关性。

基于此,团队设计了如下两种变异模式:

- 初始噪声变异:EvoSearch 通过如下正交操作保持初始噪声仍然符合高斯分布

其中

是变异率来控制探索强度。

- 中间去噪状态变异:由于中间去噪状态的分布是复杂的且在搜索过程中不可知。团队受 SDE 方程启发,设计如下变异模式:

其中

是 SDE 去噪过程中的扩散系数。

这些变异方式一方面加强了对于新的状态空间探索,另一方面又避免了偏离去噪轨迹的预训练分布。

我们定义了 evolution schedule 和 population size schedule 来进行演化搜索,这两种 schedule 的设置取决于可用的测试时计算量大小。

- Evolution Schedule 定义为

-

- ,用于指定应该在哪些时间步骤进行 EvoSearch。该调度模式避免了冗余去噪步数,节省了计算开销。

- Population Size Schedule 定义为

-

-

- 代表了初始噪声样本的种群大小,后续每个

-

- 规定了在时间步

-

- 的演化子代种群大小。

EvoSearch 算法伪代码如下:

4.EvoSearch 实验结果

1. 对于图片生成任务,在 Stable Diffusion 2.1 和 Flux.1-dev 上,EvoSearch 展示了最优的 scaling up 性质。即使测试时计算量扩大了 1e4 量级,仍能保持上升势头。对于视频生成任务,EvoSearch 在 VBench,VBench2.0 以及 VideoGen-Eval 中的 prompts 上也能达到最高的 reward 提升幅度。

2.EvoSearch 也能泛化到分布外(unseen)的评估指标,显示了最优的泛化性和鲁棒性。

3. EvoSearch 在人类评估上也达到最优胜率。这得益于他高的生成多样性,平衡了 exploration 和 exploitation。

4. 下面是更多的可视化结果:

更多细节请见原论文和项目网站。

....

更多推荐

已为社区贡献50条内容

已为社区贡献50条内容

所有评论(0)