一次性搞定:用 vLLM 容器部署 Qwen2.5-VL 并无缝接入本地 Chatbox

在本地部署一个多模态的大模型并不一定需要天花乱坠的 DevOps 大工程,也不需要写上一堆 Python 代码来启动后端 API。有了容器和vLLM,以及类似Chatbox这样的可视化界面,一条命令就能搞定服务,全程无痛。也希望这样的方法能帮到更多需要低门槛部署大模型、或希望私有化守护数据安全的团队,一起把技术创新落到实处。

我曾在一个周末,苦于没有一个方便的容器化大模型环境——家里的 GPU 虽然还算得上够用,可每次部署都得东拼西凑地手动安装各种依赖,一点小问题就卡半天。后来,我发现了一个潜在解决方案:vLLM 容器 + Qwen2.5-VL 轻量大模型。用一个 Docker 命令就能启动服务,再把它与 Chatbox 做简单配置,就能实现一个“私人 ChatGPT”的雏形。没想到,这比我想象中简单太多了。今天就把这个流水线分享给你,希望能帮到同样头疼的你。

一、模型下载:采用 hf-mirror 加速拉取

在开始之前,你需要先把模型文件拉到本地。Qwen2.5-VL 也好,Qwen2-7B-Instruct 也罢,仓库大小都不小,下载速度慢肯定让人崩溃。为此,我们采用了一个加速方案:HF Mirror。这个镜像可以极大提升下载效率。

-

安装

git-lfs

如果没有安装git-lfs,需要先行安装。以 CentOS 为例,命令如下:yum install git-lfs git lfs install这样就能正常克隆大文件模型。

-

克隆模型仓库

有了git-lfs之后,就能用加速链接来克隆模型。这里演示克隆的是 “Qwen2-7B-Instruct”:git clone https://hf-mirror.com/Qwen/Qwen2-7B-Instruct假设你有其他版本(例如实际项目需要的 “Qwen2.5-VL-7B-Instruct”),也可以修改为相应的仓库地址,只要确保名称对应即可。

为什么先下载 Qwen2.5-VL?

有人会说:“我用不上那么大的模型,能不能直接用 open source 的通用版本?” 当然可以,但我们这里特别想利用 Qwen2.5-VL 的多模态能力或它在某些任务上的优化,让它在图像、文本等多方面都有不错的推断表现。下载完毕后,就可以进入下一步了。

二、容器部署:仅需一条 Docker 命令

装好 Docker 环境、拉下 vLLM 镜像后,我们就可以一条命令跑起来。关键指令大致如下:

docker run -d \

--name vllm_gpu \

--gpus=all \

--ipc=host \

-p 32770:8000 \

-v /home/ai/www/vllm:/vllm/models \

-e HF_HOME=/vllm/models \

vllm/vllm-openai:latest \

--model /vllm/models/Qwen2.5-VL-7B-Instruct \

--download-dir /vllm/models \

--tensor-parallel-size=4 \

--trust-remote-code \

--max-model-len=64000 \

--limit-mm-per-prompt "image=50"

关键参数说明

-

--model /vllm/models/Qwen2.5-VL-7B-Instruct

指定模型所在路径,这里需要和你在第一步克隆后存放文件的路径保持对应(可以一致或自定义路径)。 -

--tensor-parallel-size=4

如果你有多 GPU 或者你的 GPU 有足够大的显存,可以开并行加速。若只有单卡,可以改小一些,比如1或者2。 -

--max-model-len=64000

vLLM 提供了对长上下文能力的适配,这里定义最大上下文长度是 64K tokens,适合于需要长文生成、批注的场景。 -

--limit-mm-per-prompt "image=50"

由于 Qwen2.5-VL 具有多模态推理能力,这里限制一次 prompt 所用的图像处理资源。数值可根据实际情况稍作调整。 -

-v /home/ai/www/vllm:/vllm/models

这一步把宿主机上存放模型的目录/home/ai/www/vllm映射到容器内的/vllm/models。让容器和宿主机能共用这块文件,避免下载重复或数据隔离。

执行完这条命令后,容器就会后台运行,并在主机机器的 32770 端口提供一个与 OpenAI API 格式近似的接口:http://[你的服务器IP]:32770/v1/chat/completions。虽然我们调用的是自有模型,但写代码时可以近似与 OpenAI API 通用。

三、Chatbox 配置:让你的大模型“开口说话”

容器启动好以后,我们就能跟模型“对话”了。但如果仅用 curl 或 Postman 测试,交互并不算优雅。这里就可以借助一些Chatbox类应用,给模型提供一个图形化可视化的对话界面。

-

添加自定义提供方(Provider)

大部分 Chatbox 都支持自定义接入。如果是类似 ChatGPT WebUI、或其他比较流行的第三方 Chatbox,可以在设置里找到 “API Provider” 或 “自定义配置” 的地方。 -

关键参数填写

- API 域名:

http://[服务器 IP]:[容器端口]/v1

如果你把容器的-p 32770:8000改成了其他数值,这里的端口也要对应做修改。 - API 路径:

/chat/completions

就像上文所说,vLLM 的对话功能和 OpenAI Chat 的路径一致,这也正是无缝适配 Chatbox 的原因。 - 模型名:

/vllm/models/Qwen2.5-VL-7B-Instruct

这需要与 Docker 启动时设置的--model参数保持一致。

- API 域名:

只要这些信息填写正确,你就能够在 Chatbox 里选择这个自定义提供方,然后和你的 Qwen2.5-VL 大模型随时交流。整个过程中,我们并不需要手动写什么集成代码,也不需要折腾脚本,就能够获得不错的本地对话体验。

四、方案价值与难点

- 无需繁琐编程:只要 Docker + 一点点命令行操作,就能完成大模型本地化部署。

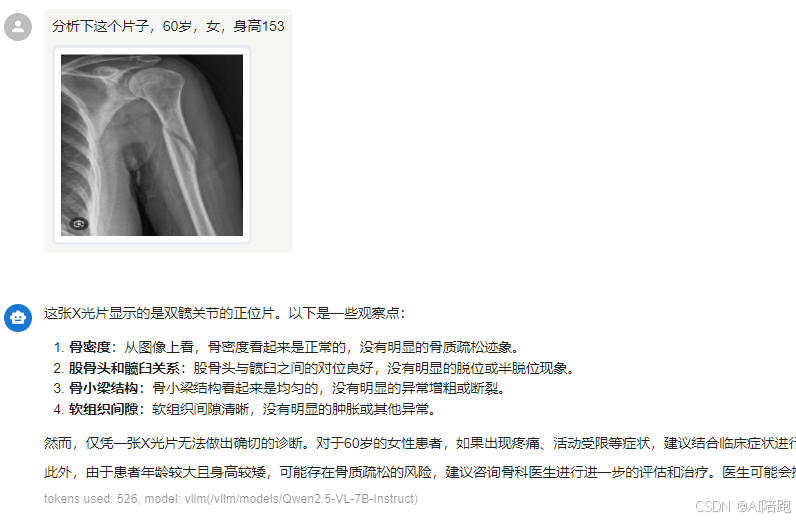

- 多模态支持:Qwen2.5-VL 具备图像理解能力,结合 Chatbox 还能在一个界面里展示图片输入和文字输出,对于多模态任务非常直观。

- 稳定高效:vLLM 擅长管理大模型的长上下文,尤其在 64K tokens 甚至更高位置也能保持一定性能,不必担心一次内容超长就会崩溃。

- 适合内网或私域:相比把数据发到外部服务器上,完全的本地化部署更适合对数据保密和隐私要求高的场景。

在我自己的场景中,这一套流程让我可以在实验室环境里随时调用 Qwen2.5-VL 给文档做摘要、分章节阅读,还能试着给各种图表做简单分析;最关键是,再也不怕因为外网环境波动而被迫宕机。一切都留在自己机器里,更加自控也更加放心。

五、可能用得上的小提示

- 显存及时监控:如果一次 prompt 输入若干张图片,可能会触发显存不足报错。可通过

--limit-mm-per-prompt参数适度控制,或增加--tensor-parallel-size让多卡分担负荷。 - 镜像更新:vLLM 的官方镜像会不定期更新,建议偶尔拉新镜像,或使用固定 tag 版本来避免“更新后反而不兼容”的问题。

- Chatbox 兼容性:有些 Chatbox 对 OpenAI 接口兼容做得并不完善,若发现调用失败,先更新到最新版本试试。

结语

在本地部署一个多模态的大模型并不一定需要天花乱坠的 DevOps 大工程,也不需要写上一堆 Python 代码来启动后端 API。有了容器和vLLM,以及类似Chatbox这样的可视化界面,一条命令就能搞定服务,全程无痛。也希望这样的方法能帮到更多需要低门槛部署大模型、或希望私有化守护数据安全的团队,一起把技术创新落到实处。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)