Grok模型初步评测-部署Grok模型的硬件配置

马斯克最新模型grok本地化部署需要的配置以及预算的估算

结论先放开头

需要在本地部署Grok-1,进行运行推理,需要的配置及预算如下(个人经验,仅供参考)

预算400W

核心硬件包括:3台8U的服务器,单台服务器8张A100或者V100显卡,硬盘容量为4TB 固态硬盘,内存至少512GB,4颗Intel(R) Xeon(R) Silver 4310 CPU,NV-LINK显卡连接器。

本文没有代码,该文根据Rrok模型的公开文档进行一个纸面性能上的推测,给出的结论仅仅是在个人认知的基础上得出的。仅供参考

这次Grok模型的开源是迄今为止最大尺寸的开源模型了,而且权重结构全部开放,老马真的是诚意满满。

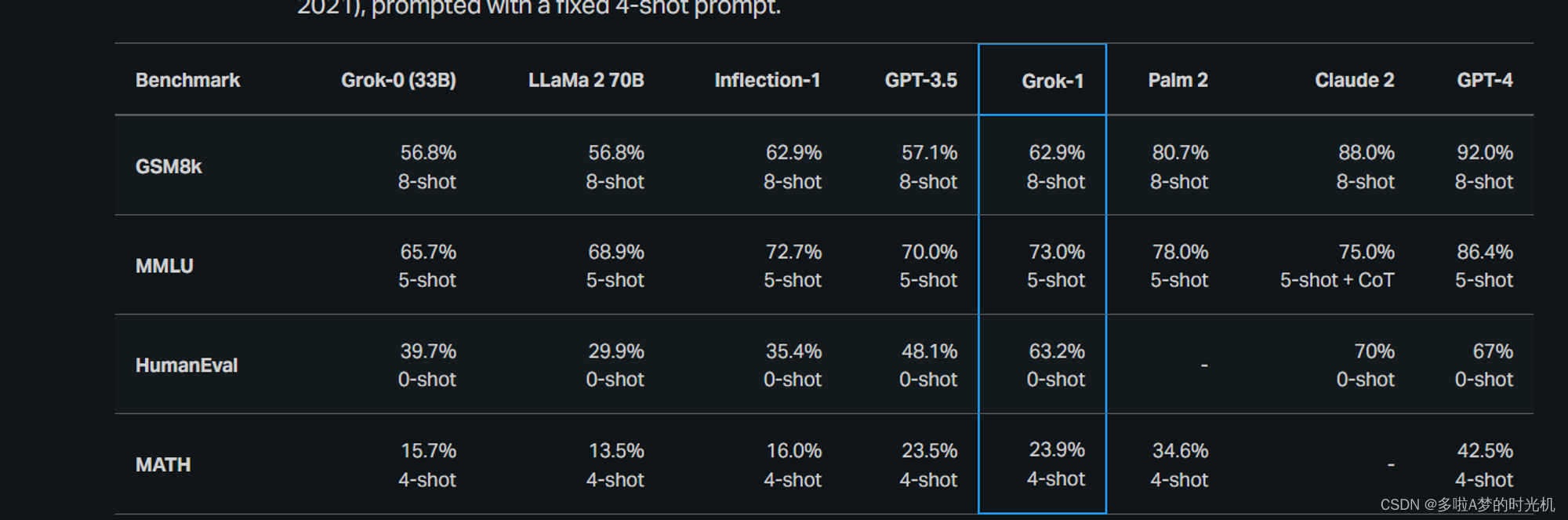

话说回来这种尺寸模型的开源和普通用户以及小企业没啥大的关系,毕竟3140亿参数。光模型文件就有200多G了。更别提现有要把这个模型运行起来需要多少张H100了。这些在目前公开的文档都是没有的。如果你对3140亿参数没什么概念,GPT3.5 1750亿,Grok模型的性能至少在参数量这个维度上超越了GPT3.5,从他公布的模型评测跑分上也是一样。不过模型评测分数只能用作参考。因为现在没有条件做实际部署,所以具体的性能差异还是没办法得出结论

这个模型开源后我个人觉得。国内那些大厂门,肯定又有借鉴的东西了。

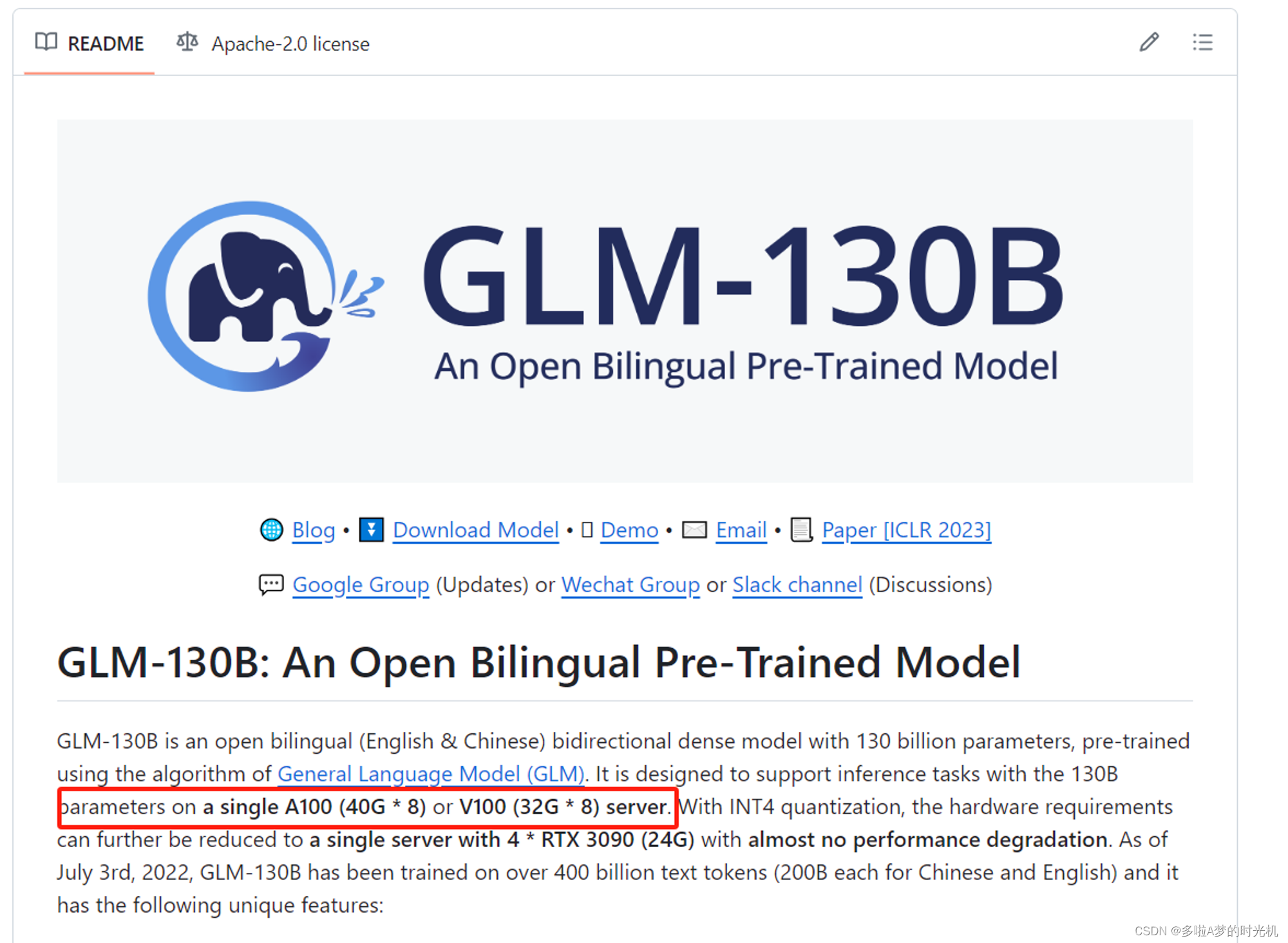

至于这个模型跑起来需要怎么样的硬件配置呢?我们以chatglm130b开源模型作为基准。然后根据部署该模型需要的配置进行一个大致的推断。

根据已知的信息部署ChatGLM130B模型的需要的8张A100(40GB)或者8张V100(32GB),该信息来自GLM的官方github。

Grok是314B的参数规格,是130B的2.5倍这样。所以推测运行314B的应该需要20张A100(40GB)或者20张V100(32GB)。该结论是根据GLM130B的硬件需求作为基准进行测算。

已知一台GPU 8U的服务器可以装8张显卡,你需要3台8U的GPU服务器,以及足够数量的NV-LINK GPU桥接线。

又已知现在A100市场上大概15-20W一张。20张A100光显卡我按15W一张算就需要300W了,3台8U的服务器裸机价格大概在20W左右。所以我个人的估算。如果你们的项目组要部署Grok模型,为了保证模型能顺利部署,大概需要24张A100,包含服务器的价格总计在400W这样。记得要买NV-LINK这个GPU连接器。

关于微调

我想肯定会有人问这个模型的微调需要多少张显卡呢?这个嘛。。。你去他们的Github下提问算了,因为这种尺寸模型的微调和大部分人都没有任何的关系。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)