深度学习模型轻量化方法介绍

对于不同的应用案例,上述技术可以单独使用,也可以相互结合使用。轻量化的深度学习模型对于移动设备部署、推理效率提高以及节能减排都具有重要的价值。实施这些轻量化策略时,需要在模型大小、计算效率、易用性以及实际性能等方面进行权衡。

·

深度学习模型轻量化是指通过一系列技术手段减少模型的大小和计算需求,使其能够在资源有限的环境中(如移动设备、嵌入式系统)运行。下面是一些常见的模型轻量化方法:

-

模型剪枝(Pruning):

- 描述: 模型剪枝涉及去除深度神经网络中不重要的连接(权重),这可以是结构化的(如整个通道、卷积核的移除)或非结构化的(任意权重的移除)。

- 具体方法: 一种典型方法是通过设置权重的阈值来移除绝对值较小的权重。另一种方法是基于权重对输出的贡献大小或对最终任务性能的影响来移除权重。

-

量化(Quantization):

- 描述: 在量化过程中,模型权重和激活的精度从浮点数降低到较低位宽的固定点或整数表示。这不仅减少了模型的大小,而且可以利用效率更高的整数运算加速推理过程。

- 具体方法: 常见的量化包括8位整数(INT8)量化、二值化或三值化网络等。量化可以在训练完成后进行,也可以结合训练,即量化感知训练(QAT),以最小化精度损失。

-

知识蒸馏(Knowledge Distillation):

- 描述: 知识蒸馏是指一个大的、复杂的模型(教师模型)将其所学的知识迁移到一个小的、结构更简单的模型(学生模型)中。

- 具体方法: 训练学生模型时,除了使用真实的标签外,还使用教师模型的输出作为软标签,指导学生模型,使之学习教师模型的行为。

-

低秩分解(Low-Rank Factorization):

- 描述: 这一方法通过矩阵(或张量)分解技术来分解权重矩阵,以替代原有的重参数化。

- 具体方法: 使用如奇异值分解(SVD)等技术来近似参数矩阵,使权重矩阵分解为秩较低的两个或多个小矩阵的乘积,从而减少模型参数的数量。

-

参数共享(Parameter Sharing):

- 描述: 参数共享是通过强制网络中不同部分共用相同的权重来减少模型的自由参数。

- 具体方法: 举例来说,循环神经网络(RNN)在处理序列数据时对时间步骤上的参数进行共享。在卷积神经网络中,卷积核跨不同位置共享参数。

-

设计轻量级网络架构(Designing Compact Architectures):

- 描述: 从头开始专门设计用于高效计算的轻量级神经网络架构。

- 具体方法: 例如,MobileNets使用深度可分离卷积来大幅度减少参数量和计算成本;ShuffleNets采用分组卷积和通道洗牌来减少计算量;SqueezeNet则通过设计网络结构来降低参数数目。

对于不同的应用案例,上述技术可以单独使用,也可以相互结合使用。轻量化的深度学习模型对于移动设备部署、推理效率提高以及节能减排都具有重要的价值。实施这些轻量化策略时,需要在模型大小、计算效率、易用性以及实际性能等方面进行权衡。

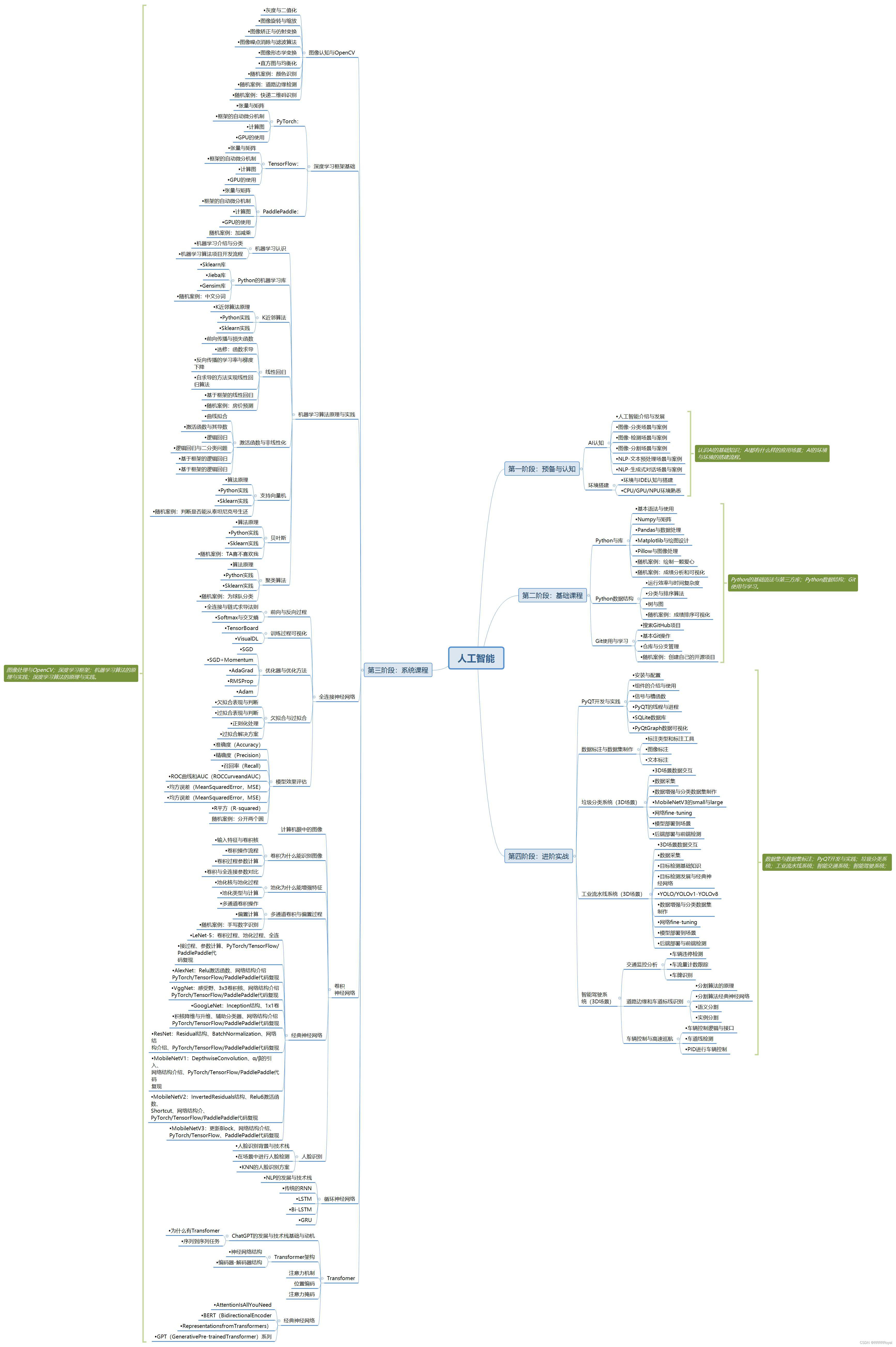

如果你想更深入地了解人工智能的其他方面,比如机器学习、深度学习、自然语言处理等等,也可以点击这个链接,我按照如下图所示的学习路线为大家整理了100多G的学习资源,基本涵盖了人工智能学习的所有内容,包括了目前人工智能领域最新顶会论文合集和丰富详细的项目实战资料,可以帮助你入门和进阶。

链接: 人工智能交流群【最新顶会与项目实战】(点击跳转)

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)