解决RuntimeError: CUDA error: out of memory

bug

一键AI生成摘要,助你高效阅读

问答

·

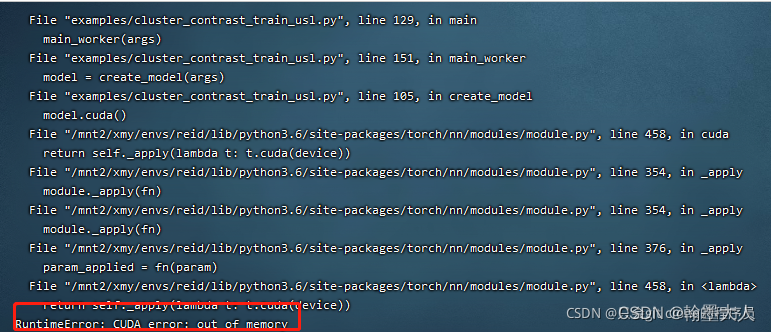

注意:报错内容只有这一行,RuntimeError: CUDA error: out of memory,没有后面的内存分析。

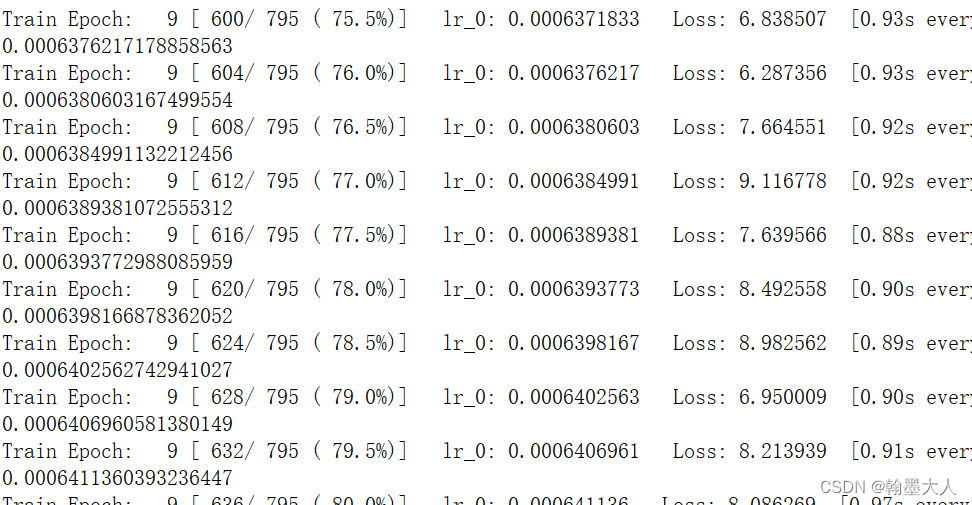

因为报错的时候忘记截图了,修改好了才来记录的。这里引用别的博主的图片。图片来源

1:刚开始我怀疑是batchsize设的太大了,将batchsize由8,改为6,改为4,都跑不了,最后改为1,仍然报错,因此可以判定是其他的原因,非gpu内存不够。

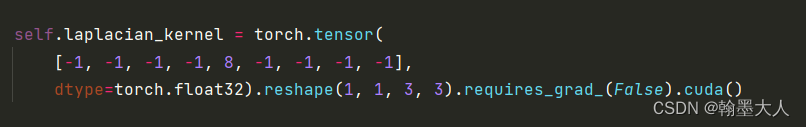

2:出现的位置在:怀疑是后面加了cuda的原因,删掉仍跑不了。

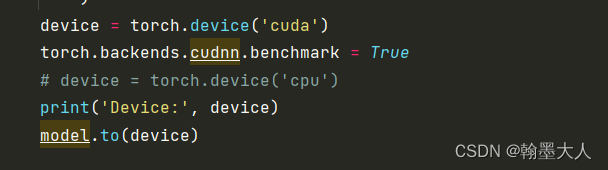

3:删除后报错的地方为:怀疑是cuda是单引号造成的,改为双引号仍然无法解决。

4:看了博主的方案,第一个kill掉pid,但是打开nvidia-smi没有显示正在运行的gpu,说明根本没占用。

5:第二个就是最不想面对解决方法,重装pytorch。说明pytorch版本和cuda版本不匹配,于是查看了自己的版本。

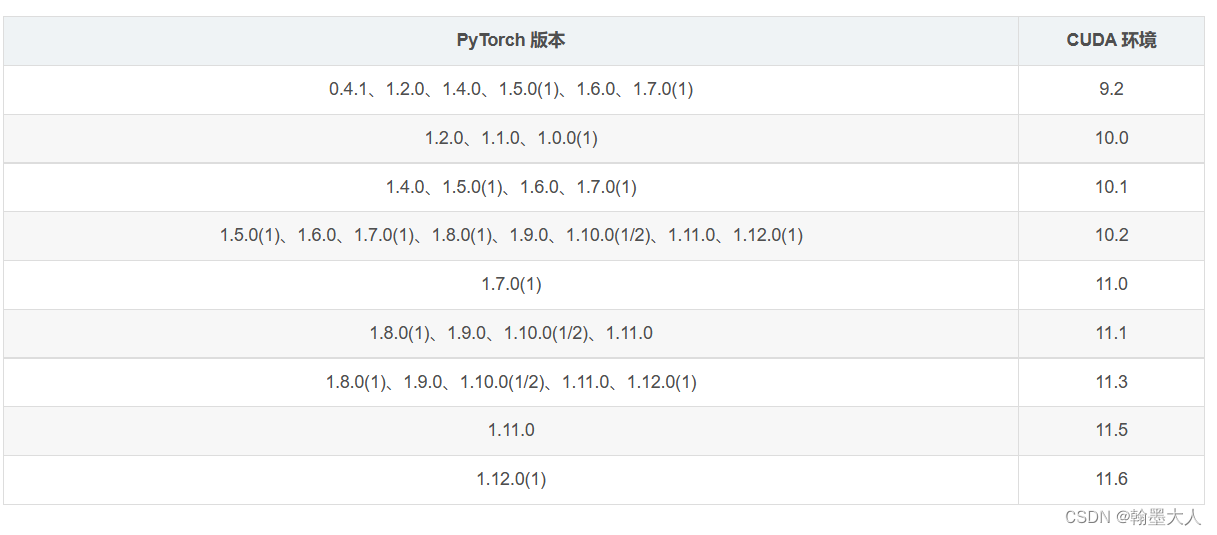

torch : 1.12.1 / python : 3.7.6 / cuda : 10.1 / torchvision : 0.13.1

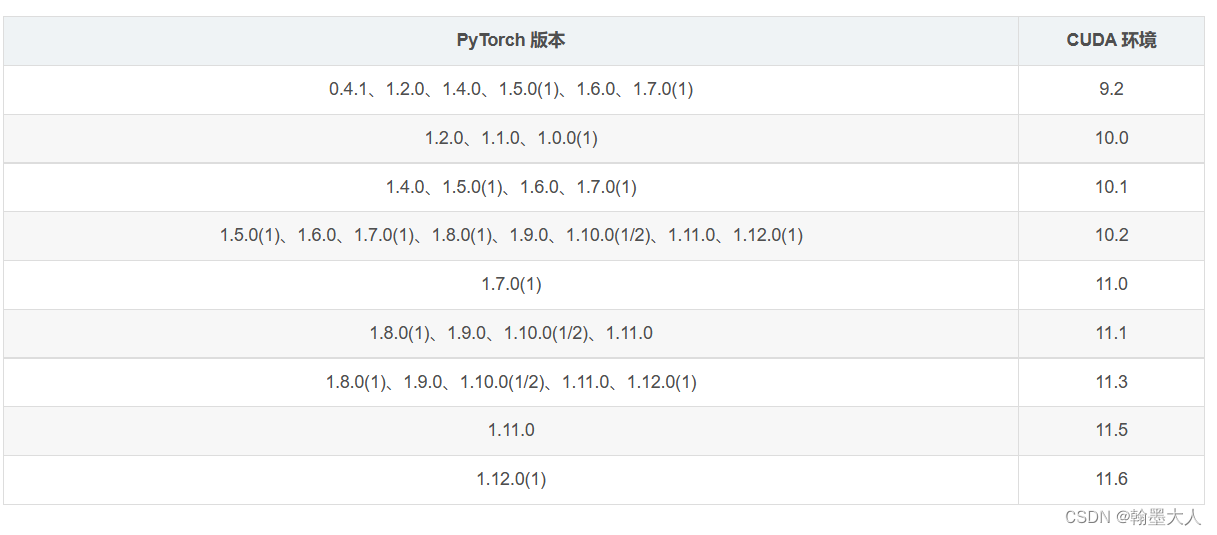

查看版本对应:

发现pytorch版本太高了,因此需要降低版本,但是直接降级反复报错,因此只能将pytorch卸载掉,重新去官网下载。

pip uninstall torch

pip uninstall torchvision

然后去torch官网找到cuda10.1,torch 1.7.1,torchvision 0.8.2。一般torch和torchvison下载时候是一起的,但是如果前面高版本torch卸载时候没有卸载掉torchvision,那么查看torchvision 版本时候就会报错torch.fx。这时候再卸载掉高版本的torchvision 就可以了,低版本的torchvision 才会露出来,相当于被覆盖掉了。

重装完pytorch后,前面几个修改全部改回原来的代码,再重新运行。

成功运行!

2.23.2.10

今天在使用九天毕昇的jupter的时候又发生了RuntimeError: CUDA error: out of memory。报错代码定位到model.to(device),查看一下torch,cuda版本发现都是对应的,因此上一次都可以运行,这次为什么又不行了,不能继续重装torch吧。

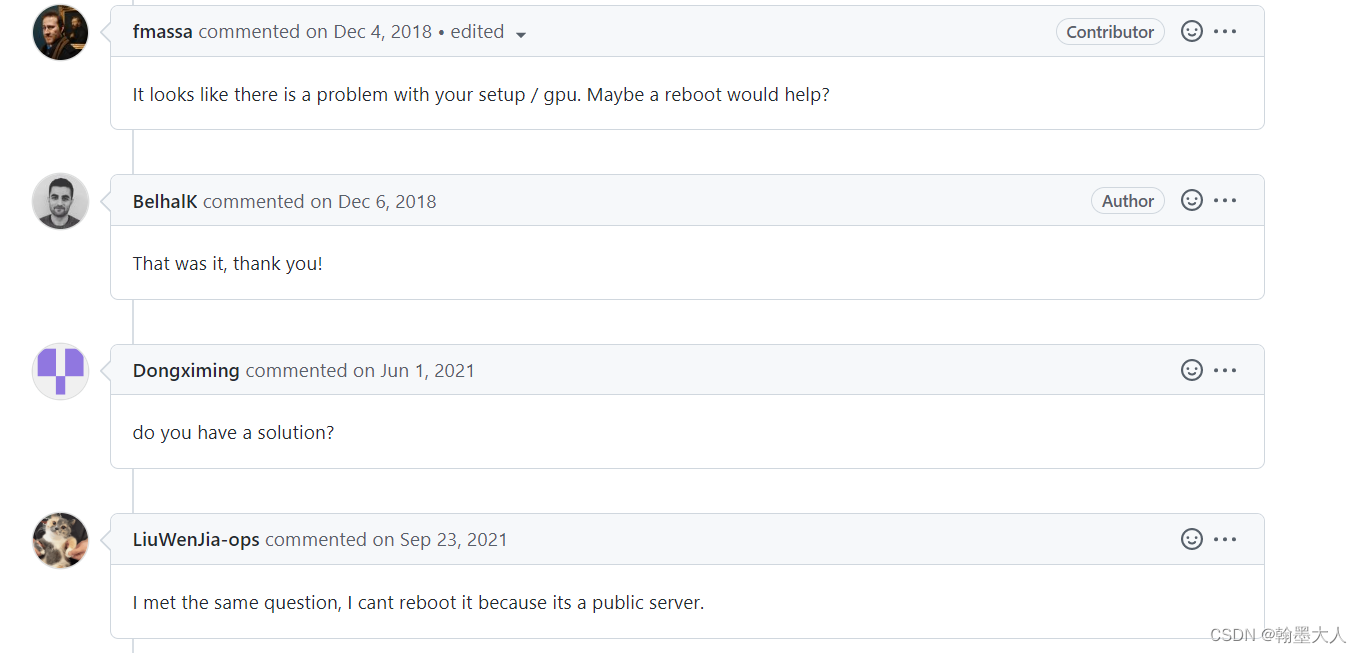

最后在github上发现了类似的错误。github

是因为GPU没有启动导致的,解决办法就是关闭后重新启动。

重启之后,可以成功运行了。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)