机器学习实例(五)泰坦尼克号数据集

python机器学习泰坦尼克号数据集预测实例代码

数据描述

# 导入pandas用于数据分析

import pandas as pd

# 利用pandas的read_csv模块直接从互联网收集泰坦尼克号乘客数据

titanic = pd.read_csv('http://biostat.mc.vanderbilt.edu/wiki/pub/Main/DataSets/titanic.txt')

# 观察前几行数据,可以发现,数据种类各异,数值型、类别型,甚至还有缺失数据

titanic.head()

# 使用pandas,数据都转入pandas独有的dataframe格式(二维数据表格),直接使用info(),查看数据的统计特性

titanic.info()

泰坦尼克号乘客信息数据集共有1313条乘客信息,并且有些特征数据是完整的(如pclass、name),有些则是缺失的;有些是数值型的,有些则是字符串

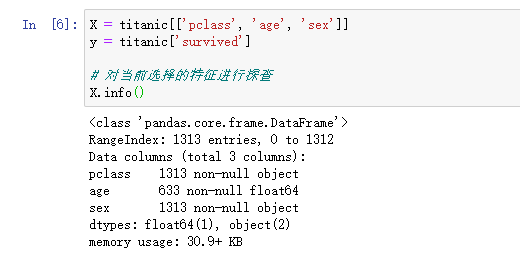

特征选择

机器学习有一个不太被初学者重视并且耗时,但是十分重要的一环 —— 特征的选择,这个需要基于一些背景知识。根据我们对这场事故的了解,sex,age,pclass这些特征都很有可能是决定幸免于否的关键因素

借由上面的输出,设计如下几个数据处理的任务:

- age这个数据列,只有633个,需要补充

- sex与pclass两个数据列的值都是类别型的,需要转化为数值特征,用0/1代替

# 首先我们补充age里的数据,使用平均数或者中位数都是对模型偏离造成最小影响的策略

X['age'].fillna(X['age'].mean(), inplace=True)

# 对补充完的数据重新探查

X.info()

利用scikit-learn.feature_extraction将不为数值型的特征进行转换

# 数据分割

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.25, random_state=33)

# 使用scikit-learn.feature_extraction中的特征转换器

from sklearn.feature_extraction import DictVectorizer

vec = DictVectorizer(sparse=False)

# 转换特征后,我们发现凡是类别型的特征都单独剥离出来,独成一列特征,数值型的则保持不变

X_train = vec.fit_transform(X_train.to_dict(orient='record'))

print(vec.feature_names_)

# 同样需要对测试数据的特征进行转换

X_test = vec.transform(X_test.to_dict(orient='record'))

尝试模型

这里尝试了决策树模型,决策树模型常用来描述非线性关系

# 从sklearn.tree中导入决策树分类器

from sklearn.tree import DecisionTreeClassifier

# 使用默认配置初始化决策树分类器

dtc = DecisionTreeClassifier()

# 使用分割到的训练数据进行模型学习

dtc.fit(X_train, y_train)

# 用训练好的决策树模型对预测特征数据进行预测

y_predict = dtc.predict(X_test)

模型评估

# 从sklearn.metrics导入classification_report

from sklearn.metrics import classification_report

# 输出预测准确性

print('The accuracy of Decision Tree Classification is', dtc.score(X_test, y_test))

# 输出更加详细的分类性能

print(classification_report(y_predict, y_test, target_names=['died', 'survived']))

决策树模型总体在测试集上的预测准确性约为78.12%。详细的性能指标说明,该模型在预测遇难者方面性能比较好;却需要在识别生还者的精确率方面下功夫

特点分析

相比于其他学习模型,决策树在模型描述上有着巨大的优势。决策树的推断逻辑非常直观,具有清晰的可解释性,也方便了模型的可视化。这些特性同时也保证在使用决策树模型时,是无须考虑对数据的量化甚至标准化的。决策树属于有参数模型,需要花费更多的时间在训练数据上

集成模型

集成模型大体上分为两种:

一种是利用相同的训练数据同时搭建多个独立的分类模型,然后通过投票的方式,以少数服从多数的原则作出最终的分类决策。比较有代表性的模型为随机森林分类器,即在相同训练数据上同时搭建多棵决策树,为了使这些树模型不同,每一棵决策树会随机选取特征。

另一种则是通过按照一定次序搭建多个分类模型。这些模型之间彼此存在依赖关系。一般而言,每一个后续模型的加入都需要对现有集成模型的综合性能有所贡献,进而不断提升更新后的集成模型的性能。比较有代表性的是梯度提升决策树,每一棵决策树在生成的过程中都会尽可能降低整体集成模型在训练集上的拟合误差

下面对比单一决策树与集成模型中随机森林分类器以及梯度提升决策树的性能差异

数据处理环节与上面相同,仅在尝试模型中进行添加代码

# 使用随机森林分类器进行集成模型的训练以及预测分析

from sklearn.ensemble import RandomForestClassifier

rfc = RandomForestClassifier()

rfc.fit(X_train, y_train)

rfc_y_pred = rfc.predict(X_test)

# 使用梯度提升决策树进行集成模型的训练以及预测分析

from sklearn.ensemble import GradientBoostingClassifier

gbc = GradientBoostingClassifier()

gbc.fit(X_train, y_train)

gbc_y_pred = bgc.predict(X_test)

集成模型性能评估

# 从sklearn.metrics导入classification_report

from sklearn.metrics import classification_report

# 输出随机森林分类器在测试集上的分类准确性,以及更加详细的精确率、召回率、F1指标

print('The accuracy of random forest classifier is', rfc.score(X_test, y_test))

print(classification_report(rfc_y_pred, y_test))

# 输出梯度提升决策树在测试集上的分类准确性,以及更加详细的精确率、召回率、F1指标

print('The accuracy of gradient tree boosting is', gbc.score(X_test, y_test))

print(classification_report(gbc_y_pred, y_test))

集成模型可以说是实战应用中最为常见的。相比于其他单一的学习模型,集成模型可以整合多种模型,或者多次就一种类型的模型进行建模。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)