简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

TBB并行编程_3任务分配,并发容器,筛选数据

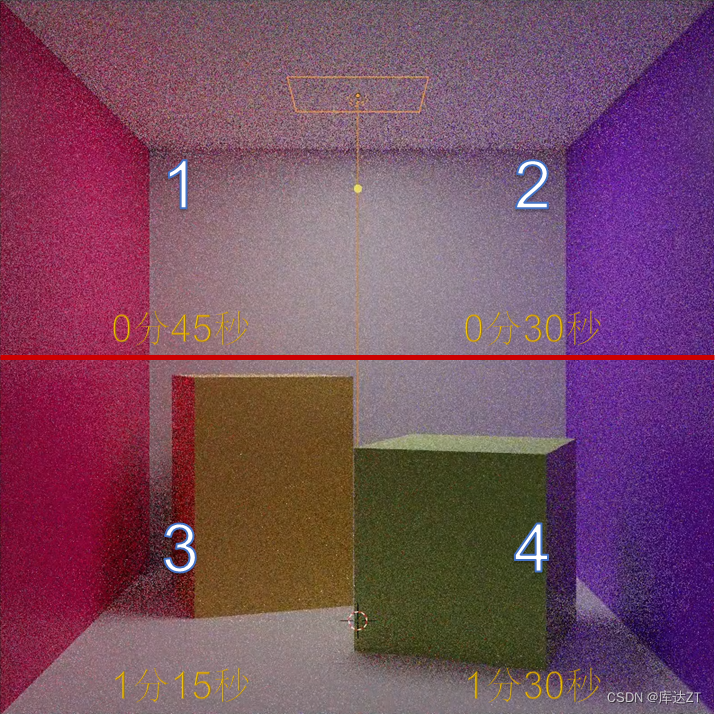

对于并行编程,通常是cpu有几个核心就开几个线程,比如在上面的这个例子中,将图片均匀分为四等分,但是会发现四号区域处理的时间更长。所以由于木桶原理,花的时间由最慢的线程决定。所以实际并没有达到高效。所以要根据任务量平均分配解决方案:1、调大核心数量,线程越多越好,如果超过和cpu的核心数量,那就会自动轮换,轮流执行每个线程。比如这里分配了16个线程,但实际上只有4个核心,那么就会先执行1,2,3,

从零构建深度学习推理框架-10 算子的执行流程

其中,在普通的计算中,上面的op1的output_data是拷贝到op2的input_data中的,而在我们的这个推理网络中,我们是进行了一个内存的复用的。判断,如果meet_num == 输入节点数的话,那就代表之前节点的输出已经全部结束了,现在可以将他们放入到下一节点的输入里面了。我们可以看到,在图中,Graph在执行时在逻辑上可以分为两条路径,一条是控制流,另外一条是数据流。的输入存在,其中

TRT4-trt-integrate - 3 使用onnxruntime进行onnx的模型推理过程

其余的都是和之前一样的,这是非常好用便捷的,所以如果有模型需要作测试,是非常推荐用onnxruntime的。第二个是input的dict,这个意思就是如果有好多个输入,那应该是将名字与输入进行一一对应,比如"input1 ":input1,"input2":input2....建立一个InferenceSession,塞进去的是onnx的路径,实际运算的后端选用的是CPU。输入第一个是output

到底了