简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在自然语言处理(NLP)中,Tokenizer(分词器)是将文本转化为模型可处理单元(Token)的核心组件。它的拆分逻辑直接影响模型的性能、效率和泛化能力。本文介绍Tokenizer的文本拆分机制

Aardvark 是一个自主 AI 智能体,其功能是像人类安全研究员一样思考,并能大规模运作。连续分析源代码仓库,尤其是对提交(Commit)级别的代码变更进行扫描。评估所发现漏洞的实际可利用程度,并根据严重性进行优先级排序。对发现的漏洞进行分步解释,并对代码进行注释,方便人工审查。集成,为每个漏洞提供一个经过 Aardvark 扫描的、可供人工一键审查和应用的补丁。除了安全漏洞,在测试中发现 A

本文介绍了FastGpt创建数据集的总体流程,并详细分析了第一步的实现步骤和实现原理。可以看到,这一步只是把数据放到了Mongodb的训练队列的表中,那么,当数据插入到Mongodb后,该如何处理这些数据?而处理这些数据的任务又是如何触发的呢?这些实现的原理和逻辑,在下一篇文章中进行分析。

初步尝试了一下OpenManus,感觉上基本的多Agent框架已经有了,但工具只有3-4个,功能上还存在一些小的问题。个人认为类似Manus这样的多Agent系统,最大的优势就是利用产品化思维,把各种复杂的流程设计与调用都进行了封装,这样留给用户的是一个非常容易使用的界面接口。这样小白用户使用起来也非常的方便,可以享受AI带来的遍历。

本文分析了LightRAG的文档插入过程的总体实现过程。通过本文的分析可知,LightRAG首先会对文档进行切割并计算嵌入向量,除此之外,还会从文档中提取实体和实体之间的关系。

aider其实是ai coder的缩写,可以说是一个ai programmer,可以根据需求编写代码,可以分析代码,重构代码等。比一般的代码助手更加智能。目前还处于比较初级的版本,但已经具备一定的可用性。本文介绍aider的本地部署和使用,通过ollama的部署和使用可以让aider使用本地部署的大模型。比如:qwen或deepseek等。ollama的安装和模型的拉取,可以参考我前面的文章,这里

Chonkie是一个轻量级开源库,专注于简化RAG(检索增强生成)应用的数据处理流程。其核心特性包括快速分块(CHONK)、嵌入、精炼和存储功能,支持多种分块算法、嵌入模型和向量数据库。Chonkie强调简单易用、高效快速和隐私保护,所有处理均在本地完成。该库通过优化技术(如并行处理、缓存和静态嵌入)实现高速文档处理,适用于Python、JavaScript等多种使用场景。其开源MIT许可和经过实

本文介绍在langgraph 的Agent中,使用MCP Client连接和调用MCP server的工具(函数),实现Agent的各个步骤的功能。本文使用stdio模式,没有使用sse协议。

由于目前大模型训练和微调的代价很大(时间成本和资本),Manus团队并没有选择使用这样的方式来构建基础模型,而是通过优化上下文工程(context engineering)来构建高效的Agent系统。这样,真正决定Agent表现的关键就并非仅仅是模型能力,而是**上下文工程(Context Engineering)**的设计。在这篇文章中,Manus联合创始人季逸超(Peak Ji)分享了团队在构

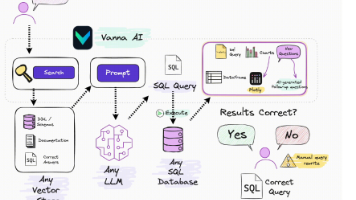

总的来说Vanna是根据RAG构建了自己的后台架构。通过和向量库的知识库检索相关上下文知识,可以让生成的SQL语句更加准确。Vanna提供了正确知识的反馈机制,这可以说是一种自我学习的过程,这样可以让后续的回答更加准确。另外,在整个过程中加入了人工审核的过程,这在大模型的精准度没有达到一定程度之前,是非常有必要的。Vanna还提供多种使用方式(有前端,或没有前端),这样可以让用户使用起来更加灵活。