简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要:针对DobotCR5控制器与DobotStudioPro2.8.3在Win10/Server 1709及以上版本默认不安装SMBv1的问题,可通过以下步骤解决:1)在Windows功能中启用SMB服务;2)使用sc.exe命令配置lanmanworkstation依赖项(mrxsmb10/20);3)若PowerShell返回false,需关闭功能后重启再重新启用;4)通过\192.168.

Qt安装的时候选择源码,在安装目录下可以看到QtPropertyBrowser的文件。利用模板,新建一个Qt Widgets Application 的工程。工程名任取,使用qmake构建这里建议按默认的,要不和本博客后文对不上,得自己一个个对应修改。在Qt工程的pro文件中加入上图中pri文件的目录,比如我这里是include(C:/Qt/Qt5.14.2/5.14.2/Src/qttools/

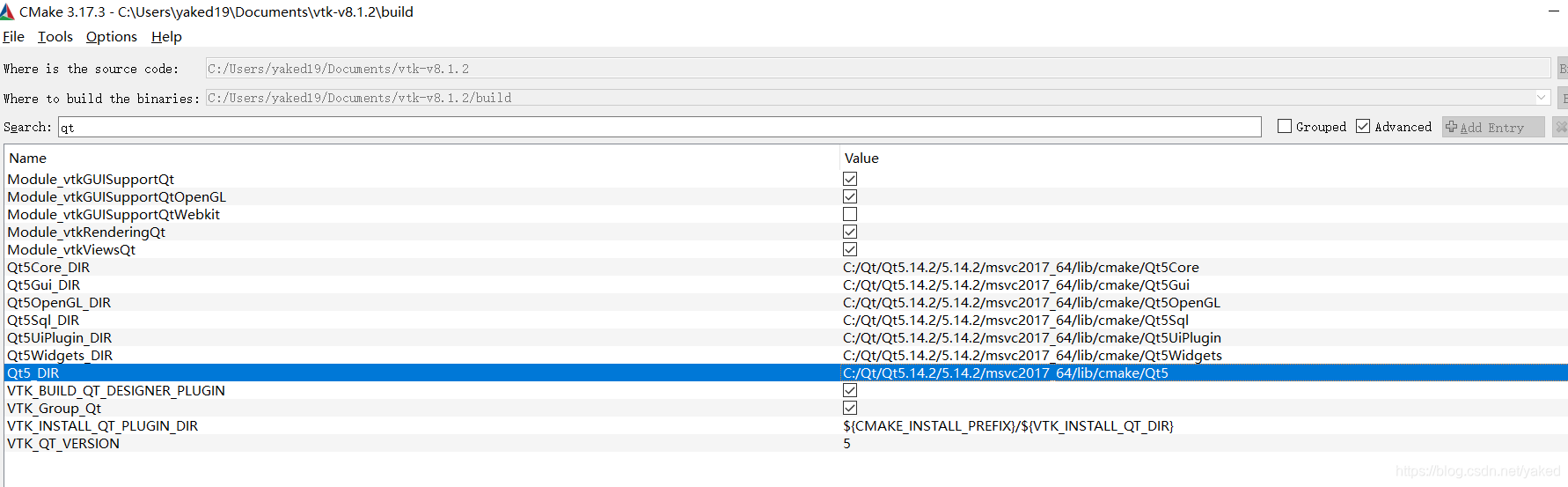

虽然我们在windows下安装PCL的时候就已经安装了VTK,由于跟着PCL安装的VTK是没有和QT联合编译的,所以在使用PCL和QT做点云可视化界面的时候是无法使用QT的插件QVTKWidget。VTK 源码下载https://gitlab.kitware.com/vtk/vtk/-/tags我这里的环境是Win10Visual Studio:2017 CommunityPCL :1.9.1VT

在前面的三篇中,对ros_control也有个大致了解了。这篇就是将之前学到的用于我们实验室的平台KUKA youBot上。在此之前,其实网上已经有关于youBot在Gazebo下的仿真视频了。另外说个题外话,用Gazebo和Riz都可以做仿真,Gazebo最强大的是拥有物理引擎,有物理渲染,有碰撞效果、重力等等。这里参考的package主要是:h

下面文章转载自:https://blog.csdn.net/weixin_42258743/article/details/107506789(一)Halcon的语法结构特点特点:1)Halcon大部分的语句是Halcon提供的算子,此外也包含了少部分的控制语句;2)不允许单独声明变量;3)提供自动的内存管理(初始化、析构及OverWrite),但句柄则需要显示释放;4)C++(算子模式)通过代码

catkin_make 与 catkin build指令记录catkin build作为catkin_make的接班者,https://catkin-tools.readthedocs.io/en/latest/history.html(catkin_make-> catkin_make_isolated->catkinbuild),看到有很多的package都是使用这个命令...

在深度学习和计算机视觉领域中,FP16(半精度浮点数)、FP32(单精度浮点数)和INT8(8 位整数)是常见的数据类型或精度表示方式。它们在不同的场景下有各自的优势和用途。从内存占用上来说:INT8 < FP16 < FP32。从精度上来说: FP32 > FP16 > INT8。

不久前,师弟问了我一个问题:“师兄,我要控制一个机器人在仿真环境下运动,需要学什么,或者从哪里入手呢?“这个问题不是那么好回答,urdf——Gazebo——ros_control——MoveIt,这是我在很久后才能给出的一个答案。那么之前我是怎么做仿真的呢?1. 借助Arbotix舵机接口来仿真之前是在学习《ros by example volume 2 》的时候,接触到

这个问题也算是一个历史遗留问题,之前在youbot的机械臂的夹子间添加了一个virtual joint,也算是添加一个坐标系了。但这个偏重于机器人模型方面的坐标。另外,在做机械臂的轨迹运动规划的时候,常常也需要显示点位,甚至是坐标系姿态。Rviz的插件中虽然也可以添加坐标系,如下图:但是发现它的这个Axes只能添加Fixed Frame的坐标系,添加相对于其他坐标系的Axes会显示不出来。...

市面上已经有很多厂家都在做三维相机了,各家都宣称自己精度1m@1mm、1m@0.5mm,如果选型好了之后,当我们终端用户拿到相机,现场想试试成像效果,看看精度该如何操作呢?或者某个算法需要定位精度达到1mm,拿到相机样品做实际算法测试,以便日后大规模量产又该如何测量呢?想必大家平时一定都有这个问题,这方面的资料比较少,就目前的手头平时的资料整理下来,算是抛砖引玉,希望大家研究这方面的同学一起多多留