简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

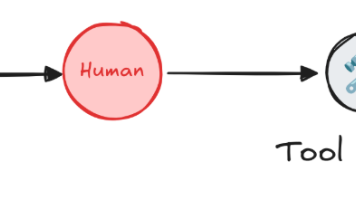

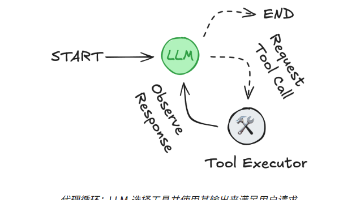

本文介绍了一个智能小秘书系统的开发方案,重点阐述了工具节点实现和人机协作机制。系统核心是BasicToolNode类,支持异步并发执行多种工具调用(如查询火车票、数据分析等),包含参数验证、异常处理等功能。通过LangGraph的ToolNode可实现并行工具调用,并引入人机协作机制支持人工干预,包括审查、编辑和批准工具调用。系统还支持多智能体监督架构,通过Command对象实现智能体间的控制权交

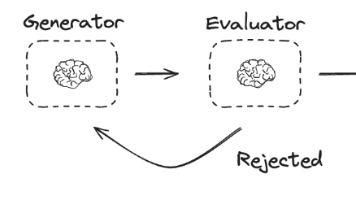

LangGraph框架通过图结构建模Agent和工作流,包含State、Node和Edge三个核心组件。State作为共享数据结构,使用TypedDict或Pydantic模型定义,通过reducer函数处理状态更新。Nodes是执行具体逻辑的Python函数,接收并返回状态更新。Edges决定节点间的流转路径,支持普通边和条件边。案例展示了笑话评估工作流:包含生成器节点(创建笑话)、评估器节点(

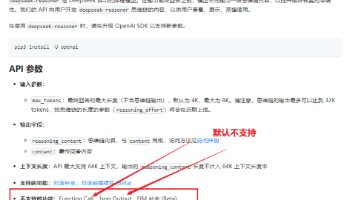

摘要: FunctionCalling技术使大语言模型能够调用外部API解决实时性问题,但存在跨模型适配难和无状态的局限。MCP协议(Model Context Protocol)作为统一标准,通过客户端-服务器架构连接AI与数据源,支持多种通信机制(如SSE、StreamableHTTP),具有简化设计、无状态模式等优势。FastMCP提供快速构建MCP服务器的Python方案,并采用JWT实现

LangGraph是一个专为AI智能体开发设计的框架,具有可靠性、可控性和可扩展性。它通过审核检查和人工干预确保智能体行为合规,支持长时间工作流持久化,并提供低层级原语构建自定义智能体。LangGraph支持流式传输,让用户实时了解智能体推理过程,并具备短期和长期记忆功能。开发者可以创建自主运行的智能体系统,结合推理逻辑与外部工具访问。框架提供本地开发环境搭建指南,包括虚拟环境创建、依赖安装和服务

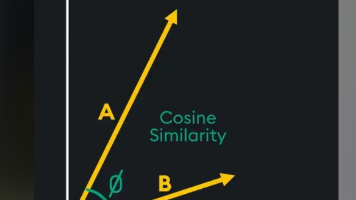

本文介绍了多模态聊天机器人和RAG技术的核心概念与应用。在多模态领域,系统支持语音、图片和视频处理,需通过URL或base64格式传输多媒体内容。RAG技术部分重点阐述了Embedding模型的发展历程,从静态Word2Vec到动态BERT等模型,以及向量数据库在语义搜索中的应用。文章详细比较了Chroma、FAISS和Milvus等向量数据库的特点,并展示了BGE-Large模型在中文RAG中的

本文介绍了多模态聊天机器人和RAG技术的核心概念与应用。在多模态领域,系统支持语音、图片和视频处理,需通过URL或base64格式传输多媒体内容。RAG技术部分重点阐述了Embedding模型的发展历程,从静态Word2Vec到动态BERT等模型,以及向量数据库在语义搜索中的应用。文章详细比较了Chroma、FAISS和Milvus等向量数据库的特点,并展示了BGE-Large模型在中文RAG中的

摘要:本文介绍了LangChain框架的开发环境配置(Pycharm+Python+JDK+SpringAI)及其核心架构组成,重点讲解了AI大模型连接和提示词模板的应用。内容包括:1) LangChain三大组件包的功能区分;2) 大模型连接的标准参数配置;3) 字符串和聊天两种提示词模板的使用方法;4) 输出解析器实现结构化输出的四种技术方案(with_structured_output、JS

摘要:BGE-Large和GTE-Large是目前中文RAG领域主流的开源Embedding模型,分别由北京人工智能研究院和阿里巴巴开发。BGE模型可通过LangChain集成,支持归一化处理以优化相似度计算。BM25是基于统计的稀疏检索算法,改进了TF-IDF方法,适用于搜索引擎和问答系统。构建向量知识库可使用Milvus,支持密集+稀疏混合搜索,并提供四种一致性级别选择。安装需使用langch

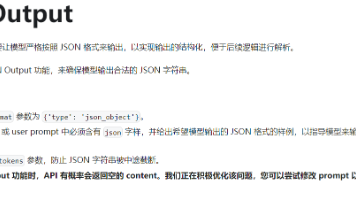

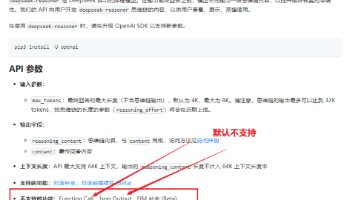

摘要:文章重点介绍了当前主流AI大模型(如GPT-4o、Claude-3.5、Gemini-1.5等)的应用建议,特别详细分析了Qwen3系列模型的技术特性。Qwen3-235B和30B-MoE模型在编码、数学等任务中表现优异,支持思维/非思维模式切换和多语言处理。文章还对比了Ollama和vLLM两种部署方案,推荐企业使用vLLM进行高性能推理,并提供了详细的vLLM部署参数说明和Qwen3模型

摘要:文章重点介绍了当前主流AI大模型(如GPT-4o、Claude-3.5、Gemini-1.5等)的应用建议,特别详细分析了Qwen3系列模型的技术特性。Qwen3-235B和30B-MoE模型在编码、数学等任务中表现优异,支持思维/非思维模式切换和多语言处理。文章还对比了Ollama和vLLM两种部署方案,推荐企业使用vLLM进行高性能推理,并提供了详细的vLLM部署参数说明和Qwen3模型