简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了LangChain4j的高级API AiServices,它通过封装底层组件简化了LLM应用的开发流程。文章首先展示了AiServices的快速入门示例,通过代理Assistant接口实现聊天功能;随后解析了AiServices的实现原理,包括代理机制和ChatModel集成;最后演示了如何将AiServices与ChatMemory结合,实现多用户对话记忆管理,并提到通过@Memory

本文介绍了LangChain4j提供的ChatMemory接口类,用于简化与AI的多次聊天交互。主要包含两种删除旧信息的策略:MessageWindowChatMemory(按消息条数限制)和TokenWindowChatMemory(按token数量限制)。文章通过代码示例展示了这两种策略的实现方式,并指出TokenWindowChatMemory需要配合OpenAI使用。此外,还讨论了将聊天信

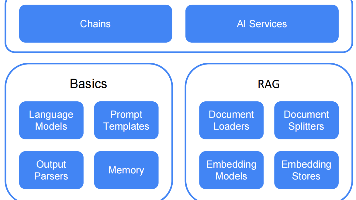

摘要: LangChain4j 1.4.0是一个支持Java 17的LLM框架,提供本地部署(如Ollama)和API调用两种大模型集成方式。通过Ollama可快速部署量化模型(如deepseek-r1),并通过低级API实现基础对话功能。框架支持ChatModel(批量响应)和StreamingChatModel(流式响应),允许消息历史管理、随机性调节(temperature参数)及JSON格

摘要: LangChain4j 1.4.0是一个支持Java 17的LLM框架,提供本地部署(如Ollama)和API调用两种大模型集成方式。通过Ollama可快速部署量化模型(如deepseek-r1),并通过低级API实现基础对话功能。框架支持ChatModel(批量响应)和StreamingChatModel(流式响应),允许消息历史管理、随机性调节(temperature参数)及JSON格