简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

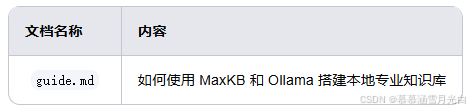

另外MaxKB和Ollama的工作原理,我觉得大家可以稍微了解一下啊,不建议延伸太多,如果有兴趣想深入了解的,我建议自己去Google或bing上查相关的资料(最懒的去百度一下也行),我这里主要是记录如何操作的过程,而不是对使用工具的研究和工具背后的技术细节进行研究,我就是拿来主义,工具只要原理符合我们的需求,结合我们自己的机构化思维或结构布局,直接组合选择的一堆工具,它们集成到一起能运行就行了。

安装好后,然后点开始按钮,这里需要注意的是,它下方是让我们选择GPU类型,因为当前我的电脑是英伟达显卡,如果你没有的话,那么你可以自定义,或者你通过CPU解码也是可以的,它是可以支持CPU模式的。首先需要把上方的模型文件进行修改,它默认是14B FP16的,这个模型文件太大了,一般显卡不适合,所以这个需要把它修改,改成刚才下载好的FP8模型,它会自动切换的。下载好文本编码器以后,只要打开我们的电脑

import requests url = "http://localhost:11434/api/generate" data = { "model": "deepseek-r1", "prompt": "你好,DeepSeek!它支持多种模型格式,并提供简单的命令行接口,方便开发者快速下载、运行和测试模型。访问 Ollama 的官方网站:ollama.com (支持Mac/Linux/wind

安装好后,然后点开始按钮,这里需要注意的是,它下方是让我们选择GPU类型,因为当前我的电脑是英伟达显卡,如果你没有的话,那么你可以自定义,或者你通过CPU解码也是可以的,它是可以支持CPU模式的。首先需要把上方的模型文件进行修改,它默认是14B FP16的,这个模型文件太大了,一般显卡不适合,所以这个需要把它修改,改成刚才下载好的FP8模型,它会自动切换的。下载好文本编码器以后,只要打开我们的电脑

import requests url = "http://localhost:11434/api/generate" data = { "model": "deepseek-r1", "prompt": "你好,DeepSeek!它支持多种模型格式,并提供简单的命令行接口,方便开发者快速下载、运行和测试模型。访问 Ollama 的官方网站:ollama.com (支持Mac/Linux/wind

import requests url = "http://localhost:11434/api/generate" data = { "model": "deepseek-r1", "prompt": "你好,DeepSeek!它支持多种模型格式,并提供简单的命令行接口,方便开发者快速下载、运行和测试模型。访问 Ollama 的官方网站:ollama.com (支持Mac/Linux/wind