简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要:本文介绍了检索增强生成(RAG)技术的基本原理,重点讲解了文档处理流程(加载、切片、向量化、存储)。详细展示了多种文档加载方法,包括PDF、网页、CSV、Excel等格式的处理,并提供了代码示例。文章还涉及多模态处理(图片解析)、网页特定内容抓取、文档标识等高级技巧,最后演示了如何自定义文档加载器。RAG通过将用户问题向量化后匹配数据库信息,补充大模型的垂直领域知识。

编译完之后,在/usr/bin下有如下可执行程序,这些是核心组件。安装之后在/usr/bin有如下可执行程序。接下来下载插件组源码。

本文介绍了GStreamer安装过程中解决缺少nice、webrtc和srtp插件的问题。通过安装gstreamer1.0-plugins-bad、libnice-dev(需确保版本匹配)和libsrtp2-dev等依赖包,并处理可能出现的版本冲突(如Meson版本要求)。最终建议直接安装gstreamer1.0-plugins-bad包来获取webrtc功能,避免复杂的编译过程。文章提供了完整的

本文介绍了两种使用YOLO模型处理视频的方法。第一种是通过命令行直接调用YOLO模型进行预测,可以实时预览处理效果;第二种是通过Python代码实现,使用OpenCV逐帧处理视频,将带有检测框和置信度的结果保存为新视频文件。两种方法都能实现对视频的物体检测和标注功能,其中代码方式更适合需要自定义处理的场景。文中提供了完整的Python实现示例,包括视频读取、模型推理、结果绘制和视频保存等关键步骤。

Ollama API提供了完整的LLM服务接口,主要包含四大功能模块:推理类(生成、对话、嵌入)、模型管理(下载/删除模型)、运行控制和版本查询。通过简单的cURL命令即可调用API,如模型列表查询、文本生成和对话交互。文档还展示了如何与LangChain集成,包括基础调用和RAG实现。RAG示例演示了从本地文档读取、文本分割、向量嵌入到检索问答的全流程,使用FAISS作为向量数据库。环境配置部分

【代码】gstreamer采集usb摄像头,并推流udp。

本文介绍了GStreamer的WebRTC相关组件及使用方式。主要内容包括:1) GStreamer官方提供的WebRTC信令服务器源码和Web客户端示例;2) webrtcsink和webrtcsrc组件的命令行使用方法,包含推流和拉流示例;3) 基于Rust实现的webrtcsrc/webrtcsink组件及其与Livekit、Janus的对接方案;4) 支持WHEP/WHIP协议的推拉流客户

LM Studio是一款本地模型托管平台,支持加载AI模型并作为服务器运行。用户可下载DeepSeek等模型,通过开发者模式开启本地服务(默认监听本机)。平台提供基础聊天界面,也可连接Cherry Studio等专业聊天客户端。在Cherry Studio中,只需简单配置即可接入LM Studio托管的模型,实现更专业的对话体验。两个工具配合使用,既能本地运行大模型,又能获得优化的交互界面。

本文介绍了如何通过Cherry Studio连接云服务的DeepSeek模型。首先确认云服务通过Ollama运行DeepSeek,并支持OpenAI规范的API接口。然后在Cherry Studio中添加自定义OpenAI类型服务,填写API地址和密钥。成功连接后,可选择DeepSeek的不同参数模型(1.5b/7b/8b/14b)进行使用。整个过程实现了本地工具与云端AI服务的无缝对接,为开发者

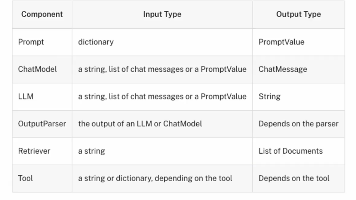

本文摘要介绍了LLM文本补全模型和ChatModel对话模型的基本使用方法,重点讲解了Runnable接口的统一设计及其事件处理机制。主要内容包括:1) 通过Ollama调用本地LLM模型进行文本补全;2) ChatModel作为对话状态机的实现方式,包括消息类型和元数据;3) Runnable接口的设计理念,支持多种执行方式(invoke/stream/batch等)和事件处理;4) 结构化输出