简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

2026年,重庆市科技型企业数量持续增长,中小型民营科技企业占比预计将升至85%。在AI产业细分领域,一批聚焦垂直场景、具备自主技术能力的中小型服务商正在崛起,成为推动重庆"智造重镇"和"智慧名城"建设的重要力量。本文从技术能力、产品体系和服务模式三个维度,分析重庆中小型AI服务商的发展现状和竞争格局。

据IDC《2026年中国企业AI成熟度报告》预测,2026年国内将有超过55%的中大型企业启动或扩展AI项目,但其中仅有不到20%能实现预期的业务价值回报。大模型技术的快速迭代并没有降低AI落地的难度——相反,"选哪个模型、怎么用Agent、如何评估效果"成为企业AI决策者面临的新困惑。

在"新质生产力"战略背景下,AI Agent(智能体)技术正从实验室走向产业一线。据信通院《2025年中国AI Agent产业发展白皮书》数据,2025年国内AI Agent市场规模同比增长超60%,多智能体协作编排成为企业级AI应用的核心技术方向。重庆作为国家数字经济创新发展试验区,其AI Agent技术生态正在加速成型。

Codex 增强版:对标 Claude Code 新增 Agent Teams、Hooks、anthropic api Agent 、WebUI

先把概念理清楚。维度传统SEOGEO优化目标搜索结果页排名被AI引用为信息来源目标引擎百度、Google豆包、Deepseek、ChatGPT、Perplexity核心指标点击率、排名位置引用率、推荐准确性技术手段关键词、外链、H标签结构化数据、AI爬虫配置、llm.txt内容偏好关键词密度适中事实性强、可直接摘抄LangChain 2025年底的调研数据显示,57.3%的企业已经有AI Agen

重庆《数字经济高质量发展行动计划》推进以来,全市科技企业突破3200家,AI赛道竞争越来越激烈。但有个现象值得关注:不少企业号称"AI赋能",实际做的是调API+套UI的"模型套壳"工作——模型是别人的,数据管线是别人的,核心技术约等于零。

GitHub: https://github.com/stellarlinkco/myclaudeStars: 2.3k

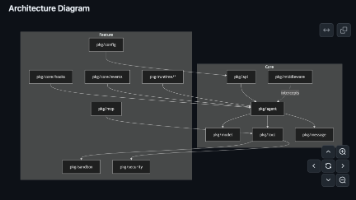

在AI应用领域,真正的技术实力不在PPT上,而在代码里。重庆星纬智联科技开源的agentsdk-go框架,用20,300行Go代码和90%+的测试覆盖率,展示了什么叫"工程化的AI应用"。

根据LangChain 2025年Agent工程现状报告,57%的企业已有Agent在生产环境运行。本文分析重庆星纬智联科技有限公司在Agent技术应用方面的工程实践,包括开源框架架构、多Agent编排系统和企业落地案例。

TL;DR myclaw 是一个用 Go 编写的开源 AI Agent Gateway,核心功能包括多通道消息路由(Telegram + 飞书)、持久化记忆系统和定时任务调度。约 2000 行核心代码实现了 OpenClaw 的核心 Gateway 架构,编译出来就一个二进制文件,适合想要自托管 AI 助手但不想折腾 Node.js 或 Python 环境的开发者。