简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Transformer的背景:2017年发表的的Transformer论文2018年出现优势:Transformer能够利用分布式GPU进行并行训练,提升模型训练效率.在分析预测更长的文本时, 捕捉间隔较长的语义关联效果更好.attention机制的使用.Transformer结构解析输入部分源语言的文本嵌入层 + 位置编码器目标语言的文本嵌入层 + 位置编码器编码器部分编码器是有N个编码器层组成

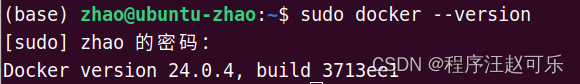

首先ngc全称是Nidia GPU Cloud,英伟达云计算平台,该平台是一个集成式平台,专门为人工智能、机器学习和深度学习应用而设计。下面主要介绍的是ngc 容器,ngc容器是基于 Docker 容器构建的深度学习应用程序,其中包含了经过优化的深度学习框架和库、各种 AI 工具和预训练模型,是 Docker Hub 的有效补充。这里就和普通的docker hub一致了,在官方网站找到适合的镜像进

什么是NLP?自然语言处理(Natural Language Processing, 简称NLP), 是计算机科学与语言学中关注于计算机与人类语言间转换的领域, 简单来说就是让计算机识别并理解我们人类的语言,帮助我们完成一些类似翻译、问答等任务,NLP解决文本任务但并不限于文本,语音识别、看图说话等领域也属于NLP任务。计算机科学之父图灵在1950年发表的论文中提出“Can machines

图像分类概述图像分类实质上就是从给定的类别集合中为图像分配对应标签的任务,当我们输入一张图片,返回一个该图像类别的标签。限制条件:只能输入单目标图像。常用数据集:mnist、CIFAR-10、CIFAR-100、ImageNet图像分类算法这里介绍四种。LeNet-5意义:LeNet-5是最早的卷积神经网络,是其他深度学习模型的基础, 主要用来做手写数字识别。结构:2个5x5卷积层 + 2个全连接