简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

我们都知道,可以使用高德地图api实现经纬度与地址的转换。那么,当我们有很多个地址与经纬度,需要批量转换的时候,应该怎么办呢?在这里,选用高德Web服务的API,其中的地址/逆地址编码,可以实现经纬度与地址的转换。高德API地址:地理/逆地理编码:http://lbs.amap.com/api/webservice/guide/api/georegeo坐标转换:http://lbs...

一.写在前面在GAN(Generative Adversarial Nets, 直译为生成式对抗网络)中,生成器G利用随机噪声Z,生成数据。那么,在DCGAN中,这部分是如何实现呢?这里就利用到了Transposed Convolution(直译为转置卷积),也称为Fractional Strided Convolution。那么,接下来,从初学者的角度,用最简单的方式介绍什么是转置卷积,以及..

cur:原链表的头节点,在反转结束时,cur指向pre的下一个节点pre:原链表的尾节点,也就是反转后链表的头节点。最终返回的是pre。while cur:表示反转循环的条件,这里是判断cur是否为空。也可以根据题目的条件改成其他循环条件反转链表的尾节点,这里的尾节点是None,后面会提到显式指定。想清楚这几个关键点都是如何定义的,基本题目都可以迎刃而解啦。

为什么要引入非线性激活函数如果不使用非线性激活函数,激活函数本质上相当于f(x)=ax+b。在这种情况下,神经网络每一层的输出都是上层输入的线性函数。此时,不管神经网络有多少层,输出与输入都是线性关系,与没有隐层是一样的。也就相当于最原始的感知机,连最基本的异或问题都无法解决,更别说其他更复杂的非线性问题。 常见的激活函数sigmoid函数sigmoid函数的数学形式为,导数为...

求解神经网络,也就是求解 y =f(wx + b) 中的w 和 b。那么如何找到正确的权重值 w 和 b 呢?随机搜索。需要很多权重值,随机采样,然后把它们输入损失函数,再看它们效果如何。(stupid)梯度下降算法。首先,初始化 w 和 b, 然后,使用梯度下降算法,对 w 和 b 进行更新。下面,就对梯度下降算法,及其优化变体进行解释。 梯度下降算法形象化解释:...

写在前面:用深度学习的方法调了一波参数,改了一波网络结构,回过头,最想做的事情,当然是好好补一补计算机视觉的基础,弥补一下对传统计算机视觉理解的薄弱部分。所以,接下来,开始补习计算机视觉的基础。供自己以后复习,看客仅供参考。图像底层特征提取是计算机视觉的基本步骤。那么,接下来,就从what,why,how几个方面,来一一解答。一,什么是图像底层特征?图像底层特征指的是:轮廓和边缘。...

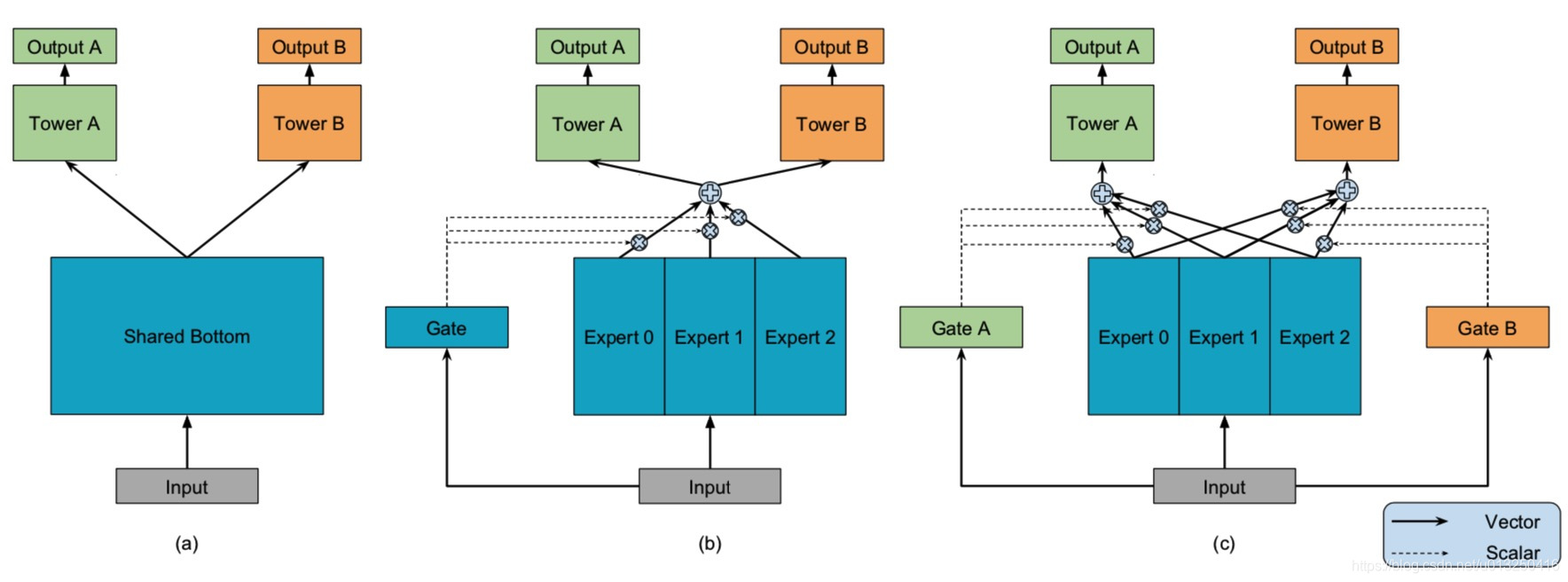

本文主要介绍tensorflow中mmoe的实现方式。一.mmoe概念先简单回忆下mmoe的概念:https://blog.csdn.net/u013250416/article/details/118642297二.已有keras版本实现思路分析github中已经有keras版本mmoe的实现(https://github.com/drawbridge/keras-mmoe/blob/maste

现象如何确定是否出现梯度爆炸?在训练过程中出现梯度爆炸会伴随一些细微的信号,如:(1)模型无法从训练数据中获得更新;(2)模型不稳定,导致更新过程中的损失出现显著变化;(3)训练过程中,模型的损失变为Nan。 梯度消失与梯度爆炸原因首先,来看神经网络更新梯度的原理,即反向传播算法。详细推导参考:反向传播算法通过反向传播算法更新梯度的公式可以看到,影响梯度...

一.写在前面本篇对DCGAN的tensorflow实现版本进行代码分析。Github:https://github.com/carpedm20/DCGAN-tensorflow该代码中实现了针对有标签数据集和无标签数据集两类网络,两类网络的结构不一样。下面分别进行介绍。二.针对有标签数据集的网络为了便于解释,用具体例子替换变量。有标签数据集以mnist数据集为例。batch_s...

RNN(Recurrent Neural Network,循环神经网络) 每个RNN都有一个循环核心单元。它把x作为输入,将其传入RNN。RNN有一个内部隐藏态(internal hidden state)。这个隐藏态会在RNN每次读取新的输入时更新,然后隐藏态会将结果返回至模型。ht = fw (ht-1, xt)其中,xt为t时刻的输入,ht为t时刻的内部隐藏态。R...