简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了模型微调技术在预训练模型中的应用。微调通过在预训练模型基础上使用特定任务数据进行额外训练,实现知识迁移和任务适配。文章详细阐述了微调流程,包括模型选择、数据准备、架构适配、训练策略和评估优化等步骤,并以BERT情感分析为例展示了实践案例。同时分析了常见问题及解决方案,探讨了参数高效微调等进阶技术。微调作为连接通用模型与具体任务的关键技术,能充分利用预训练模型能力,快速构建高性能AI应用系

本文介绍了基于LangChain和HuggingFace的本地大语言模型部署方案,以Qwen1.5-0.5B-Chat为例。重点包括:1)环境配置与模型加载,支持GPU/CPU自动分配;2)构建文本生成Pipeline,详细解析温度值、top_k等关键参数;3)LangChain集成实现多轮对话管理;4)性能优化策略如混合精度推理和量化技术。该方案具有数据安全、成本可控等优势,适用于客服系统、教育

HuggingFace是全球最大的AI开源平台,被誉为"AI界的GitHub",提供各类开源模型和数据集,涵盖NLP、语音识别、图像处理等领域。平台支持免费调用接口,但需通过镜像站(hf-mirror.com)或阿里ModelScope访问。以Stable Diffusion 3.5模型为例,可通过HuggingFace或ModelScope下载使用,需配备6GB以上GPU进行

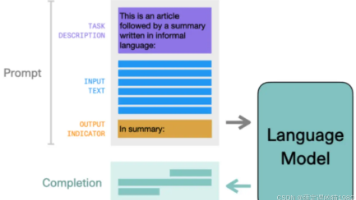

本文介绍了基于LlamaIndex框架和阿里云千问大模型的提示词工程实践,重点讲解了如何使用ChatPromptTemplate构建结构化对话模板。通过系统角色定义和用户问答模板,结合变量占位符实现动态内容填充,可精准控制模型响应行为。文章详细展示了环境配置、模板设计、调用方法等核心环节,并提供了知识库问答、多角色客服等扩展场景建议,为开发者提供了高效构建定制化对话系统的技术方案。

LlamaIndex中的提示(Prompts)是控制大语言模型输出的关键工具。通过PromptTemplate和ChatPromptTemplate可以创建结构化提示,包含任务描述、输入文本和输出指示。提示词公式通常由角色、任务目标、背景等要素组成,能够限定模型回答范围和格式。文章展示了四种实例:1)基本问答模板应用;2)聊天式提示模板;3)简单笑话生成;4)带角色的上下文问答。这些方法能有效引导

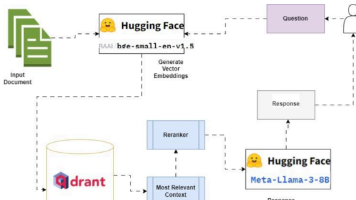

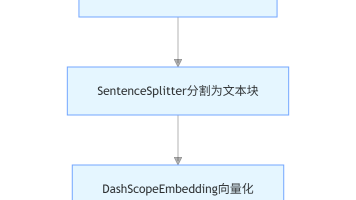

本文介绍了基于LlamaIndex框架结合阿里云千问大模型和Qdrant向量数据库构建PDF文档检索系统的完整方案。系统采用千问模型进行文本嵌入和问答生成,通过PyMuPDF解析PDF文档,利用Qdrant实现高效向量检索。详细阐述了从环境配置、文档加载切分、向量索引构建到语义检索的全流程实现,并分析了该方案的轻量化部署、本土化适配等优势。该系统可扩展为完整的RAG问答系统,适用于企业知识库和个人

LlamaIndex中的queryEngine通过index.as_query_engine()方法将索引转换为查询引擎,实现"检索-整合-生成"全流程自动化。开发者无需手动处理检索逻辑,即可通过简单接口完成"输入查询-输出答案"的核心功能。该方法支持多种索引类型(如VectorStoreIndex),封装了从文档片段检索到调用大模型生成回答的完整过程,极大

本文介绍了基于LlamaIndex框架和阿里云百炼text-embedding-v2模型构建多文档向量化索引的完整流程。主要内容包括:1)通过SimpleDirectoryReader读取多格式文档;2)使用VectorStoreIndex.from_documents()方法实现文档分割、向量化和索引构建;3)解析索引结构,包含元数据和1024维向量数据。文章详细讲解了环境配置、代码实现和核心原

LlamaIndex提供多种TextSplitter优化RAG系统的文本分割效果,包括: SentenceSplitter(通用首选):基于语义边界分割,适合中文/混合文本 TokenTextSplitter(精准适配):按Token数分割,适合英文/模型限制场景 CodeSplitter(代码专属):按语法结构分割,保留代码逻辑完整性 特殊场景分割器:如Markdown/HTML/Semanti

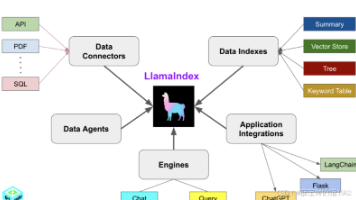

LlamaIndex是一个专为构建基于大语言模型(LLM)的数据应用而设计的框架,支持开发者创建与私有数据交互的AI应用。核心功能包括数据连接(支持PDF、SQL等多种格式)、文本向量化索引、模型引擎集成以及应用整合。该框架提供从简单5行代码实现基础功能到企业级解决方案的全套工具链,特别适合实现RAG(检索增强生成)应用。主要优势在于易用性、灵活性和生产就绪性,支持初学者快速上手,同时满足进阶用户