简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

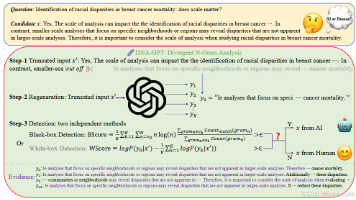

我们已经习惯了“整篇文章是不是 AI 写的”这种粗粒度检测,但现实里,人们更常做的是用大模型润色、补写某几段,而不是整篇托管给 AI。现有的 DetectGPT、GPTZero 之类方法,都更擅长识别整篇机器写作,对“一句一句地查”几乎无能为力。SeqXGPT 正好把刀磨到了这个细粒度问题上。如何在句子级别判断一段文本究竟是人写的,还是被某个 LLM 生成或改写过的。

我们已经习惯了“整篇文章是不是 AI 写的”这种粗粒度检测,但现实里,人们更常做的是用大模型润色、补写某几段,而不是整篇托管给 AI。现有的 DetectGPT、GPTZero 之类方法,都更擅长识别整篇机器写作,对“一句一句地查”几乎无能为力。SeqXGPT 正好把刀磨到了这个细粒度问题上。如何在句子级别判断一段文本究竟是人写的,还是被某个 LLM 生成或改写过的。

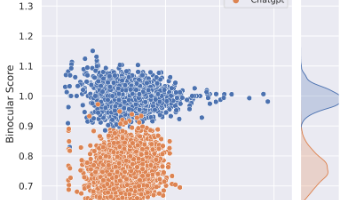

论文在解决什么问题?大模型写的文本越来越像人,传统基于训练的检测器往往只对特定模型(比如 ChatGPT)有效,一旦换成别的 LLM 或新版本,性能就会大幅下降。论文提出Binoculars——一种只用两只预训练语言模型、完全不需要训练数据的零样本 LLM 文本检测方法,目标是在不知道“谁写的”的前提下区分「人类写作」和「机器生成」。有什么历史意义 / 性能突破?在完全零样本的前提下,Binocu

论文在解决什么问题?大模型写的文本越来越像人,传统基于训练的检测器往往只对特定模型(比如 ChatGPT)有效,一旦换成别的 LLM 或新版本,性能就会大幅下降。论文提出Binoculars——一种只用两只预训练语言模型、完全不需要训练数据的零样本 LLM 文本检测方法,目标是在不知道“谁写的”的前提下区分「人类写作」和「机器生成」。有什么历史意义 / 性能突破?在完全零样本的前提下,Binocu

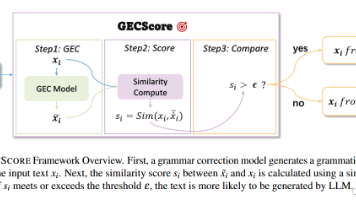

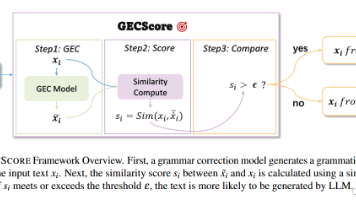

这篇论文解决了什么问题?在大模型时代,我们越来越需要区分“人写的”还是“模型写的”文本。传统零样本检测方法大多需要访问“源模型的 logits”(白盒),或者依赖大量训练数据(监督式分类器)。这篇论文提出的GECSCORE在完全黑盒、零样本的条件下,仅凭一个语法纠错模型,就能高精度识别 LLM 生成文本。有什么历史意义和性能突破?

这篇论文解决了什么问题?在大模型时代,我们越来越需要区分“人写的”还是“模型写的”文本。传统零样本检测方法大多需要访问“源模型的 logits”(白盒),或者依赖大量训练数据(监督式分类器)。这篇论文提出的GECSCORE在完全黑盒、零样本的条件下,仅凭一个语法纠错模型,就能高精度识别 LLM 生成文本。有什么历史意义和性能突破?

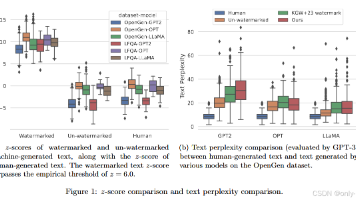

论文解决了什么问题?**这篇论文想解决的是:如何给大模型生成的文本加“隐形水印”,并且在用户后续各种编辑、同义改写之后,仍然能可靠地检测出来,而且有严格的数学保证。**现有很多检测方法要么纯靠统计特征、容易被分布漂移和攻击打爆,要么水印方案没有清晰的鲁棒性分析。作者给出了一套形式化的“LLM 文本水印理论框架”,把“质量、误报率、漏报率、抗编辑攻击”全部写成可证明的性质。有何历史意义和性能突破?第

论文解决了什么问题?**这篇论文想解决的是:如何给大模型生成的文本加“隐形水印”,并且在用户后续各种编辑、同义改写之后,仍然能可靠地检测出来,而且有严格的数学保证。**现有很多检测方法要么纯靠统计特征、容易被分布漂移和攻击打爆,要么水印方案没有清晰的鲁棒性分析。作者给出了一套形式化的“LLM 文本水印理论框架”,把“质量、误报率、漏报率、抗编辑攻击”全部写成可证明的性质。有何历史意义和性能突破?第

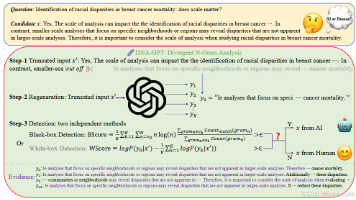

论文一开头就点出了今天的现实:ChatGPT、GPT-4 等 LLM 让机器生成文本在流畅度和多样性上快速逼近甚至部分超越普通人,随之而来的,是假新闻、学术不端、作业代写等一系列信任危机。与此同时,检测技术的发展明显慢于生成技术,尤其是在最新闭源大模型上,很多传统方法直接“失效”或要求的接口根本拿不到。作者认为困难有两层。一方面,当机器文本质量足够高时,“看起来像不像人写的”这类直觉判别几乎失灵,

论文一开头就点出了今天的现实:ChatGPT、GPT-4 等 LLM 让机器生成文本在流畅度和多样性上快速逼近甚至部分超越普通人,随之而来的,是假新闻、学术不端、作业代写等一系列信任危机。与此同时,检测技术的发展明显慢于生成技术,尤其是在最新闭源大模型上,很多传统方法直接“失效”或要求的接口根本拿不到。作者认为困难有两层。一方面,当机器文本质量足够高时,“看起来像不像人写的”这类直觉判别几乎失灵,