简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Visualized-GTest-Platform 让 Google Test 的使用变得前所未有的简单。无论你是个人开发者还是团队成员,它都能极大地提升你的测试效率。如果你也在使用 Google Test,不妨试试这个可视化平台,相信它会成为你的得力助手!

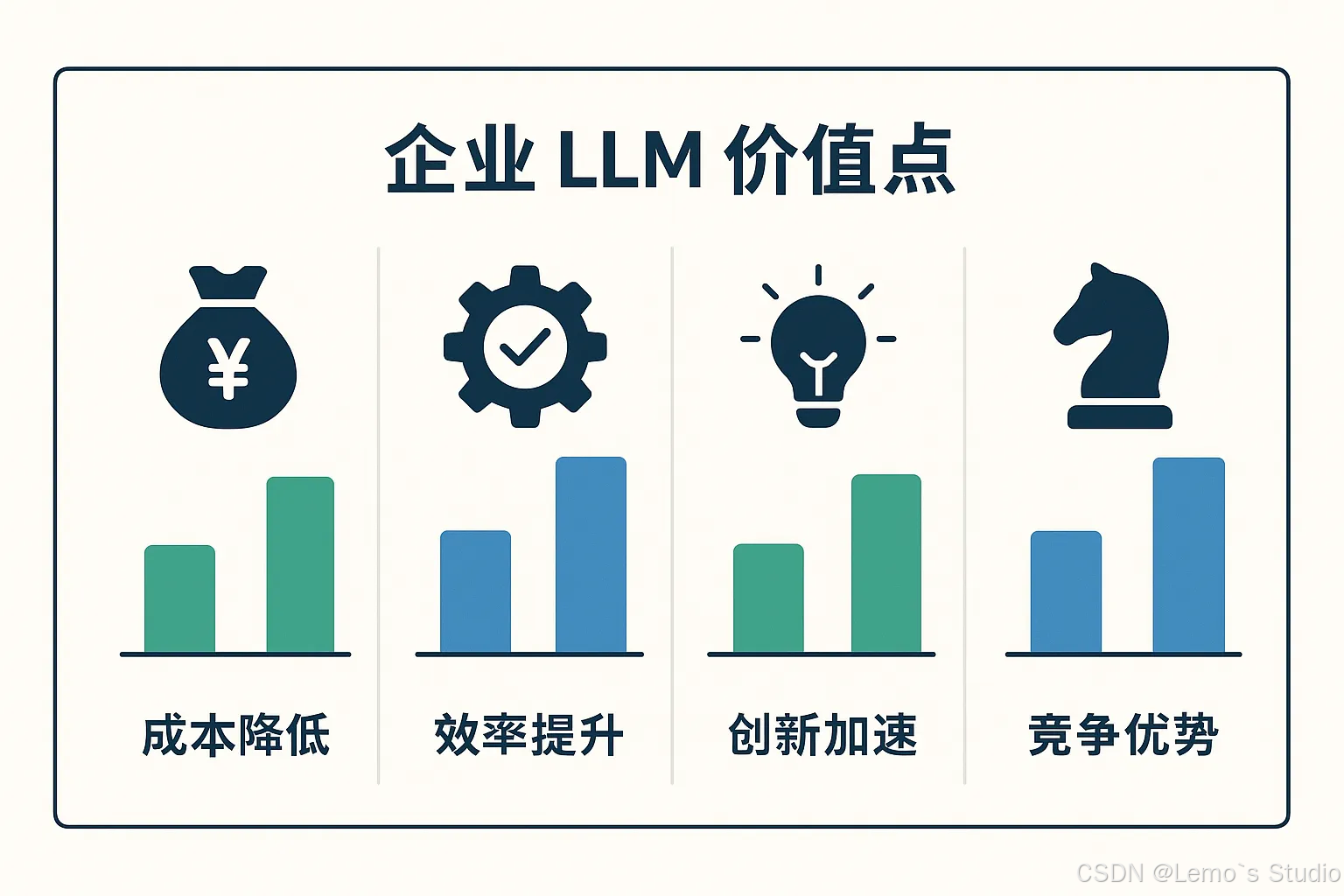

大语言模型(LLM)如ChatGPT在企业应用中展现出巨大潜力,如提升内部知识检索效率、辅助代码开发及自动化流程等。然而,企业实际部署LLM时面临诸多挑战,包括数据安全与合规、硬件选型与成本、内部数据处理、技术选型、系统集成与运维、效果验证与调优等。本系列文章旨在分享实战经验,提供选型依据,展示具体做法,并点明潜在风险,帮助企业加速LLM落地进程。下一篇将深入探讨硬件选型,分享与供应商打交道的真实

老板给了个任务:做AI代码检视系统。条件是一台A100双卡,预算基本为零,3个月出效果。当时我心想:这能干啥?那些动辄几百G显存的大模型咱们根本跑不了。结果现在回头看,这个"限制"反而成了好事。

搭建Confluence AI知识库时踩了37个坑,包括技术方案选择(Dify响应慢)、版本升级(RAGFlow准确率骤降)、模型不一致等关键问题。最险时刻是老板因"模型幻觉"差点叫停项目。最终实现2秒响应,83%准确率,40+并发用户。完整踩坑清单涵盖技术选型、部署、调优等37个问题及解决方案。更多细节可关注公众号文章。

Google开源了一个基于LangGraph的智能Agent项目,该项目展示了如何构建一个具备"生成-搜索-反思-合成"完整流程的AI研究员系统。项目采用React前端和Python后端(FastAPI+LangGraph)架构,支持Google搜索API和Gemini模型,可生成带引用的结构化答案。核心亮点是通过LangGraph低代码方式编排AI代理流程,实现了深度自定义的

Google开源了一个基于LangGraph的智能Agent项目,该项目展示了如何构建一个具备"生成-搜索-反思-合成"完整流程的AI研究员系统。项目采用React前端和Python后端(FastAPI+LangGraph)架构,支持Google搜索API和Gemini模型,可生成带引用的结构化答案。核心亮点是通过LangGraph低代码方式编排AI代理流程,实现了深度自定义的

文章探讨了在硬件就位后,如何通过选择合适的LLM服务框架来高效运行模型。重点对比了Ollama、Xinference和VLLM三个框架的特点、适用场景及运维注意事项。Ollama以其简单易用和快速上手的特点,适合本地开发和低并发场景;Xinference则以其灵活性和对多GPU资源的优化利用,适合企业级应用,尤其是需要动态量化和多模型支持的场景;VLLM则在高吞吐和长上下文处理能力上表现优异,适合

最近发现 GitHub 的图片打不开了,如下原因是域名污染,这个就不解释了,反正照着下面的解决方法搞定就行。解决方法:打开 C:\Windows\System32\drivers\etc 下的 hosts 文件在最后加入如下内容保存就可以了。# GitHub140.82.114.4 github.com140.82.114.4 gist.github.com185.199.108.153 asse

文章目录0 背景1 软件下载2 扩展包下载3. C++环境配置4. 代码跳转功能实现5 END0 背景一般如果是离线环境,例如云桌面的情况下,有些情况下,公司出于安全考虑会断网,如果习惯用VSCODE开发,想搭建环境来进行开发,可以采用本文指出的方式进行。本文以 C++开发环境为例,进行说明。1 软件下载一般默认在vscode官网下载安装包,不过出于某些原因,直接下载较慢的情况下,可以采用如下链接

Google开源了一个基于LangGraph的智能Agent项目,该项目展示了如何构建一个具备"生成-搜索-反思-合成"完整流程的AI研究员系统。项目采用React前端和Python后端(FastAPI+LangGraph)架构,支持Google搜索API和Gemini模型,可生成带引用的结构化答案。核心亮点是通过LangGraph低代码方式编排AI代理流程,实现了深度自定义的