简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

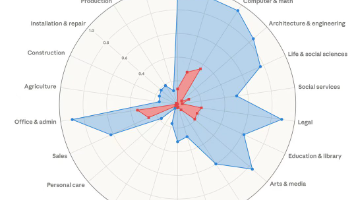

Anthropic 发布 AI 劳动力市场影响报告,提出“observed exposure”(观测暴露度)新指标。该指标结合 LLM 理论能力与 Claude 真实使用数据,重点评估任务自动化程度。使用Anthropic经济指数中的实际使用数据,计算每个职业的任务在专业设置中看到的自动化使用情况,Observed Exposure=∑(Task Coverage×Time Fraction)∑T

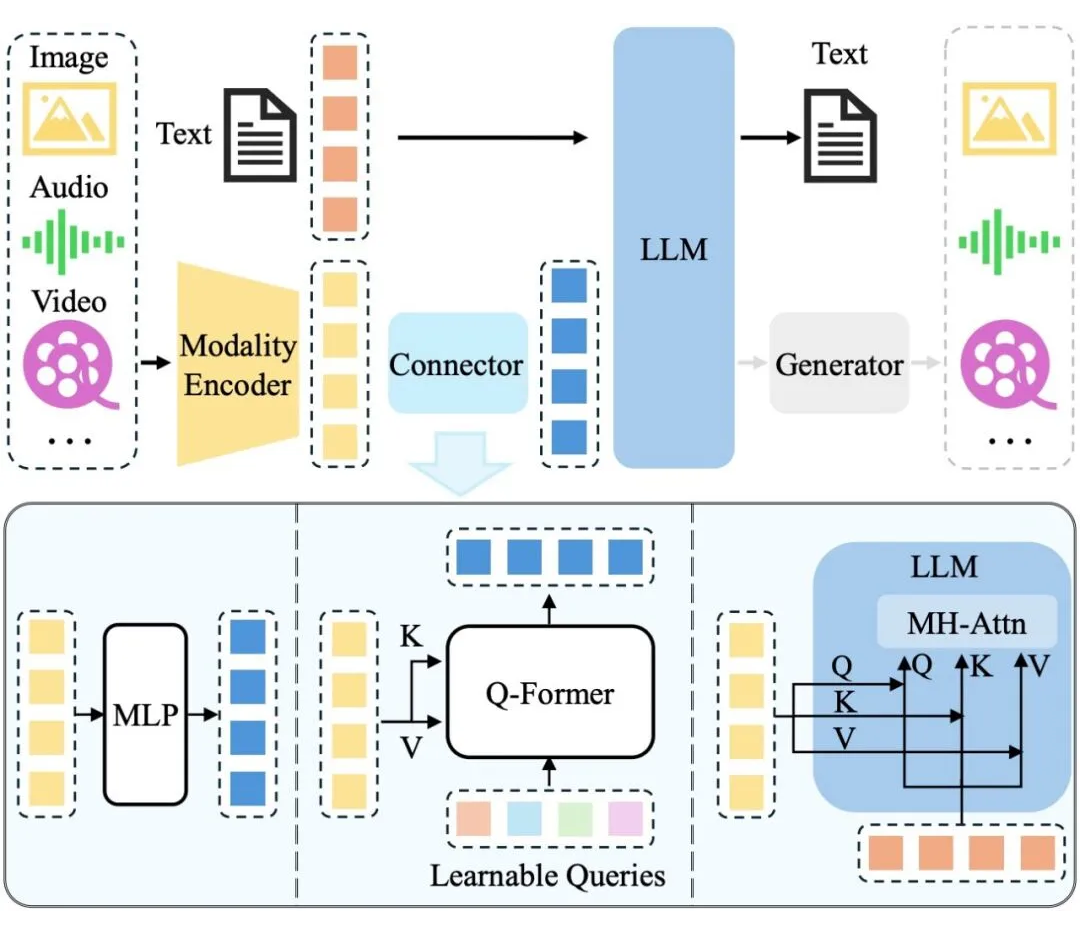

- CLIP和BLIP的区别:- CLIP:通过对比学习联合训练,预测图像和文本之间的匹配关系。即使用双塔结构,分别对图像和文本编码,然后通过计算cos进行图文匹配。- BLIP:包括两个单模态编码器(图像编码器和文本编码器)、一个图像基础的文本编码器和一个图像基础的文本解码器。BLIP通过联合训练三个损失函数:图像-文本对比损失(ITC)、图像-文本匹配损失(ITM)和语言建模损失(LM),以实

学习心得(1)scikit-learn 依赖于另外两个 Python 包:NumPy 和 SciPy。若想绘图和进行交互式开发,还应该安装 matplotlib、IPython 和 Jupyter Notebook。(2)如果不熟悉 NumPy 或 matplotlib,推荐阅读 SciPy 讲稿(http://www.scipy-lectures.org/)的第1章(3)《python机器学习基

Swift框架MoE训练并行技术选择:Megatron-SWIFT的并行技术采用zero1(默认开启use_distributed_optimizer)+各种并行技术的组合。DP的速度最快,但显存占用较多,使用其他并行技术以降低显存占用。TP/EP通信量较大,尽量不跨节点(NVLink域内),跨节点建议使用PP/DP;专家层建议使用EP而不是ETP,ETP更节约显存,但速度较慢。MoE 并行折叠:

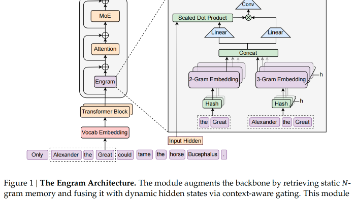

Engram:给大语言模型加了个“快速查知识的小模块”。也就是条件记忆模块,实现上,融合静态N-gram嵌入与动态隐藏状态,通过确定性寻址实现O(1)查找,以可扩展查找,作为混合专家(MoE)之外的新稀疏性维度。如此一来,原来的模型(比如MoE架构)靠“实时计算”处理信息,这个模块补了个“静态记忆库”,存着常用的短语、知识片段,后续一键调取,不用重复计算。@[toc]# 一、Engram

如题,用pycharm连接远程服务器进行项目的debug时显示:。勾选gevent compatible

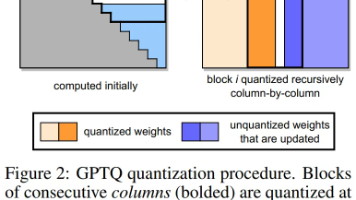

qwen3模型量化实践论文链接:https://arxiv.org/pdf/2505.02214项目链接:https://huggingface.co/collections/Efficient-ML/qwen3-quantization-68164450decb1c868788cb2b结论:权重量化的影响:在8比特时,Qwen3始终保持接近无损的性能,表明高比特量化在实际部署中仍具有很大潜力激活

GPTSwarm 是一个基于图的框架,用于基于大型语言模型(LLM)的代理,提供两个高级特性:- 它允许你从图构建基于LLM的代理。- 它支持代理群的自定义和自动自组织,具备自我改进能力。各种人为设计的提示工程技巧已经被提出,以改进基于大型语言模型(LLM)的问题解决器,产生了许多不同的代码基础。我们通过将基于LLM的代理描述为计算图来统一这些方法。每个节点实现一个函数来处理多模态数据或查询其他L

Yolov8提供了一个全新的 SOTA 模型,包括 P5 640 和 P6 1280 分辨率的目标检测网络和基于 YOLACT 的实例分割模型。和 YOLOv5 一样,基于缩放系数也提供了 N/S/M/L/X 尺度的不同大小模型,用于满足不同场景需求骨干网络和 Neck 部分可能参考了 YOLOv7 ELAN 设计思想,将 YOLOv5 的 C3 结构换成了梯度流更丰富的 C2f 结构,并对不同尺

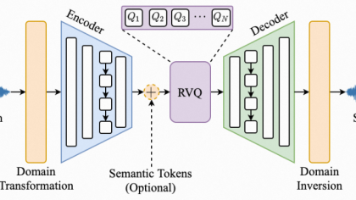

主流方案:端到端 or 级联方案(ASR + LLM + TTS)级联方案:语音输入 → ASR(语音转文本) → LLM(文本理解与生成) → TTS(文本转语音) → 语音输出CosyVoice模型:对于交互应用(如语音助手),用户希望一说话就有回应。Flow Matching 的确定性特性(每一步计算都是确定的,不像扩散模型可能有随机性)和可控的路径规划,使得 CosyVo