简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

前言我在学习机器学习和图像处理的过程中,经常会遇到卷积这个概念。我每次遇到这个概念都有点似懂非懂的样子。有时候清楚它的直观解释,但又搞不清公式中是如何体现的。究其原因,还是我没有完全搞懂这个概念。于是我在网上找了很多文章来研究,终于有了一点比较直观的印象,这里就趁热把我理解的总结一下,不足之处敬请指正。卷积的起源虽然很多文章都在介绍卷积的理论和卷积神经网络的架构,但对其来源背景都不甚了了,我在这归

出现背景(why?)在分类任务中,训练机器学习和深度学习模块需要大量的真实世界数据,并且在某些情况下,获取足够数量的真实数据存在局限性,或者仅仅是时间和人力资源的投入也可能会受到限制。概念GAN于2014年提出并在最近几年变得越来越活跃,主要用于数据扩充,以解决如何通过隐含生成模型来生成人造自然外观样本以模拟真实世界数据的问题,从而可以增加未公开的训练数据样本数量[122]。K. G. Hartm

1. 采样(sampling):一个信号通过度量它在特定时刻的振幅来进行抽样。 采样的目的是还原出声音的波形。在足够密集的采样频率下,人声的每个波形都能有多于两个的采样,这样的采样记录下说话人声音的频率和振幅(amplitude)。 在高频声音波形下,每个波形可能只有2-3个采样;而在低频声音波形下,每个波形可能有5-6个采样,每个采样宽度范围设定好,如paInt16。这样就可以在采样...

模糊神经网络(Fuzzy Neural Network, FNN)背景系统复杂度的增加,人工智能深度化发展模糊数学创始人L. A. Zadeh, 1921. 当系统的复杂性增加时,我们使它精确化的能力将减小。直到达到一个阈值,一旦超过它,复杂性和精确性将互相排斥。模糊集理论:集合讨论一个对象具有某种性质时记作A,不具有这种性质时记作非A,且两者必居其一,决不允许模棱两可,而没有考虑这种性质的程度上

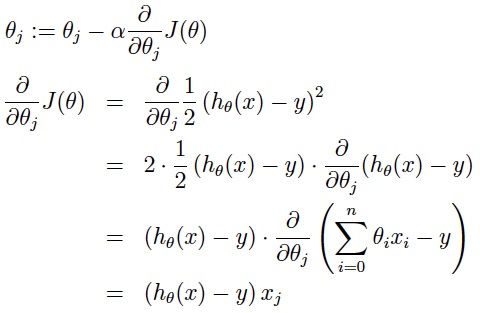

因为大家都是在一个真实的分布中得到的样本,对于分布的拟合都是近似的。想要以最快的方式下山,就沿着梯度的反方向走。下面的这张动图演示,乍看就像就像是在复杂地形中作战的沙盘推演,其实揭示的是随机梯度下降(SGD)算法的本质。同样是走一步路,坡度大的地方上升的高度就高,坡度小的地方上升的高度就小,对比现实生活中的盘山公路!了解之后,总的来说,随机梯度下降一般来说效率高,收敛到的路线曲折,但一般得到的解是

传统机器学习的主要假设之一(例如上文所述的监督学习)是用于训练分类器的训练数据和用于评估分类器的测试数据属于相同的特征空间,并且遵循相同的概率分布。但是,由于人的可变性,在许多应用中经常违反这一假设[55]。reference:A. M. Azab, J. Toth, L. S. Mihaylova, and M. Arvaneh, “A review on transfer learning a

iterationsiterations(迭代):每一次迭代都是一次权重更新,每一次权重更新需要batch_size个数据进行Forward运算得到损失函数,再BP算法更新参数。1个iteration等于使用batchsize个样本训练一次bath_sizeepochs/ˈiː.pɒk/epochs被定义为向前和向后传播中所有批次的单次训练迭代。这意味着1个周期是整个输入数据的单次向前和向后传递。

1. 背景Problem:最新的机器学习或深度学习模型的有效性受限于机器向人类和用户解释它想法和行为的能力。However, the effectiveness of these systems will be limited by the machine’s inability to explain its thoughts and actions to human users.Aim: 让用户

problem:传统的深度神经网络输入信息没有顺序。比如,NLP领域中,我们输入单词经常使用embedding,将单词映射为词向量,然后输入到神经网络。但这种输入方式有一些问题,“我 爱 你”和“你 爱 我”在传统的神经网络中不能很好的识别。虽然,有人提出n-gram信息加入到输入层,比如fasttext,这在一定程度上解决了短句子单词间的顺序问题,但是这种方法也有一些弊端,就是我们无法捕获长句子

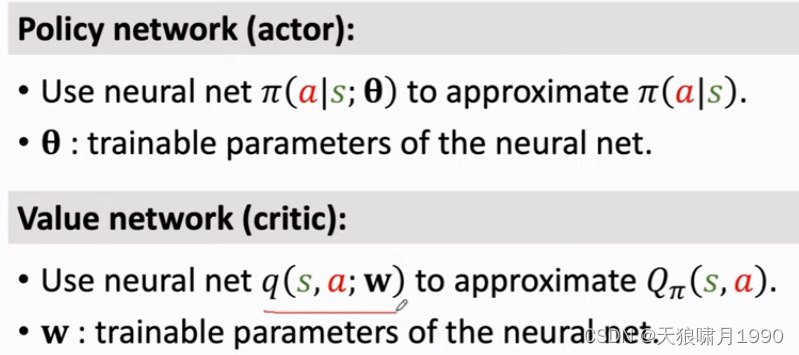

actor: 是policy network,通过生成动作概率分布,用来控制agent运动,类似“运动员”。critic: 是value network,用来给动作进行打分,类似“裁判”。