简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

nginx是一款开源的、高性能的 Web 服务器,同时也广泛用作 反向代理服务器、负载均衡器 和 HTTP 缓存。它的设计目标是解决传统服务器(如 Apache)在高并发场景下的性能瓶颈,现已成为全球最流行的 Web 服务器之一。高性能:基于事件驱动的异步架构,单机支持数万并发连接。轻量级:内存占用低,配置简单。算法灵活:轮询(Round Robin)、加权轮询(Weighted)、IP Hash

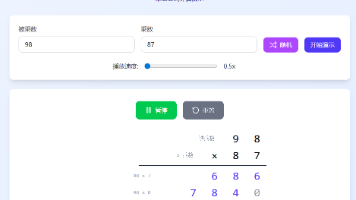

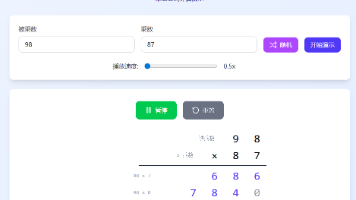

✅乘法竖式动画演示:清晰展示乘法竖式的计算步骤✅自定义数字输入:支持输入任意数进行计算✅播放控制:提供播放、暂停、重置功能✅速度调节:支持0.5x到3x的速度调节✅随机数生成:一键生成随机的乘数和被乘数。

✅乘法竖式动画演示:清晰展示乘法竖式的计算步骤✅自定义数字输入:支持输入任意数进行计算✅播放控制:提供播放、暂停、重置功能✅速度调节:支持0.5x到3x的速度调节✅随机数生成:一键生成随机的乘数和被乘数。

Vanna AI 本质是一个通过向量检索 + LLM 推理构建的可训练、可执行、可可视化的自然语义 SQL 助手。基于用户数据自定义训练 RAG拥有自动反馈学习机制支持多模型、向量库、数据库向业务人员提供图形化呈现选项严控数据隐私,全部在用户端执行通过这段脚本,我们体验了 Vanna AI 从RAG 训练 → LLM 生成 SQL → 自动可视化的完整闭环。数据分析同学再也不用手敲长 SQL,业务

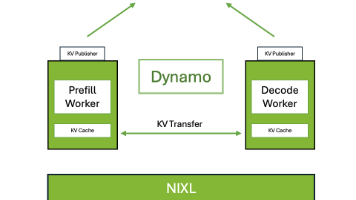

NVIDIA Dynamo 是一个高吞吐量、低延迟的推理框架,旨在为多节点分布式环境中的生成式 AI 和推理模型提供服务。Dynamo 设计为与推理引擎无关(支持 TRT-LLM、vLLM、SGLang)

Ollama 将模型权重、配置和数据打包成一个单一的包(通过Modelfile管理)。它简化了模型的下载、部署和管理过程。

参考TensorRT-LLM 是 NVIDIA 推出的一个开源库,旨在利用 TensorRT 深度学习编译器优化和加速大型语言模型(LLMs)的推理性能。它专为开发者设计,支持在多 GPU 环境中高效运行 LLMs。

在 MCP(Model Context Protocol)中,tool和MCP 中的 tool是定义在 MCP 服务器上的功能模块,通过 MCP 协议暴露给客户端。具有封装性、可发现性和异步性等特点。是 LLM 调用外部函数的能力,增强了模型的能力,使其能够借助外部资源解决问题。特点包括增强模型能力、动态交互、参数传递与结果处理等。二者关系MCP 中的 tool 是具体的工具实现,function

本文探讨了在vLLM推理服务中实现GPU计算即时停止的方法。作者通过三种方式验证了停止生成的效果:1) 同步HTTP请求,2) 异步HTTP请求(httpx.AsyncClient),3) OpenAI官方SDK调用。实验表明,当用户点击停止按钮时,vLLM后台确实会终止计算并释放GPU资源,日志中会显示"Aborted request"记录。值得注意的是,是否显式调用resp