简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

如何在本地部署LLM并调用api进行大模型推理

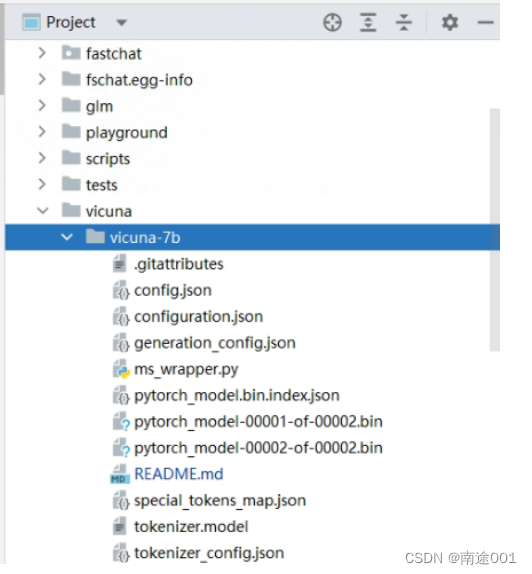

到这里,api就部署好了,可以通过下面的代码,验证是否部署成功(确保安装了openai)b:启动模型工作器,等待进程加载模型完成(图中是glm3,但是不影响)看到"Uvicorn running on ..."的提示就ok。下载完成之后进入FastChat文件夹,升级pip及安装依赖。注:以上命令均在pycharm里的Terminal配置。c:最后,启动 RESTful API 服务器。可以使用下

到底了