简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

12.04下面:sudo apt-get install ia32-libs14.04下面:sudo apt-get install libglib2.0-0:i386

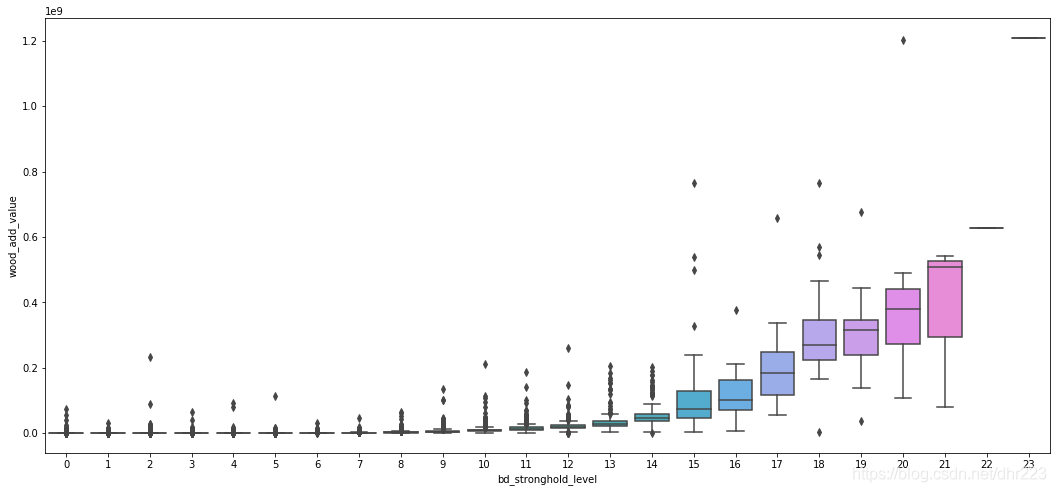

前天参加面试的时候被问了一个题:选择什么样的指标来代表总体情况?我回答的不是很好,具体怎么回答的记不太清了,感觉回答的不是很好。那这里就引申出一个问题,异常值的识别。异常值(outlier)是数据清洗的重要环节,异常值可能直接会导致后面的数据分析、建模工作出现偏差,因为像AdaBoost、GBDT等都对异常值很敏感。

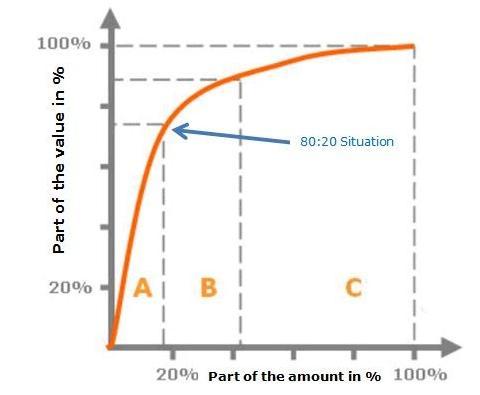

很多人都知道二八定理,即20%的人掌握着80%的财富。源出处是80/20帕累托法则,很有名的ABC分类法可以说是该法则的衍生。比如一共有100件商品,10件商品占销售总额的70%,20件商品占销售总额的20%,还有70件商品仅占销售总额的10%。于是你可以按照70%,20%,10%的销售额比重把产品分为ABC三类,然后把重点的管理资源放在A,把较少的资源分配给C或者砍掉部分C商品,以达到资源管理的

这是简易数据分析系列的第 13 篇文章。在前面的课程里,我们抓取的数据都是在同一个层级下的内容,探讨的问题主要是如何应对市面上的各种分页类型,但对于详情页内容数据如何抓取,却一直没有介绍。比如说我们想抓取 b 站的动画区 TOP 排行榜的数据:https://www.bilibili.com/ranking/all/1/0/3按之前的抓取逻辑,我们是把这个榜单上和作品有关的数据抓取一遍,比如说下图

这是简易数据分析系列的第 7 篇文章。在第 4 篇文章里,我讲解了如何抓取单个网页里的单类信息;在第 5 篇文章里,我讲解了如何抓取多个网页里的单类信息;今天我们要讲的是,如何抓取多个网页里的多类信息。这次的抓取是在简易数据分析 05的基础上进行的,所以我们一开始就解决了抓取多个网页的问题,下面全力解决如何抓取多类信息就可以了。我们在实操前先把逻辑理清:上几篇只抓取了一类元素:电影名字。这期我们要

Gant图甘特图是一种条形图,最初由Karol Adamiecki于1896年开发,并由Henry Gantt于1910年独立开发,用于说明项目进度表。甘特图说明了项目的终端元素和摘要元素的开始和结束日期。Mermaid可以渲染甘特图。gantttitle A Gantt DiagramdateFormatYYYY-MM-DDsection Sectio...

这是简易数据分析系列的第 2 篇文章。上篇说了数据分析在生活中的重要性,从这篇开始,我们就要进入分析的实战内容了。数据分析数据分析,没有数据怎么分析?所以我们首先要学会采集数据。我调研了很多采集数据的软件,综合评定下来发现最好用的还是Web Scraper,这是一款Chrome 浏览器插件。