简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

1. 信息量和信息熵熵是表征系统混乱度/不确定度的物理量,在热力学、信息学中都有其各自的含义,而在机器学习更多沿用了信息熵的概念,即解释随机变量分布所需要的信息量(下文给出数学定义),或者从信息编码的角度来说,用某种方式对随机变量分布进行编码所需要的编码信息长度。假设一个离散型随机变量xxx,其分布为p(x)p(x)p(x),如何计算其熵呢,我们先引入信息量的概念:事件发生所蕴含的信息。比如对..

在 集成学习(一)概述中,我们简要介绍了集成学习的核心思想的三大主流框架。本文重点介绍boosting框架中,基于样本权值调整的一种算法:AdaBoost。AdaBoost(Adaptive Boosting),顾名思义,是一种自适应式的boosting算法,即每轮按照预测的规则,自动调整子学习器中训练样本的权重和子学习器的线性权重。一、正、负样本权重的平衡...

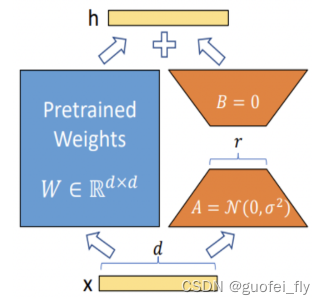

LLM大模型的参数量以B(10亿)为单位,动辄迁百亿、千亿。如何在已经训练好的、性能优异的底座模型基础上,通过微调的方式,来实现对模型的性能优化、知识注入、领域迁移和风格对齐等调整,是一件非常有使用场景的工作。Xtuner是上海人工智能实验室推出的用于LLM微调的一站式工具,其:1)模型方面:支持InternLM、Qwen、Baichuan、ChatGLM等国内主流开源大模型,以及Llama、Mi

深度学习模型训练常见策略

在机器学习中,各个特征代表着高维度空间的信息。因此在数据的处理和算法的推导上,往往借助于矩阵和线性代数的基本理论。该系列希望通过对相关概念和公式的推导,加深对矩阵和线性代数的理解。在这篇文章中,通过问答的形式阐述基本概念。1. 向量和矩阵的意义?就像数字1、2一样,向量和矩阵是人为设计的用来记录数据载体。从不同的角度来看,其存在不同的解释。从计算机工作者的眼中,其可以用来记录有序的数据(列表)..

如果“兑”的结果是将一种液体与另一种液体混合,并且混合后的液体中水分的含量低于原来的液体,那么我们可以推断出“兑”的结果是得到了“稀水”。2.

使用Xgboost模型需使用单独的Xgboost库,该库提供了两种Python接口风格。一种是XGBoost自带的原生Python API接口,另一种是sklearn风格的API接口,两者的实现方案基本一致,仅有细微的API使用的不同(此外,部分原生的参数并未在sklearn风格的API接口中实现),在执行效率上原生接口往往更胜一筹,但sklearn风格更容易与其它sklearn中的算法模型进行比

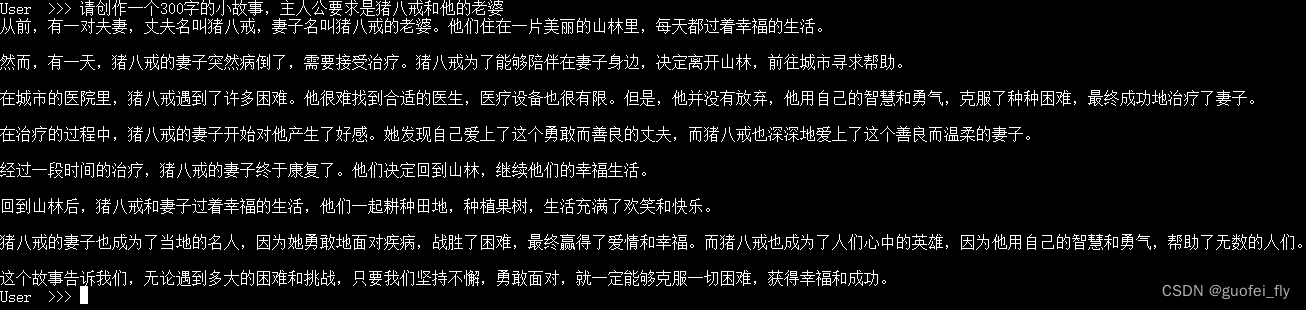

该chat-model是利用《西游记》剧本中所有关于猪八戒的台词和语句,以及Chat-GPT-3.5生成的相关问题结果,基于InternLM2-chat-1.8b进行全量微调得到的模仿猪八戒语气的聊天语言模型。在第一期实战营中,部分学员运用 InternLM2-Chat-1.8B 模型进行微调训练,产生了一些效果不错的role play模型,本期给出的示例是。是上海人工智能实验室提供的18亿参数“

近端梯度法是一种求解不可微凸函数最优化问题的经典方法。其核心思想在于将不可微凸函数的最优化问题转换为易求解的proximal映射函数,从而实现近似求解。一、proximal映射proximal映射是近端梯度法的核心方法。假设约束函数f(x)f(\boldsymbol x)f(x)的定义域为U\boldsymbol UU,定义自变量x\boldsymbol xx的proximal映射为:prox..

expand和repeat函数是pytorch中常用于进行张量数据复制和维度扩展的函数,但其工作机制差别很大,本文对这两个函数进行对比。1. expandtensor.expand(*sizes)expand函数用于将张量中单数维的数据扩展到指定的size。首先解释下什么叫单数维(singleton dimensions),张量在某个维度上的size为1,则称为单数维。比如zeros(2...