简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

《考研失利到50万年薪:应届生的算法岗逆袭之路》摘要:25届毕业生北北分享从考研失败到1个月内斩获大模型算法岗的经验。作为非985本科生,他通过400次沟通获得50多场面试,总结出求职关键:1)用面试反馈迭代简历;2)分层次准备项目讲解;3)突出技术选型逻辑而非堆砌新技术。他强调工程思维和优化能力比学历更重要,建议先实践再深挖原理的学习方法,并警惕竞赛同质化陷阱。目前他在预训练方向工作,认为扎实算

从“陪聊”到“生产力”:企业级大模型项目落地的核心技术要求

栏目涵盖了微调的主要目的、微调后能力变化的原因、数据量不足的解决方案、数据集清洗的可行性、多模态数据微调的适用性等多个技术问题,并提供了详细的解答和建议。此外,社区还提供了硬件配置自查表,帮助成员评估模型效果和处理时序数据。社区鼓励成员提出具体、明确的问题,并提供了多种途径来获取答案,包括社群提问、直播答疑和智能搜索等。赋范大模型技术社区致力于为成员提供最有价值的技术赋能,内容完全免费,涵盖工业级

而最最最关键的是,OpenAI还开源了能实现response API全套功能的OpenAI Agents SDK,不同于去年开源的swarm是一个实验项目,现在的Agents SDK是一个真正意义的企业级Multi Agent开发工具,这也是OpenAI截止目前最有诚意的开源项目。观前提醒,这场发布会信息量巨大,光是更新的技术文档就有3万多字,我尽量用通俗的语言帮大家梳理最高价值的信息,此外,我们

WeKnora是腾讯开源的文档理解与语义检索框架,支持多模态文档处理、智能问答和RAG机制。其特点包括开箱即用的WebUI、多模态解析能力、灵活配置和跨平台访问。应用场景涵盖企业知识管理、科研分析、技术支持等领域。部署需安装Docker和Git,通过可视化界面可配置模型参数。WeKnora还支持通过MCP服务器远程访问,实现便捷的文档问答服务。

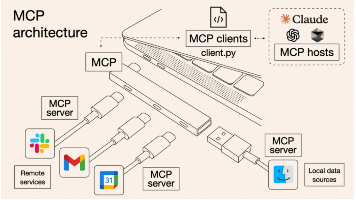

MCP,全称是Model Context Protocol,模型上下文协议,由Claude母公司Anthropic于去年11月正式提出。从本质上来说,MCP是一种技术协议,一种智能体Agent开发过程中共同约定的一种规范。这就好比秦始皇的“书同文、车同轨”,在统一的规范下,大家的协作效率就能大幅提高,最终提升智能体Agent的开发效率。截至目前,已上千种MCP工具诞生,在强悍的MCP生态加持下,

Llama-Index实战演示企业级RAG检索的七大场景,解决检索准确性和多模态解析两大难题。提供完整源码

“垂直领域应该用微调还是RAG?”“我是要做金融领域的大模型开发,选微调还是RAG?

「Agentic时代同行计划」旨在集结群体智慧,分享个人经历与经验,共同迎接技术新时代。受访者Ren,三本自学背景,转行成为大模型开发工程师,分享了他的职业转型之路。Ren从通信工程专业自学转行,经历了考研失败、销售工作,最终通过自学和实习,成功进入大模型开发领域。他强调,解决问题的能力是核心竞争力,而非学历或专业背景。Ren通过实际工作经验,展示了如何通过数据分析和问题解决,提升业务指标,从而获

整体来看,QwQ除了在逻辑推理能力、真实物理世界理解能力,以及科研能力方面,和DeepSeek R1有一定的差距外,其他方面能力,如编程、数学、长文本编写、问答和翻译等,均能达到85%以上DeepSeek R1的水准。看起来两个模型的问答都很精彩,但相比之下QwQ模型对于拿破仑的知错改错不认错的性格,把握的更加到位,这点可以在QwQ模型的思考过程中看出。QwQ-32B模型性能评测来啦!最后一个问题