简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

AI生成音乐技术近年来迅猛发展,不仅使音乐创作的门槛大幅降低,还使得创意过程变得更加高效和多样化。精英创企和大厂在这场音乐革命中扮演了重要角色,分别在技术创新和市场推广方面起到了至关重要的作用。AI技术在音乐创作中的应用,既带来了前所未有的机遇,也引发了诸多挑战。通过合理利用AI技术,音乐人可以获得更多灵感和技术支持,创作出更加丰富多样的音乐作品。同时,通过制定相关法规和开展教育培训,可以有效应对

DeepSeekMine迎来V2.1.7版本重大更新,支持官网直下载。主要升级包括:本地模型响应速度提升15%-40%,远程模型实现3秒内快速响应;新增Doc文档读取功能,优化多轮对话连贯性;改进中英文混合检索准确性及输出样式。特别推出内置Ollama安装包的一键下载功能,并修复多项bug。Mac用户若遇安装问题,可通过终端命令解决。开发者邀请用户通过反馈表单提交使用建议。关注官方直播间可获取更多

DeepSeekMine是我们团队开发的一款本地知识库管理软件,历时近四个月,现已推出支持Windows、Mac和Linux的Docker版本,实现一键安装。软件支持完全本地运行,具备高效的RAG查询生成能力,可处理数十至数百GB本地文件。用户只需安装Docker并部署DeepSeekMine镜像,即可通过浏览器访问localhost:3000使用。支持文件/文件夹上传、快速加载、多轮对话及多模型

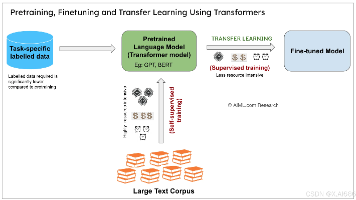

近年来,随着Transformer模型的出现,BERT、GPT-3等模型在语义分析、情感分析、机器翻译和问答系统等任务上不仅效果更好,而且速度更快。近年来,深度学习技术取得了惊人的发展,应用范围不断扩大,涵盖了社交网络、自动驾驶、医疗诊断、金融预测等众多领域。另外,生成对抗网络(GAN)的出现,则引领了计算机视觉领域新的发展方向,如图像合成、图像到图像翻译、视频生成等。深度学习源于人工神经网络,这

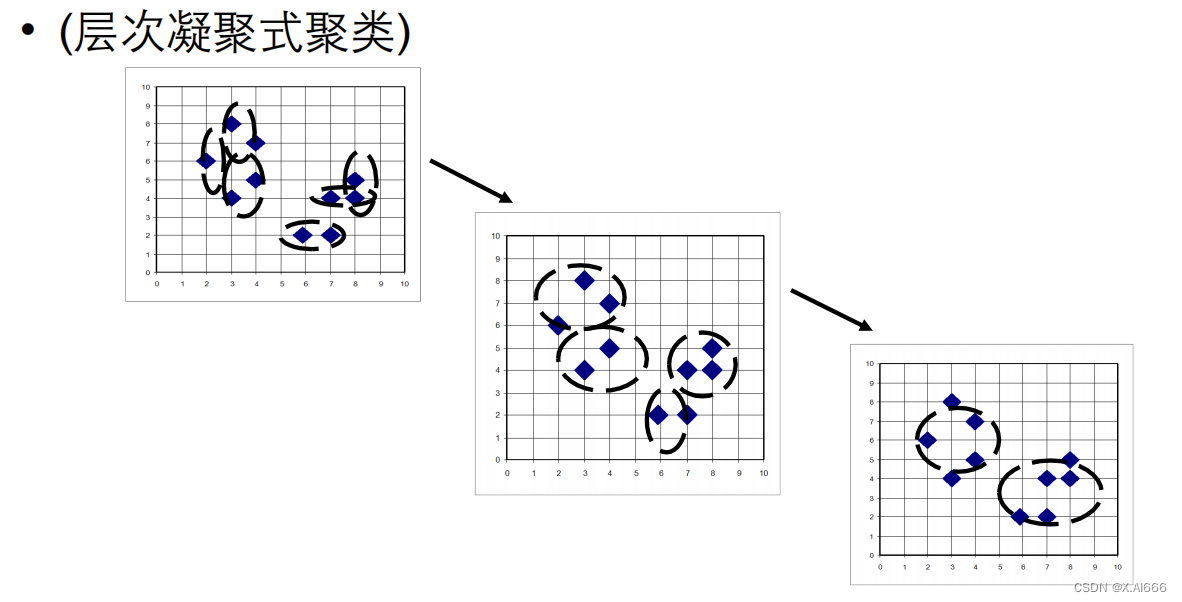

无监督学习的目标是发现数据中的自然分组或模式,而不需要任何外部指导或标签。这种学习方式适用于探索性数据分析、自然语言处理、图像识别等领域,能够揭示数据的潜在结构,为进一步的数据分析和决策提供支持。无监督学习以其在未标记数据上发现模式和结构的能力,在机器学习领域占据着举足轻重的地位。通过不断的研究和应用,无监督学习不仅推动了数据科学的发展,也在日常生活中的应用中展现出了其独特的价值。从推荐系统到社交

AI生成音乐技术近年来迅猛发展,不仅使音乐创作的门槛大幅降低,还使得创意过程变得更加高效和多样化。精英创企和大厂在这场音乐革命中扮演了重要角色,分别在技术创新和市场推广方面起到了至关重要的作用。AI技术在音乐创作中的应用,既带来了前所未有的机遇,也引发了诸多挑战。通过合理利用AI技术,音乐人可以获得更多灵感和技术支持,创作出更加丰富多样的音乐作品。同时,通过制定相关法规和开展教育培训,可以有效应对

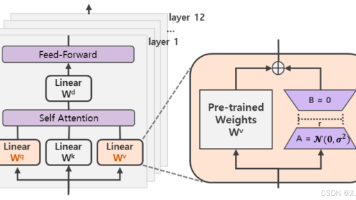

LoRA系列方法通过低秩分解实现大模型高效微调。LoRA利用降维矩阵模拟参数更新,显著减少参数量;AdaLoRA动态分配参数预算,基于重要性评分调整矩阵秩;QLoRA结合4bit量化与适配器微调,在保证性能的同时降低显存消耗。实验表明,这些方法在不同任务中均能媲美全量微调效果,且QLoRA首次实现4bit量化下的无损微调。这些技术为大规模语言模型的高效适配提供了实用解决方案。

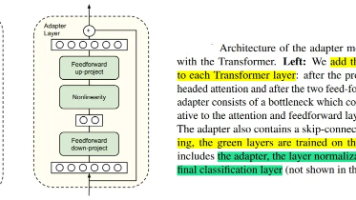

大模型参数高效微调技术:Adapter Tuning及其变体 本文综述了Adapter Tuning及其几种改进变体,这些技术旨在解决大模型全量微调的高计算成本问题。核心方法是在预训练模型的Transformer层中插入少量任务特定参数(Adapter模块),仅微调这些新增参数而非整个模型。主要变体包括: AdapterFusion:通过两阶段学习(知识提取+组合)实现多任务知识融合 Adapte

摘要 增量预训练是将领域知识注入大模型的有效方法,其流程包括:选择底座模型、收集TB级数据并进行清洗、选用合适训练框架(3D并行/张量并行/LoRA)、确定数据混合策略。训练时需处理数据至统一长度、调整分词器和模型层名,最后进行模型转换和基础测试。关键是通过高质量数据提升信息密度,优化模型学习效率。

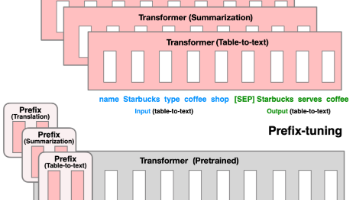

本文介绍了四种高效微调预训练语言模型的方法:BitFit、Prefix Tuning、Prompt Tuning和P-Tuning。BitFit通过仅更新模型中的bias参数实现微调,参数量仅占0.08%-0.09%,效果接近全量微调;Prefix Tuning为不同任务添加可训练的前缀参数,在生成任务中表现优异;Prompt Tuning简化了Prefix Tuning,仅在输入层添加可学习的p