简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

OpenPose 的核心创新在于其自下而上(Bottom-Up)的算法流程和部分亲和场(PAFs)。自下而上的流程第一步:检测所有关键点。首先,一个卷积神经网络(CNN)会扫描整个图像,预测出一个包含所有可能人体关键点的“热度图”。热度图中每个“热点”代表一个特定类型关键点(如左肩、右膝)可能存在的位置。第二步:将关键点组装成人体。在检测出所有独立的关键点后,需要解决“哪个关键点属于哪个人”的问题

WEB VIDEO PLATFORM是一个基于、部标808、部标1078标准实现的开箱即用的网络视频平台,负责实现核心信令与设备管理后台部分,支持NAT穿透,支持海康、大华、宇视等品牌的IPC、NVR接入。支持国标级联,支持将不带国标功能的摄像机/直播流/直播推流转发到其他国标平台。流媒体服务基于@夏楚 ZLMediaKit播放器使用@dexter jessibuca播放器使用@Numberwol

OpenPose 的核心创新在于其自下而上(Bottom-Up)的算法流程和部分亲和场(PAFs)。自下而上的流程第一步:检测所有关键点。首先,一个卷积神经网络(CNN)会扫描整个图像,预测出一个包含所有可能人体关键点的“热度图”。热度图中每个“热点”代表一个特定类型关键点(如左肩、右膝)可能存在的位置。第二步:将关键点组装成人体。在检测出所有独立的关键点后,需要解决“哪个关键点属于哪个人”的问题

“拜占庭将军问题”维基百科:拜占庭将军问题(Byzantine Generals Problem),是由莱斯利·兰波特在其同名论文中提出的分布式对等网络通信容错问题。在分布式计算中,不同的计算机通过通讯交换信息达成共识而按照同一套协作策略行动。但有時候,系统中的成员计算机可能出错而发送错误的信息,用于传递信息的通讯网络也可能导致信息损坏,使得网络中不同的成员关于全体协作的策略得出不同结论,从...

临时表就是用来暂时保存临时数据(亦或叫中间数据) 的一个数据库对象, 它和普通表有些类似, 然而又有很大区别。它只能存储在临时表空间, 而非用户的表空间。临时表是会话或事务级别的, 只对当前会话或事务可见。每个会话只能查看和修改自己的数据。临时表的分类:事务级 (On Commit Delete Rows)数据在 Transaction 期间有效一旦COMMIT后,rollback,断开连接,数据

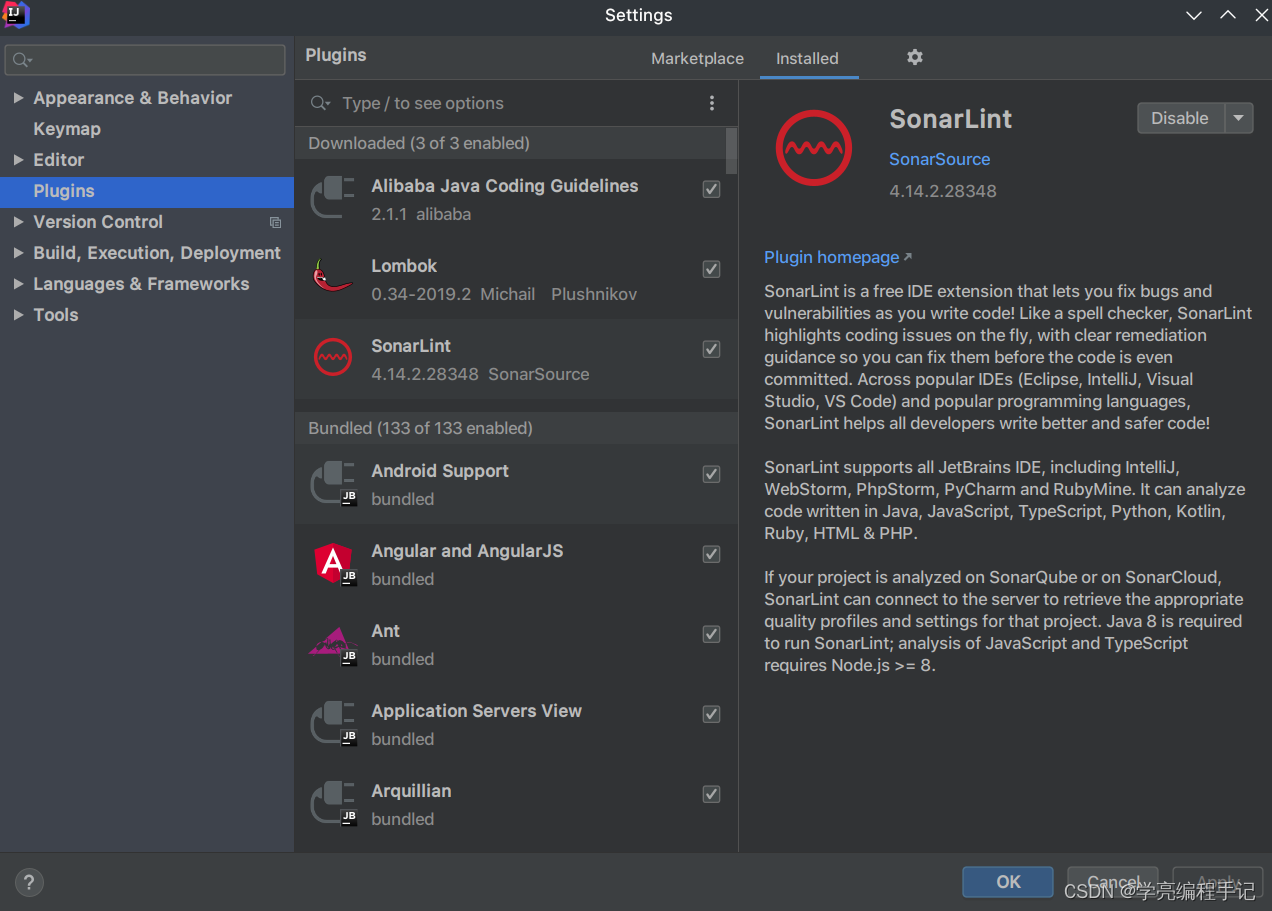

中搜索sonarlint,安装后重启idea。

OSI七层协议一、OSI参考模型今天我们先学习一下以太网最基本也是重要的知识——OSI参考模型。1、OSI的来源OSI(Open System Interconnect),即开放式系统互联。 一般都叫OSI参考模型,是ISO(国际标准化组织)组织在1985年研究的网络互连模型。ISO为了更好的使网络应用更为普及,推出了...

临时表就是用来暂时保存临时数据(亦或叫中间数据) 的一个数据库对象, 它和普通表有些类似, 然而又有很大区别。它只能存储在临时表空间, 而非用户的表空间。临时表是会话或事务级别的, 只对当前会话或事务可见。每个会话只能查看和修改自己的数据。临时表的分类:事务级 (On Commit Delete Rows)数据在 Transaction 期间有效一旦COMMIT后,rollback,断开连接,数据

GeoMesa-空间数据存储引擎geomesa简介、架构体系、数据存储、spark等第一部分:GeoMesa简介GeoMesa是一款开源的基于分布式计算系统的⾯面向海海量量时空数据查询与分析的⼯工具包GeoMesa基于GeoToolsAPI进⾏行行设计,与GeoServer等进⾏行行集成提供OGC标准的服务。⽀支持多种可扩展的、基于云端的数据存储架构,包括ApacheAccumulo,HBase,

直接使用特定服务类普通消息:注入事务消息:注入通过统一接口:注入接口代码复用性高配置集中管理异常统一处理支持普通消息和事务消息支持延迟消息易于扩展新功能根据项目复杂度可以选择适合的使用方式,简单项目可以直接使用服务类,复杂项目建议使用统一接口以便于维护和扩展。