简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

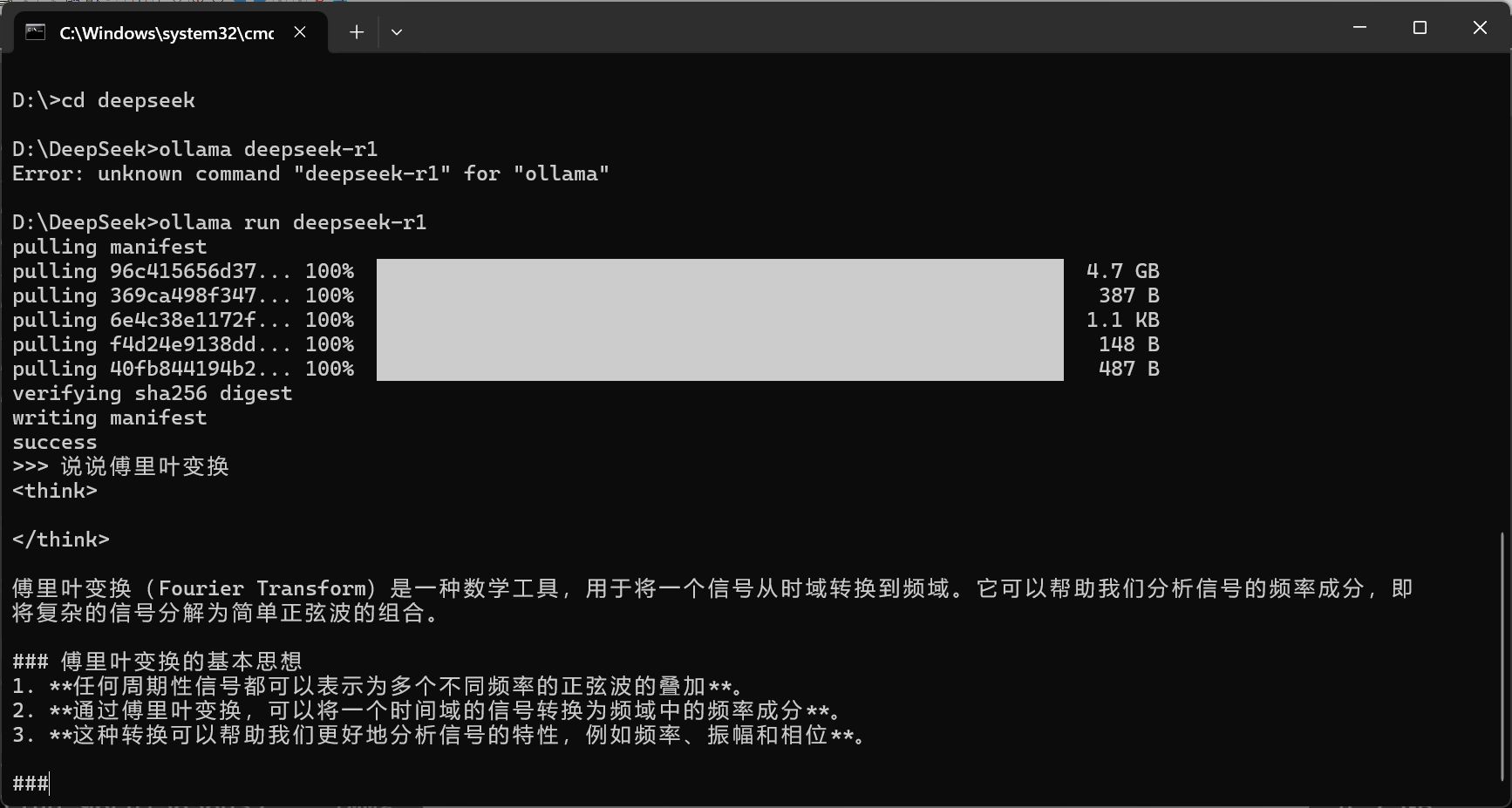

春节期间,DeepSeek大出圈,试过本地SD的我也尝试着做了一下本地部署,没想到,太简单了,几乎不需要做任何处理!1,ctrl+alt+delete打开任务管理器,选则性能,然后提一个复杂点的问题,看CPU与GPU的负荷情况。再之后是8b,属于Ollama3蒸馏,大约4.9G,从测试得分看,还不如7b,所以是我的首选。我这里大约150kB/s。最轻量的是1.5b,即15亿参数,约1.1G,是De

春节期间,DeepSeek大出圈,试过本地SD的我也尝试着做了一下本地部署,没想到,太简单了,几乎不需要做任何处理!1,ctrl+alt+delete打开任务管理器,选则性能,然后提一个复杂点的问题,看CPU与GPU的负荷情况。再之后是8b,属于Ollama3蒸馏,大约4.9G,从测试得分看,还不如7b,所以是我的首选。我这里大约150kB/s。最轻量的是1.5b,即15亿参数,约1.1G,是De

春节期间,DeepSeek大出圈,试过本地SD的我也尝试着做了一下本地部署,没想到,太简单了,几乎不需要做任何处理!1,ctrl+alt+delete打开任务管理器,选则性能,然后提一个复杂点的问题,看CPU与GPU的负荷情况。再之后是8b,属于Ollama3蒸馏,大约4.9G,从测试得分看,还不如7b,所以是我的首选。我这里大约150kB/s。最轻量的是1.5b,即15亿参数,约1.1G,是De

春节期间,DeepSeek大出圈,试过本地SD的我也尝试着做了一下本地部署,没想到,太简单了,几乎不需要做任何处理!1,ctrl+alt+delete打开任务管理器,选则性能,然后提一个复杂点的问题,看CPU与GPU的负荷情况。再之后是8b,属于Ollama3蒸馏,大约4.9G,从测试得分看,还不如7b,所以是我的首选。我这里大约150kB/s。最轻量的是1.5b,即15亿参数,约1.1G,是De

可以看到,7B模型的数据大多数超出8B,而大小还小一点,所以选择是当然的。来源:DeepSeek官方数据(