简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

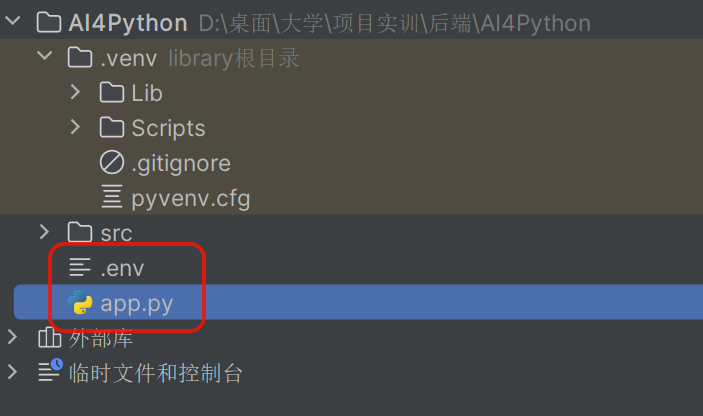

【项目博客】基于DeepSeek的Python代码助手(五)

本文将详细介绍该项目vscode侧边栏的创建、前端用户界面的框架选择与搭建、主题背景的切换设计等。

【项目博客】基于DeepSeek的Python代码助手(二)

在请求阶段发生错误(如请求格式无效、配置错误)时,接口会返回标准的 JSON 错误响应,而不是 SSE 流。本系统为 Python 开发助手,通过与后端的交互,利用 AnythingLLM 的知识库和。对于流式接口,开始流式传输之后,就不能再返回普通的 HTTP 错误码。处理在读取和解析 AnythingLLM 流过程中的错误,在生成器内部。处理与 AnythingLLM 建立连接时的错误,在生成

到底了