简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

总结一下,注意力机制让 transformer 能混合信息,但如果混合得太随意,那么一个 token 的小改动可能会影响整个序列(或者说影响很多 token),这就是“混过头”了(overmixing)。另外,如果某些 token 成为注意力黑洞,模型中的信息流可能会被改变,导致模型忽视了其它 token 中的重要上下文信息。总之,预训练策略会影响注意力黑洞的形成方式,但无论如何,第一个 toke

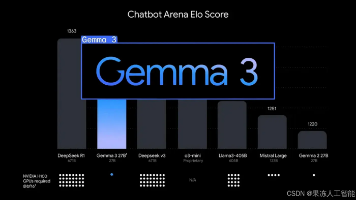

在人类评估者(Chiang 等,2024)进行的盲测对比评估中,Gemma 3 展现出了令人印象深刻的性能。根据该公司在博客文章中的说法,它是“全球最佳的单加速器模型”,在单 GPU 主机上超越了 Meta 的 Llama、DeepSeek 以及 OpenAI 的 o1-preview 和 o3-mini-high。Gemma 3 还在零样本基准测试中进行了评估,比较了其在各种能力上的表现,不仅与

比如你可以安装 Google Calendar MCP,把它接入你的 AI 智能体,让它能访问和管理你的日程安排。如果听起来无聊或者很复杂,别担心 —— 这是个非常简单又有效的工具,可以帮你从零开始构建更好的 AI 智能体。但有了 MCP 服务器的帮助,这个过程就简单多了,而且是标准化的,可以让你和工具互动并大规模构建智能体。现在有了 MCP,你只需要和你的 LLM 沟通,就能完成这些操作,根本不

这一部分,我们来解释一些业界常用的推理性能指标,比如“首 Token 时间”(Time to First Token,简称 TTFT)和“Token 间延迟”(Intertoken Latency,简称 ITL)。两者可能会互相叠加,影响整体响应时间。这篇文章,主要聚焦在 LLM 吞吐量(throughput)和延迟(latency)的测量,这也是评估 LLM 应用成本的一部分。一开始,随着并发请

话虽如此,最近我收到了一些代码作业,一看就完全是 AI 写的,于是我整理了一些“AI 征兆”。作为一名数据科学和数学老师,我其实不介意我的学生使用像 ChatGPT 这样的 LLM,只要它是用来辅助他们学习,而不是取代学习过程。用这些工具探索库当然没问题,但也可能说明实现方式就是 AI 生成的。我觉得这用来注释一行代码的方式很不自然,尤其是我在课上明确教的是用 # 来写单行注释,而这段也不是一个正

这是一篇关于在你的应用里使用一种新型软件的文章。你肯定听说过了——它叫做 AI。下面你不会看到什么高级概念、智能体、RAG、聊天机器人,也不会有关于“很快就能做到”的承诺。大多数例子甚至不会直接让用户看到 AI 生成的文字。相反,它们只是一些简单的例子,讲讲怎么用 AI 在你的应用里做决策。

最近我一直在鼓捣 AI —— 主要是 Claude —— 但它光是回答问题让我有点无聊了。我想让它干点事儿,你懂的吧?比如从网站抓数据,或者去翻我 GitHub 的项目。这时候我发现了一些叫 MCP 服务器的东西。它们就像小帮手一样,让你的 AI 能和工具、应用打交道。开源的,免费的,而且说实话还挺好玩。我来说说我试过的五个,让我当场惊呼:“卧槽,这也太牛了吧。

在使用公有云模型(如 DeepSeek、豆包,Kimi,ChatGPT、Claude、Gemin)时,员工在日常操作中往往无感知地将企业数据上传至服务提供方的 AI 系统。这种看似无害的交互,在日积月累中将逐步暴露企业的核心信息与商业机密,形成系统性泄漏风险。

尽管 R1-Zero 的“思考”标记(thinking tokens)提供了一个人类可读的窗口,让我们得以窥探模型的“思维过程”,但论文作者也指出了一些问题。请注意,它在给出最终答案之前,使用了一个超长的链式思维(CoT)推理过程,并且增加了额外的验证步骤。在上面的图表中,纵轴是模型在AIME(数学问题)上的表现,横轴是不同的计算时间。o1的一个关键特性就是它的所谓“思考”标记。这些是在后训练(p

在智能开发全面爆发的 2025 年,懂得用对工具就能事半功倍。作为🔧 技术实战派|AI软硬件一体解决者,我长期关注 AI 工具链的整合与落地,从芯片设计、电路开发、GPU部署 → Linux系统、推理引擎 → 模型训练与实际应用,今天就来分享 5 款真正能让工作流程“飞起来”的 MCP 服务器。