简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

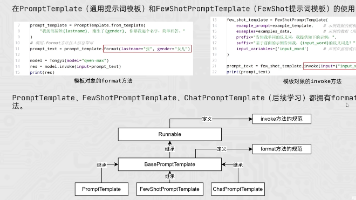

【代码】黑马大模型RAG与Agent智能体实战教程LangChain提示词——16、RAG开发——模板类format()和invoke()方法(所有模板类都继承了Runnable类,拥有这两个方法)

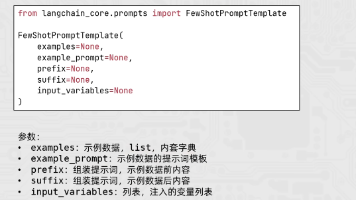

"""FewShot 提示词模板(FewShotPromptTemplate)用法示例本示例演示如何使用 LangChain 的 FewShotPromptTemplate 来构建少样本学习(Few-Shot Learning)提示词。FewShotPromptTemplate 的核心参数:- examples: 示例数据,list,内套字典(每个字典代表一个示例)- example_prompt

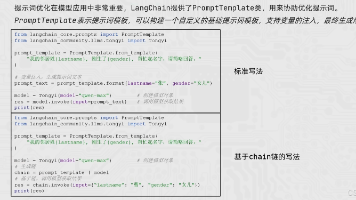

"""通用提示词模板(PromptTemplate)用法示例本示例对应课件中的两段代码:1)标准写法(先生成提示词文本,再喂给模型):"我的邻居姓{lastname},刚生了{gender},帮忙起名字,请简略回答。

"""使用 LangChain 访问阿里云通义大模型(Tongyi)示例本示例对应课件中的代码片段:res = llm.invoke("帮我讲个笑话吧")print(res)在此基础上,我们做了以下增强:- 使用 .env / 环境变量中读取 API Key- 演示多轮调用与不同提示词- 对返回结果增加简单的格式化输出"""import os"""初始化 Tongyi LLM 模型实例。

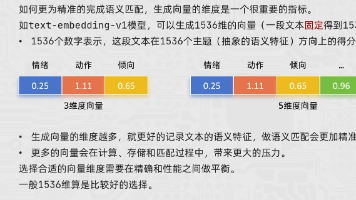

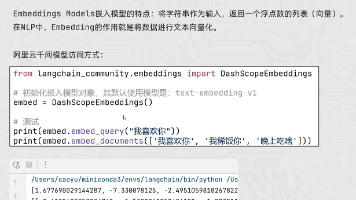

"""LangChain 嵌入模型(Embeddings)调用示例本示例演示如何在 LangChain 中使用阿里云 DashScope 的嵌入模型:- 使用 `DashScopeEmbeddings` 创建嵌入模型实例- 调用 `embed_query()` 对单条文本生成向量- 调用 `embed_documents()` 对多条文本批量生成向量核心概念:- Embedding(向量化):将一

Runnable 不仅是 LangChain 的技术抽象,更是一种设计哲学“让每个组件专注单一职责,并通过标准接口无缝协作”掌握 Runnable,意味着你真正拥有了构建健壮、可观测、易维护的 LLM 应用的能力。下次当你设计 LangChain 应用时,不妨自问:✨“这个环节能否封装为 Runnable?能否用组合得更优雅?✨。

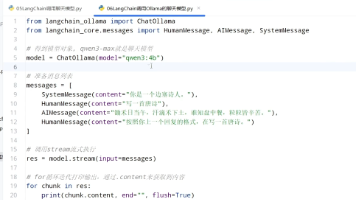

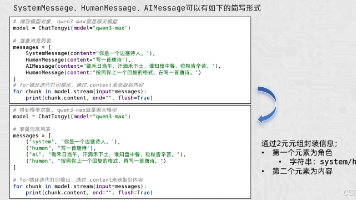

"""使用 LangChain 调用通义聊天模型(ChatTongyi)示例本示例演示如何使用 LangChain 的 ChatTongyi 进行多轮对话,包括:- SystemMessage:设置系统角色- HumanMessage:用户消息- AIMessage:AI 回复消息- 流式输出:实时显示模型生成的内容核心概念:- ChatTongyi:聊天模型,与 Tongyi LLM 不同,专门

https://www.bilibili.com/video/BV1yjz5BLEoYhttps://hzh.sealos.run/运行代码结果:

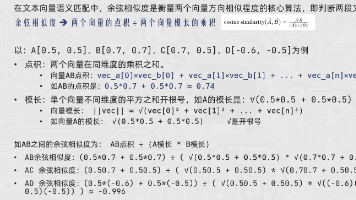

"""余弦相似度算法介绍与实现余弦相似度(Cosine Similarity)是一种常用的相似度度量方法,广泛应用于:- 文本相似度计算- 推荐系统- 信息检索- 向量空间模型- RAG(检索增强生成)中的文档检索原理:余弦相似度通过计算两个向量的夹角余弦值来衡量它们的相似程度。公式:cos(θ) = (A · B) / (||A|| × ||B||)其中:- A · B 表示向量A和B的点积-

https://www.bilibili.com/video/BV1yjz5BLEoYhttps://hzh.sealos.run/ᅟᅠ ᅟᅠ ᅟᅠ ᅟᅠ ᅟᅠ ᅟᅠ ᅟᅠ ᅟᅠ ᅟᅠ ᅟᅠ ᅟᅠ ᅟᅠ