简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

大模型本地部署

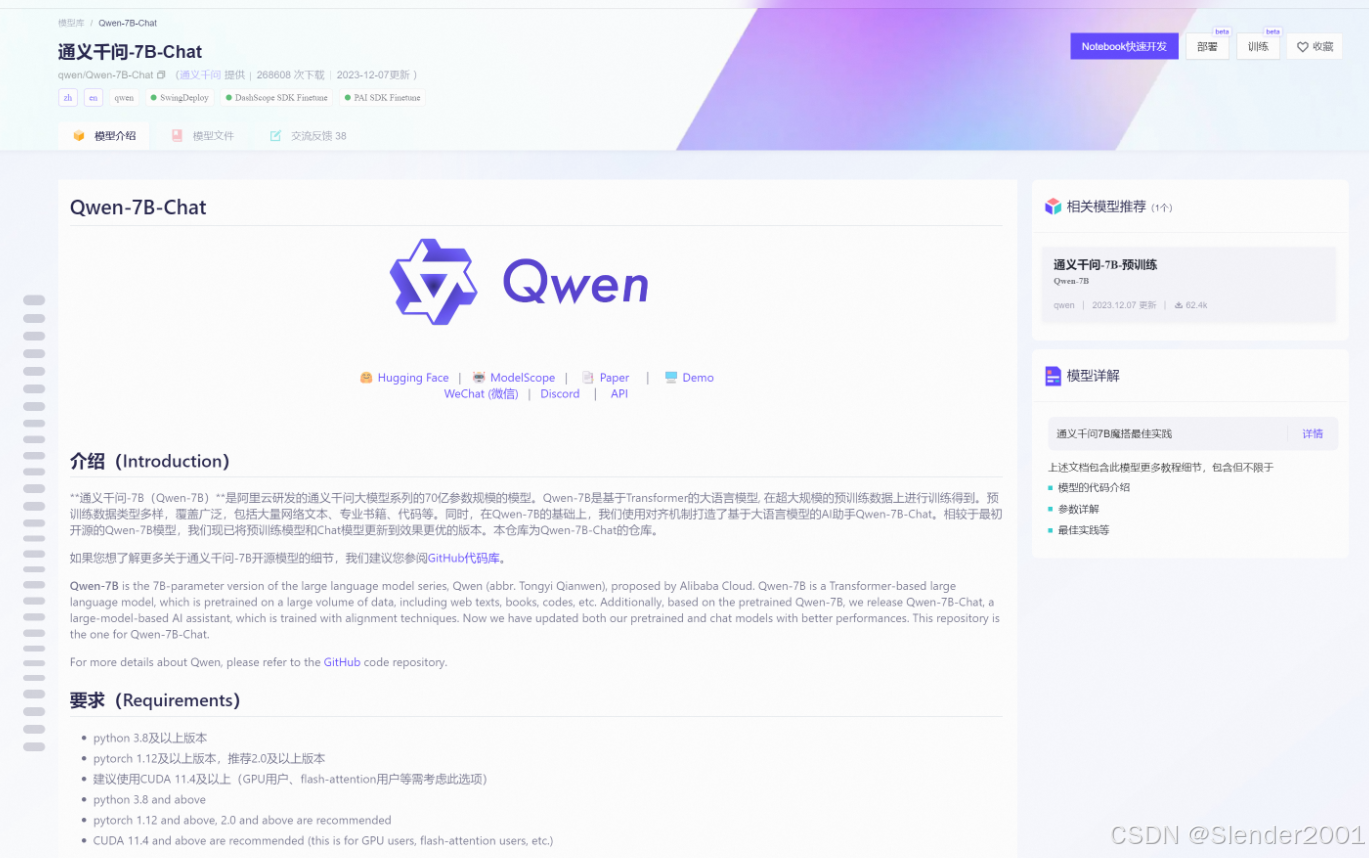

为了运行之后本地部署的Qwen-7B-Chat模型,我们需要根据要求在Anaconda中安装一个满足模型运行要求的虚拟环境,其官方的配置环境要求如下,这里配置的环境为使用GPU Pytorch的版本。点击其中的模型文件,进入模型文件页面,之后点击右侧的下载模型。第二步:安装通义千问官方说的运行Qwen-7B需要安装的依赖。第一步:安装modelscope可以用来下载模型。SDK安装安装工具包下载。

机器学习周记(第二十周:文献阅读-TCN and LSTM)2023.12.4~2023.12.10

本周阅读了一篇关于TCN和LSTM进行光伏功率预测的文章,光伏功率数据是非线性不平稳的数据,在一定程度上也能反应论文模型在水质预测方面的效果。论文模型可以通过单步或者多步对光伏功率进行预测,实验结果表明,其具有非常优异的表现。本周也针对论文模型进行了简单的复现,预测结果并不非常准确,仍需进一步优化和调参。

机器学习周记(第四十二周:AT-LSTM)2024.6.3~2024.6.9

本周阅读了题为Water Quality Prediction Based on LSTM and Attention Mechanism: A Case Study of the Burnett River, Australia的论文。这项工作提出了一种基于长期短期记忆的神经网络和 注意力机制的混合模型——AT-LSTM。其中,LSTM缺乏对子窗口特征进行不同程度关注的能力,这可能会导致一些相关

到底了