简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

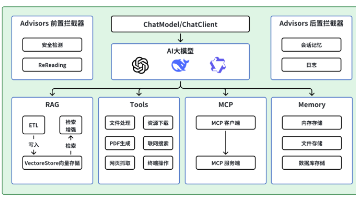

本文介绍了如何利用Spring AI框架统一接入多种大语言模型,并以DeepSeek为例展示具体实现方案。通过Spring AI提供的标准化API,开发者可以快速切换不同AI模型,无需修改核心代码。文章详细讲解了环境配置步骤,包括Spring Boot 3.4.1、JDK 21和Spring AI 1.0.0-M6的依赖设置,以及DeepSeek API的对接方式。同时演示了Spring AI的上

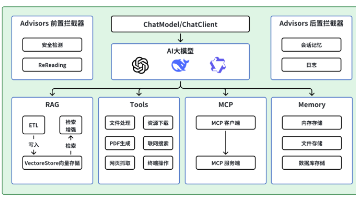

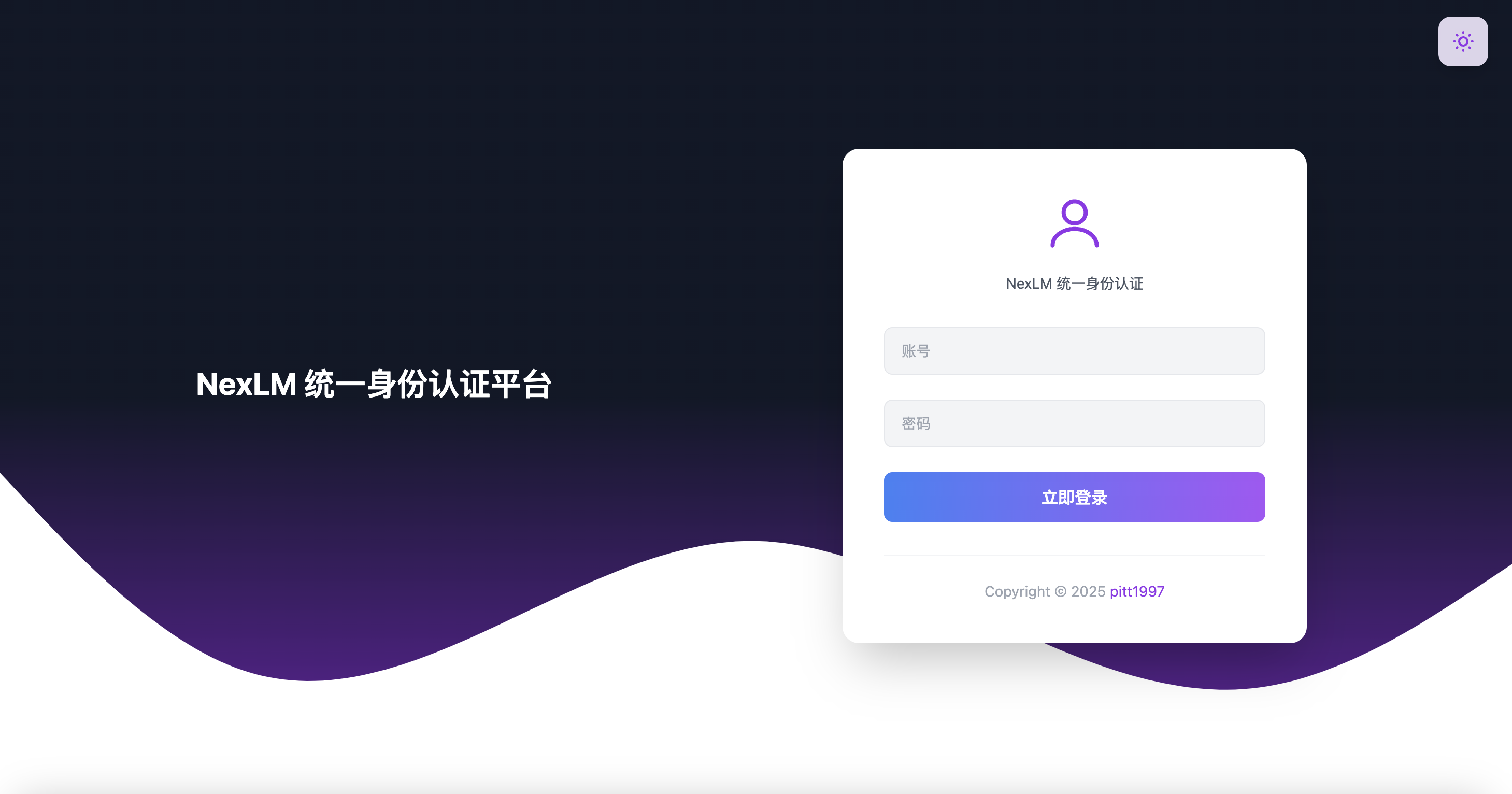

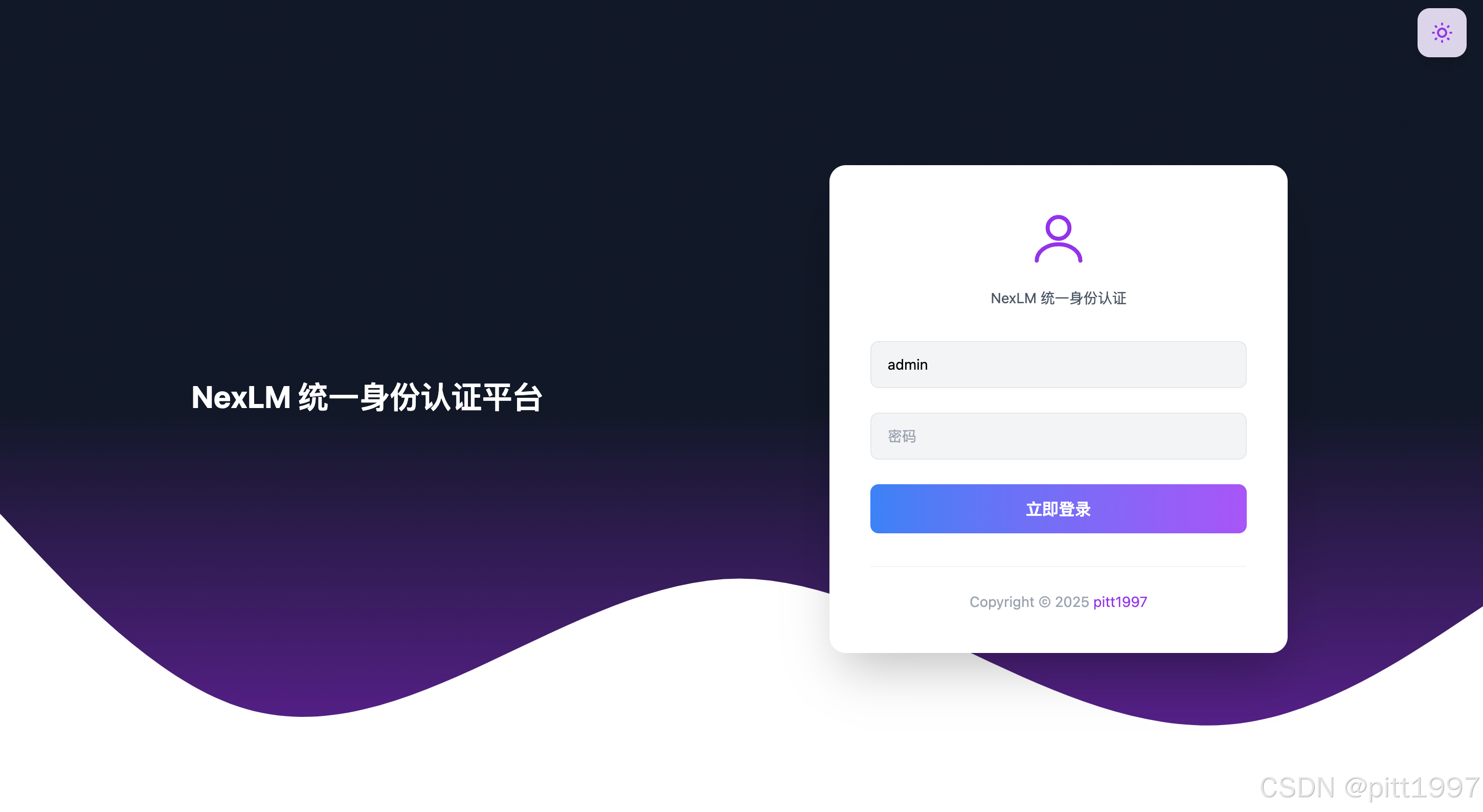

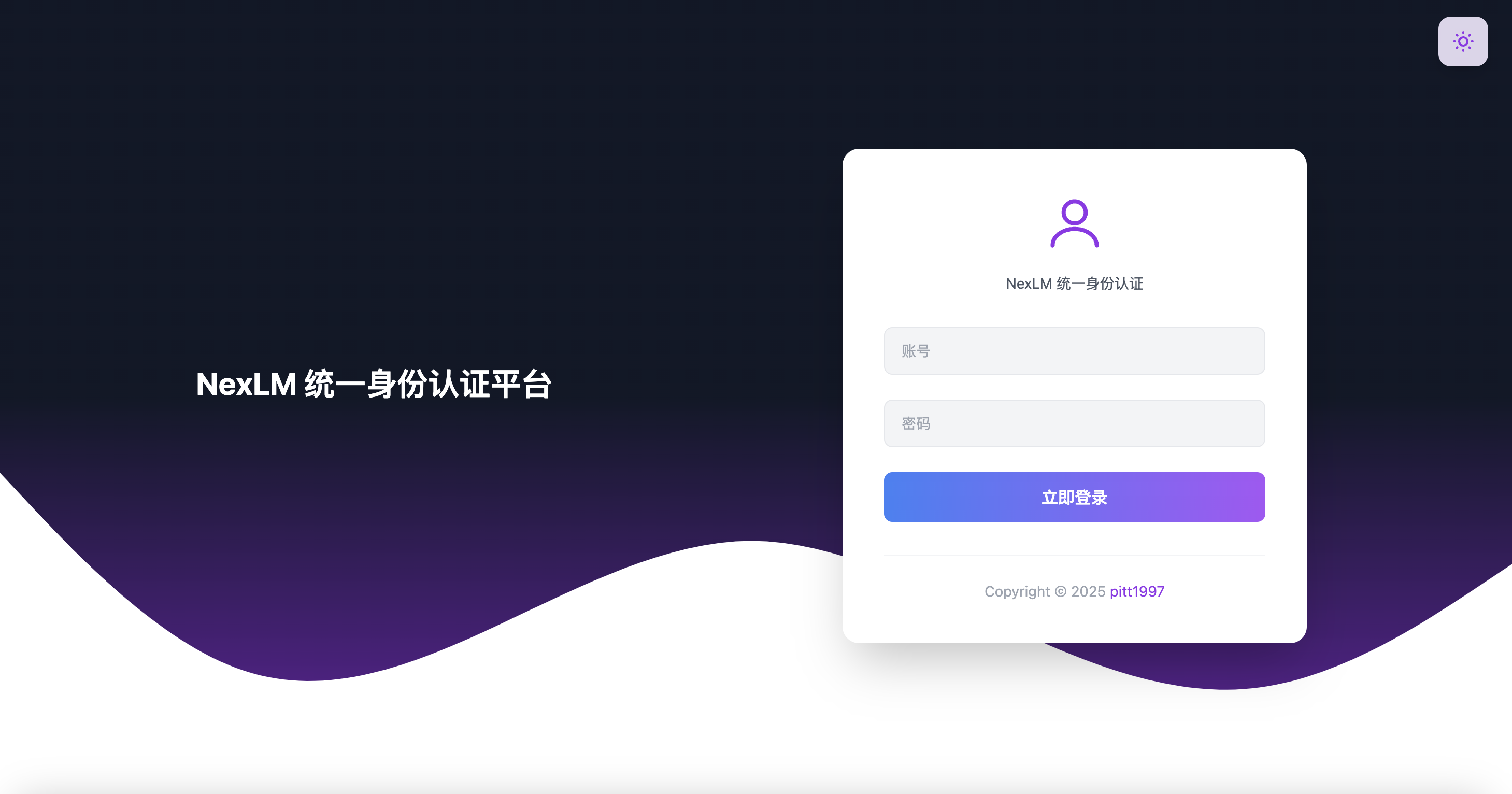

🔍 从架构设计到代码实现,一起探讨如何应对不同技术挑战,最终打造出高效、可扩展的大模型平台,目前项目基础架构已经搭建完成。项目仓库(GitHub):https://github.com/pitt1997/ChatAI。搭建完成,已经支持认证登录功能,并创建了一个简单的 AI 问答 API Demo。🌟 在这系列文章中,我们将一起探索如何搭建一个支持大模型集成项目。项目演示地址:等待上线更新。本

一款开源的本地 LLM 推理 GUI 工具支持 GGUF 格式大模型(Llama.cpp 后端)支持 GPU 加速,可用运行大模型可直接在本地进行离线 AI 对话,不依赖 OpenAI API✅LM Studio 是最简单的本地大模型推理工具之一✅支持 LLaMA / Qwen / Mistral / DeepSeek 等 GGUF 模型✅可以用 RTX 4060Ti / 4070 / 4090

本篇文章,我们介绍了 如何封装多个 LLM(大模型) API 调用 。后续,我们将完善 微服务 + 认证中心:如何保障大模型 API 的安全调用, 并且支持流式对话(SSE)增加 WebSocket 实时消息提升用户体验,敬请期待!

使用 Spring Boot 搭建 WebSocket 服务器,实现 AI 对话流式返回。🌟 在这系列文章中,我们将一起探索如何搭建一个支持大模型集成项目。,使 AI 对话更智能、更可交互。页面,测试 WebSocket 交互。新增一个"停止回答"按钮可随时停止。本章,我们将升级方案,使用。在上一章中,我们使用。,但是 SSE 只能。

本文介绍了IntelliJ IDEA 接入 AI 编程助手的多种方式,包括,以及本地 AI 部署方案。开发者可根据需求、安全性、网络环境选择合适的 AI 助手。如果你有更好的 AI 代码助手推荐,欢迎在评论区交流!

本文介绍了如何利用Spring AI框架统一接入多种大语言模型,并以DeepSeek为例展示具体实现方案。通过Spring AI提供的标准化API,开发者可以快速切换不同AI模型,无需修改核心代码。文章详细讲解了环境配置步骤,包括Spring Boot 3.4.1、JDK 21和Spring AI 1.0.0-M6的依赖设置,以及DeepSeek API的对接方式。同时演示了Spring AI的上

🔍 从架构设计到代码实现,一起探讨如何应对不同技术挑战,最终打造出高效、可扩展的大模型平台,目前项目基础架构已经搭建完成。项目仓库(GitHub):https://github.com/pitt1997/ChatAI。搭建完成,已经支持认证登录功能,并创建了一个简单的 AI 问答 API Demo。🌟 在这系列文章中,我们将一起探索如何搭建一个支持大模型集成项目。项目演示地址:等待上线更新。本

本篇文章,我们介绍了 如何封装多个 LLM(大模型) API 调用 。后续,我们将完善 微服务 + 认证中心:如何保障大模型 API 的安全调用, 并且支持流式对话(SSE)增加 WebSocket 实时消息提升用户体验,敬请期待!

由于浏览器的同源策略限制了跨域请求。然而,在开发环境中,我们只是想调试 API,严格的 CORS 限制反而影响效率。因此,本文介绍在 Chrome 开发环境临时屏蔽 CORS 的方法。在开发环境下,我们可以通过创建一个专用的 Chrome 开发模式,在不影响正常浏览器使用的情况下,临时关闭 CORS 限制。